为4G战局注入强芯针 Marvell新发64位5模LTE芯片

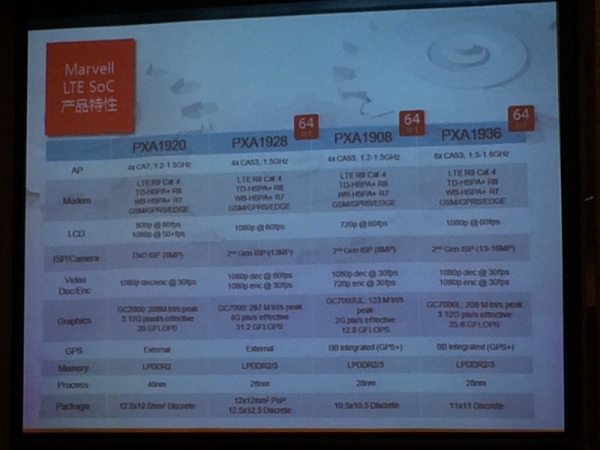

自从去年苹果发布iPhone 5s时宣布使用64位处理器以后,高通、英特尔、联发科等芯片大厂也纷纷跟进推出了自主研发的64位处理器产品。而一直在芯片市场上辛勤耕耘的Marvell也不甘示弱,近日推出两款64位4G LTE移动芯片——ARMADA Mobile PXA1936和PXA1908。

两者均采用ARM Cortex A53 64位架构CPU,其中PXA1936是一款8核芯片,提供优秀的图形和安全功能、高性能图像处理能力以及集成的SensorHub功能,适用于全球高性能智能手机和平板电脑。而PXA1908是一款经过成本优化的移动处理器针对全球快速增长的5模4G LTE大众市场,属于Marvell 4核 64位移动LTE SoC系列。

移动市场是攻占高地

Marvell是全球化的移动产品提供商,为移动通信、存储、物联网(IoT)、云基础设施方面都提供完整芯片解决方案。除了中国,目前在美国、以色列、日本、欧洲、印度等国家都有设计中心。在发布会现场,Marvell全球副总裁李春潮表示,Marvell明年在中国的战略核心将放在移动业务上。

“目前LTE发展非常快,全球已有约4亿部LTE手机或终端,明年还会继续增长。今年年初时,Marvell大部分的LTE产品都是以运营商市场为主,而下半年公开市场和电商市场也成为了很重要的市场。”

事实上,Marvell在进军4G手机之前就已经定调了其千元4G的地位,并在上一年发布了首款支持4G LTE的1088 LTE这款业内首款四核心LTE单芯片,在中国移动主导的TD-SCDMA领域,Marvell将重点放在了TD-LTE制式网络的支持上。

目前,与Marvell深度的合作伙伴有中国移动、联通、三星、中华酷联,最近魅族刚刚发布的一款高端手机MX4 Pro,也是采用了Marvell的LTE方案。

刚刚过去的第三季度Marvell帮助合作伙伴推出了非常多的LTE手机,市场份额表现良好。目前,在中国LTE市场,Marvell是前两名的芯片供应商,在全球也是第二。Marvell对终端芯片市场非常有信心,并会继续加大力度发展。

为4G战局注入强芯针

对于实现移动计算、社交网络、云游戏以及其他数据密集型应用而言,4G LTE是非常关键的技术,已经成为我们日常生活中不可或缺的组成部分。作为全球领导厂商,用优秀的创新和发明为人们提供更好的生活体验是Marvell所肩负的使命,也是Marvell的激情所在。

此次发布的两款4G LTE芯片中,ARMADA Mobile PXA1936采用了Marvell低功耗SensorHub技术,提供优秀的传感器数据融合能力。作为Marvell 64位移动SoC系列的组成部分,该产品还为设备制造商开发基于安卓操作系统5.0的64位平板电脑和智能手机创造了机会。

Marvell PXA1936拥有八个CPU核心,主频为1.5GHz,支持1080p显示以及视频编解码、1300万像素至1600万像素的相机,并增强了安全处理器功能。而Marvell PXA1908则拥有四个CPU核心,主频为1.2GHz,支持720p显示以及800万像素摄像头。

值得一提的是,ARMADA Mobile PXA1936与PXA1908 SoC在软件上完全兼容,从而使OEM和ODM能够快速无缝地推出高性能8核手机。两者在都支持目前最流行的蜂窝通信技术,包括TD-LTE、FDD-LTE、TD-SCDMA、WCDMA和 GSM。

目前,64位4核5模LTE SoC用来满足快速增长的LTE市场需求,简便地实现了2G和3G连接与4G LTE集成。而Marvell 64位系列移动SoC已准备好为设备制造商基于安卓5.0操作系统开发,用于64位平板电脑和智能手机,预计一些重要智能手机厂商将于2015年初开始在全球发布采用Marvell PXA1908的产品。

好文章,需要你的鼓励

-

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的"稀疏化魔法"

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

-

不用再训练AI模型,香港科技大学团队发明"智能管家",让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

-

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的"语义迷宫"让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

-

华为诺亚方舟实验室新突破:不加内存也能让AI变聪明的神奇方法

华为诺亚方舟实验室提出VersatileFFN创新架构,通过模仿人类双重思维模式,设计了宽度和深度两条并行通道,在不增加参数的情况下显著提升大语言模型性能。该方法将单一神经网络分割为虚拟专家并支持循环计算,实现了参数重用和自适应计算分配,为解决AI模型内存成本高、部署难的问题提供了全新思路。