忘掉算法吧,AI的未来在于硬件

CNET科技行者 1月16日 北京消息 乔治·扎卡达基斯(George Zarkadakis)伦敦城市大学人工智能方向博士,计算机系统工程师、科学作家。曾在埃森哲和美国硅图公司等机构工作。目前,他是一位技术咨询师和互联网企业家。因其在国际科学交流方面做出的贡献,被法国政府授予爵士头衔。他一直为媒体和出版物撰写稿件,包括《卫报》、《华盛顿邮报》等知名刊物。他同时还是一名小说家和剧作家,著有《人类的终极命运:从旧石器时代到人工智能的未来》一书,作品在多国(希腊、西班牙、意大利、中国等)出版。

就目前来讲,人工智能的宣传主要集中在算法层面。在机器学习领域处于全球领先水平的谷歌公司近期发表了一篇文章,其中介绍了AlphaGo Zero如何依靠一己之力从零开始成为围棋世界的统治者,并凭借着先进算法轻松击败全部原有AI版本。尽管这一切已经证明强化学习算法的深厚功力,而谷歌公司及其它各类组织机构也仍在积极网罗算法设计以及数据利润总额领域的顶尖人才。

但是,真正的爆炸性新闻却来自硬件世界——没错,来自由线路、芯片与电子元件组成的世界。硬件又回来了!

摩尔定律的扁平化

首先,让我们对历史作出一番快速回顾:

1958年,仅包含2个晶体管的首个集成电路问世,其规模相当庞大——面积达到惊人的1平方厘米;到1971年,集成芯片性能的指数级增长使得“摩尔定律”逐渐浮出水面,与此前相同的面积下已经能够封装多达2300个晶体管;到2014年,IBM公司的P8处理器已经拥有多达42亿个晶体管与16个计算核心,且芯片面积仅为650平方毫米。

但遗憾的是,在给定芯片之上能够封装多少个晶体管由自然规律所决定,且我们很快就将迎来这块可恶的天花板。此外,在模式识别(例如语音理解与图像识别等)领域,机器学习应用需要大量并行处理能力。

当谷歌公司宣布其算法已经能够成功从图片中识别出猫这一对象时,他们没有提到该软件需要16000块处理器才能正常运行。虽然大家可以使用云服务器农场中的计算资源来解决这个问题,但不可否认,我们有时候可能也需要在小型移动设备上运行此类算法。随着各个行业越来越多地将这类需求提上议事日程,在终端设备中运行先进机器学习功能开始带来愈发可观的潜力——不仅能够为用户提供理想服务,更能够解决大量数据隐私问题。想象一下,如果Siri不需要对接云端进行调用,而能直接利用智能手机硬件处理所有数据及算法,该有多好。然而,用户显然也不希望刚刚使用几分钟的Siri或者《我的世界》,自己的手机就因过热而无法继续工作。

解决瓶颈

设备之所以会快速过热,是因为我们目前的计算机硬件设计主要依托于所谓“冯-诺依曼”架构,而其中存在着固有瓶颈:传统计算机体系架构将处理与数据存储资源彼此分离,这意味着数据需要在不同位置往来传输,才能完成计算流程。并行机制能够将计算任务加以分解并分别处理的方式在一定程度上缓解了这个难题,但用户仍然需要最终进行数据移动,以便将所有内容协调为需要的输出结果。那么,我们是否有办法摆脱这一硬件瓶颈?如果处理资源与数据驻留在同一位置,不需要任何移动操作,是否就能够降低产生的热量与消耗的能量?毕竟我们的大脑就采用这样的工作方式:我们不会像计算机那样刻意区分独立的处理与数据存储区域,一切都立足神经元中进行。

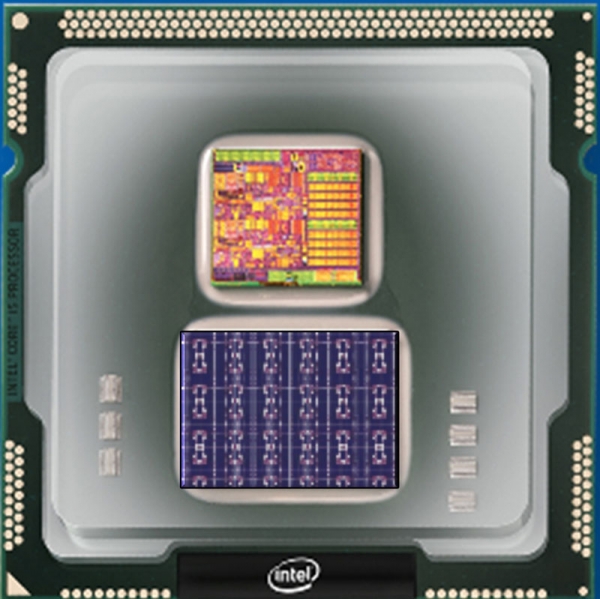

英特尔神经拟态计算(类脑)芯片Loihi

汲取来自大脑运作方式的灵感,在人工智能领域早已不是什么新鲜事物——我们已经在利用神经网络实现深度学习。然而,我们实现这一目标的方法在于利用机器学习算法及并行处理来模拟神经元功能。但我们是否能够构建起并非“模拟”,而是真正与我们的大脑拥有同等运作方式的计算机呢?自上世纪七十年代以来,人们就已经设想将大脑的功能实际映射至硬件之上,换言之即设计出能够直接映射大脑结构的硬件。这种被称为“神经形态计算”的方法最近已经开始进行商业化,英特尔与高通等厂商已经宣布将推出适合商业用途的神经形态芯片。

神经形态芯片很可能成为人工智能的终极助力,这样的消息无疑令人振奋异常。需要强调的是,其也有可能将机器的智能水平提升到全新的高度。通过使用电子学而非软件来开发机器认知,我们或许能够实现通用型人工智能这一梦想,即创造出真正的智能系统。

量子:计算领域的宇宙大爆炸

然而,计算领域真正的宇宙大爆炸并非来自神经形态芯片(尽管前景光明,但其可能将长时间作为小众应用存在),而是来自量子物理原理。随着快速计算需求的持续增加,我们解决真正困难问题的雄心也在持续巩固。如果我们能够计算出一系列分子排布来攻克癌症,人类的未来会如何?这个问题实际上直指迄今为止所有癌症研究的核心,即通过试错法进行实验。经典计算无法解决这样的问题,因为参数组合在数次迭代之后将递增至爆炸性的规模。量子计算则有可能一次性计算所有可能的组合,并在几秒钟之内找到正确答案。量子计算能够解决诸多类似的优化型问题,例如考虑复杂业务中的资源分配优化、在经济体系中进行资源分配,做出能够支持最佳策略的预测——甚至可以对密码因子进行分解。

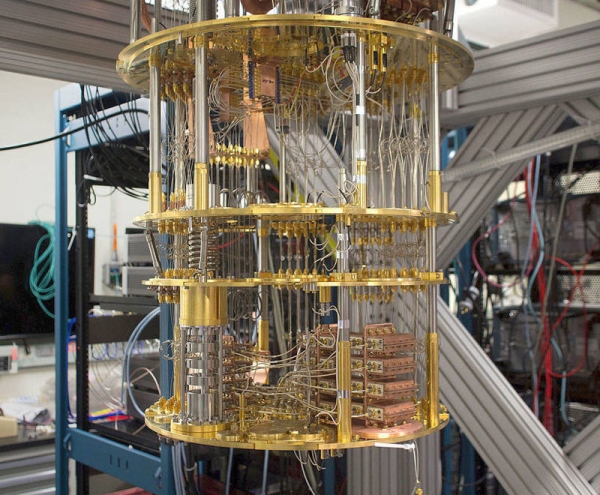

IBM量子计算机

量子计算机正在快速发展:我们目前的量子处理器处于50量子位水平。下面我们来详细解读这一数字的含义。32位量子计算机能够处理40亿个系数与256 GB信息——这样的结果可能无法给人留下深刻的印象,因为大家可能会说自己的笔记本电脑也能在几秒钟内完成类似的程序。然而,一旦我们构建起64位量子计算机,那么情况将大不相同。这样的计算机可以一次性计算出互联网上的所有信息,更具体地讲为74 EB(即10亿GB)数据——利用目前的超级计算机,这些数据需要几年才能处理完成。我们距离成功已经很近了!然而这还不够,一旦我们开发出256位量子计算机,真正的游戏规则改变者就会降临——这样一台计算机能够对宇宙中全部原子的数量进行计算。量子计算即为宇宙计算,其无疑将给整个人类文明带来巨大而深远的影响。

好文章,需要你的鼓励

-

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

openGauss的目标是探索oGRAC和超节点深度融合的可能,打造超节点原生数据库。

-

清华团队让机器学会"透视眼":用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

-

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

-

上海AI实验室创造"无限视频世界",用键盘就能探索!

上海AI实验室团队开发的Yume1.5是一个革命性的AI视频生成系统,能够从单张图片或文字描述创造无限可探索的虚拟世界。用户可通过键盘控制实时探索,系统8秒内完成生成,响应精度达0.836,远超现有技术。该系统采用创新的时空通道建模和自强制蒸馏技术,支持文本控制的事件生成,为虚拟现实和内容创作领域开辟了新的可能性。