虽然AI预测犯罪很有用,但有时候偏见也不小

CNET科技行者 1月23日 北京消息 一部分人认为人工智能可以消除人类偏见。在商务、医药、学术、打击犯罪等领域,即使是简单的统计工具也远超人类。还有一部分人反对AI将偏见系统化,因为即使偏见未被编入程序,AI也自带偏见。

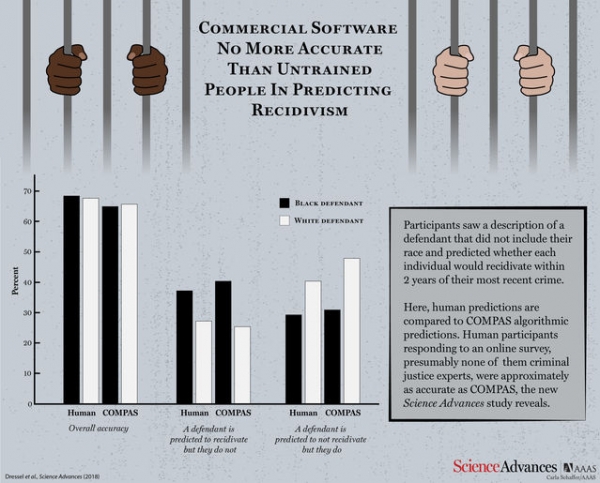

2016年,ProPublica(一个独立的非盈利新闻编辑部,为公众利益进行调查报道)发布了一份广泛引用的报告(Machine Bias),该报告认为,预测犯罪概率的常用算法(COMPAS)带有种族歧视。一份新的研究报告(The accuracy, fairness, and limits of predicting recidivism)显示,至少ProPublica提到的案例算法,双方不相上下,算法并不比人类精确公正。该报告还显示:某些情况下,人类对高级AI的需求被过度放大。

自2000年起,名为COMPAS的专有算法开始用于预测再次犯罪,即猜测某名罪犯是否会因再次犯罪而被逮捕。ProPublica的记者观察了来自佛罗里达州的罪犯样本,发现那些并未再犯的人群当中,被COMPAS错误标记为高风险再犯的黑人人数几乎是白人的两倍。而那些再犯人群中,被错误标记为低风险再犯的白人人数却是黑人的两倍,这激怒了公众。但此后,有报道又称,算法比人们想象中的公正。风险评分相同的黑人和白人,再犯的几率也相同,因此并不存在种族差异。算法是否公平,取决于衡量标准,任何算法都不可能满足所有标准。

研究人员将预测再犯(罪)概率的准确性作为主要衡量标准。受试网络用户阅读的罪犯信息涉及七个方面,包括年龄、性别和犯罪记录。研究人员使用COMPAS软件预测。

COMPAS内部的算法未知,但能够读取每个与人类预测的精准度和公正度基本相似,还有两大惊人发现。其一,已知罪犯种族(第一组受试者和COMPAS的使用数据均不涉及种族信息),第二组受试者预测再犯概率时表现的偏见度与不知情时基本一致。

其二,要与COMPAS媲美,无需137条数据(甚至7条都用不上),也不用聪明的头脑或算法。某次试验中,研究人员使用了一个极其简单的机器学习算法(逻辑回归),仅需罪犯的两条数据(年龄及此前犯罪的总次数),预测精准度就可高约65%。研究人员还尝试了一个需7条数据完成预测的强大算法(非线性支持向量机),但精准度并未提高。该项发现证实了一点(许多人工智能研究员也曾提及):“深度学习”这一时下热门技术并非万金油。有些时候,仅需最简单的算法和极少量数据即可解决问题。

此外,研究人员还想强调,预测社会问题并非总是有迹可循。这些算法预测的不是再犯的概率,而是被再次拘捕的概率。然而,即便同一种罪行,黑人往往比白人更容易入狱。因此,算法(或人类)如果从包含人类种族偏见的数据中学习预测模式,很容易过度预测黑人的再犯率,从而增加其入狱率,陷入不公平循环。

达特茅斯大学计算机科学家Hany Farid 曾与学生Julia Dressel(现已毕业)开展了一项研究,希望这一发现能让法院重新审视算法的地位,比如法官在得知网络投票可信度不亚于复杂的系统预测结果时,能够对其再次评估(补充一句,法官或许会更信任前者)。Farid称:“我们希望算法的工作原理更加透明。”

不少案例证明人工智能有时要比人类更精准公正。然而,反之亦然,人工智能和人类有时也不相上下。我们需要提倡此类研究,以验证AI能做什么,不能做什么。

好文章,需要你的鼓励

-

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的"稀疏化魔法"

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

-

不用再训练AI模型,香港科技大学团队发明"智能管家",让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

-

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的"语义迷宫"让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

-

华为诺亚方舟实验室新突破:不加内存也能让AI变聪明的神奇方法

华为诺亚方舟实验室提出VersatileFFN创新架构,通过模仿人类双重思维模式,设计了宽度和深度两条并行通道,在不增加参数的情况下显著提升大语言模型性能。该方法将单一神经网络分割为虚拟专家并支持循环计算,实现了参数重用和自适应计算分配,为解决AI模型内存成本高、部署难的问题提供了全新思路。