燧原科技发布第二代AI训练芯片 公司CEO:下一步建生态

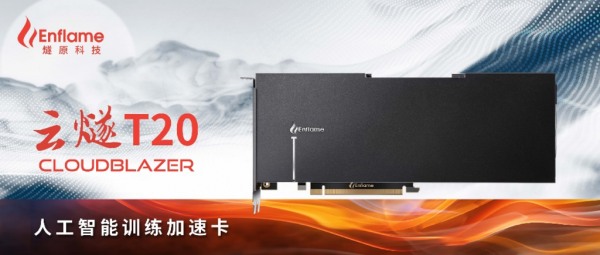

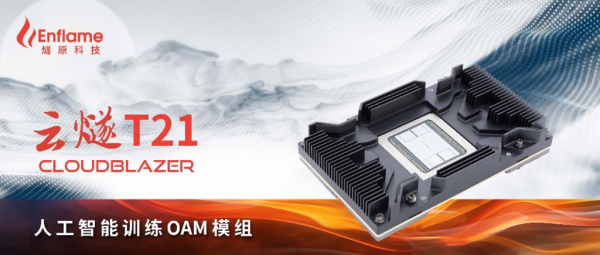

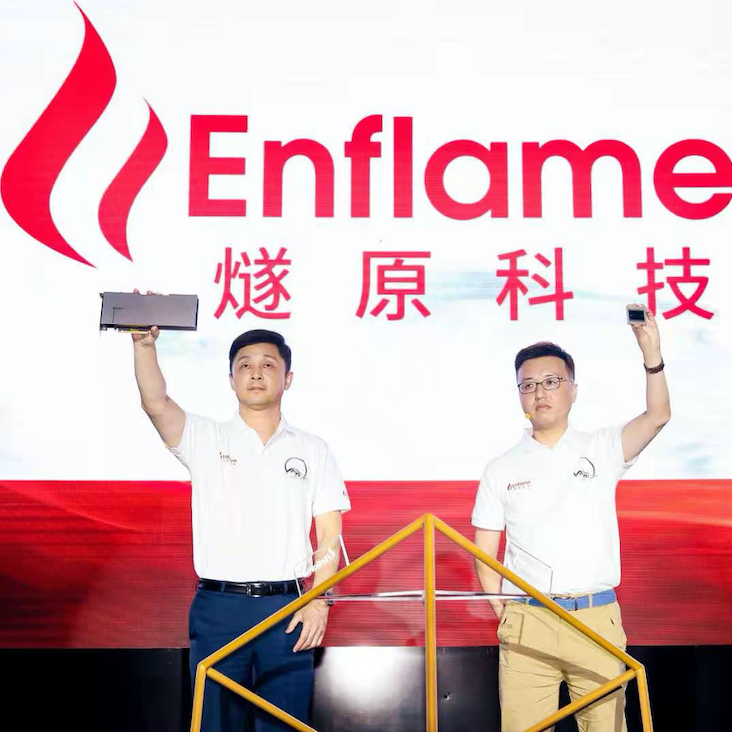

7月7日,燧原科技在上海发布一系列新品,包括第二代人工智能训练产品——“邃思2.0”芯片、基于邃思2.0的“云燧T20”训练加速卡和“云燧T21”训练OAM模组,全面升级的“驭算TopsRider”软件平台以及全新的“云燧集群”,成为国内首家发布第二代人工智能训练产品组合的公司。

燧原科技第二代通用人工智能训练芯片“邃思2.0”

从2018年3月成立,到2019年12月推出第一款云端训练芯片“邃思”和第一代训练加速卡“云燧T10”,再到如今的“邃思2.0”和“云燧T20”——燧原科技完成对AI训练芯片的二次迭代,仅用了三年时间。

“路虽远行则将至,事虽难不做不成”,燧原科技CEO赵立东在现场,用这14个字总结心路历程。在他看来,这是一个AI算力爆炸的时代,过去五年,每3.5个月,AI算力加倍,换算成一年就是10倍,而目前AI算力生态链被垄断。而燧原希望与合作伙伴打破这种垄断,构建一个没有依赖的自主生态。

究竟如何做生态?燧原提出“燎原”计划,以人工智能为起点,构建通用异构计算生态,构建标准化的技术体系,共建完整的开发者生态、产业生态、科研生态,服务数字中国。该计划有三个特征:原始创新、标准化、开放姿态共建生态。

“第二代人工智能训练产品的发布,是燧原科技开发原始创新的算力产品和构建自主生态又一重要的里程碑。通过芯片架构和软件平台的升级迭代,提升产品竞争力,满足市场需求,从而加速产品商业化的步伐。”赵立东指出,“在复杂的国际大环境下,原始创新和自主生态成为发展趋势,这也是燧原科技自创立以来始终坚持的战略选择,是支撑技术和业务长远发展,不断拉近与世界先进水平的距离,并在市场竞争中取得主动的基础。面向泛互联网、传统行业(金融、交通、电力、医疗、工业等)以及新基建三大业务方向,燧原科技正以全新、更具竞争力的产品,服务市场和客户。”

谈到新产品,燧原科技COO张亚林现场介绍:“邃思2.0大幅提升了算力指标,升级后的驭算软件平台更加便捷易用和客户友好,燧原科技也可针对客户的场景和业务模型提供软件定制化服务和优化,打造差异化解决方案。此外,基于云燧T20和T21训练产品、GCU-LARE互联技术和新一代驭算,燧原科技可以打造超大规模的集群产品CloudBlazer Matrix,有效降低人工智能超算集群的整体复杂度和成本,同时通过与合作伙伴的联合开发,一起构建超大规模的液冷智能数据中心,以响应国家‘低碳算力’和‘绿色一体化智能计算’的战略方向。”

燧原科技CEO赵立东(左)与 燧原科技COO张亚林(右)共同发布“云燧T20”训练加速卡和“邃思2.0”芯片

据悉,邃思2.0的计算能力、存储和带宽、互联能力较第一代训练产品有巨大提升,对超大规模的模型支持能力获得显著增强。而同步升级的驭算TopsRider软件平台,成为燧原科技构建原始创新软件生态的基石。完全自研的软硬件架构,助力燧原科技在知识产权和产品升级迭代上可以自主掌控方向和节奏。

燧原科技第二代通用人工智能训练加速卡“云燧T20”

燧原科技第二代通用人工智能训练模组“云燧T21”

四大核心升级 打造全新产品矩阵与智算集群

架构升级实现算力飞跃:邃思2.0进行了大规模的架构升级,新一代全自研的GCU-CARA全域计算架构,针对人工智能计算的特性进行深度优化,夯实了支持通用异构计算的基础;支持全面的计算精度,涵盖从FP32、TF32、FP16、BF16到INT8,并成为中国首款支持单精度张量TF32数据精度的人工智能芯片。单精度FP32峰值算力达到40 TFLOPS,单精度张量TF32峰值算力达到160 TFLOPS,均为国内第一。

HBM2E存储带来海量吞吐:邃思2.0共搭载了4颗HBM2E片上存储芯片,高配支持64 GB内存,带宽达1.8 TB/s,是中国第一个支持世界最先进存储HBM2E和单芯片64 GB内存的产品。

高速互联支撑算力扩展:GCU-LARE全域互联技术是燧原专为人工智能训练集群研发的互联技术,提供双向300 GB/s互联带宽,支持数千张云燧CloudBlazer加速卡互联,实现优异的线性加速比。

全新软件驾驭澎湃算力:驭算TopsRider是燧原科技自主知识产权的计算及编程平台,通过软硬件协同架构设计,充分发挥邃思2.0的性能;基于算子泛化技术及图优化策略,支持主流深度学习框架下的各类模型训练;利用Horovod分布式训练框架与GCU-LARE互联技术相互配合,为超大规模集群的高效运行提供解决方案。开放升级的编程模型和可扩展的算子接口,为客户模型的优化提供了自定义的开发能力。

好文章,需要你的鼓励

-

利用大语言模型探索科学创新前沿:南洋理工大学团队开发检测学术新颖性的突破性方法

这项研究利用大语言模型解决科学新颖性检测难题,南洋理工大学团队创新性地构建了闭合领域数据集并提出知识蒸馏框架,训练轻量级检索器捕捉想法层面相似性而非表面文本相似性。实验表明,该方法在市场营销和NLP领域显著优于现有技术,为加速科学创新提供了有力工具。

-

un?CLIP:通过反转unCLIP来提升CLIP模型的视觉细节捕捉能力

un?CLIP是一项创新研究,通过巧妙反转unCLIP生成模型来增强CLIP的视觉细节捕捉能力。中国科学院研究团队发现,虽然CLIP在全局图像理解方面表现出色,但在捕捉细节时存在不足。他们的方法利用unCLIP生成模型的视觉细节表示能力,同时保持与CLIP原始文本编码器的语义对齐。实验结果表明,un?CLIP在MMVP-VLM基准、开放词汇语义分割和视觉中心的多模态任务上显著优于原始CLIP和现有改进方法,为视觉-语言模型的发展提供了新思路。

-

角色扮演能力大考验:里尔大学研究团队开发的大语言模型角色扮演评估新标准

这项研究介绍了RPEval,一个专为评估大语言模型角色扮演能力而设计的新基准。研究团队从法国里尔大学开发的这一工具专注于四个关键维度:情感理解、决策制定、道德对齐和角色一致性,通过单轮交互实现全自动评估。研究结果显示Gemini-1.5-Pro在总体表现上领先,而GPT-4o虽在决策方面表现出色,但在角色一致性上存在明显不足。这一基准为研究人员提供了一个可靠、可重复的方法来评估和改进大语言模型的角色扮演能力。

-

LegalSearchLM:北大团队打造突破性法律案例检索新方法,将案例检索重新定义为法律要素生成

这篇论文介绍了LegalSearchLM,一种创新的法律案例检索方法,将检索任务重新定义为法律要素生成。研究团队构建了LEGAR BENCH数据集,涵盖411种犯罪类型和120万案例,并开发了能直接生成关键法律要素的检索模型。实验表明,该模型在准确率上超越传统方法6-20%,且在未见犯罪类型上展现出强大泛化能力。这一突破为法律专业人士提供了更高效、精准的案例检索工具。