对话诺亦腾CEO刘昊扬:生成式AI为动作捕捉带来了新思路

从早稻田大学1972年研发的WABOT,到特斯拉2022年首秀的Optimus,人类科学家对人形机器人的研发走过了半个世纪。在这半个世纪里,人形机器人的发展已经从本田ASIMO、波士顿动力Atlas代表的技术验证期,过渡到了以特斯拉Optimus为代表的商业试水期,一个新的机器人时代正在开启。

为此,至顶科技特别策划推出《机器人新纪元》专题报道,旨在探寻全球机器人团队的技术变迁和创新故事。

本文收录于至顶科技《机器人新纪元》专题。

作者 | 金旺

栏目 | 机器人新纪元

动作捕捉技术是不少好莱坞大片中常用的一项技术,后来又在VR领域得到了广泛应用。

不过,这项技术的商业价值远不止于此,成立于2012年、以动作捕捉技术闻名于世的诺亦腾,如今不仅将动作捕捉技术应用到了体育运动分析领域,还将这项技术应用到了医疗领域。

诺亦腾CEO刘昊扬告诉我们,医疗领域是诺亦腾现在重点关注的一个领域,动作捕捉技术也正在医疗领域发挥着重要作用。

在2023世界机器人大会现场,我们和诺亦腾CEO刘昊扬进行了一次交流,谈了谈他眼中动捕技术的发展、在医疗领域的应用,以及在AI大模型上的探索。

AI大模型和动作捕捉新思路

问:动作捕捉技术在过去经历了怎样的技术迭代?

刘昊扬:最开始,动作捕捉技术是基于纯光学的方案,我们进入这个领域时,开始基于人体穿戴的传感器做动作捕捉,这样基于可穿戴式传感器的方案极大地提高了应用的便利性,让用户在户外也能采集数据,用无线方式随时随地可以做动作捕捉。

再后来,出现了视觉技术,它是一种无标记点、完全靠人工智能识别人身上关键点,然后把人的动作恢复出来的技术。

从精度上来说,基于光学的方案最好,基于传感器的方案在某些方面不如光学方案,视觉表现有时候会差一些。

动作捕捉的目的有两种,一种是精准还原人的动作(类似测量),另一种是根据人的动作,复现出接近的,符合视觉表现要求的动作数据(类似特效创作)。

随着生成式AI的出现,动作捕捉技术又往前迈进了一步,现在很多人在用生成式AI尝试做一些新的方向:

其中一个新方向是,针对以前几种方案中出现的环境遮挡、信号丢失问题,这些原来需要通过人来修复的画面,现在是否可以用生成式AI自动修复;

另一个新方向是,基于足够多动作数据的动作库,通过生成式AI生成动作,甚至不再需要演员来演示。

这是生成式AI为动作捕捉领域带来的新变化。

动作捕捉技术发展其实走得是比较快的,而且这些年一直在加速。

光学方案过去三四十年没有太大的变化,传感器技术近10年发生了很大的变化,视觉技术到现在还没有发展多久,还没有开始真正用起来,生成式AI技术就已经出现了。

例如此前在用动作捕捉技术做游戏时,一个动作游戏我们需要采集很多段动作,游戏实际上只是把这些动作连在了一起,未来有了生成式AI,可能在游戏制作中直接生成动作,甚至都不需要动作捕捉这个步骤了,这可能会对行业带来一个很大的冲击。

不过,现在我们还不太清楚生成式AI会带来怎样的冲击,这是因为动作捕捉的应用创新是落后于技术发展的。

问:视觉技术在动作捕捉领域应用现状是怎样的?

刘昊扬:用视觉做人的动作捕捉这项技术,一直以来就没有发展得很成熟。

由于缺少扎实的应用场景,这项技术的发展相对比较偏科研探索,在动作捕捉领域的精准度一直不太够,人的大幅度动作用视觉做动作捕捉一直不是很精准。现在比较成熟的应用场景是捕捉面部表情,因为这个场景是相对静止的。

我们看到更多应用场景是在科研领域,以及对精度没什么要求的场景,做一些粗略的人的动作识别。

当然一些人开始发力基于纯视觉的、没有标记点的动作捕捉技术时,生成式AI技术又出现了,这时行业又开始新一轮技术”内卷“。

问:所以现在会存在一个技术路线选择问题吗?

刘昊扬:其实都不用选择,因为大家知道肯定要往生成式AI方向走。

医疗手术中的动捕应用

问:动捕技术在落地应用上有怎样的发展?

刘昊扬:我们公司名字,诺亦腾,其实就是英文单词motion倒过来的拼写,我们是希望改变动作捕捉这个行业,不仅仅是改变动作捕捉的技术,还希望它能在行业真正应用起来,所以做着做着,我们发现我们成了唯一一家既提供动作捕捉技术,同时也提供动作捕捉技术行业应用的厂商。

其他大部分厂商都只是卖工具,或者卖SDK,他们的目标用户大多是科研领域的用户,或者一些数字媒体中做创新的用户。

我们动作捕捉已经在很多领域在做具体应用,例如在体育领域将运动员动作捕捉下来做分析,可是没有人去做这个桥梁,于是我们自己开始上手做运动员的分析训练系统,因为高尔夫运动员对动作细节非常讲究,我们早期做了高尔夫运动员分析系统。

随着之后业务发展,我们逐渐分出一条业务线来做体育场景中的应用,我也参与了北京体育大学体育工程学院的创建,我们现在在那里培养既懂计算机、又懂动作捕捉,同时又了解运动的复合型人才做科研创新和应用。

在健康领域,我们早年就已经有一些客户,例如达芬奇机器人创始人Federic Moll博士后来成立的新公司Auris Health想做一个全新的手术机器人,他就用到了我们动作捕捉设备,尝试一种手术机器人应用新模式。

他认为机器人的自由度不够多,可以通过动作捕捉技术,让人遥控机器人,这是一个很好的想法。

虽然后来这种理念没能被Federic Moll博士实现,但是这让我们发现手术机器人是动作捕捉一个很好的应用方向,于是我们开始进入到这一领域,现在我们已经做了创伤骨科手术机器人,每天都有由我们手术机器人完成的手术。

我们手术机器人做的是很难的手术,最主要是在微创环境下做骨盆复杂骨折后的复位和固定的手术,这类手术号称是骨外科最难的手术。

我们在这类手术中用到了三维可视化模型再现和运动追踪技术,在手术过程中,我们可以在屏幕上看到三维的骨盆,用特制的牵引针做复位时,可以对着屏幕操作,屏幕和真实人体中的画面是1:1呈现的。

这其中运用到的三维模型重构技术和运动追踪技术,我们之前用来追踪人体运动,现在用来追踪人体中的骨块,技术本质是一样的。

目前我们主要在和301医院创伤骨科在合作。

问:这样的设备是否提高了(手术)医生的入行门槛?

刘昊扬:我先说结论,结论是大幅降低了他们学习的复杂程度,他们更容易掌握这种手术了,而且成功率很高。

这其中的原因在于,以前做微创骨科手术的时候,每进行一个动作,都需要在术中不断拍X光片,由于拍出来的片子是二维的,其中这么多人体组织的三维关系是怎样的就需要医生有很好的三维想象力和很丰富的经验,这对医生来说是一件很难的事。

现在我们有了三维图像,无论是做复位,还是从体外打螺丝钉固定也好,都可以对应到屏幕的三维图像上,屏幕上的三维图像是实时连续的,这让整个手术过程变得很简单。

我们有次去一家医院,他们用的就是我们这套技术,我们看到这家医院的一位主任医生从手术台上下来时,将手套一摘,叹了口气,说:“以后的新医生太幸福了,这样做手术太简单,再也不需要花那么多时间练手感了。“

技术先行,场景为王

问:为什么动作捕捉技术应用落后于技术本身的发展?

刘昊扬:生成式AI对于动作捕捉技术来讲,主要还是两点,一个是自动修复,一个是自动生成,这些工作我们之前其实一直在做,只是大模型出现后,为我们提供了一种新的思路。

不过,这其实只是技术的迭代,并没有从根本上颠覆这件事情,所以这个问题的本质是,最重要的到底是什么,是一个新的动作捕捉技术吗?

其实我认为现在最缺少的还是应用场景,我举一个很现实的例子,动作捕捉技术此前海外用的最成熟的应用场景,是虚拟拍摄行业中预演片的拍摄,这是指在导演拍一个特效特别复杂的电影时,需要基于动作捕捉技术先做出来一个相对粗糙的快速动画,然后所有演员和工作人员再基于这个动画重新进行拍摄一遍。

今天在好莱坞,所有大片都是这么来的。

但是在国内,到今天为止,用动作捕捉技术拍预演片这件事儿都还没有普及,只有国内思想比较前卫的一些导演会用这项技术。

这么直接的动作捕捉的行业应用场景,推广都没有想象的那么快,实际上一个新的技术要改造行业,需要很多人的努力。

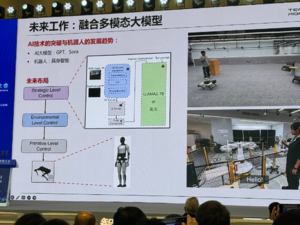

问:诺亦腾在生成式AI技术上有做哪些布局和工作?

刘昊扬:我们也在基于我们在动作捕捉上积累的数据,尝试基于和现在AI大模型同样的思路和框架做这样一个大模型。

但是现在我们也是两条腿走路,一边迭代我们的技术,一边去看我们的应用场景在哪里。

好文章,需要你的鼓励