日期碎片化:大语言模型时间推理的隐藏瓶颈,阿伯丁大学与格勒诺布尔阿尔卑斯大学联合研究揭示

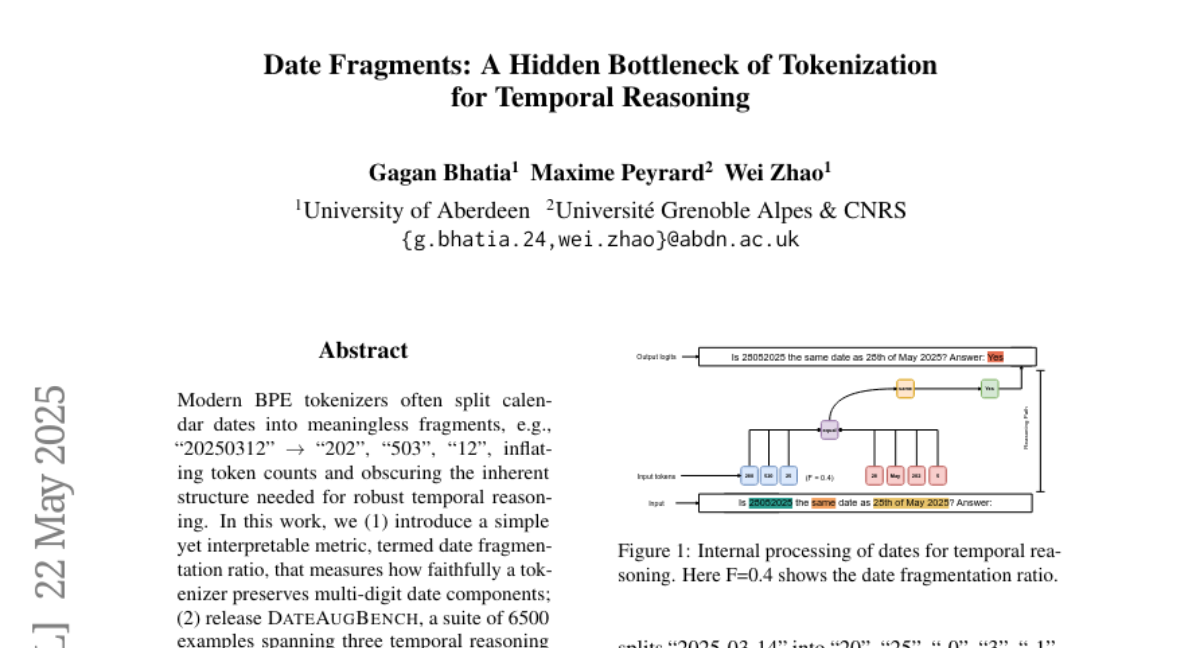

在一个日益数字化的世界里,时间和日期处理看似简单,但实际上充满了挑战。你有没有想过人工智能如何理解"20250312"这样的数字序列是一个日期?或者它如何判断"03/12/2025"和"12/03/2025"是否指同一天?2025年5月22日,阿伯丁大学的Gagan Bhatia和Wei Zhao与格勒诺布尔阿尔卑斯大学的Maxime Peyrard联合发表了一项引人深思的研究,揭示了大语言模型(LLMs)处理日期信息时的一个关键瓶颈:日期的碎片化处理。这项研究发表在arXiv预印本平台(arXiv:2505.16088v1),为我们打开了理解AI时间推理能力的新窗口。

一、日期碎片化:AI处理时间信息的暗礁

想象一下,如果我告诉你"20250312"代表"2025年3月12日",你能轻松理解。但对于大语言模型来说,这串数字可能被拆分成毫无意义的片段:"202"、"503"、"12"。这就像把一块完整的巧克力砸碎成不规则的碎片,原本的形状和结构荡然无存。

当今主流的大语言模型使用一种叫做BPE(字节对编码)的技术来处理文本,这种技术会将文字切分成更小的单元(称为"token")。问题在于,当处理日期时,这种切分往往不尊重日期的自然结构——年、月、日之间的界限被打破,导致原本紧密相连的信息被割裂。

研究团队形象地解释了这一问题:"这就像把一幅拼图打散,却没有保留每块拼图的完整边缘。"当日期被切分成这样的碎片,模型就需要额外的计算资源来重新组合这些碎片,理解它们实际代表的是一个日期。这不仅增加了处理的复杂性,还可能导致模型在进行时间推理时出错。

例如,当模型需要比较"20250314"和"March 14, 2025"是否是同一天时,它首先需要理解这两个表达式都指向同一个日期,尽管它们的形式和被切分的方式完全不同。

二、研究方法:揭示隐藏在表面之下的问题

为了深入研究这个问题,研究团队开发了一套全面的评估框架。他们首先提出了一个简单而有效的指标:"日期碎片化率"(date fragmentation ratio),用来衡量一个分词器(tokenizer)在处理日期时的表现。这个比率越接近0,说明分词器越好地保留了日期的自然结构;越接近1,则表明日期被严重碎片化。

这就像是给不同的厨师评分,看他们切菜时能否保持食材的完整性。一个优秀的厨师会沿着自然的纹理切开食材,而不是随意切碎。同样,一个好的分词器应该尊重日期的自然结构,保留年、月、日的完整性。

研究团队还创建了一个名为DATEAUGBENCH的评估数据集,包含6,500个样本,覆盖了三类时间推理任务:

首先是基于上下文的日期解析,类似于从一段文字中找出"奥米德·纳马齐在1990年6月10日为哪支球队效力?"这样问题的答案。

其次是格式不变性测试,检验模型是否能识别不同格式表示的同一日期,例如"20251403"和"14th March 2025"是否指同一天。

最后是日期算术,测试模型进行日期计算的能力,比如"5/4/2025之前10,000天是什么日期?"

这些测试覆盖了历史、当代和未来的日期范围,全面评估了模型处理不同时间段日期的能力。就像一场全面的驾驶测试,不仅要求在平坦的城市道路上行驶,还包括山路、乡间小道和高速公路。

三、惊人发现:碎片化与推理能力的密切关系

研究团队对多种主流大语言模型进行了测试,包括OLMo、GPT-4、Llama 3和Qwen等。结果揭示了一些令人惊讶的发现。

首先,不同模型的分词器在处理日期时表现各异。OLMo表现最佳,平均碎片化率仅为0.15,而Phi和LLaMa的碎片化率高达0.63。这就像不同的阅读者面对同一段文字,有些人能准确理解每个句子的含义,而有些人则断章取义,丢失了关键信息。

更重要的是,研究发现日期碎片化率与模型在时间推理任务上的表现密切相关。当日期被严重碎片化时,模型在处理不常见的历史日期和未来日期时,准确率最多下降了10个百分点。这相当于一个学生在考试中因为误解了问题而失去10分,尽管他本来掌握了相关知识。

格式对模型的影响也很显著。含有分隔符(如斜杠或破折号)的日期格式,如"DD-MM-YYYY",通常比没有分隔符的紧凑格式(如"DDMMYYYY")更容易被模型正确处理。这就像阅读一段没有标点符号的文字和一段有正确标点的文字的区别——后者显然更容易理解。

四、模型内部的神奇机制:日期抽象能力

研究团队没有止步于表面现象,他们进一步探索了模型如何在内部处理这些碎片化的日期。通过分层探测和因果注意力跳跃分析,他们发现了一个令人惊讶的现象:模型具有"日期抽象"(date abstraction)的能力。

想象一下拼图游戏。当你面对一堆散乱的拼图碎片时,你会先寻找边缘和角落,然后逐渐拼出完整的图案。大语言模型也采用类似的策略。当它接收到碎片化的日期信息时,会在处理的不同层级逐渐将这些碎片"拼接"起来,重建日期的完整表示。

研究发现,模型的规模与其日期抽象能力密切相关。越大的模型能够越快地完成这种抽象过程。例如,研究团队定义了"分词补偿点"(tokenization compensation point),即模型能够正确理解日期的最早层级。对于Qwen2.5-7B模型(拥有70亿参数),这个补偿点出现在第4层(总层数的14.3%);而对于Qwen2.5-0.5B模型(拥有5亿参数),这个点则推迟到第12层(总层数的50%)。

这就像大脑处理信息的速度差异——一个经验丰富的专家可以迅速理解复杂问题,而初学者则需要更多时间才能得出相同的结论。

五、大语言模型的推理路径:与人类思维的不同

通过因果分析,研究团队还揭示了大语言模型如何"缝合"日期碎片以进行时间推理的过程。这就像追踪侦探如何从散乱的线索中推理出案件的真相。

令人惊讶的是,研究发现大语言模型的推理路径与人类的思维方式截然不同。人类通常按照年→月→日的顺序理解日期,而大语言模型则采用一种更灵活的方法,根据日期格式的不同调整处理顺序。

例如,当处理"03122025"(代表2025年3月12日)这样的日期时,Llama 3模型首先识别出"25"(年份的后两位),然后是"220"(年份的前三位),接着是"031"(月和日),最后得出结论这是一个有效日期。这种处理方式类似于解密密码,而非人类理解日期的自然方式。

研究团队将这种现象描述为"基于日期碎片重新路由"(date fragments re-routing)而非"整体语义解释"(holistic semantic interpretation)。这种差异解释了为什么大语言模型在处理非标准格式或罕见历史日期时可能会出错——它们没有真正理解日期的语义结构,而是通过统计关联来"猜测"正确答案。

六、研究启示与未来方向

这项研究不仅揭示了大语言模型处理时间信息的内部机制,还为改进这些模型提供了宝贵的见解。研究团队建议,未来的模型设计应考虑"日期感知"(date-aware)的词汇表和自适应分词器,确保日期组件在处理过程中保持完整。

从更广泛的角度看,这项研究揭示了分词方式如何影响模型的推理能力,这一发现不仅适用于日期处理,也可能适用于其他需要结构化理解的领域,如数学表达式、代码和化学式等。

正如研究团队所指出的,随着大语言模型越来越多地被应用于跨时间的应用场景,如气候预测、经济预测和自动化课程安排,由分词碎片化引入的脆弱性可能会将时间偏差和不准确性传播到下游的科学发现和决策系统中。理解并解决这些问题至关重要。

七、结论:弥合数字与时间的鸿沟

时间是人类经验的基本维度,而准确处理时间信息对于人工智能系统的实用性至关重要。本研究揭示了一个令人惊讶的事实:即使是最先进的大语言模型,也可能因为基础处理机制的局限而在时间推理上面临挑战。

日期碎片化问题就像是AI与时间之间的一道鸿沟。尽管模型能够通过其强大的内部机制在某种程度上跨越这道鸿沟,但这种补偿机制并不完美,尤其是对于较小的模型或处理非标准日期时。

未来的研究方向应该关注如何从根本上改进分词策略,使其更好地尊重日期的自然结构。同时,理解模型如何内部表示和处理时间信息,也为构建更强大、更可靠的AI系统提供了重要线索。

对于我们日常使用AI系统的普通人来说,这项研究提醒我们在依赖这些系统处理时间敏感信息时应保持警惕。在安排重要约会或做出依赖精确日期计算的决策时,多一分核查可能会避免不必要的混淆。

时间不会等待任何人,也不会等待任何AI。理解并解决日期碎片化这一隐藏瓶颈,是让AI系统更好地服务于人类需求的重要一步。

好文章,需要你的鼓励

-

LLM情境调节与持续工作流程提示:革新化学分子式的多模态验证技术

这项研究探索了如何通过"LLM情境调节"和"持续工作流程提示"技术来提高大型语言模型在验证化学分子式时的准确性。研究者发现,普通提示方法往往不可靠,因为LLM倾向于自动"纠正"错误而非指出它们。然而,通过精心设计的情境调节提示,研究成功引导Gemini 2.5 Pro不仅识别出文本中的错误,还发现了之前人工审阅未察觉的图像中的分子式错误。这一概念验证研究表明,即使不修改模型本身,也能通过适当的提示策略显著提高LLM在科学技术文档细节验证中的表现。

-

微生物显微图像分割新突破:复旦大学研究团队借助多模态大语言模型统一显微镜下的"万物分割"

复旦大学研究团队开发的uLLSAM模型成功将多模态大语言模型(MLLMs)与分割一切模型(SAM)结合,解决了显微镜图像分析的跨域泛化难题。通过创新的视觉-语言语义对齐模块(VLSA)和语义边界正则化(SBR)技术,该模型在9个领域内数据集上提升了7.71%的分割准确度,在10个从未见过的数据集上也展现了10.08%的性能提升。这一统一框架能同时处理光学和电子显微镜图像,大大提高了生物医学图像分析的效率和准确性,为科研人员提供了强大的自动化分析工具。

-

用强化学习让大语言模型为汇编代码提速:斯坦福团队的优化探索

斯坦福大学等机构研究团队利用强化学习训练大语言模型,使其能够优化汇编代码性能。研究构建了8,072个程序的数据集,并通过近端策略优化(PPO)训练模型生成既正确又高效的汇编代码。实验表明,训练后的Qwen2.5-Coder-7B-PPO模型实现了96.0%的测试通过率和1.47倍平均加速比,超越包括Claude-3.7-sonnet在内的所有其他模型。研究发现模型能识别编译器忽略的优化机会,如用单一指令替代整个循环,为性能敏感应用提供了有价值的优化途径。

-

播放师傅变声魔术:让你的录音遵循参考风格的推理时间优化新方法

这项研究提出了一种改进的声乐效果风格迁移方法,通过在推理时间优化过程中引入高斯先验知识,解决了传统ST-ITO方法忽视参数合理性的问题。研究团队基于DiffVox数据集构建了专业效果器参数分布模型,将风格迁移转化为最大后验概率估计问题。实验结果表明,该方法显著优于基准方法,参数均方误差降低了33%,并在主观听感测试中获得最高评分。这一创新为音频处理领域融合数据驱动和专业知识提供了新思路。