语音无需语音:Menlo Research团队为低资源语言开发的创新语音指令训练方法

在当今数字化时代,语音助手已成为我们日常生活的重要组成部分。无论是苹果的Siri、亚马逊的Alexa还是谷歌助手,这些智能语音助手让我们通过自然语言就能与设备进行交互。然而,开发一个高质量的语音助手并不容易,尤其是对于越南语这样的低资源语言来说更是挑战重重。2025年5月,来自Menlo Research和新加坡南洋理工大学的研究团队发表了一篇题为《Speechless: Speech Instruction Training Without Speech for Low Resource Languages》的研究论文,提出了一种创新方法,可以在不使用实际语音数据的情况下训练语音助手。这篇发表在arXiv(arXiv:2505.17417v1)上的论文为低资源语言的语音技术发展开辟了新的可能性。

传统上,训练语音助手需要大量的语音指令数据,比如用户提出问题的录音及其对应的文本回答。获取这些数据通常有两种途径:一是收集真实用户的语音指令,这既昂贵又耗时;二是使用文本转语音(TTS)系统生成合成语音,但问题是,对于越南语等低资源语言,高质量的TTS系统往往不够完善。想象一下,这就像是想教会一个孩子回答问题,但既没有能让他听到问题的耳机,也没有能向他解释问题的语言教师一样困难。

Menlo Research团队提出的"Speechless"方法就像是找到了一个聪明的捷径。它不需要直接使用语音数据,而是通过一种叫做"语义表示"的中间形式来训练语言模型。这个过程可以比喻为:与其教计算机理解完整的语音,不如先教它理解语音中的"含义密码",这些"密码"比完整的语音简单得多,但保留了语音中的核心信息。

该研究的创新之处在于它完全跳过了生成实际语音波形的步骤,而是直接在语义表示层面上工作。这就像是不必学习一门外语的完整发音,只需掌握核心词汇和语法结构就能理解意思一样。研究团队利用Whisper语音识别模型的编码器,将文本指令转换为语义表示,然后用这些表示来训练大型语言模型(LLM),使其能够理解和执行语音指令。

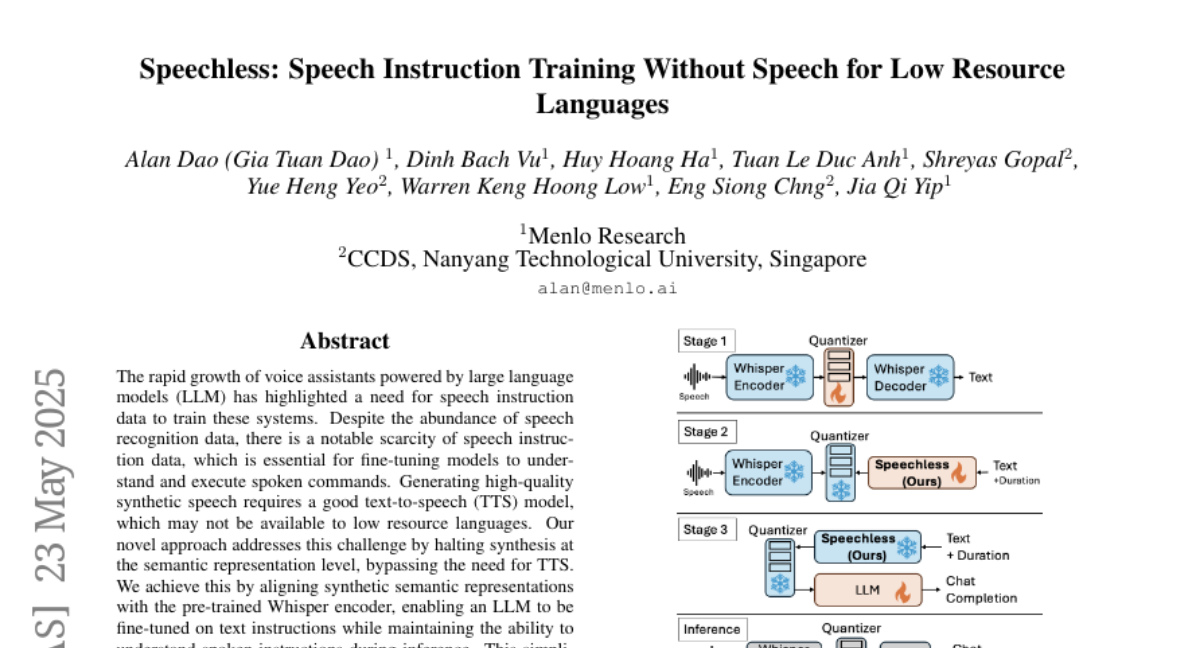

这项研究分为三个主要阶段。在第一阶段,研究人员训练了一个量化器,将语音转换为离散的语义标记。这就像是把复杂的语音信号简化为一系列代表其含义的数字编码。在第二阶段,他们训练了名为"Speechless"的模型,这个模型学习如何将文本和持续时间标记转换为这些语义标记。最后,在第三阶段,他们使用Speechless生成的合成数据来微调LLM,使其能够接受语音输入,尽管在训练过程中并没有使用任何实际的语音数据。

研究团队在越南语上进行了测试,结果表明,使用Speechless训练的模型在自动语音识别(ASR)任务中表现出色,无需基于语音的微调就能达到竞争性能。这项成果对于资源有限的语言来说意义重大,为开发这些语言的语音助手提供了一种经济高效的方法。

一、Speechless方法的背景和意义

想象一下,你正在为一家企业建设客服中心,需要开发一个能用越南语对话的智能语音助手。问题是,你找不到足够的越南语语音指令数据来训练系统,而市面上的越南语文本转语音技术又不够完善。这就是许多开发低资源语言语音技术的研究人员和企业面临的现实困境。

语音助手技术通常依赖于两种模式:一种是级联模式,即先用自动语音识别(ASR)系统将语音转换为文本,再由大型语言模型(LLM)处理这些文本指令;另一种是早期融合模式,直接让语言模型接受语音表示而非文本转录。后一种方法可以减少延迟,提升用户体验,但需要大量的语音指令数据进行训练。

像LLaMA-Omni这样的模型就是使用了包含20万条语音指令及其对应回复的InstructS2S-200k数据集进行训练的。然而,这类语音指令在语言学上与ASR数据有所不同——它们主要包含问题和答案,而ASR转录则主要是陈述句。即使对于常见语言,这类口头指令数据也比ASR数据稀缺,对于越南语等低资源语言来说,这个问题更为严重。

解决语音指令数据缺乏的最常见方法是生成合成数据。研究人员通常使用文本转语音(TTS)系统来生成语音,有时还会使用大型语言模型(LLM)来生成问题的文本。虽然这种方法被证明是有效的,但它依赖于所使用的TTS模型的质量,并且需要模拟多样的说话者声音才能获得良好的泛化效果。对于像英语这样的高资源语言,可以受益于高质量的TTS模型,但越南语等低资源语言的TTS模型在性能上往往落后。

这就是Menlo Research团队提出Speechless方法的背景。它提供了一种不依赖TTS系统的解决方案,通过在语义表示层面而非波形生成层面工作,为低资源语言的语音助手开发提供了新的可能性。这就像是找到了一条通往山顶的捷径,不必沿着陡峭的山路攀爬,而是搭乘缆车直达目的地。

二、Speechless方法的技术原理

Speechless方法的核心思想是:与其让计算机学习理解复杂的语音波形,不如让它学习理解一种更简单的、代表语音含义的"语义标记"。这种方法分为三个主要阶段,就像是一道需要三步完成的烹饪食谱。

第一阶段是训练一个量化器。想象一下,人类语音就像是一幅色彩丰富的油画,有无数种色调和细节。量化器的工作就是将这幅画简化为一张使用有限色彩的素描画,保留主要特征但去除复杂细节。具体来说,研究团队使用了一种叫做残差向量量化器(RVQ)的技术,它能将Whisper编码器生成的高维语音表示转换为离散标记,同时保留语音的语义含义。

为了适应低资源语言,研究团队将量化器的容量扩大了四倍,将码本大小从512增加到2048个条目。这就像是增加素描画的色彩数量,使其能更准确地表达原画的内容。然而,简单地增加容量会导致码本利用率不高,就像给画家提供了更多颜色但他只使用其中几种一样。为了解决这个问题,团队采用了一种不同的策略:复制原始码本权重,然后对这些副本应用随机噪声,确保新增加的"颜色"能被有效利用。

第二阶段是训练Speechless模型。这是一个拥有10亿参数的仅解码器语言模型,设计用于生成语音的语义表示作为离散标记。通过将语义标记视为一种新型语言,Speechless的功能类似于机器翻译模型,它将基于文本的指令翻译成一系列语义标记,这些标记与Whisper编码器处理同一文本的真实语音时生成的标记非常接近。这种文本和语音语义表示之间的紧密对齐使我们能够仅使用文本指令进行训练,但在推理时让模型理解语音。

在文本到语音转换中,一个关键挑战是处理文本和语音标记之间的不匹配问题,因为给定的文本序列通常对应的语音标记数量要多得多,而且所需的语音标记数量可能会变化。Speechless通过其设计为自回归解码器模型来解决这个挑战,它能一次预测一个标记。这种自回归方法允许模型灵活地为任何输入文本生成适当数量的语音标记,不管长度如何。

为了训练Speechless,研究团队使用了ASR数据集中的语音-文本对。原始转录作为Speechless的输入,附加在特殊任务标记<|text to semantic|>之后。语音使用第一阶段的量化器进行标记化,作为目标输出。为了减少计算成本,团队通过创建一个<|duration|>标记来表示每个重复声音标记组内的重复,从而压缩目标序列长度。

第三阶段是训练大型语言模型(LLM)。在训练完Speechless后,研究团队使用它生成合成数据,这些数据可用于微调预训练的LLM。对于文本数据,他们结合了多个指令数据集:英文内容使用Ichigo,越南语使用Sailor和Viettel x NVIDIA数据集。数据准备过程包括几个过滤步骤以确保质量:他们移除了提示长度过长的样本,过滤掉非可听内容(如数学方程和过多的标点符号),并使用Qwen2.5-32B模型为Viettel数据集的答案进行细化。最后,他们使用Speechless将用户轮次标记为离散语音标记。

随后,在生成合成语义标记后,他们可以应用标准的语音指令调优管道,只需进行最小的修改。为了确保使用Speechless的训练成功,他们向LLaMA标记器添加了新的声音和持续时间标记,并调整了LLaMA模型的嵌入和最终线性头,使模型能够使用新标记进行训练。因此,通过将Speechless添加到任何指令调优管道中,研究团队能够仅使用文本指令训练模型,但在推理时让模型理解语音。

三、实验设置与数据集

Menlo Research团队为了验证Speechless方法的有效性,设计了一系列实验,就像科学家在实验室中测试新药的效果一样。他们使用了多个数据集和基础模型,让我们一起来看看他们是如何搭建这个"实验室"的。

首先,让我们了解第一阶段使用的数据集。研究团队使用了两个自动语音识别(ASR)数据集:越南语的viVoice和英语的LibriTTS-R。viVoice数据集包含86.8万条用于训练的语音片段,1万条用于验证,以及1万条用于测试。而LibriTTS-R数据集则包含11.2万个训练样本,5.6千个验证样本和4.6千个测试样本。由于训练数据主要由清晰语音组成,因此最终的模型对噪音表现出了较高的敏感度,就像一个在安静环境中长大的人可能更容易被嘈杂环境干扰一样。

在第二阶段的训练中,研究团队从viVoice中提取了88万个样本,从LibriTTS-R Clean中提取了11.2万个样本,并将这些数据集中的音频转换为使用第一阶段量化器生成的语义标记。然后,他们使用这些量化音频的对应转录文本创建文本到语义的训练对。

对于第三阶段,研究团队使用了更多的数据:88万个来自viVoice的样本,11.2万个来自LibriTTS-R Clean的样本,以及240万个来自MLS Eng的样本作为预训练数据,并使用量化器和Speechless模型将这些数据集的转录文本转换为语义标记。然后,他们使用Ichigo的指令数据来训练模型处理指令,使用Speechless将音频转换为语义标记。研究团队还在Huggingface上发布了这个合成数据集,供其他研究人员使用。

为了创建第三阶段的合成数据,研究团队创建了一个高效的处理流程,使用vLLM进行批量推理Speechless模型(该模型只有10亿参数,仅占用4GB显存)。他们使用Ray进行分布式处理,在多个GPU上运行vLLM实例。

在使用的基础模型方面,研究团队在第一和第二阶段的训练中使用了Whisper Medium检查点。所有输入音频都被填充到30秒长度(在适用的情况下),以兼容Whisper的默认实现。对于第三阶段,他们测试了使用Speechless对LLaMA 3.2 1B和LLaMA 3.2 3B的基础版本和指令版本进行下游微调的效果。然而,在大多数实验中,他们选择了LLaMA 3.2 1B Base模型。初步实验表明,3B模型的表现与1B模型相似,因此他们选择使用资源效率更高的LLaMA 3.2 1B。

训练过程的计算成本也值得一提。整个训练过程分为三个不同的阶段,每个阶段都有其自己的计算需求。在第一阶段,训练分为两个阶段。第一阶段需要75小时完成50个周期,而第二阶段需要29小时完成20个周期。这个阶段使用了8个A6000 GPU,每个GPU的批量大小为42。学习率设置为1e-3,使用AdamW优化器。前500步应用了线性预热,然后是余弦衰减计划,并实施了0.001的权重衰减。

第二阶段的训练过程在60小时内完成,使用了6个A6000 GPU。每个GPU的批量大小增加到48,学习率调整为1e-4。与第一阶段类似,前100步使用了线性预热,然后是余弦衰减计划,权重衰减为0.01。

最后,第三阶段分为两部分:预训练和监督微调。预训练阶段在A6000 GPU上花费了240小时,每个GPU的批量大小为42,学习率为2e-4。应用了与前面阶段相同的计划策略。监督微调阶段在H100 GPU上需要40小时,每个GPU的批量大小为32,学习率为3e-4。这个阶段也使用了100步的线性预热,然后是余弦衰减计划,权重衰减为0.01。总的来说,训练过程是资源密集型的,反映了模型开发的复杂性和规模。

四、实验结果与性能评估

在科学研究中,结果是检验方法有效性的最终标准,就像厨师烹饪的菜肴最终要通过味蕾的评判一样。Menlo Research团队通过多种测试来评估Speechless方法的性能,让我们来看看这道"技术大餐"的味道如何。

首先,研究团队评估了Speechless模型本身的性能。他们使用ASR测试集,比较了Whisper编码器从语音生成的语义标记与Speechless从文本生成的语义标记。在这两种情况下,语义标记都由相同的Whisper解码器模型解码。理想情况下,Speechless和Whisper编码器在干净数据集上的词错误率(WER)应该相似,而Speechless在有噪音的数据集上的WER应该更好。

为了评估量化Whisper模型的一般ASR能力,研究团队使用了LibriSpeech数据集的test-clean部分和VBDemand数据集的clean测试集。他们还使用LibriSpeech的test-other部分和VBDemand的noisy测试集评估了模型。test-clean部分包含2,620个语音片段,总共约5.4小时的清晰朗读语音,而test-other部分包含2,939个语音片段,对应5.1小时的朗读语音。VBDemand测试集包含824个语音片段,其中noisy子集融入了来自八个DEMAND噪音类别的背景噪音,信噪比各不相同。

对于多语言ASR评估,研究团队使用了Mozilla Common Voice 17的越南语(VI)和英语(EN)子集。Common Voice是一个众包数据集,包含具有多种口音、方言和录音条件的录音,非常适合评估多语言性能。他们选择了官方测试集,包括越南语的4,325个语音片段和英语的6,125个语音片段,分别约为8.3小时和12.6小时的语音。

研究结果显示,Speechless模型能够生成语义标记,这些标记在由Whisper解码器解码后,在英语和越南语文本数据的多个领域中显示出非常低的WER。这表明Speechless能够将原始文本信息映射到潜在空间中的清晰语音。当添加噪音(VBD noisy)时,Whisper编码器开始生成与之前相比显示更差WER的标记,这也是预期之中的。

研究团队还观察到,一旦量化,Whisper编码器的性能在噪音和多语言环境中都会下降。他们认为这主要是由于在残差向量量化操作期间信息丢失导致的。由于Whisper解码器模块在添加量化层后没有经过训练,它不了解潜在语音嵌入的变化。此外,在生成码本的第一阶段训练中只使用了干净的英语和越南语语音,因此这些代码可能没有接触到噪音训练数据。

为了评估使用Speechless合成数据进行语音指令调优的模型性能,研究团队使用了VoiceBench的子集,包括AlpacaEval、CommonEval、SD-QA、OpenBookQA和AdvBench,其中基于文本的问答对已转换为口语友好的指令并通过TTS模型朗读。

实验结果表明,Speechless的性能与LLaMA-Omni相当,后者也使用LLaMA-3.1-8B,但是使用真实语音指令进行训练。然而,Whisper-v3-turbo+LLaMA-3.1-8B(一个级联模型)的性能明显更好。这可能是因为级联模型的LLM只需要理解单一模态的数据——文本,这使其能够充分利用预训练。Speechless微调模型的性能也优于Moshi,同时达到与VITA-1.0相当的性能。但它的表现不如使用不同文本LLM作为起点的较新模型,如Baichuan-Omni-1.5、GLM-4-Voice和Qwen2-Audio。

研究团队还报告了模型在MMLU和VMLU上的表现,这些是基于文本的问答基准测试。结果表明,经过指令调优的模型与基础模型相比表现出一定程度的性能下降,这是预期之中的,因为模型现在必须能够接受语音和文本标记,但使用相同数量的参数。这种性能下降先前已在其他研究中报告过,归因于灾难性遗忘(catastrophic forgetting)。

五、研究意义与局限性

Menlo Research团队的Speechless方法就像是为低资源语言的语音技术开发找到了一把钥匙,打开了一扇新的大门。然而,每把钥匙都有其适用范围,Speechless也不例外。让我们来看看这项研究的意义和局限性。

这项研究的最大意义在于,它为低资源语言的语音助手开发提供了一种新的、成本效益高的方法。传统上,开发语音助手需要大量的语音指令数据和高质量的TTS系统,这对于资源有限的语言来说是一个巨大的障碍。Speechless通过在语义表示层面而非波形生成层面工作,绕过了这一障碍,使得即使在没有高质量TTS系统的情况下,也能开发出有效的语音助手。

此外,研究团队通过发布越南语的预标记化指令数据集,为低资源NLP领域填补了一个关键空白。这为其他研究人员和开发者提供了宝贵的资源,可以加速越南语语音语言模型的开发。这就像是为后来的探险者留下了一张地图,使他们能够更轻松地踏上同样的旅程。

然而,Speechless方法也有其局限性。首先,在文本基准测试中观察到的性能下降表明,在语音指令调优过程中可能存在灾难性遗忘的问题。这就像是一个学生在学习新知识的同时忘记了一些旧知识。其次,虽然Speechless在干净和受控环境中表现出色,但在高度嘈杂或多样语言环境中的稳健性还需要进一步探索。这就像是一辆在平坦道路上表现出色的车辆,可能在崎岖地形上面临挑战。

研究团队在论文中承认了这些局限性,并指出他们的未来工作将重点放在增强噪音稳健性和扩大适用性到更广泛的语言和方言范围上。尽管Speechless目前主要在干净数据上进行了测试,但原则上,论文中描述的方法也可以应用于嘈杂数据,这为未来的研究提供了一个有希望的方向。

总的来说,Speechless方法为低资源语言的语音技术开发带来了新的可能性,尽管还有提升空间,但它已经迈出了重要的一步,为未来的研究和发展铺平了道路。

六、总结与展望

当我们回顾Menlo Research团队的Speechless研究时,可以看到这是一项富有创新性的工作,为低资源语言的语音助手开发提供了一种新的思路和方法。就像是在传统道路堵塞时找到了一条新的捷径,Speechless绕过了对高质量TTS系统的依赖,直接在语义表示层面上工作,为低资源语言的语音技术开发开辟了新的可能性。

研究团队的贡献主要有三个方面:首先,他们提出了Speechless这一新范式,通过与Whisper编码器的语义标记对齐生成指令训练数据,消除了对TTS系统的依赖;其次,他们证明了这种方法对越南语(一种TTS资源有限的语言)的有效性,在没有基于语音的微调的情况下实现了有竞争力的ASR性能;第三,他们发布了第一个预标记化的越南语指令数据集,为语音语言模型的开发提供了支持,填补了低资源NLP领域的一个关键空白。

从实验结果来看,Speechless在多个测试集上表现出色,证明了其方法的有效性。虽然在某些方面还不如最先进的模型,但考虑到它不需要实际语音数据进行训练,这一性能已经相当令人印象深刻。正如研究团队所言,Speechless的方法原则上也可以应用于嘈杂数据,未来的工作将重点放在增强噪音稳健性和扩大适用性到更广泛的语言和方言范围上。

展望未来,Speechless方法为低资源语言的语音技术开发提供了一种新的可能性。随着这一方法的进一步完善和扩展,我们可以期待看到更多低资源语言的语音助手被开发出来,为全球更多的人提供智能语音交互服务。这就像是为数字鸿沟的另一端搭建了一座桥梁,让更多人能够享受到语音技术带来的便利。

对于研究人员和开发者来说,Speechless不仅提供了一种新方法,还提供了可重用的代码和数据集,这为后续的研究和开发提供了宝贵的资源。就像是在科学探索的长征中留下了一个补给站,为后来的探险者提供了支持和帮助。

总的来说,Menlo Research团队的Speechless研究是语音技术领域的一项重要进展,为低资源语言的语音助手开发提供了新的思路和方法。虽然还有一些局限性需要在未来的研究中解决,但它已经为这一领域的发展注入了新的活力和可能性。随着时间的推移和技术的进一步发展,我们可以期待看到更多基于Speechless思想的创新和应用,为全球更多语言的用户带来智能语音交互的体验。

好文章,需要你的鼓励

-

Queen's大学重磅研究:程序员的角色即将彻底改变,从码农到智能体指挥官

Queen's大学研究团队提出结构化智能体软件工程框架SASE,重新定义人机协作模式。该框架将程序员角色从代码编写者转变为AI团队指挥者,建立双向咨询机制和标准化文档系统,解决AI编程中的质量控制难题,为软件工程向智能化协作时代转型提供系统性解决方案。

-

医疗AI的"显微镜革命":西北工业大学团队发布首个超声影像专用智能助手EchoVLM

西北工业大学与中山大学合作开发了首个超声专用AI视觉语言模型EchoVLM,通过收集15家医院20万病例和147万超声图像,采用专家混合架构,实现了比通用AI模型准确率提升10分以上的突破。该系统能自动生成超声报告、进行诊断分析和回答专业问题,为医生提供智能辅助,推动医疗AI向专业化发展。

-

上海AI实验室突破自回归图像生成瓶颈:ST-AR让AI"先理解再创造"

上海AI实验室团队发现自回归图像生成模型存在局部依赖、语义不一致和空间不变性缺失三大问题,提出ST-AR训练方法。该方法通过掩码注意力、跨步骤对比学习和跨视角对比学习,让AI"先理解再生成"。实验显示,ST-AR将LlamaGen模型的图像理解准确率提升一倍以上,图像生成质量提升42-49%,为构建更智能的多模态AI系统开辟新路径。