通过"冷启动"强化学习提升多模态模型的推理能力:上海交大团队的最新研究突破

想象一下,你拥有一个智能助手,这个助手不仅能理解你说的话,还能看懂图片中的内容并解答复杂的数学问题。但问题是,它有时候会答非所问,或者明明看起来在认真思考,却给出错误答案。为什么会这样?如何让这个助手变得更聪明?这正是上海交通大学魏来、李玉婷、郑凯鹏等研究团队在2025年5月发布的最新研究所关注的问题。

这项研究由上海交通大学计算机科学学院、上海创新研究院、中关村研究院和利哈伊大学的研究人员共同完成,并以《通过冷启动强化学习提升多模态推理》为题发表在arXiv预印本平台(arXiv:2505.22334v1)。研究团队为了让拥有视觉和语言能力的大型模型(也就是多模态大语言模型,简称MLLM)变得更擅长解决复杂推理问题,开发了一种全新的训练方法。

在解释这项研究之前,我们先来聊聊背景。近年来,像ChatGPT这样的大语言模型(LLM)展现出了令人印象深刻的推理能力,它们能够一步步分析问题并给出解决方案。这种能力被称为"思维链"(Chain-of-Thought)推理。特别是,当这些模型在解题过程中突然意识到自己的错误并进行自我纠正时,研究人员称之为"啊哈时刻"(aha moment)。许多研究者认为,强化学习(RL)是培养这种能力的关键。

但是,当这种能力被应用到既能看图又能理解文字的多模态模型时,情况变得更加复杂。想象一下,模型不仅要理解文字描述的数学问题,还要看懂题目中的几何图形、图表或表格,然后正确分析并解答。这就像是让一个学生同时应对数学、物理和艺术鉴赏的综合考试,难度陡然提升。

现在,来看看上海交大团队的研究发现和创新方法。

一、"啊哈时刻"的迷思:自我反思不等于真正的思考能力

研究团队首先发现了一个有趣的现象:许多研究者认为强化学习可以让模型产生"啊哈时刻",即模型能够自我反思并纠正错误,这被视为思考能力提升的标志。然而,上海交大团队通过实验发现,这种反思模式实际上在未经强化学习训练的模型中就已经存在!

具体来说,研究团队对Qwen2.5-VL模型进行了测试,发现该模型在回答问题时已经会使用"让我们重新评估"、"让我们重新检查"等反思性表达。更重要的是,他们发现这些看似反思的表达与模型实际推理能力之间并没有正相关关系。

想象一下,这就像一个学生在考试中写道:"等等,我刚才的思路可能有问题,让我重新思考一下..."但实际上,他仍然得出了错误答案。这种表面的自我反思并不能真正提高解题能力。

研究团队举了一个具体例子:当一个模型被问到"在平行四边形ABCD中,如果角B和角D的和为100°,那么角A的度数是多少?"时,模型会先假设一些条件,然后突然说:"这是不正确的,我们需要重新评估问题。"虽然它表现出了反思的迹象,但最终给出的答案仍然是错误的。

这一发现颠覆了之前的普遍观点,表明"啊哈时刻"可能只是一种表面现象,而非真正推理能力提升的证据。研究团队将这种现象形象地比喻为"海市蜃楼"——看起来像是思考能力的提升,实际上可能只是表达方式的变化。

二、冷启动强化学习:两阶段训练的创新方法

基于上述发现,研究团队提出了一种新的训练方法:冷启动强化学习。这种方法包含两个关键阶段:

第一阶段是"冷启动",就像汽车在寒冷的冬天需要先热一会儿发动机才能正常行驶一样。研究团队使用监督微调(Supervised Fine-Tuning,简称SFT)的方法,让模型学习高质量的推理模式。这就像是先给学生提供详细的解题步骤和思考方法,让他们掌握基本的思维框架。

研究团队探索了多种构建"思维链"数据的方法:

1. 蒸馏式思维链(Distilled-CoT):研究团队使用更大的模型(如Qwen2.5-VL-7B和Qwen2.5-VL-32B)生成高质量的思维链回答,然后让较小的模型学习这些思维模式。这就像是让优秀的老师示范解题,然后让学生模仿学习。

2. 反思式思维链(Reflection-CoT):研究团队收集了包含正确和错误回答的数据,并创建了一种两步推理模式。当模型给出错误答案后,添加一段反思性文字(如"等等,让我们从不同角度思考一下..."),然后提供正确答案。这就像教导学生在犯错后如何进行有效的自我纠正。

3. 描述式思维链(Caption-CoT):模型先描述图像内容,再提供答案。这就像教导学生先仔细观察题目中的图形或图表,理解题意后再解答。

4. 自我批评式思维链(Self-Critic-CoT):模型先生成初步答案,然后对自己的回答进行批评性评估,最后提供改进后的最终答案。这就像教导学生如何批判性地审视自己的解题过程。

第二阶段是强化学习,研究团队使用了GRPO(Group-Regularized Policy Optimization)算法。在这个阶段,模型通过不断尝试和获得反馈来优化自己的推理能力。就像一个学生在掌握了基本解题方法后,通过大量练习和反馈不断提升自己的能力。

这种两阶段方法的核心思想是:先给模型提供高质量的推理模式作为基础(冷启动),然后通过强化学习进一步优化和激活这些能力。就像是先教会学生正确的解题方法,然后通过大量练习和反馈帮助他们真正掌握并灵活运用这些方法。

三、实验结果:小模型也能有大智慧

研究团队在四个多模态数学推理基准测试上评估了他们的方法:MathVision、MathVista、MathVerse和We-Math。这些测试涵盖了各种复杂的视觉数学问题,包括几何题、图表分析和表格理解等。

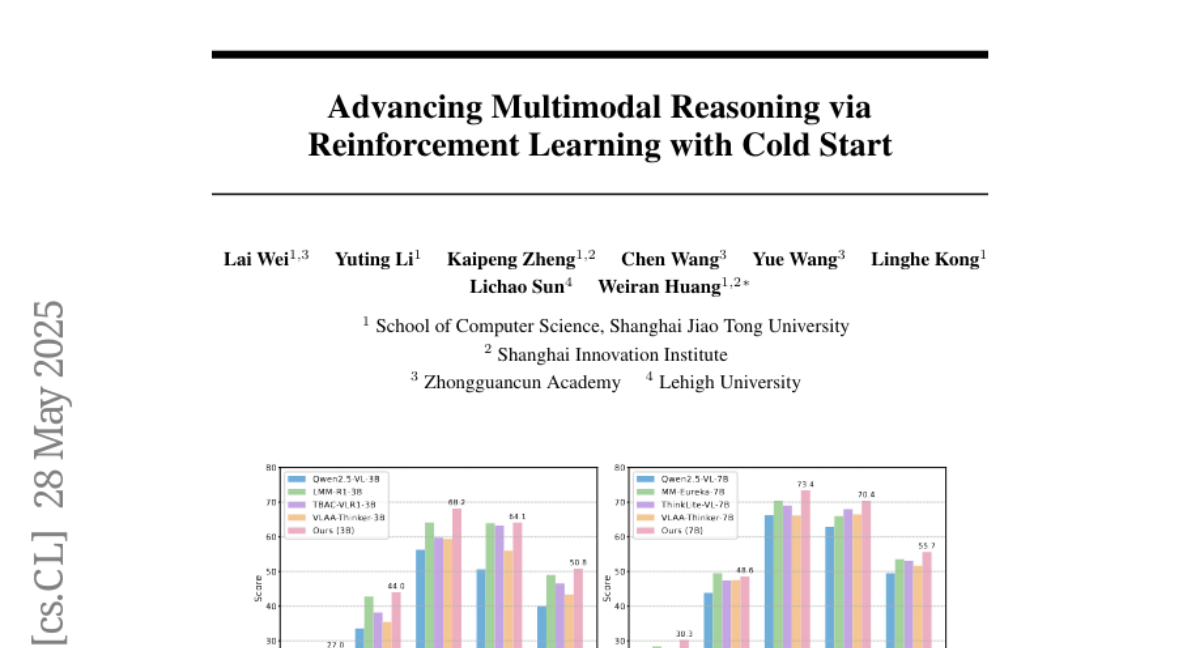

实验结果令人印象深刻。在7B参数规模(相当于较大的模型)上,他们的方法相比基础模型(Qwen2.5-VL-7B)取得了显著提升:在MathVista上从66.3%提升到73.4%,在We-Math上从62.9%提升到70.4%。平均而言,他们的7B模型在所有基准测试上的得分提高了6.19分。

更令人惊讶的是,他们的3B参数规模模型(相当于较小的模型)也取得了出色的表现。平均而言,3B模型的得分提高了10.84分,甚至在某些测试中超过了一些7B规模的模型,如Qwen2.5-VL-7B和VLAA-Thinker-7B。这就像是一个初中生通过有效的学习方法,在某些题目上能够超越高中生的表现!

为了更好地理解"冷启动"和强化学习之间的关系,研究团队进行了大量的消融实验(即移除某些组件来观察效果变化的实验)。他们发现:

1. 单独使用监督微调(SFT)或强化学习(RL)都能提高模型性能,但两者结合效果最佳。这就像学习任何技能一样,理论学习(SFT)和实践练习(RL)相结合才能取得最佳效果。

2. 冷启动阶段的性能与最终模型质量有很强的正相关关系。这表明投资高质量的监督数据是至关重要的。就像是奠定良好的基础知识对学生的长期学习成果至关重要。

3. 从更强大的模型(如32B参数模型)中蒸馏知识,效果优于从较小模型(如7B参数模型)中蒸馏。这就像是向特级教师学习比向普通教师学习更有效。

四、重新审视"啊哈时刻":形式与实质的区别

研究团队还专门设计了实验来重新评估"啊哈时刻"的作用。他们构建了一个只包含展示"啊哈时刻"模式的数据集(Reflection-CoT v2),并与随机选择的32B模型蒸馏数据进行比较。

结果显示,在"啊哈时刻"数据上训练的模型实际上表现不如在随机选择数据上训练的模型。这进一步证明了"啊哈时刻"的表面形式并不能真正提升模型的推理能力。

研究团队还探究了数据质量对模型性能的影响。他们发现,即使使用包含错误答案的数据进行训练,模型仍然能从中学习到有用的推理结构。这表明思维链推理中的结构模式可以独立于解题正确性而被学习。就像学生可以从错误示例中学习解题的逻辑结构,即使答案本身是错误的。

五、研究意义与未来展望

这项研究的意义远超模型性能的提升。它揭示了一个重要洞见:看似高级的反思能力("啊哈时刻")可能只是一种表面现象,而真正的推理能力提升需要更加系统和有针对性的训练方法。

研究团队的两阶段训练方法——先进行监督微调,再进行强化学习——为开发具有高级推理能力的多模态模型提供了一个可行且有效的框架。特别是,他们的方法能够让较小规模的模型(3B参数)达到接近甚至超越某些较大模型(7B参数)的性能,这对于资源受限的应用场景具有重要意义。

未来,这种训练方法可能被应用于各种需要复杂推理的多模态任务,如医学图像分析、科学文献理解、复杂图表解读等。随着模型能力的提升,我们可能会看到更多智能助手能够准确理解并解答涉及文字和图像的复杂问题,为教育、科研和日常生活带来便利。

总的来说,上海交大团队的研究不仅提升了多模态模型的推理能力,还为我们理解和培养人工智能的"思考能力"提供了新的视角。他们的方法就像是为AI提供了一套更系统、更有效的"学习方法",而不仅仅是让AI模仿表面的思考过程。随着这类研究的深入,未来的AI助手可能会更加真正地"理解"我们的问题,而不仅仅是表面上看起来在思考。

有兴趣深入了解这项研究的读者可以通过GitHub(https://github.com/waltonfuture/RL-with-Cold-Start)访问研究团队的代码,或直接查阅原论文(arXiv:2505.22334v1)获取更详细的技术细节。

好文章,需要你的鼓励

-

大语言模型为什么老是"胡编乱造"?OpenAI团队揭开AI幻觉的真相

OpenAI团队的最新研究揭示了大语言模型产生幻觉的根本原因:AI就像面临难题的学生,宁愿猜测也不愿承认无知。研究发现,即使训练数据完全正确,统计学原理也会导致AI产生错误信息。更重要的是,现有评估体系惩罚不确定性表达,鼓励AI进行猜测。研究提出了显式置信度目标等解决方案,通过改革评估标准让AI学会诚实地说"不知道",为构建更可信的AI系统指明方向。

-

ByteDance AI实验室发布重磅研究:让计算机学会"逆向思考",解决创意写作难题

字节跳动AI实验室提出"逆向工程推理"新范式,通过从优质作品反推思考过程的方式训练AI进行创意写作。该方法创建了包含2万个思考轨迹的DeepWriting-20K数据集,训练的DeepWriter-8B模型在多项写作评测中媲美GPT-4o等顶级商业模型,为AI在开放性创意任务上的应用开辟了新道路。

-

电脑终于学会了像人类一样用键盘鼠标:ByteDance推出会玩游戏的AI助手

ByteDance Seed团队开发的UI-TARS-2是一个革命性的AI助手,能够通过观看屏幕并用鼠标键盘操作电脑,就像人类一样完成各种任务和游戏。该系统采用创新的"数据飞轮"训练方法,在多项测试中表现出色,游戏水平达到人类的60%左右,在某些电脑操作测试中甚至超越了知名AI产品,展现了AI从对话工具向真正智能助手演进的巨大潜力。