突破性创新:西湖大学研究团队实现了一秒内完成3D场景艺术风格化重建

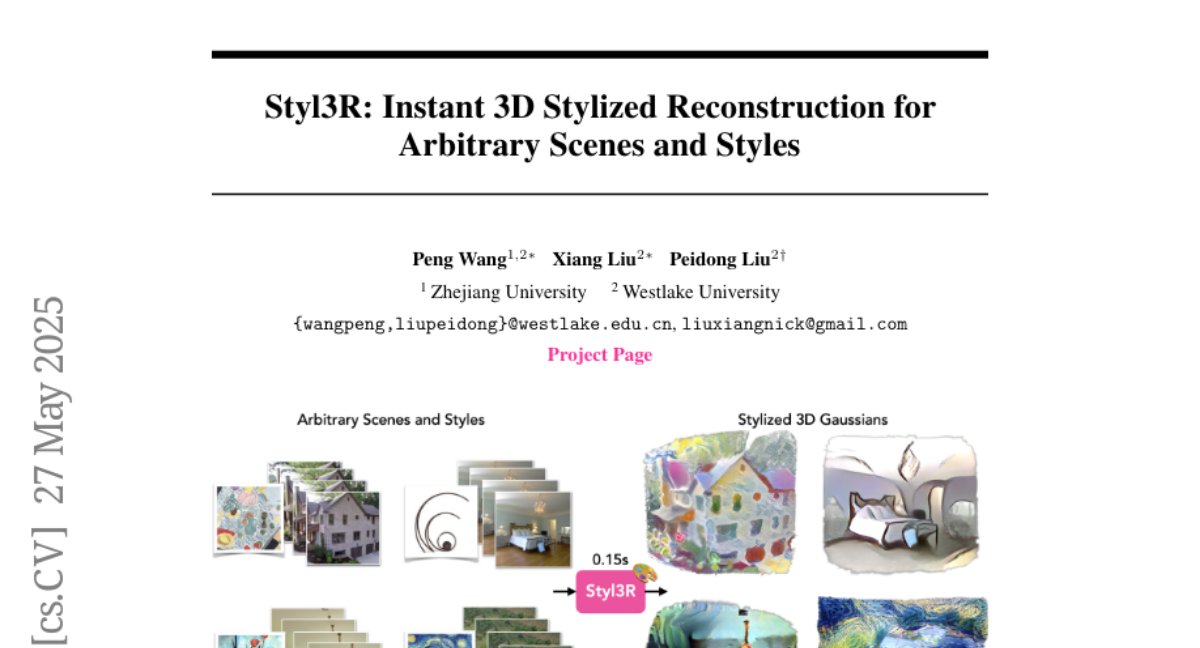

在数字内容创作领域,一项来自中国浙江大学和西湖大学的突破性研究正在改变我们欣赏3D世界的方式。这项名为"Styl3R"的研究由浙江大学的王鹏和西湖大学的刘祥与刘培东(通讯作者)共同完成,并发表于2025年5月的arXiv预印本平台(arXiv:2505.21060v1)。这项研究解决了3D艺术风格化中的一个核心挑战:如何在不到一秒的时间内,仅从几张普通照片和一张艺术风格图片中,创建出风格一致、结构完整的3D艺术场景。

一、为什么3D风格化如此困难?

想象一下,你有几张普通的房间照片,还有一幅梵高的《星空》作为风格参考。你希望将这个普通房间变成一个充满梵高笔触的3D艺术空间,让你可以从任何角度欣赏这个梵高风格的房间。听起来很简单?实际上,这个过程充满了技术挑战。

现有的3D风格化技术面临两大难题。首先,虽然2D图像风格化(比如Instagram滤镜)已经相当成熟,但当我们想把这种技术应用到3D空间时,问题就变得复杂了。如果简单地对每个视角单独应用2D风格化,当你在3D空间中移动时,墙壁上的艺术纹理会忽然变化,给人一种不协调的感觉——就像一个视频中的贴纸在不断抖动一样。

其次,现有的3D风格化方法(如StyleRF、StyleGaussian或ARF)虽然能保持多视角一致性,但它们需要大量的已知相机位置的照片,以及每个场景或每种风格都需要耗时的优化过程,通常需要数小时甚至更长时间。想象一下,你每次想尝试一种新风格,都要等上几个小时,这显然不够实用。

二、Styl3R:艺术与技术的完美结合

Styl3R的名字本身就透露了它的目标:Style(风格)+ 3R(3D重建)。这个系统的神奇之处在于,它只需要2到8张普通的、未标注相机位置的照片,再加上一张任意的风格图像,就能在不到一秒的时间内创建出风格化的3D场景。

王鹏和刘祥团队的关键创新在于他们设计了一个"双分支"网络架构,就像一个有两个专业分工的团队:一个"结构团队"专注于理解场景的3D几何结构,另一个"外观团队"则负责根据参考图像添加艺术风格。这种分离设计确保了风格化过程不会破坏原始场景的结构完整性。

具体来说,这个系统使用了被称为"3D高斯飞溅"(3D Gaussian Splatting)的技术来表示3D场景。如果将3D场景想象成由无数小气球组成,每个气球都有特定的位置、大小、方向和颜色,那么结构分支就负责确定这些气球的位置、大小和方向,而外观分支则决定这些气球的颜色。

通过这种设计,系统可以在保持场景几何结构不变的同时,根据参考图像调整场景的视觉风格,就像给房子换了一层漆,但没有改变房子的结构。

三、独特的训练方法:从现实到艺术的平滑过渡

研究团队采用了一种创新的两阶段训练策略,就像先教会孩子认识现实世界,再教他如何创作艺术作品。

在第一阶段,系统学习如何从少量照片准确重建真实世界的3D场景。这相当于让系统掌握基本的"素描"技能,学会理解空间和物体的结构。在这个阶段,系统的目标是生成看起来尽可能真实的3D场景。

一旦系统掌握了这种基础能力,研究团队就进入了第二阶段:风格化训练。在这个阶段,结构分支被冻结(就像保护好已经画好的素描轮廓),只训练外观分支来学习如何根据参考风格图像调整场景的视觉风格。

这个过程中使用了一个巧妙的"身份损失"技术。简单来说,系统被随机训练以处理两种情况:有时接收艺术风格图像进行风格化,有时接收原始场景照片保持真实外观。这就像教一个画家既能画写实画,也能画印象派作品,灵活切换不同风格。

通过这种训练方法,Styl3R不仅能够创建风格化的3D场景,还能在需要时还原场景的原始真实外观,这使它成为一个真正灵活的系统。

四、突破性的实验结果

研究团队使用了RealEstate10K和DL3DV两个数据集进行训练,这些数据集包含了各种室内和室外场景的视频。对于风格参考,他们使用了WikiArt数据集中的艺术作品。为了测试系统的泛化能力,他们还在完全不同的Tanks and Temples数据集上进行了评估。

实验结果令人印象深刻。在定量评估中,Styl3R在短距离和长距离一致性测试中都优于所有现有方法。简单来说,当你在风格化的3D场景中移动时,墙壁上的艺术纹理会保持稳定,不会像某些方法那样忽然变化。

在视觉质量方面,Styl3R生成的结果展现了风格和内容之间的完美平衡。与StyleRF和StyleGaussian相比,它更好地捕捉了参考风格图像的色调和纹理;与ARF相比,它更好地保留了原始场景的结构细节。例如,在一个客厅场景中,ARF方法使家具因过度风格化而几乎无法辨认,而Styl3R则保持了家具的清晰形状,同时成功应用了艺术风格。

最令人惊叹的是处理速度:Styl3R只需0.147秒即可完成风格化过程,而现有的3D方法需要12分钟到2小时不等。这相当于将处理时间从喝一杯咖啡的时间缩短到眨眼的瞬间。

五、实际应用:风格插值的魔力

除了基本的风格化功能,研究团队还展示了一个有趣的应用:风格插值。想象你有两幅不同风格的艺术作品,比如梵高的《星空》和毕加索的《格尔尼卡》。Styl3R可以在这两种风格之间创建平滑过渡,生成一系列混合风格的3D场景。

实际操作很简单:系统会从两幅风格图像中提取特征,然后按照不同比例混合这些特征,从而创建风格过渡序列。这就像一个DJ混合不同的音乐风格,创造出全新的听觉体验。

这种技术为创意专业人士提供了强大的工具,他们可以探索不同艺术风格的混合效果,发现可能从未见过的视觉表现形式。

六、灵活性:适应不同数量的输入图像

Styl3R的另一个显著特点是其灵活性。虽然系统在训练时使用了4张输入图像,但实际使用时可以处理2到8张不等的输入图像。

当只有2张输入图像时,系统仍能生成令人满意的风格化结果。更有趣的是,当提供8张输入图像时,虽然系统从未见过这么多输入,它仍然能够出色地处理,证明了其泛化能力。

相比之下,只用2张图像训练的模型在处理8张输入图像时会出现问题,如重复的柱子或沙发,这表明它无法正确对齐来自多个视角的信息。

这种灵活性使Styl3R特别适合实际应用场景,因为用户可能有不同数量的可用照片,系统能够适应这种变化。

七、与现有方法的对比:快速、高质量、易使用

为了全面评估Styl3R的性能,研究团队将其与多种现有方法进行了比较。

在2D方法方面,他们选择了AdaIN、AdaAttN和StyTr2作为基准。这些方法首先提取地面真实的新视角图像,然后对每个图像单独应用风格化。虽然这些方法能快速处理单个图像,但它们无法保证多视角一致性,导致在3D场景中移动时出现视觉不连贯。

在3D方法方面,他们比较了ARF、StyleRF和StyleGaussian。这些方法虽然能够保持多视角一致性,但都需要密集的已知相机位置的输入图像和每个场景的优化过程,处理时间从12分钟到2小时不等。

在直观的比较中,2D方法(如StyTr2)在单个图像上产生了视觉上令人愉悦的结果,但在不同视角之间缺乏一致性——例如,一个灯或床单的颜色会在不同视角下显著变化。而3D方法虽然保持了一致性,但StyleRF和StyleGaussian往往产生过度平滑的结果,无法准确捕捉参考风格的色调;ARF虽然能捕捉风格颜色,但往往过度风格化,掩盖了场景细节。

Styl3R则达到了完美的平衡:它既保持了多视角一致性,又准确捕捉了参考风格,同时保留了原始场景的结构细节,最重要的是,它在不到一秒的时间内完成了这一切。

八、局限性与未来发展方向

尽管Styl3R展现了令人印象深刻的性能,研究团队也坦诚承认了其局限性。当前版本仅支持静态场景,无法处理动态对象,如移动的人或动物。在未来的工作中,扩展系统以支持动态场景将是一个重要方向。

另一个可能的改进方向是进一步增强系统的灵活性,使其能够处理更极端的场景和风格组合,或者实现更精细的风格控制,比如只对场景的特定部分应用特定风格。

研究团队相信,随着这些改进的实现,Styl3R将成为内容创作者、设计师和游戏开发者的强大工具,帮助他们更快、更容易地创建风格化的3D内容。

这项研究的意义远不止于学术界。它为虚拟现实、增强现实、游戏设计和电影制作等领域提供了一种快速、高质量的3D风格化解决方案。想象一下,游戏设计师可以在几秒钟内将普通场景转换为各种艺术风格;电影制作人可以快速探索不同的视觉风格;甚至普通用户也可以将自己的家转换为梵高或莫奈风格的虚拟空间。

Styl3R代表了人工智能和计算机图形学结合的未来方向,它不仅提高了内容创作的效率,也扩展了创意表达的可能性。正如研究团队所展示的,技术与艺术的结合可以创造出令人惊叹的新体验,而这仅仅是开始。

好文章,需要你的鼓励

-

大语言模型为什么老是"胡编乱造"?OpenAI团队揭开AI幻觉的真相

OpenAI团队的最新研究揭示了大语言模型产生幻觉的根本原因:AI就像面临难题的学生,宁愿猜测也不愿承认无知。研究发现,即使训练数据完全正确,统计学原理也会导致AI产生错误信息。更重要的是,现有评估体系惩罚不确定性表达,鼓励AI进行猜测。研究提出了显式置信度目标等解决方案,通过改革评估标准让AI学会诚实地说"不知道",为构建更可信的AI系统指明方向。

-

ByteDance AI实验室发布重磅研究:让计算机学会"逆向思考",解决创意写作难题

字节跳动AI实验室提出"逆向工程推理"新范式,通过从优质作品反推思考过程的方式训练AI进行创意写作。该方法创建了包含2万个思考轨迹的DeepWriting-20K数据集,训练的DeepWriter-8B模型在多项写作评测中媲美GPT-4o等顶级商业模型,为AI在开放性创意任务上的应用开辟了新道路。

-

电脑终于学会了像人类一样用键盘鼠标:ByteDance推出会玩游戏的AI助手

ByteDance Seed团队开发的UI-TARS-2是一个革命性的AI助手,能够通过观看屏幕并用鼠标键盘操作电脑,就像人类一样完成各种任务和游戏。该系统采用创新的"数据飞轮"训练方法,在多项测试中表现出色,游戏水平达到人类的60%左右,在某些电脑操作测试中甚至超越了知名AI产品,展现了AI从对话工具向真正智能助手演进的巨大潜力。