大语言模型能从真实世界文本中推断因果关系吗?——一项来自伍斯特理工学院与亚马逊通用人工智能团队的探索

在人工智能飞速发展的今天,一个有趣的问题浮出水面:我们日常使用的大语言模型(LLM),是否真的理解了世界运行的基本规则——因果关系?这项由伍斯特理工学院的Ryan Saklad、Oleg Pavlov、Raha Moraffah与亚马逊通用人工智能部门的Aman Chadha共同完成的研究,发表于2025年5月25日的arXiv预印本平台(arXiv:2505.18931v1),深入探讨了这个关键问题。

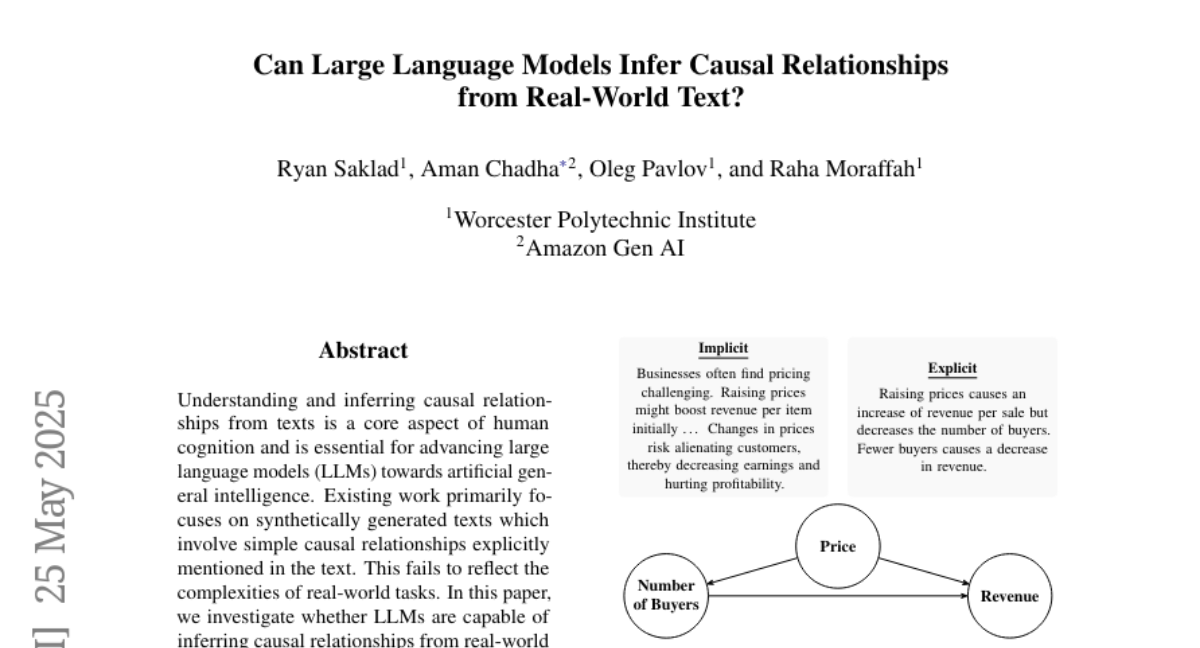

理解因果关系是人类智能的核心特征。当我们阅读"提高价格可能会初期增加单件商品收入...价格变化可能会疏远顾客"这样的文字时,我们能自然地推断出"价格"会影响"客户数量",进而影响"收入"。但大语言模型能做到同样的推理吗?这项研究告诉我们,答案并不乐观。

研究团队发现,以往评估语言模型因果推理能力的方法存在一个重大缺陷:它们通常使用人工合成的简单文本,这些文本中的因果关系往往被明确表述出来。想象一下两种描述同一经济规律的文本:一种直白地说"提高价格导致每次销售收入增加但减少买家数量。较少的买家导致收入下降";另一种则更加隐晦:"企业通常发现定价具有挑战性。提高价格可能最初会提高每件商品的收入...价格变化可能会疏远客户,从而减少收入并损害盈利能力。"后者更接近我们在现实世界中遇到的复杂文本,其中因果关系往往是隐含的,分散在长段落中,需要深入思考才能提取出来。

为了评估语言模型在真实世界条件下的因果推理能力,研究团队创建了一个全新的基准测试集——ReCAST(Realistic Causal Structure from Text)。这是首个基于真实世界学术文献的因果推理数据集,包含了各种复杂度的文本:不同长度、不同显隐程度的因果关系、不同数量的事件和变量,以及来自多个领域和子领域的内容。

研究团队对包括R1、o3-mini、QwQ、Qwen-32B和Llama-8B在内的多个最先进大语言模型进行了测试。结果令人担忧:表现最好的模型(R1)也只达到了0.477的平均F1分数,远低于理想水平。更具体地说,模型在识别显式表述的因果关系时表现尚可,但在处理隐含信息、区分相关因果因素与周围环境细节,以及连接分散在长文本中的相关信息时,表现得极为糟糕。

让我们通过一个例子来理解模型的困境。在一个关于青巴山区生计效率的样本中,文本明确指出:"土地和气候是农业生产的基本条件...因此,阳光、降水和耕地面积被选为代表县域自然资本的指标。"尽管这段文字直白地描述了气候因素与农业产出之间的因果关系,最强大的R1模型仍然无法准确捕捉这些关系。它在推理过程中正确识别了降水是一个相关因素,但在最终的因果图中完全忽略了所有气候驱动因素,甚至创建了一些完全错误的连接。

即使当研究人员向模型提供所有正确的节点名称,只要求它确定节点间的因果关系时,模型的表现也只有微小改善。这表明问题不仅仅出在节点识别上,而是在更深层次的因果推理能力上。

这项研究的意义远超学术界。因果推理是人类智能的基石,也是通往人工通用智能(AGI)的必经之路。如果大语言模型无法从真实世界的文本中准确推断因果关系,它们就无法真正理解世界的运作方式,从而限制了它们在复杂决策场景中的应用。

研究团队创建的ReCAST基准测试集为未来的研究提供了宝贵工具,可以系统地评估和改进语言模型的因果推理能力。通过揭示当前模型的局限性,这项研究为开发下一代更具因果推理能力的AI系统指明了方向。

对于我们普通用户来说,这项研究提醒我们,当前的大语言模型虽然在生成文本方面表现出色,但在理解文本背后的因果关系时仍有显著不足。当我们使用这些模型分析复杂情况或协助决策时,应该保持适当的谨慎。

在未来,随着研究人员不断改进模型的因果推理能力,我们可能会看到更加智能的AI系统,它们不仅能够理解"是什么",还能理解"为什么"——这将是迈向真正智能系统的重要一步。

那么,大语言模型能从真实世界文本中推断因果关系吗?目前的答案是:它们尝试了,但离成功还有很长的路要走。

研究方法:从学术文献到因果图

研究团队设计了一个精心的三步流程来构建ReCAST基准测试集。首先,他们从经济学领域的开放获取期刊(MDPI和PLOS)中收集论文,特别选择包含"因果环路图"这一术语的文献。这个领域特别适合作为基准测试,因为经济学论文通常包含详细的文本描述,同时避免过度依赖非文本元素(如数值数据)。

经过筛选,研究团队确保每篇选定的论文只包含一个主要的因果图,作为评估模型的标准答案。随后,领域专家将这些图转换为标准化的文本格式("源变量" -> "目标变量")。最后,团队进行了严格的后处理,确保数据的质量和准确性。

为了评估模型的表现,研究团队不仅使用了传统的评估指标(如精确率、召回率、F1分数等),还创新性地采用了"LLM作为评判者"的方法。由于传统的图形比较方法难以处理语义相似但表述不同的节点(比如"人"和"人类"),他们使用了一个经过专门提示的语言模型来评估生成图的质量,提供更细致的反馈。

ReCAST最终包含了292个样本,平均每个图包含约25个节点和37条边,平均文本长度超过4万字符,这远超过以往的合成数据集,更真实地反映了现实世界的复杂性。

实验结果:模型的表现与局限

研究团队评估了五个最先进的大语言模型:闭源的o3-mini和开源的R1(685B参数)、Qwen-32B、QwQ-32B以及Llama-8B。测试结果显示,即使是最强大的模型也难以胜任这项任务。

最好的模型R1仅达到0.477的平均F1分数,而最弱的Llama-8B只有0.302。有趣的是,研究发现模型的大小与其表现有明显关联——参数量更大的模型表现更好。同样,专门针对推理能力训练的模型(如R1和QwQ)比一般的指令微调模型表现更佳。

研究还揭示了几个关键的发现:

首先,"混淆度"(一个衡量文本中隐含信息多少的指标)对模型表现有显著影响。当混淆度低于10%(即大多数因果关系在文本中有明确表述)时,R1模型能达到0.57的F1分数;但当混淆度超过50%时,分数骤降至0.31。这表明模型在处理隐含因果关系时特别困难。

其次,令人惊讶的是,输入规模(文本长度、图中的节点和边数量)与模型表现有微弱的正相关。研究者进一步分析发现,这可能是因为较长的文本往往包含更多明确的信息,混淆度较低,因此相对更容易处理。

最后,一个关键的实验是"节点名称辅助"测试——研究团队向模型提供了所有正确的节点名称,只要求模型确定节点之间的因果关系。即使在这种大幅简化的条件下,模型的表现也只有微小改善(R1的F1分数仅提高0.025),这进一步证明问题的核心在于因果推理能力本身,而非实体识别。

研究启示:从人造文本到真实世界

这项研究为AI领域带来了几个重要启示。首先,它挑战了我们对大语言模型能力的认知。尽管这些模型在生成文本和回答问题方面表现出色,但在理解真实世界文本中的因果关系时却显得力不从心。

其次,研究指出了评估AI系统的重要性——我们需要使用真实、复杂的数据来测试模型,而非简化的人造环境。正如一位老练的登山者不会仅在健身房内训练就挑战珠穆朗玛峰,AI系统也需要在真实条件下接受测试。

最后,这项研究为未来指明了方向。要开发真正智能的AI系统,我们需要特别关注因果推理能力的培养。这可能需要新的训练方法、模型架构,甚至是全新的理论框架。

研究也存在一些局限性。例如,基准测试主要基于经济学文献,这可能限制了评估的多样性。此外,尽管研究者尽力确保评估的客观性,但使用LLM作为评判者也可能引入某些偏见。不过,研究者通过与确定性评估方法的对比验证了评估的可靠性。

结论:通往因果AI的漫长道路

这项开创性研究告诉我们,尽管大语言模型取得了令人瞩目的进展,但在理解真实世界文本中的因果关系方面,它们仍有很长的路要走。正如人类孩童需要多年学习才能掌握复杂的因果推理,我们的AI系统也需要更多时间和更好的方法来发展这种核心智能能力。

ReCAST基准测试集为研究社区提供了一个宝贵的工具,可以系统地评估和改进AI系统的因果推理能力。通过揭示当前模型的局限性,这项研究为开发下一代更具因果推理能力的AI系统指明了方向。

归根结底,因果推理是智能的基石,也是通往人工通用智能的必经之路。只有当机器能够真正理解"为什么",而不仅仅是"是什么"时,它们才能开始接近人类的认知能力。这项研究提醒我们,尽管我们在AI领域取得了惊人进展,但真正的智能系统仍然需要更深入的研究和更多的突破。

对于关注AI发展的读者,这项研究提供了一个重要的视角:在为大语言模型的能力惊叹的同时,也应该清醒地认识到它们的局限性。如果你对这项研究感兴趣,可以通过arXiv:2505.18931v1访问完整论文,深入了解ReCAST基准测试集和研究的详细结果。

好文章,需要你的鼓励

-

北航大学团队推出Easy Dataset:让普通人也能制作AI训练数据的神奇工具

北航团队推出Easy Dataset框架,通过直观的图形界面和角色驱动的生成方法,让普通用户能够轻松将各种格式文档转换为高质量的AI训练数据。该工具集成了智能文档解析、混合分块策略和个性化问答生成功能,在金融领域实验中显著提升了AI模型的专业表现,同时保持通用能力。项目已开源并获得超过9000颗GitHub星标。

-

网络安全AI助手:让电脑漏洞危险等级一秒识别的RoBERTa智能系统

卢森堡计算机事件响应中心开发的VLAI系统,基于RoBERTa模型,能够通过阅读漏洞描述自动判断危险等级。该系统在60万个真实漏洞数据上训练,准确率达82.8%,已集成到实际安全服务中。研究采用开源方式,为网络安全专家提供快速漏洞风险评估工具,有效解决了官方评分发布前的安全决策难题。

-

人工智能评判官:xVerify如何解决复杂推理模型的评估难题

中国电信研究院等机构联合开发的xVerify系统,专门解决复杂AI推理模型的评估难题。该系统能够准确判断包含多步推理过程的AI输出,在准确率和效率方面均超越现有方法,为AI评估领域提供了重要突破。

-

只需输入音频就能生成说话人视频?昆仑集团推出的Skywork R1V让AI同时看懂图片和推理数学

昆仑公司Skywork AI团队开发的Skywork R1V模型,成功将文本推理能力扩展到视觉领域。该模型仅用380亿参数就实现了与大型闭源模型相媲美的多模态推理性能,在MMMU测试中达到69.0分,在MathVista获得67.5分,同时保持了优秀的文本推理能力。研究团队采用高效的多模态迁移、混合优化框架和自适应推理链蒸馏三项核心技术,成功实现了视觉理解与逻辑推理的完美结合,并将所有代码和权重完全开源。