精准的记忆手术:研究人员开发PISCES技术,在不影响其他能力的情况下从大语言模型中精确"抹除"概念

**论文基础信息**:这项研究由特拉维夫大学的Yoav Gur-Arieh、Clara Suslik和Mor Geva,纽约大学的Yihuai Hong以及牛津大学和WhiteBox的Fazl Barez共同完成。该论文名为《大语言模型中精确的参数内概念擦除》(Precise In-Parameter Concept Erasure in Large Language Models),于2025年5月28日发表于arXiv(预印本编号:2505.22586v1)。

想象一下,你有一个非常聪明的AI助手,它知道关于《哈利·波特》的一切,但你希望它忘记这些内容——也许是因为版权问题,也许是因为你不希望孩子们通过AI了解这些内容。你该怎么做呢?现有的方法就像是用锤子敲打记忆:虽然能让AI忘记《哈利·波特》,但同时也可能让它忘记其他幻想小说,甚至影响它的整体智能。更糟糕的是,有时这种"遗忘"只是表面的,通过一些技巧,AI仍能回忆起这些内容。

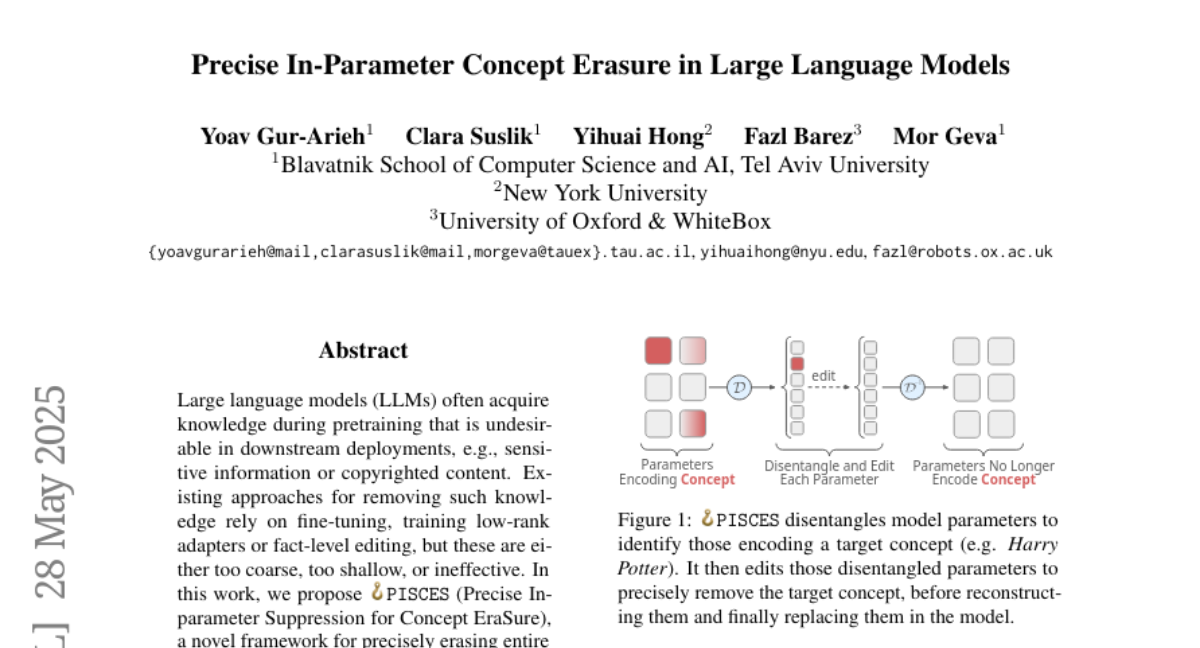

特拉维夫大学和合作伙伴的研究团队提出了一个全新方法,称为PISCES(精确的参数内概念擦除),这就像是一种精确的记忆手术,可以只删除大语言模型中特定的知识,而不影响其他能力。这就好比医生能够精确地只移除大脑中与《哈利·波特》相关的记忆,而不伤及其他记忆或思考能力。

**为什么需要从AI中移除知识?**

大语言模型(如ChatGPT、Gemma或Llama)在训练过程中吸收了互联网上的海量信息,就像一个饥渴的学生吞噬整个图书馆的知识。但这种学习并非总是理想的,有时模型会学到我们不希望它知道的内容:

1. 敏感信息:如个人隐私数据 2. 受版权保护的内容:如特定作品的详细情节 3. 有害内容:如制作危险物品的指南 4. 不适合特定用户的内容:如不适合儿童的主题

当我们想让AI"忘记"这些内容时,现有方法存在两个主要问题:

1. **粗糙性**:它们不仅移除目标知识,还会影响相关甚至不相关的能力,就像想忘记一个人,却连带忘记了整个城市。 2. **浅层性**:表面上看起来已被移除的知识,通过特定提示或微调后仍可恢复,就像把东西藏在地毯下而非真正扔掉。

**PISCES:记忆外科手术的突破**

研究团队开发的PISCES方法就像是记忆的精密外科手术,它直接针对存储知识的神经元参数进行修改。想象你的大脑中有一个个存储不同知识的小抽屉,PISCES能够精确定位存储"哈利·波特"知识的抽屉,然后只清空这些抽屉,而不触碰其他抽屉。

具体来说,PISCES分为三个关键步骤:

**第一步:识别概念相关特征**

首先,研究人员使用一种称为"解缠器"(disentangler)的工具,将语言模型的MLP(多层感知机)向量分解成易于理解的细粒度特征。这就像把一团缠绕在一起的毛线分解成不同颜色的单独线条。这些特征可能表示各种概念,如"哈利·波特"、"足球"或"猫"等。

通过一种称为"词汇投影"的技术,研究人员可以确定哪些特征与目标概念(如"哈利·波特")相关。简单来说,他们看哪些特征会强烈激活与"哈利·波特"相关的单词,比如"魔杖"、"霍格沃茨"或"伏地魔"。

**第二步:识别需要编辑的MLP向量**

找到与目标概念相关的特征后,研究人员确定哪些MLP向量强烈激活了这些特征。想象MLP向量是大脑中的神经元,每个神经元可能参与存储多种知识。PISCES找出那些对"哈利·波特"知识反应特别强烈的神经元。

研究人员发现,不需要编辑所有神经元,只需针对那些最强烈表达目标概念的神经元进行修改。这种选择性编辑最大限度地减少了对模型其他能力的影响。

**第三步:分解、编辑、重构和替换**

最后,对于每个选定的MLP向量,PISCES: 1. 将其分解成细粒度特征 2. 删除或抑制与目标概念相关的特征 3. 重建"清洁"的MLP向量(不再包含目标概念) 4. 将原始向量替换为编辑后的向量

这就像是精确地从神经元中移除特定记忆,同时保留其他所有功能。这种方法与现有方法有本质区别:它不是在模型表面添加"不要谈论哈利·波特"的指令,而是真正从模型的"记忆存储"中移除这些信息。

**PISCES的惊人效果**

研究团队在Gemma-2-2B和Llama-3.1-8B两个模型上进行了广泛测试,评估了PISCES与其他四种先进方法的性能,包括ELM、RMU、MEMIT和AlphaEdit。

测试内容覆盖了11个不同概念,包括"哈利·波特"、"足球"、"爱尔兰共和国"和一些敏感主题如"枪支"和"赌博"。

评估重点考察了四个关键指标:

1. **有效性**:模型是否真的"忘记"了目标概念?在回答相关问题时是否不再提供正确信息?

2. **特异性**:移除目标概念后,模型在其他领域的能力是否保持完好?特别是类似领域(如移除"哈利·波特"后对"魔戒"的了解)和一般知识测试(MMLU测试)。

3. **连贯性**:编辑后的模型是否仍能生成流畅、合理的文本?是否能正确理解并执行指令?

4. **鲁棒性**:当模型在编辑后再次接触与目标概念相关的文本时,是否会"重新学习"已被删除的知识?

结果令人印象深刻:

在Gemma模型上,PISCES将目标概念的正确回答率降至仅14.3%(相比原始模型的100%),同时保持了84.1%的相关领域准确性和97.2%的MMLU测试准确性。这意味着模型几乎"忘记"了所有关于目标概念的知识,但保留了对相关概念和一般知识的理解能力。

在Llama模型上,效果更加显著,将目标概念的准确率降至仅7.7%,同时保持了87.6%的相关领域准确性和99.4%的MMLU测试准确性。

相比之下,其他方法在有效性上表现稍差,且对模型其他能力的影响更大。例如,一些方法可能将目标概念准确率降至15-24%,但同时也将相关领域准确率降至38-77%,显著影响了模型的其他能力。

最令人印象深刻的是PISCES在"鲁棒性"测试中的表现。当编辑后的模型接触与目标概念相关的新文本时,其他方法处理的模型很快"重新学习"了被删除的知识(准确率恢复到79-103%),而PISCES处理的模型则保持较低的准确率(51-65%),证明它真正从模型的"记忆"中移除了这些知识,而非仅仅是表面抑制。

**PISCES如何工作的更深入理解**

为了理解PISCES的成功,研究团队进行了深入分析,发现两个关键因素:

1. **特征质量**:当解缠器能够识别出高度一致且明确表达目标概念的特征时,PISCES的表现最佳。例如,对于"高尔夫"、"爱尔兰共和国"和"棒球"等概念,解缠器找到了非常明确的特征,PISCES因此表现出色。

2. **特征数量**:研究发现,使用较少但高质量的特征往往比使用大量模糊特征效果更好。过多的特征可能导致过度编辑,影响模型在无关领域的表现。

PISCES在计算效率上也表现优异。对于单一概念的编辑,PISCES需要约5×10^14次浮点运算(Gemma模型),与MEMIT和AlphaEdit相当,但比ELM和RMU低一个数量级。更重要的是,当编辑多个概念时,PISCES的效率优势更加明显,因为它的某些步骤(如词汇投影)只需执行一次,可以重复使用。

**现实应用与局限性**

PISCES为AI系统中的知识编辑开辟了新方向,但研究人员也坦诚承认其局限性:

1. 当前实现只针对MLP参数,而最新研究表明注意力头(attention heads)也存储知识,将PISCES扩展到这些组件可能会进一步提高性能。

2. 依赖于稀疏自编码器(SAE)作为解缠器工具引入了一些限制,如只能擦除被捕获为特征的概念,且重构过程可能不完美。未来开发更优的解缠器方法可能会解决这些问题。

3. 基于词汇投影的特征识别在模型早期层中可能不够可靠,结合其他自动解释技术可能会改进整体表现。

**对比PISCES与其他方法的关键优势**

假设我们想让模型"忘记"关于"魁地奇"(《哈利·波特》中的一种虚构运动)的知识。当被问到"什么运动是使用飞天扫帚、鬼飞球和金色飞贼的?"时:

1. **原始模型**会回答:"那是魁地奇,J.K.罗琳《哈利·波特》系列中的虚构运动。"

2. **PISCES处理后的模型**会回答:"听起来像是地板曲棍球!这是因为:飞天扫帚是球员使用的球杆..."(创造性地用现实世界的替代解释)

3. **ELM处理后的模型**可能会回答:"这是一个小谜语!你在想的是魁地奇!这是一种魔法运动,使用飞天扫帚、鬼飞球、游走球和金色飞贼!"(未能完全移除知识)

4. **RMU处理后的模型**可能会回答:"这是一个经典谜语!你描述的运动是魁地奇。原因如下:鬼飞球是游戏中使用的物体..."(同样未能完全移除知识)

这个例子生动地展示了PISCES真正从模型的"记忆"中移除了目标概念,而其他方法只是表面上抑制了这些知识,在特定提示下仍会泄露信息。

**结论与未来展望**

PISCES代表了AI模型知识编辑的重要突破,它能够精确地从模型参数中移除特定概念,同时保持模型的其他能力。这种方法在有效性、特异性和鲁棒性方面都优于现有技术,为AI系统的安全部署和法律合规提供了新的可能性。

未来的研究方向可能包括: 1. 将PISCES扩展到注意力机制和其他模型组件 2. 开发更高效的解缠器工具 3. 探索更复杂概念的擦除,如抽象思想或价值观 4. 结合其他解释技术提高特征识别的准确性

总的来说,PISCES为我们提供了一种精确的"记忆手术"工具,让AI系统能够有选择地忘记特定知识,同时保持其整体能力。这不仅解决了版权和安全问题,也为我们理解AI系统如何存储和使用知识提供了新的见解。

研究团队已经在GitHub上开源了PISCES的代码(https://github.com/yoavgur/PISCES),使研究社区能够进一步探索和改进这一技术。

好文章,需要你的鼓励

-

利用大语言模型探索科学创新前沿:南洋理工大学团队开发检测学术新颖性的突破性方法

这项研究利用大语言模型解决科学新颖性检测难题,南洋理工大学团队创新性地构建了闭合领域数据集并提出知识蒸馏框架,训练轻量级检索器捕捉想法层面相似性而非表面文本相似性。实验表明,该方法在市场营销和NLP领域显著优于现有技术,为加速科学创新提供了有力工具。

-

un?CLIP:通过反转unCLIP来提升CLIP模型的视觉细节捕捉能力

un?CLIP是一项创新研究,通过巧妙反转unCLIP生成模型来增强CLIP的视觉细节捕捉能力。中国科学院研究团队发现,虽然CLIP在全局图像理解方面表现出色,但在捕捉细节时存在不足。他们的方法利用unCLIP生成模型的视觉细节表示能力,同时保持与CLIP原始文本编码器的语义对齐。实验结果表明,un?CLIP在MMVP-VLM基准、开放词汇语义分割和视觉中心的多模态任务上显著优于原始CLIP和现有改进方法,为视觉-语言模型的发展提供了新思路。

-

角色扮演能力大考验:里尔大学研究团队开发的大语言模型角色扮演评估新标准

这项研究介绍了RPEval,一个专为评估大语言模型角色扮演能力而设计的新基准。研究团队从法国里尔大学开发的这一工具专注于四个关键维度:情感理解、决策制定、道德对齐和角色一致性,通过单轮交互实现全自动评估。研究结果显示Gemini-1.5-Pro在总体表现上领先,而GPT-4o虽在决策方面表现出色,但在角色一致性上存在明显不足。这一基准为研究人员提供了一个可靠、可重复的方法来评估和改进大语言模型的角色扮演能力。

-

LegalSearchLM:北大团队打造突破性法律案例检索新方法,将案例检索重新定义为法律要素生成

这篇论文介绍了LegalSearchLM,一种创新的法律案例检索方法,将检索任务重新定义为法律要素生成。研究团队构建了LEGAR BENCH数据集,涵盖411种犯罪类型和120万案例,并开发了能直接生成关键法律要素的检索模型。实验表明,该模型在准确率上超越传统方法6-20%,且在未见犯罪类型上展现出强大泛化能力。这一突破为法律专业人士提供了更高效、精准的案例检索工具。