图视角解密大模型知识结构:俄勒冈大学研究揭示大语言模型如何组织和存储知识

在人工智能快速发展的今天,大语言模型(LLM)已成为我们日常生活中不可或缺的一部分,从回答问题到提供建议,它们似乎无所不知。但你是否曾好奇过:这些模型到底是如何组织和存储知识的?它们的"大脑"里的信息是随机分布的,还是遵循某种特定的结构模式?

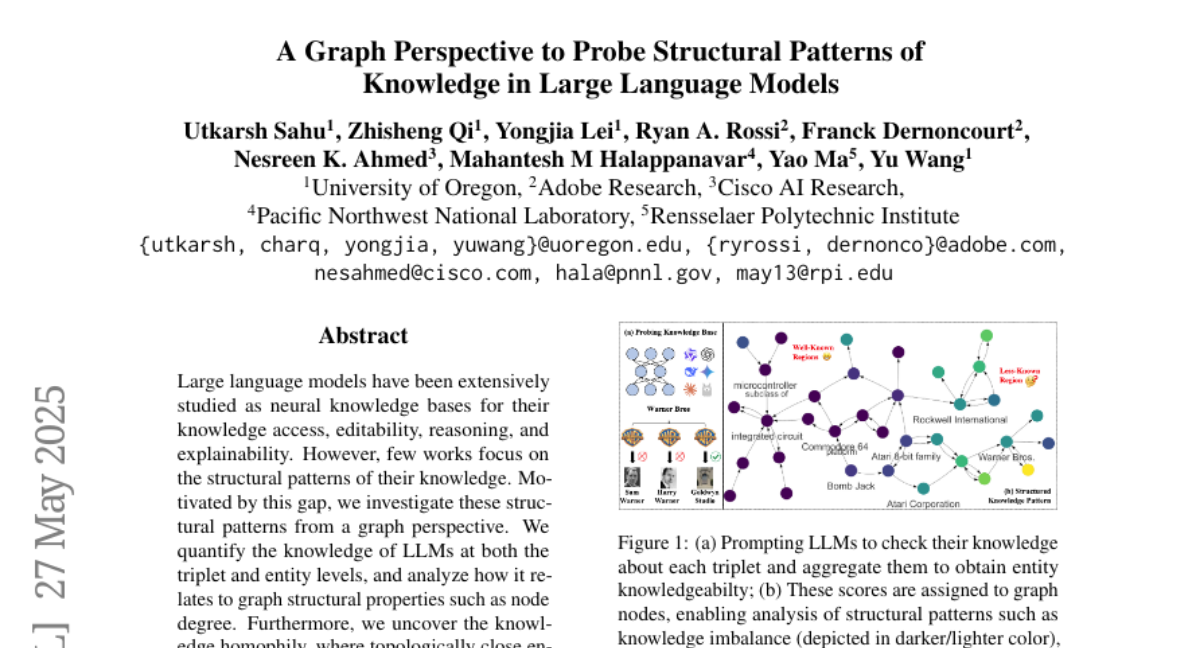

来自俄勒冈大学、Adobe研究院、思科AI研究院、太平洋西北国家实验室和伦斯勒理工学院的研究团队联合发表了一篇题为《图视角探索大语言模型中的知识结构模式》的研究论文。这篇发表于2025年5月的论文(arXiv:2505.19286v2)尝试用一种全新的视角——图论视角——来解密大语言模型的知识结构。

研究团队受到认知神经科学的启发。在人类大脑中,知识并非随机存储,而是形成了精密的结构模式——相关概念会聚集在一起形成语义网络,特定的脑区负责处理特定类型的信息,感官输入则形成拓扑图。研究者猜想:大语言模型或许也存在类似的结构化知识组织模式?

这项研究就像是给大语言模型做了一次"脑部扫描"。研究团队设计了一种方法,不仅可以测量模型对单个事实的了解程度,还能评估它对特定实体(如人物、地点或概念)的整体认知水平。更重要的是,他们发现了大语言模型知识中存在的结构模式,特别是"知识同质性"现象——在知识图谱中拓扑位置相近的实体往往具有相似的知识水平。

基于这些发现,研究团队开发了图机器学习模型,能够基于实体在知识图谱中的位置预测模型对该实体的了解程度。这不仅有助于我们理解大语言模型的内部运作机制,还能指导我们更有效地选择信息来改进这些模型。

让我们一起深入探索这项研究,看看它如何揭示大语言模型的"思维"结构,以及这些发现对AI技术发展的重要意义。

一、研究方法:如何"扫描"大语言模型的知识结构

研究团队面临的第一个挑战是:如何评估大语言模型对知识的掌握程度?这就像是想要测试一个人的知识水平,但不能直接"看到"他的大脑活动一样。

研究人员采用了一种巧妙的方法。想象一下,你有一本百科全书,里面包含了无数的知识陈述,比如"爱因斯坦发明了相对论"或"巴黎是法国的首都"。如果你想测试某人的知识水平,你可以随机挑选一些陈述,问他们这些陈述是对还是错。

研究团队正是采用了类似的方法。他们使用了几个知识图谱数据集,如MVPKG(政治科学知识)、T-Rex(维基百科知识)、PharmKG8K(药物学知识)等。这些知识图谱就像是结构化的百科全书,其中包含了大量的"三元组"知识陈述,每个三元组由主体、关系和客体组成,例如(唐纳德·特朗普,访问了,中国)。

研究人员将这些三元组转化为自然语言陈述,然后"询问"大语言模型(如GPT-3.5、GPT-4o、Gemini-2.5 Flash等)这些陈述是否正确。如果模型回答"True",就表示它认识这个事实;如果回答"False",则表示它不认识。

这样,研究者就能够为每个三元组分配一个"知识得分"——1表示模型认识这个事实,0表示不认识。进一步,他们通过聚合与特定实体相关的所有三元组的知识得分,计算出了该实体的"知识水平得分"。

例如,如果一个知识图谱中有关"巴拉克·奥巴马"的10个事实,而大语言模型能够正确识别其中8个,那么"巴拉克·奥巴马"这个实体的知识水平得分就是0.8或80%。

这种方法不仅允许研究者评估模型对单个事实的认识程度,还能够评估模型对特定实体的整体认知水平。这就像是既能测试学生对单个知识点的掌握,又能评估他们对整个学科的理解一样。

有了这些知识水平得分,研究团队就能够开始探索大语言模型知识的结构模式了。他们把这些得分映射到知识图谱上,就像是给图谱中的每个节点(实体)涂上不同深浅的颜色——知识水平高的实体颜色深,知识水平低的实体颜色浅。然后,他们分析这些"颜色"在图谱中的分布模式,寻找可能存在的规律。

二、知识结构的关键发现:大模型的"大脑"如何组织知识

通过对大语言模型知识结构的深入分析,研究团队发现了几个令人惊讶的模式,这些发现就像是窥探了大模型"大脑"的运作方式。

首先,研究者发现大语言模型的知识水平呈现出三峰分布模式。想象一下,如果我们把所有实体按照知识水平得分(从0到1)排列在一条线上,会发现实体主要集中在三个位置:得分为0的地方(表示模型对这些实体几乎一无所知)、得分为0.5的地方(表示模型对这些实体知道一半左右的相关事实)和得分为1的地方(表示模型对这些实体了如指掌)。这就像是学生的考试成绩分布,有完全不会的、一半一半的和满分的三组人。

更有趣的是,这种分布模式会因知识领域而异。对于一般性知识(如来自维基百科的T-Rex数据集),大语言模型表现出右偏分布——大多数实体的知识水平得分接近1,说明模型对这类常见知识掌握得很好。而对于专业领域知识(如药物学PharmKG8K或政治科学MVPKG),则呈现左偏分布——大多数实体的知识水平得分接近0,表明模型对这些专业知识了解有限。

第二个重要发现是"节点度数与知识水平的正相关"。在图论中,节点的度数表示它与多少其他节点直接相连。研究发现,度数高的实体(即与许多其他实体有关联的"流行"实体)通常具有更高的知识水平得分。这就像是社交网络中的"名人效应"——越是广为人知的人物,大语言模型对它们的了解就越全面。

这个发现很有意义:高度数的实体通常在预训练语料库中出现频率更高,模型有更多机会学习关于它们的信息。举个例子,像"美国"或"巴拉克·奥巴马"这样的热门实体会在各种文本中反复出现,模型自然能够积累大量相关知识。相比之下,小众或专业领域的实体出现频率较低,模型对它们的了解就相对有限。

第三个关键发现是"知识同质性"(knowledge homophily)。研究团队发现,在知识图谱中相互连接的实体往往具有相似的知识水平得分。这就像是"物以类聚,人以群分"——知识图谱中彼此相近的实体,大语言模型对它们的了解程度往往相似。

具体来说,如果计算每个实体与其邻居实体之间知识水平得分的平均差异,会发现这个差异通常很小(同质性得分大多集中在0.8左右,表示高度相似)。这一发现表明,大语言模型的知识并非随机分布在知识图谱中,而是呈现出清晰的结构模式——知识在图谱中形成了"知识岛屿"或"知识社区"。

值得注意的是,当研究者考虑时间信息时(例如"唐纳德·特朗普于2017年11月8日访问中国"这种带时间戳的事实),知识同质性会略有下降。这表明时间维度为知识增加了复杂性,使得邻近实体之间的知识水平差异增大。

这些发现共同揭示了大语言模型知识的结构化特性,表明模型的知识并非随机存储,而是呈现出与人类认知系统类似的组织模式。这不仅帮助我们理解大语言模型如何"思考",还为如何更有效地利用和改进这些模型提供了重要线索。

三、知识预测与模型改进:从发现到应用

研究团队的发现不仅仅是理论上的有趣,它们还具有实际应用价值。基于他们发现的"知识同质性"现象——图谱中相互连接的实体往往具有相似的知识水平——研究者开发了一种基于图神经网络的方法,可以预测大语言模型对特定实体的知识水平。

想象一下,你有一张巨大的知识地图,上面有成千上万的实体(人物、地点、概念等),但你只知道其中一小部分实体的"知识得分"(即大语言模型对它们的了解程度)。基于已知的这部分信息,你能否预测模型对其他未测试实体的了解程度?这就是研究团队尝试解决的问题。

他们使用了图神经网络(GNN)来完成这个任务。简单来说,图神经网络是一种专门处理图数据的深度学习模型,它能够利用节点之间的连接关系提取信息。在这项研究中,GNN通过分析已知实体的知识得分和它们在图谱中的位置关系,学习预测未知实体的知识得分。

研究结果表明,这种方法非常有效。模型预测的知识水平与实际测量结果之间的平均绝对误差仅为0.15-0.25,这意味着预测准确率达到了75%-85%。更有趣的是,基于文本嵌入(将实体名称转换为数值向量)的GNN并没有显著优于使用简单的独热编码(one-hot encoding),这表明实体之间的文本相似性并不能可靠地反映知识水平的相似性。相比之下,图神经网络明显优于多层感知器(MLP),这强调了利用邻域信息对知识水平预测的重要性。

这种预测能力有什么实际用途呢?研究团队展示了一个极具价值的应用:知识检查和模型微调的信息性三元组选择。

传统上,当我们想要通过微调来改进大语言模型的知识时,通常是随机选择一批三元组进行训练。但这种方法可能会浪费资源——如果选中的大多是模型已经掌握的知识,那么微调的效果就会很有限。

研究团队提出了一种更智能的方法:首先随机选择20%的三元组测试模型的知识水平,然后基于这些测试结果训练GNN模型预测所有实体的知识水平。接着,优先选择那些预测知识水平较低的实体相关的三元组进行微调。这就像是针对性补习——重点教学生不懂的知识点,而不是重复他们已经掌握的内容。

实验结果证明,这种基于图的微调方法(Graph-FT)明显优于随机选择三元组的方法(Random-FT)。平均而言,基于图的方法在测试集上的准确率提高了约7个百分点(从62.09%提升到69.04%)。这一成功表明,利用知识图谱的结构信息可以更有效地改进大语言模型的知识。

值得注意的是,这种改进在专业领域知识(如政治科学MVPKG和药物学PharmKG8K)上尤为显著,这正是大语言模型通常表现较弱的领域。例如,在MVPKG数据集上,使用基于图的方法微调Mistral 7B模型,准确率从65.10%提升到了76.70%,提高了11.6个百分点。

这些应用表明,理解大语言模型的知识结构不仅具有理论意义,还能够指导我们更高效地改进这些模型,特别是在专业领域知识方面。

四、研究意义与未来展望:大语言模型知识结构研究的新篇章

这项研究的重要性远超出了对大语言模型知识结构的简单描述。它开创了一种全新的视角来理解和改进大语言模型,为未来的研究和应用打开了多个方向。

首先,从理论角度看,这项研究证实了大语言模型的知识并非随机分布,而是呈现出结构化的模式,这与人类认知系统有某种相似之处。人类大脑中的知识也是结构化组织的——相关概念聚集在一起,形成语义网络;特定的脑区负责处理特定类型的信息;感官输入形成拓扑图等。大语言模型似乎也"自然地"发展出了类似的组织模式,这提示我们,知识的结构化组织可能是高效信息处理系统的普遍特性,无论是生物的还是人工的。

其次,从方法论角度看,这项研究引入了图论视角来分析大语言模型的知识,这是一种创新的跨学科方法。图论提供了一套强大的工具来分析复杂系统中的关系和模式,而这正是理解大语言模型内部知识组织所需要的。研究团队开发的知识水平评估方法和基于图的知识预测模型,为未来的研究提供了有价值的工具和思路。

从应用角度看,研究的发现对改进大语言模型有直接的实用价值。基于图的三元组选择方法证明可以显著提高微调效率,特别是在专业领域知识方面。这对于开发面向特定领域的大语言模型应用具有重要意义。例如,要开发一个医学领域的AI助手,可以利用这种方法更有效地向模型教授医学知识,而不是盲目地灌输大量可能已知或不相关的信息。

此外,研究中发现的知识同质性现象也为知识图谱检索提供了新思路。当我们需要从外部知识库检索信息来辅助大语言模型时,可以优先选择模型知识水平较低的区域,这样能够最大化检索的价值。同样,这一发现也可以用于高效识别知识缺陷——如果我们知道模型对某些实体的知识水平低,那么很可能与这些实体相关的其他实体也存在知识缺陷。

当然,这项研究也存在一些局限性。首先,目前的方法仅适用于具有明确定义的实体和关系的知识图谱,而现实世界的网络通常更复杂,包含丰富的文本信息。未来的研究可以尝试将这种分析扩展到文本属性图等更复杂的数据结构。其次,当前的应用主要集中在微调三元组选择上,而研究发现的结构模式还有更广泛的应用潜力,如指导知识图谱检索和知识缺陷识别等。

未来的研究方向可能包括:探索其他类型的结构模式,如知识的层次结构或时间演化模式;研究不同大语言模型之间知识结构的差异和共性;开发更复杂的基于图的模型来预测和改进大语言模型的知识;探索这些发现在实际应用中的更广泛用途,如对话系统、信息检索和事实核查等。

总的来说,这项研究不仅揭示了大语言模型知识的结构模式,还为如何更有效地理解和改进这些模型提供了新的视角和方法。它标志着大语言模型知识结构研究的一个重要里程碑,为未来的研究和应用开辟了新的可能性。

归根结底,这项研究告诉我们,大语言模型不仅仅是文字的简单处理器,它们内部蕴含着复杂的知识结构,这些结构影响着模型如何获取、存储和使用知识。通过理解这些结构,我们可以更好地利用这些强大的工具,使它们更好地服务于我们的需求。

对于普通用户来说,这意味着未来的AI助手可能会更加智能,特别是在专业领域的知识方面;对于研究者和开发者来说,这提供了一种更有效的方法来改进和定制大语言模型;对于整个AI领域来说,这是向理解人工智能"思维"结构迈出的重要一步。

如果你对这项研究感兴趣,可以访问arXiv:2505.19286v2查阅完整论文,了解更多技术细节和研究发现。

好文章,需要你的鼓励

-

北航大学团队推出Easy Dataset:让普通人也能制作AI训练数据的神奇工具

北航团队推出Easy Dataset框架,通过直观的图形界面和角色驱动的生成方法,让普通用户能够轻松将各种格式文档转换为高质量的AI训练数据。该工具集成了智能文档解析、混合分块策略和个性化问答生成功能,在金融领域实验中显著提升了AI模型的专业表现,同时保持通用能力。项目已开源并获得超过9000颗GitHub星标。

-

网络安全AI助手:让电脑漏洞危险等级一秒识别的RoBERTa智能系统

卢森堡计算机事件响应中心开发的VLAI系统,基于RoBERTa模型,能够通过阅读漏洞描述自动判断危险等级。该系统在60万个真实漏洞数据上训练,准确率达82.8%,已集成到实际安全服务中。研究采用开源方式,为网络安全专家提供快速漏洞风险评估工具,有效解决了官方评分发布前的安全决策难题。

-

人工智能评判官:xVerify如何解决复杂推理模型的评估难题

中国电信研究院等机构联合开发的xVerify系统,专门解决复杂AI推理模型的评估难题。该系统能够准确判断包含多步推理过程的AI输出,在准确率和效率方面均超越现有方法,为AI评估领域提供了重要突破。

-

只需输入音频就能生成说话人视频?昆仑集团推出的Skywork R1V让AI同时看懂图片和推理数学

昆仑公司Skywork AI团队开发的Skywork R1V模型,成功将文本推理能力扩展到视觉领域。该模型仅用380亿参数就实现了与大型闭源模型相媲美的多模态推理性能,在MMMU测试中达到69.0分,在MathVista获得67.5分,同时保持了优秀的文本推理能力。研究团队采用高效的多模态迁移、混合优化框架和自适应推理链蒸馏三项核心技术,成功实现了视觉理解与逻辑推理的完美结合,并将所有代码和权重完全开源。