ReasonGen-R1:微软使用监督微调与强化学习让图像生成模型先思考后创作

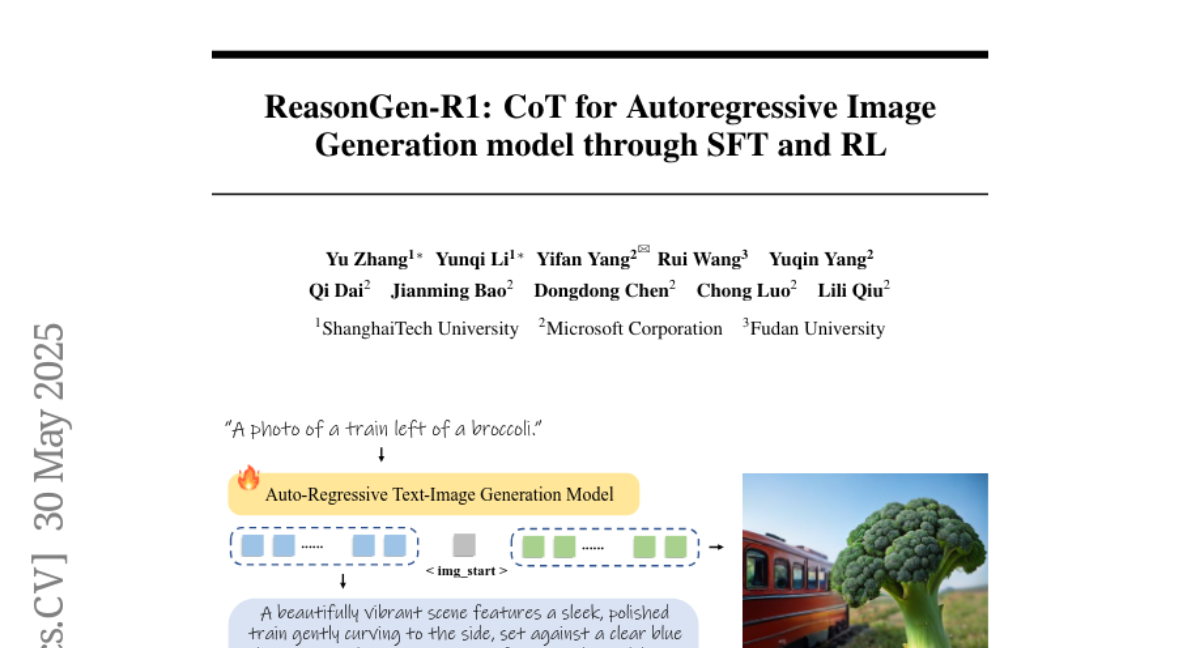

在科技与创意的交汇处,人工智能如何能更像人类一样"思考"后再创作?2025年5月,一个由上海科技大学、微软公司和复旦大学研究人员组成的团队发表了一篇引人注目的研究论文《ReasonGen-R1: CoT for Autoregressive Image Generation model through SFT and RL》。这项研究将链式思考(Chain-of-Thought,简称CoT)和强化学习(Reinforcement Learning,简称RL)这两种在自然语言处理领域取得巨大突破的技术,首次成功应用到了自回归图像生成模型中。有兴趣深入了解的读者可以通过arXiv:2505.24875v1访问完整论文。

一、研究背景:为什么图像生成模型需要"思考"能力?

想象一下,当艺术家创作一幅画作时,他们通常不会立即动笔。相反,他们会先在脑海中构思画面的结构、色彩、光影等元素,考虑如何安排画面中的各个对象,以及整体氛围应该如何表达。这种"先思考后创作"的过程是艺术创作的核心。

然而,目前的图像生成模型大多是直接从文本提示词跳到生成图像,中间缺乏可见的思考过程。即使是像ChatGPT、Gemini和Janus-Pro这样的先进模型,虽然能够生成高质量的图像,但它们的"思考"过程对用户来说仍然是一个黑盒。

微软、上海科技大学和复旦大学的研究团队意识到,如果能让图像生成模型像人类艺术家一样先进行文字形式的思考,再创作图像,这将大大提高模型遵循指令的能力和生成图像的质量。这也是ReasonGen-R1项目的核心目标:让自回归图像生成模型学会自主产生文本推理序列,然后基于这些推理生成高质量图像。

二、面临的挑战:如何教会图像模型"思考"?

实现这一目标面临两大挑战。首先,目前主流的自回归图像生成模型(如Janus-Pro)通常是直接从文本提示词生成图像,而没有同时产生文本推理的能力。如果直接使用强化学习方法,可能会因为模型本身缺乏推理能力而效果不佳。

想象一下,这就像是试图教一个从未学过步法的人直接跳高难度舞蹈动作——在没有基础的情况下,高级训练往往效果有限。

第二个挑战是,目前学术界还没有一套成熟的框架,能够在自回归图像生成模型中有效地实现"基于思考的生成"过程。这需要研究人员开发新的方法和技术。

三、ReasonGen-R1的创新方案:两阶段训练方法

为了解决这些挑战,研究团队提出了一个名为ReasonGen-R1的两阶段训练框架,巧妙地结合了监督微调(Supervised Fine-Tuning,简称SFT)和强化学习(RL)。

第一阶段是监督微调(SFT)。就像先教会舞者基本步法一样,研究团队首先需要让模型学会如何生成文本推理。为此,他们构建了一个大规模数据集,包含20万对样本,每个样本包含指令、推理文本和相应图像。这些样本是通过从LAION美学数据集筛选出的图像,并使用GPT-4.1-mini生成丰富的链式思考(CoT)推理轨迹精心创建的。

在训练过程中,研究团队采用了"指令→CoT→图像"的管道,同时监督文本推理序列和图像输出。这有点像教导学生:看到题目(指令)后,先写下解题思路(CoT),再给出最终答案(图像)。通过这种方式,模型逐渐学会了生成连贯的推理文本,并基于这些推理生成相应的图像。

第二阶段是强化学习(RL)。这一阶段使用了一种名为群组相对策略优化(Group Relative Policy Optimization,简称GRPO)的强化学习框架。研究团队使用强大的图像理解模型Qwen-2.5-VL作为奖励模型,评估生成图像与原始提示词之间的一致性。

具体来说,对于每次训练尝试,研究团队会让模型生成一个完整序列:提示词→推理→图像。然后,奖励模型会评估生成的图像与提示词的一致性,给出二元一致性分数(0或1)。这些分数会反馈给模型,引导它调整自己的推理方式,从而生成更符合提示词要求的图像。

值得一提的是,研究团队发现,当文本和图像输出交替进行时,强化学习训练极易出现"熵爆炸"(模型输出过于随机)或"熵消失"(模型输出过于固定)的问题。为了解决这个问题,他们引入了一种独特的自适应熵损失设计,确保训练过程稳定有效。

四、数据集的精心构建:思考的原材料

任何AI模型的训练都离不开高质量的数据。为了教会模型"思考",研究团队需要构建一个包含大量<指令,推理,图像>三元组的数据集。

这个过程可以类比为给孩子提供学习材料:我们需要题目(指令)、解题思路(推理)和正确答案(图像)三部分,才能教会孩子如何思考。

研究团队首先从LAION美学V1数据集中选择了20万张图像。由于基础模型Janus-Pro只能生成正方形图像,团队将每张图像的长边裁剪为与短边相同的长度,得到正方形输出。

接下来,他们使用GPT-4.1 mini为每张图像生成一个简洁的标题,重点关注图像中物体的颜色、数量、位置等关键细节。然后,他们使用GPT-4.1 nano基于这个简洁标题生成多种增强提示词,包括一组图像标签、以物体为中心的短语、三个改写版本的简洁标题,以及一个用不同风格编写的变体标题。

同时,他们还生成了一个详细的标题,提供更全面的图像描述。值得注意的是,这个详细标题仅基于简洁标题生成,而非直接从图像生成,这确保了GPT-4.1不会引入图像中的额外信息,防止在SFT训练过程中出现信息不一致的问题。

通过这种方法,研究团队构建了一个高质量、多样化的数据集,包含简洁标题、增强的简洁标题和详细标题与图像的配对。

五、监督微调:教会模型如何思考

大多数自回归生成器目前生成文本和图像是分开的序列,需要用户明确指示才能切换模态。这就像是一个厨师需要被告知"现在开始切菜",然后再被告知"现在开始炒菜",而不能自然地完成整个烹饪过程。

在监督微调阶段,研究团队解决了这一限制。他们训练模型首先生成一个连贯的推理理由,然后自然地过渡到图像合成,所有这些都在一个连续序列中完成。团队以Janus-Pro-7B作为基础模型,该模型使用特殊的图像开始标记来触发视觉输出。

如图1所示,每个训练序列以简洁的图像提示词开始,然后是详细的推理说明。接着插入图像开始标记和相应的图像标记。通过这种格式,模型学会了在自动发出图像开始标记和生成最终图像之前,先生成详细的推理理由。

六、强化学习:优化思考的质量

监督微调让模型学会了基本的思考能力,但如何确保这些思考能够引导生成高质量、符合指令的图像呢?这就是强化学习阶段的任务。

群组相对策略优化(GRPO)在增强LLM模型的推理能力方面已经显示出强大的能力。为了进一步使生成的图像与文本推理和输入提示保持一致,研究团队将GRPO调整用于图像生成。

不同于原始GRPO中基于规则的奖励,评估提示词和生成图像之间的一致性很难有预定义的黄金规则。为了解决这个问题,研究团队使用强大的视觉语言模型Qwen-2.5-VL 7B作为奖励模型。

在每次推理中,生成模型会产生单一序列:提示词→推理→图像。研究团队仅通过查询预训练的视觉语言模型来评估输入文本和输出图像之间的一致性,从而计算生成图像的奖励。为了给前面的推理步骤提供信用,他们将图像级奖励向后传播到整个序列,强化那些产生高质量视觉输出的文本推理。

这有点像训练一个学生:不仅要看最终答案是否正确,还要看解题思路是否合理。通过这种方式,模型不仅学会了生成高质量的图像,还学会了生成能够引导高质量图像创作的推理文本。

七、实验结果:思考后的图像更符合指令

那么,ReasonGen-R1的表现如何呢?研究团队在多个基准测试上对模型进行了评估,包括GenEval、DPG-Bench和T2I-Benchmark。

在GenEval基准测试中,ReasonGen-R1达到了0.86的总体分数,比基线模型Janus-Pro-7B的0.80高出了6个百分点。特别是在位置和颜色属性方面,ReasonGen-R1分别获得了0.84的高分,而Janus-Pro-7B只有0.79和0.66。

在DPG-Bench基准测试中,ReasonGen-R1的总体分数为85.88,比Janus-Pro-7B的84.19高出1.69个百分点。在全局、实体、属性和关系各个方面,ReasonGen-R1都取得了更好的表现。

最令人印象深刻的是在T2I-Benchmark上的表现,ReasonGen-R1在属性绑定方面表现突出,尤其是在颜色(0.8321)和纹理(0.7295)属性上,比Janus-Pro-7B分别高出0.1962和0.2359。总体而言,ReasonGen-R1在复杂属性方面的得分为0.3909,比Janus-Pro-7B的0.3559高出13.38%。

这些结果清楚地表明,通过引入链式思考和强化学习,ReasonGen-R1显著提高了自回归图像生成模型的指令遵循能力和图像质量。

八、链式思考的内容分析:模型如何思考?

研究团队对ReasonGen-R1的链式思考内容进行了深入分析,发现了一些有趣的模式。

首先,模型通常会先锚定场景的高层框架——"感觉"、"场景"和"自然"等词汇在超过140%的思考链中出现,强调整体背景和现实设置。然后,它会精细调整视觉风格:如"柔和"、"突出"、"情绪"和"光滑"等词汇(所有出现率均超过100%)来指定光照质量、情感基调和纹理。

关键的是,"突出"和"强调"(至少在70%的思考链中出现)的存在表明模型在显式规划构图焦点。这揭示了ReasonGen-R1不仅仅是描述物体,它还在积极规划构图重点。

除了核心词汇外,ReasonGen-R1还利用大量不太常见的修饰词——"背景"建立环境背景;"特征"突出显著的视觉元素;"平静"唤起宁静的氛围;"时刻"传达时间捕捉的感觉;"捕捉"强调摄影现实感等——为每个推理序列注入微妙的、特定于上下文的细微差别。

总体而言,这种分析表明ReasonGen-R1的链式思考利用了互补的组件——场景框架、风格细节、主题突出和叙述丰富——协同引导图像生成。

九、消融实验:各个组件的重要性

为了理解SFT和RL阶段各自的贡献,研究团队进行了详细的消融实验。

结果显示,ReasonGen-R1显著优于仅使用RL的基线(没有SFT),在GenEval基准测试中高出18个百分点。这表明SFT阶段为基础模型提供了进行适当交错推理和生成的引导。

然而,仅使用SFT的变体表明,SFT本身并不足够,因为GPT注释的CoT轨迹并不总是代表最有利于高质量图像合成的推理轨迹。尽管如此,没有SFT和没有RL之间的差距表明,SFT使模型能够探索多样化的思考路径;随后的RL阶段对于释放这种潜力,充分实现"思考和生成"的动机,并实现最终性能提升至关重要。

研究团队还发现,奖励模型的大小对RL的效果有显著影响。使用Qwen-2.5-VL-3B作为奖励模型VLM进行比较时,较小的VLM无法提供良好的奖励信号,导致RL后的性能不佳。这表明使用大型且准确的奖励模型对于RL算法至关重要。

十、自适应熵损失的稳定作用

研究团队还发现,在RL训练过程中,模型容易出现熵爆炸或熵消失的问题,导致模式崩溃。为了解决这个问题,他们引入了自适应熵损失。

如图4所示,没有熵损失的RL在100个训练步骤后经历了熵爆炸,导致性能下降。另一方面,应用固定的熵惩罚-0.002导致熵持续下降,在步骤80时达到危险的低水平,导致模式崩溃和奖励急剧下降。

相比之下,研究团队的自适应熵损失有效地将熵维持在最佳范围内,确保了训练的稳定性。这就像是一个自动调节的温度控制系统,既不让锅太热导致沸腾溢出,也不让锅太冷导致无法烹饪。

十一、视觉化结果展示:直观感受思考的力量

研究团队还展示了ReasonGen-R1的一些生成示例,直观地证明了链式思考对图像生成的积极影响。

例如,当给定提示词"一张自拍的蒙娜丽莎"时,ReasonGen-R1先生成了一段思考:"柔和的自然光照亮了一个温暖、诱人的场景,一个人自信地站在令人惊叹的风景前。在他们身后,起伏的山丘和茂密的植被创造了一个宁静、和平的背景...",然后才生成最终图像。这种思考过程帮助模型规划场景的整体结构和氛围,使最终生成的图像更加协调和符合提示词的要求。

另一个例子是当给定提示词"多伦多的鸟瞰图,CN塔楼清晰可见,河流明显地将城市景观一分为二"时,ReasonGen-R1通过详细的思考过程,成功生成了一张CN塔楼醒目、河流清晰分割城市的俯瞰图像。

这些案例直观地展示了链式思考如何帮助模型更好地理解和执行复杂的视觉指令,生成更符合用户期望的图像。

十二、结论与未来展望

ReasonGen-R1证明了将链式思考和强化学习整合到自回归图像生成模型中的巨大潜力。通过先"思考"再"创作",模型在指令遵循和图像质量方面都取得了显著进步。

虽然取得了令人鼓舞的结果,但这项研究也有一些局限性。首先,当前的评估主要集中在特定的基准测试上,可能无法完全代表现实世界任务的多样性。其次,依赖大型预训练模型(如GPT-4.1)可能会引入数据偏见,影响生成输出的鲁棒性和公平性。最后,虽然研究团队实施了自适应熵损失来缓解模式崩溃,但这个参数对特定任务的敏感性还需要更好地理解。

未来的研究方向包括探索更多样化的数据集,开发更精细的奖励机制,以及将这种思考能力扩展到更多的多模态任务中。

总的来说,ReasonGen-R1为图像生成模型的发展开辟了一条新路径,向着更接近人类艺术家"先思考后创作"的方向迈进。正如微软和上海科技大学的研究团队所展示的,通过赋予模型思考能力,我们可以得到更符合人类期望、更富有创意的AI生成内容。

论文作者计划在未来发布他们的数据集和训练代码,以促进这一研究领域的持续发展。对于那些对AI创意生成感兴趣的开发者和研究人员来说,这无疑是一个值得关注的领域。

好文章,需要你的鼓励

-

如何让AI像电影配乐师一样创作完整的长篇音频故事——腾讯ARC实验室团队AudioStory突破性进展

腾讯ARC实验室推出AudioStory系统,首次实现AI根据复杂指令创作完整长篇音频故事。该系统结合大语言模型的叙事推理能力与音频生成技术,通过交错式推理生成、解耦桥接机制和渐进式训练,能够将复杂指令分解为连续音频场景并保持整体连贯性。在AudioStory-10K基准测试中表现优异,为AI音频创作开辟新方向。

-

Meta与特拉维夫大学联手打造VideoJAM:让AI生成的视频动起来不再是奢望

Meta与特拉维夫大学联合研发的VideoJAM技术,通过让AI同时学习外观和运动信息,显著解决了当前视频生成模型中动作不连贯、违反物理定律的核心问题。该技术仅需添加两个线性层就能大幅提升运动质量,在多项测试中超越包括Sora在内的商业模型,为AI视频生成的实用化应用奠定了重要基础。

-

上海AI实验室重磅发布:让AI看图"说人话"的神奇训练法,解决多模态AI与人类价值观对齐难题

上海AI实验室发布OmniAlign-V研究,首次系统性解决多模态大语言模型人性化对话问题。该研究创建了包含20万高质量样本的训练数据集和MM-AlignBench评测基准,通过创新的数据生成和质量管控方法,让AI在保持技术能力的同时显著提升人性化交互水平,为AI价值观对齐提供了可行技术路径。

-

谷歌研究团队发布超级预测模型:让AI像天气预报员一样预测全球大气变化

谷歌DeepMind团队开发的GraphCast是一个革命性的AI天气预测模型,能够在不到一分钟内完成10天全球天气预报,准确性超越传统方法90%的指标。该模型采用图神经网络技术,通过学习40年历史数据掌握天气变化规律,在极端天气预测方面表现卓越,能耗仅为传统方法的千分之一,为气象学领域带来了效率和精度的双重突破。