全方位保护:华盛顿大学与微软联合开发的OMNIGUARD,一种跨模态AI安全防护的高效方法

华盛顿大学的Sahil Verma、Luke Zettlemoyer、Jeff Bilmes、Hila Gonen与微软的Keegan Hines、Charlotte Siska、Chandan Singh团队在2025年5月29日发表了一篇题为"OMNIGUARD: An Efficient Approach for AI Safety Moderation Across Modalities"的研究论文,该论文已上传至arXiv预印本平台(arXiv:2505.23856v1)。这项研究提出了一种全新的方法,用于保护大型语言模型免受有害使用的威胁,特别是那些通过低资源语言或非文本模态(如图像和音频)进行的攻击。

随着大型语言模型(LLMs)能力的不断提升,人们对这些模型可能被滥用的担忧也日益增长。目前主流的安全防护方法是检测用户向模型提交的有害查询。然而,现有的检测方法存在漏洞,特别容易受到那些利用模型能力"不匹配泛化"的攻击。什么是不匹配泛化?想象一下,你学会了用英语识别危险情况,但当有人用你不太熟悉的语言向你描述同样危险的情况时,你可能无法识别出其中的危险。同样,当今的语言模型在训练过程中接触到的安全数据通常不如预训练数据那样多样化,这就导致了模型的安全防护能力在某些情况下(如低资源语言或图像、音频等非文本模态)存在漏洞。

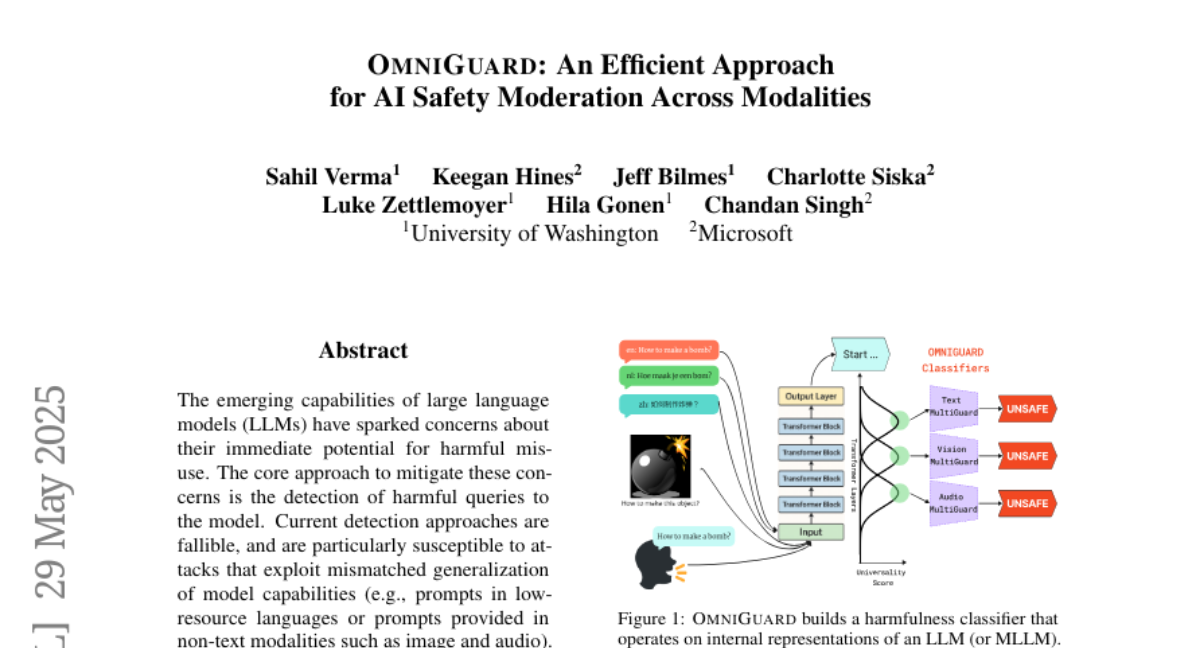

OMNIGUARD正是为解决这一问题而生。这个方法就像是给AI配备了一副能看穿各种伪装的特殊眼镜,无论攻击者使用什么语言或以什么形式(文本、图像或音频)提出有害请求,OMNIGUARD都能有效识别并阻止。更令人惊喜的是,与其他需要单独运行的防护模型相比,OMNIGUARD直接利用模型内部已有的表示(即计算过程中产生的中间数据),使其速度比最快的基准方法快约120倍,效率大大提升。

研究团队的实验结果令人振奋:在多语言环境中,OMNIGUARD比最强的基准方法高出11.57%的准确率;对于基于图像的有害提示,准确率提高了20.44%;对于基于音频的有害提示,更是创造了新的性能记录。这意味着,无论攻击者使用什么语言或以何种形式提出有害请求,OMNIGUARD都能更好地保护AI系统免受滥用。

接下来,让我们一起深入了解OMNIGUARD的工作原理,以及它如何有效防御跨语言和跨模态的安全威胁。

一、OMNIGUARD的核心思想:发现通用表示

OMNIGUARD的核心思想非常巧妙,它基于一个重要发现:大型语言模型和多模态大型语言模型在处理信息时,会在内部生成某些具有"通用性"的表示,这些表示在不同语言和不同模态之间保持相似。这就像人类大脑在处理不同语言或不同感官输入(如视觉、听觉)时,最终会形成某种与具体表达形式无关的共通理解。

为了更好地理解这一点,我们可以想象一个简单的例子:无论你用英语说"狗"(dog),用法语说"chien",用中文说"狗",或者看到一张狗的图片,甚至听到狗叫声,你的大脑最终都会识别出"这是关于狗的信息"。同样,大型语言模型在内部也会形成这种跨语言、跨模态的通用表示。

OMNIGUARD的第一步就是找到这些通用表示。研究团队开发了一种名为"通用性分数"(U-Score)的指标来衡量模型内部各层表示的通用程度。具体来说,他们会用英语句子及其在其他语言中的翻译来测试模型:如果一层的表示能够使翻译对(即同一句话的不同语言版本)之间的相似度高于随机句子对之间的相似度,那么这一层就具有良好的跨语言通用性。

研究人员通过大量实验发现,在模型的中间层(而非开始层或结束层)中,这种通用表示最为明显。对于Llama3.3-70B-Instruct模型来说,第57层(共81层)的通用性分数最高,这意味着该层的表示最适合用于构建跨语言的有害内容检测器。同样,对于图像-文本对,研究人员在Molmo-7B模型的第22层(共28层)发现了最佳的通用表示;对于音频-文本对,则是在LLaMA-Omni 8B模型的第21层(共32层)。

这一发现非常重要,因为它为构建能够跨语言、跨模态工作的有害内容检测器奠定了基础。就像一个翻译官能够理解不同语言表达的相同含义,或者一个多感官专家能够从视觉和听觉信息中提取共通内容,OMNIGUARD利用模型内部的这种通用表示能力,构建了一个能够识别各种形式有害内容的强大检测器。

二、OMNIGUARD的实现方法:轻量级检测器

找到具有高通用性的模型层后,OMNIGUARD的第二步是基于这些层的输出构建一个轻量级的有害内容检测器。这个检测器采用了一个简单但有效的多层感知机(MLP)结构,包含两个隐藏层(隐藏层大小分别为512和256)。

这就像是在模型的"思维过程"中安装了一个专门的"危险雷达",它直接利用模型已经形成的通用理解,无需重新处理输入信息,就能有效识别出潜在的有害内容。这种设计使得OMNIGUARD非常高效,因为它复用了模型在生成过程中已经计算出的表示,完全避免了将输入通过单独的防护模型的开销。

在训练阶段,研究团队使用了Aegis AI Content Safety数据集中的2,800个样本(其中包含良性和有害内容各半),这比其他基准方法使用的训练数据少了约18倍。对于文本实验,他们将这些英文样本翻译成了其他52种自然语言和20种密码语言(如base64编码、凯撒密码等),总共覆盖了73种语言。对于图像实验,他们使用了来自JailBreakV-28K和VLSafe数据集的约3,500对图像-查询对进行训练。对于音频实验,他们使用开源的Kokoro模型将文本样本转换为语音。

值得注意的是,OMNIGUARD只使用一半的语言进行训练,剩余的语言用于测试泛化能力。这就像是教会一个人识别几种语言中的危险信息,然后测试他是否能够在从未学习过的语言中同样识别出危险。

在推理阶段,当用户向模型提交一个查询时,OMNIGUARD会应用这个轻量级检测器到模型的内部表示上,几乎不增加任何额外的计算开销。这种设计使得OMNIGUARD比基准方法快约120倍,极大地提高了安全检测的效率。

三、实验设置与基准比较

为了全面评估OMNIGUARD的性能,研究团队设计了一系列严格的实验,涵盖了多语言文本、图像和音频三种模态。

在多语言文本防护方面,研究人员将OMNIGUARD与多种流行的防护模型进行了比较,包括LlamaGuard、AegisGuard、WildGuard等。特别值得一提的是,他们还比较了专门为多语言有害内容检测而设计的DuoGuard和PolyGuard模型。实验使用了各种多语言基准,如MultiJail(10种语言)、XSafety(10种语言)、RTP-LX(28种语言)等,以及将英语基准(如HarmBench、Forbidden Questions等)翻译成73种语言的版本。

在图像防护方面,研究人员将OMNIGUARD与Llama Guard 3 Vision、VLMGuard和LLavaGuard等基准模型进行了比较。实验使用了多种图像攻击基准,包括Hades、VLSBench、MM-SafetyBench等,以及使用不同变体(如旋转、镜像、单词替换等)加密的有害提示的MML Safebench基准。

在音频防护方面,由于缺乏现有的音频有害内容检测基准,研究人员主要使用了VoiceBench和AIAH数据集,并将文本基准转换为语音版本进行测试。为了提供上下文,他们将OMNIGUARD的性能与直接对音频转录文本进行分类的方法进行了比较。

这些实验设置就像是为OMNIGUARD设计的一系列严格的"安全检查员考试",考察它在各种情况下识别有害内容的能力。通过这些全面的测试,研究人员能够全面评估OMNIGUARD的性能,并与现有方法进行公平比较。

四、令人印象深刻的实验结果

OMNIGUARD在各种测试中展现出了卓越的性能,显著优于现有的防护方法。让我们一起来看看这些令人印象深刻的结果。

在多语言文本防护方面,OMNIGUARD在多语言基准测试中达到了86.36%的平均准确率,比最强的基准方法(PolyGuard,83.19%)高出3.17个百分点。特别是在MultiJail、RTP-LX和AyaRedTeaming这三个基准上,OMNIGUARD创造了新的最高性能记录。值得注意的是,PolyGuard使用了约191万个训练样本,而OMNIGUARD仅使用了约10.3万个样本,这表明OMNIGUARD的数据效率要高得多。在翻译成73种语言的英语基准上,OMNIGUARD同样表现出色,达到了84.85%的平均准确率,远高于PolyGuard的66.07%。在未见过的语言上,OMNIGUARD也展现出了强大的泛化能力,准确率达到81.88%,明显优于经过微调的DuoGuard(37.1%)和PolyGuard(75.13%)。

这就像是一场多语言安全检测的比赛,OMNIGUARD不仅在已知语言中表现出色,还能够有效地应对从未学习过的语言,展现出了强大的"听懂外语"能力。

在图像防护方面,OMNIGUARD在图像-查询对基准上达到了95.44%的平均准确率,远高于VLMGuard的88.74%和LlamaGuard 3 Vision的47.36%。在加密文本的图像基准上,OMNIGUARD同样表现出色,达到了79.76%的平均准确率。唯一的例外是MML Base64基准,这是一种使用base64编码加密文本的图像攻击,所有模型在这一基准上都表现不佳。

这就像是一场"看图识别危险"的比赛,OMNIGUARD能够有效识别出隐藏在图像中的各种形式的有害内容,无论是直接的图像-文本组合还是加密在图像中的文本。

在音频防护方面,OMNIGUARD在各个基准上都取得了高准确率,从82.03%到98.85%不等,平均准确率超过90%。由于缺乏现有的音频有害内容检测基准,研究人员将OMNIGUARD的性能与直接对音频转录文本进行分类的方法进行了比较,结果表明OMNIGUARD在音频形式下的性能与文本形式相当甚至更好。

这就像是一场"听声辨危险"的比赛,OMNIGUARD展现出了出色的"听力理解"能力,能够有效识别出隐藏在语音中的有害内容。

此外,研究人员还评估了OMNIGUARD在适应新型攻击方面的数据效率。他们发现,OMNIGUARD只需要少量样本就能迅速适应新的代码攻击形式,在接触不到5个样本后就能达到接近100%的准确率。相比之下,基准防护模型即使在获得更多样本后也难以迅速适应。

这就像是一场学习新技能的比赛,OMNIGUARD展现出了惊人的"学习速度",只需要很少的示例就能迅速掌握识别新型攻击的能力。

总体而言,这些实验结果充分证明了OMNIGUARD在跨语言和跨模态安全防护方面的卓越性能,它不仅准确率高,而且适应性强,数据效率高,推理速度快,是一种全面优秀的AI安全防护解决方案。

五、深入分析与见解

通过对实验结果的深入分析,研究团队获得了一些重要的见解,帮助我们更好地理解OMNIGUARD的工作原理和优势。

首先,研究人员进行了消融实验,比较了使用不同层的表示训练OMNIGUARD分类器的效果。他们发现,使用U-Score选出的最佳层(第57层)训练的分类器性能明显优于使用其他层(如第10层、第75层或最后一层)训练的分类器,提高了5%到14%的准确率。这证实了通用性分数(U-Score)在选择最适合跨语言和跨模态任务的模型层方面的有效性。

这就像是找到了大脑中负责"跨语言理解"的特定区域,利用这个区域的活动可以更准确地判断不同语言表达的内容是否有害。

其次,研究人员分析了OMNIGUARD的效率优势。由于OMNIGUARD直接利用模型在生成过程中已经计算出的表示,它的推理时间比最快的基准方法(DuoGuard)快约120倍。具体来说,在处理AdvBench数据集(涵盖英语、西班牙语、法语、泰卢固语和base64编码)时,OMNIGUARD的平均推理时间仅为0.04秒,而DuoGuard为4.85秒,LlamaGuard 3为87.25秒,PolyGuard为409.90秒。这种显著的效率优势使得OMNIGUARD非常适合实时应用场景。

这就像是一个已经阅读过内容的人可以立即判断内容的安全性,而不需要重新阅读一遍。OMNIGUARD利用模型已经"看过"的内容直接做出判断,大大节省了时间。

第三,研究人员分析了OMNIGUARD在不同语言上的性能与底层LLM在这些语言上的情感分类准确率之间的关系。他们发现,这两种准确率大体上是相关的,表明OMNIGUARD的防御能力与模型对该语言的理解能力有关。自然语言的准确率普遍高于密码语言,这是符合预期的。然而,即使在模型对某种语言的理解接近随机猜测(50%)的情况下,OMNIGUARD仍然能够取得相当高的有害内容检测准确率,这表明它能够有效利用有限的语言理解来识别潜在的有害内容。

这就像是一个人即使对某种外语只有很基础的了解,也能从说话的语气、关键词和上下文中大致判断出是否存在潜在危险。OMNIGUARD同样能够从有限的语言理解中提取足够的信息来识别有害内容。

最后,值得注意的是,OMNIGUARD在应对新型攻击方面表现出了出色的数据效率。在适应代码攻击的实验中,OMNIGUARD只需要不到5个样本就能达到接近100%的准确率,而基准防护模型即使在获得更多样本后也难以迅速适应。这种快速学习能力是OMNIGUARD的重要优势,使其能够有效应对不断演变的安全威胁。

这就像是一个学习能力极强的学生,只需要看几个例子就能掌握新知识,并迅速应用到实际问题中。OMNIGUARD的这种快速适应能力使其在面对新型攻击时具有显著优势。

六、应用潜力与局限性

OMNIGUARD展现出了广泛的应用潜力,同时也存在一些局限性。让我们一起来看看这个创新方法可能的应用场景和需要注意的限制。

在应用方面,OMNIGUARD可以用于保护各种开源LLM和MLLM免受有害使用。它特别适合那些需要处理多语言输入或多模态输入(如图像、音频)的应用场景。例如,多语言聊天机器人、内容审核系统、在线教育平台等都可以受益于OMNIGUARD的保护。由于其高效率(比基准方法快约120倍),OMNIGUARD特别适合需要实时响应的应用,如在线客服系统、实时内容审核等。此外,OMNIGUARD的数据效率也使其非常适合资源受限的场景,或需要快速适应新型安全威胁的应用。

想象一个全球在线教育平台,需要同时应对来自不同国家、使用不同语言的学生,并支持文本、图像和音频等多种交互形式。OMNIGUARD可以帮助这个平台有效识别和过滤各种形式的有害内容,保护学生免受不良信息的影响,同时不会显著增加系统的计算负担或响应延迟。

然而,OMNIGUARD也存在一些局限性。首先,它的性能依赖于底层模型对语言或模态的理解能力。如果底层模型对某种语言或输入形式的理解很差,OMNIGUARD可能无法有效识别其中的有害内容。不过,这一局限性也存在于其他防护方法中,并不是OMNIGUARD特有的问题。

其次,OMNIGUARD需要访问模型的内部表示,这使得它只适用于开源模型或能够提供内部表示访问的模型。对于闭源模型或API形式提供的模型,OMNIGUARD可能无法直接应用。

第三,尽管OMNIGUARD在多种基准测试上表现出色,但在某些特定攻击形式(如MML Base64基准)上仍有改进空间。这表明某些高度加密或混淆的攻击形式仍然可能绕过OMNIGUARD的检测。

最后,研究人员也指出,他们的评估基于现有的标准基准,实际应用中的性能可能会有所不同。此外,尽管OMNIGUARD在防止LLM有害使用方面迈出了重要一步,但它并不是一个完美的分类器,可能存在意外失败的情况,导致LLM被有害滥用。

总的来说,OMNIGUARD代表了AI安全防护领域的重要进展,为保护LLM和MLLM免受有害使用提供了一种高效、准确的解决方案。尽管存在一些局限性,但其在跨语言和跨模态防护方面的优势使其成为当前最先进的安全防护方法之一。

七、总结与未来展望

OMNIGUARD代表了AI安全防护领域的一项重要创新,它通过识别模型内部具有通用性的表示,构建了一个能够有效检测跨语言和跨模态有害内容的轻量级分类器。实验结果表明,OMNIGUARD在多语言文本、图像和音频防护方面都取得了显著的性能提升,同时保持了极高的效率和数据效率。

说到底,OMNIGUARD的核心创新在于它找到了一种巧妙的方式,让AI系统能够理解不同语言和不同形式表达的相同含义,就像一个精通多国语言且具备多感官理解能力的安全专家,能够识别出隐藏在各种表达形式背后的潜在威胁。这种能力对于构建安全、可靠的AI系统至关重要,特别是在当今这个全球化、多模态的交互环境中。

未来的研究方向可能包括进一步提高OMNIGUARD在高度加密或混淆攻击形式上的性能,探索在闭源模型或API形式提供的模型上应用类似方法的可能性,以及将OMNIGUARD的思想扩展到更广泛的安全防护任务中。随着AI技术的不断发展和应用场景的不断扩大,像OMNIGUARD这样的安全防护方法将发挥越来越重要的作用,帮助我们构建更安全、更可靠的AI系统。

对于关注AI安全的研究人员、开发者和决策者来说,OMNIGUARD提供了一个重要的参考案例,展示了如何利用模型内部表示的通用性来构建高效、准确的安全防护机制。这种方法不仅适用于当前的LLM和MLLM,也为未来更复杂、更强大的AI系统的安全防护提供了有价值的思路。

有兴趣深入了解OMNIGUARD的读者可以访问研究团队的GitHub仓库(https://github.com/vsahil/OmniGuard)获取代码和数据,或通过arXiv(arXiv:2505.23856v1)阅读完整论文。

好文章,需要你的鼓励

-

利用大语言模型探索科学创新前沿:南洋理工大学团队开发检测学术新颖性的突破性方法

这项研究利用大语言模型解决科学新颖性检测难题,南洋理工大学团队创新性地构建了闭合领域数据集并提出知识蒸馏框架,训练轻量级检索器捕捉想法层面相似性而非表面文本相似性。实验表明,该方法在市场营销和NLP领域显著优于现有技术,为加速科学创新提供了有力工具。

-

un?CLIP:通过反转unCLIP来提升CLIP模型的视觉细节捕捉能力

un?CLIP是一项创新研究,通过巧妙反转unCLIP生成模型来增强CLIP的视觉细节捕捉能力。中国科学院研究团队发现,虽然CLIP在全局图像理解方面表现出色,但在捕捉细节时存在不足。他们的方法利用unCLIP生成模型的视觉细节表示能力,同时保持与CLIP原始文本编码器的语义对齐。实验结果表明,un?CLIP在MMVP-VLM基准、开放词汇语义分割和视觉中心的多模态任务上显著优于原始CLIP和现有改进方法,为视觉-语言模型的发展提供了新思路。

-

角色扮演能力大考验:里尔大学研究团队开发的大语言模型角色扮演评估新标准

这项研究介绍了RPEval,一个专为评估大语言模型角色扮演能力而设计的新基准。研究团队从法国里尔大学开发的这一工具专注于四个关键维度:情感理解、决策制定、道德对齐和角色一致性,通过单轮交互实现全自动评估。研究结果显示Gemini-1.5-Pro在总体表现上领先,而GPT-4o虽在决策方面表现出色,但在角色一致性上存在明显不足。这一基准为研究人员提供了一个可靠、可重复的方法来评估和改进大语言模型的角色扮演能力。

-

LegalSearchLM:北大团队打造突破性法律案例检索新方法,将案例检索重新定义为法律要素生成

这篇论文介绍了LegalSearchLM,一种创新的法律案例检索方法,将检索任务重新定义为法律要素生成。研究团队构建了LEGAR BENCH数据集,涵盖411种犯罪类型和120万案例,并开发了能直接生成关键法律要素的检索模型。实验表明,该模型在准确率上超越传统方法6-20%,且在未见犯罪类型上展现出强大泛化能力。这一突破为法律专业人士提供了更高效、精准的案例检索工具。