从令牌到行动:状态机推理减轻信息检索中的过度思考

Seoul国立大学计算机科学与工程学院的Dohyeon Lee、跨学科人工智能项目的Yeonseok Jeong以及同时隶属于这两个部门的Seung-won Hwang教授(通讯作者)于2025年5月29日发表了一篇题为《From Token to Action: State Machine Reasoning to Mitigate Overthinking in Information Retrieval》的研究论文。这篇发表在arXiv预印本平台上的研究(编号为2505.23059v1)探讨了如何解决大型语言模型在信息检索中的过度思考问题。

大型语言模型(LLM)的思维链(Chain-of-Thought,简称CoT)提示已经成为增强复杂推理的强大工具,特别是在信息检索(IR)领域。想象一下,当你向搜索引擎提问"什么是LLM?"时,系统需要理解你的意图并找到最相关的信息。传统的搜索方式可能仅仅匹配关键词,但使用CoT推理的模型会像人类一样思考:"用户想知道LLM是什么,这是一个缩写,我应该解释它代表'大型语言模型',可能还需要提供更多背景信息..."

然而,研究团队发现,这种思维链方法经常导致"过度思考"问题——模型生成冗长且语义重复的推理步骤,不仅没有实际帮助,有时甚至会产生负面影响。就像一个过分热心的朋友,在回答你简单问题时不停地解释、重复、偏离话题,最终让你感到困惑而非清晰。

研究者确定了信息检索中两个关键挑战:一是冗余轨迹,模型反复回到类似的状态;二是误导性推理,推理过程偏离用户意图。想象一下,如果你问"什么是LLM?",模型可能先解释缩写,然后考虑用户可能想了解更多,尝试改写查询,反复思考几个选项,最终可能偏离到讨论LLM的应用场景,而非你最初想知道的定义。

为了解决这些问题,研究团队提出了状态机推理(State Machine Reasoning,简称SMR)框架。这是一种基于转换的推理框架,由三个离散动作组成:精炼(REFINE)、重新排序(RERANK)和停止(STOP)。就像导航系统一样,SMR不会像传统思维链那样不停地"思考路线",而是根据当前状态直接决定下一步行动:是修改当前路线(精炼查询),调整目的地优先级(重新排序结果),还是已经达到目标可以停止导航。

在BEIR和BRIGHT这两个基准测试中的实验表明,SMR不仅提高了检索性能(nDCG@10)3.4%,更令人印象深刻的是同时减少了74.4%的令牌使用量。简单来说,它不仅找到了更好的答案,还用了更少的计算资源。更重要的是,这种方法在不同的语言模型和检索器之间表现稳定,无需任务特定的调整,为传统CoT推理提供了一种实用的替代方案。

一、理解过度思考问题:为何高效推理在信息检索中如此重要

想象一下你在拥挤的图书馆寻找一本特定的书。传统的搜索方式相当于你按照书名直接查找目录。而思维链(CoT)推理则像是一个图书管理员帮你思考:"这本书可能在哪个分类下?作者是谁?它可能与哪些相关主题放在一起?"这种思考过程对于找到复杂问题的答案非常有价值。

然而,过度热心的图书管理员可能会陷入无休止的思考:"这本书可能在科幻区,不过也可能被归类在幻想文学,或者因为作者的背景也可能在传记区,但考虑到内容也可能在科学区..."这就是研究团队所说的"过度思考"问题。

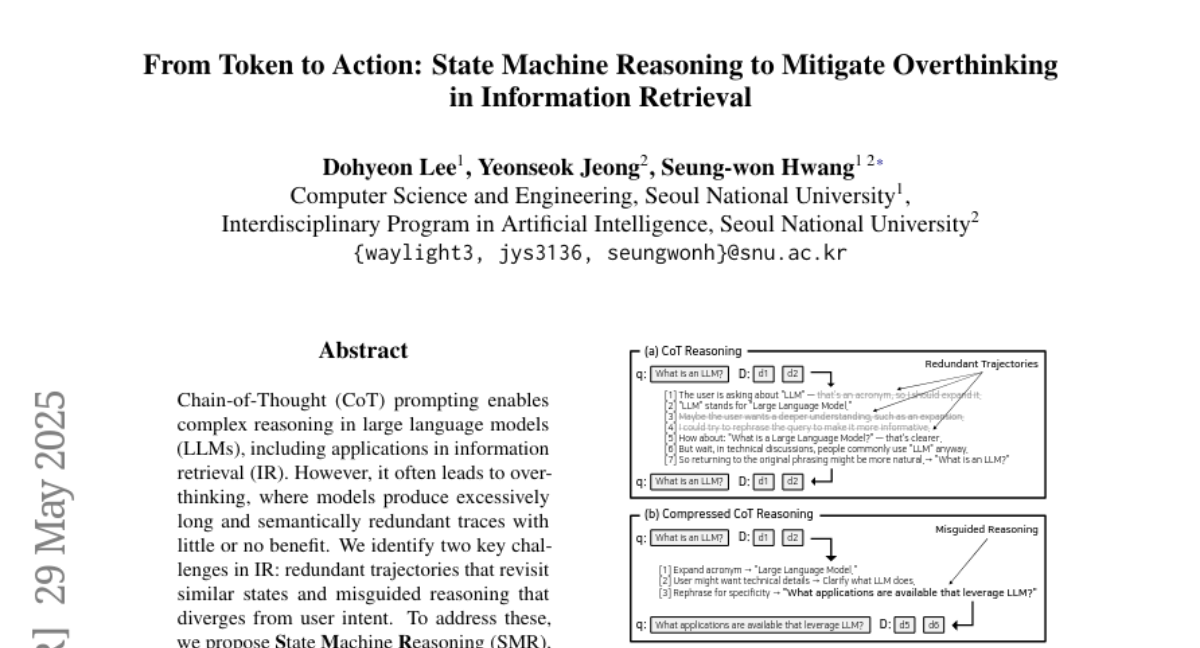

研究者发现,在信息检索领域,CoT推理面临两个主要挑战。首先是冗余轨迹问题。如图1(a)所示,当模型试图理解"什么是LLM?"这个查询时,它可能会生成许多语义上重复的步骤:"LLM是一个缩写,代表Large Language Model",然后思考"用户可能想要更深入的理解",接着考虑重新表述查询,最终又回到原始表述。这些冗余步骤会消耗大量计算资源,却没有引入任何新的证据来改善检索结果。

第二个挑战是误导性推理。一些方法尝试通过强化学习压缩CoT轨迹,如O1-Pruner。如图1(b)所示,这种压缩可能导致语法上简洁但语义上偏离的查询,例如将"什么是LLM?"改写为"哪些应用程序利用LLM?"。这种偏离会导致检索到不相关的文档,如图中的d5和d6,完全违背了用户原始的定义查询意图。此外,这种压缩方法需要任务特定的训练和奖励工程,限制了其泛化能力。

二、状态机推理:一种结构化的解决方案

为了应对这些挑战,研究团队提出了状态机推理(SMR)框架。想象你在使用一个智能导航系统——不是那种不停喃喃自语思考所有可能路线的系统,而是一个清晰告诉你"转弯"、"直行"或"到达目的地"的系统。SMR就是这样一个框架,它将推理简化为三个明确的动作:精炼查询、重新排序结果或停止推理。

如图1(c)所示,SMR将每一步表示为状态(q, D)之间的转换,其中q表示当前查询,D表示检索到的文档排序列表。比如,初始状态可能是查询"什么是LLM?"和一些初步检索到的文档d1、d2。模型首先选择REFINE动作展开缩写,将查询更新为"什么是大型语言模型?",这样能检索到更多相关文档如d3和d4。接着,它选择RERANK动作,识别出d3是最相关的文档并将其移到结果列表的顶部。最后,当模型确定进一步推理不会产生增益时,它选择STOP动作结束过程。

这种设计带来两个关键优势。首先是令牌效率。传统的令牌级生成方法缺乏识别语义重复的机制,而SMR通过在显式定义的状态上操作,避免了冗余推理。每一步都更新一个结构化状态,使系统能够检测何时回到等效状态,从而实现早期停止。

其次是动作有效性。通过将每个推理步骤基于IR相关操作,SMR使检索系统能够通过两个明确的动作做出改进:REFINE用于查询重写,RERANK用于文档重新排序。这些动作使系统能够在当前结果不足时重新发出查询,或在初始排名不理想时重新排序文档。这种设计支持增量检索改进,并精确控制在每一步调整管道的哪个组件。相比之下,令牌级生成缺乏对每一步改进的明确验证,可能导致偏离用户意图的输出。

三、SMR框架的技术实现:从概念到实践

研究团队将SMR框架设计为马尔可夫决策过程(MDP),具有离散动作空间和结构化状态表示。虽然他们没有显式学习价值函数,但设计灵感来自决策理论框架,其中每个推理步骤对应于抽象状态之间的转换。

在这个框架中,推理状态被表示为结构化元组(qt, Dt),其中qt表示当前查询,Dt是检索到的前k个文档的排序列表。初始状态s0 = (q0, D0)使用用户发出的查询q0和从静态检索器获得的相应文档D0构建。随后的推理步骤更新查询或文档列表,产生结构化状态的轨迹。

为了避免冗余推理并减轻过度思考,SMR采用停止机制,检测系统何时已达到等效状态。具体来说,如果当前状态st = (qt, Dt)中的检索文档与之前状态相同且查询保持不变,则将st视为等同于st-1。这确保状态转换反映增量改进而非冗余循环。

SMR的动作空间包含三个离散动作:REFINE、RERANK和STOP。REFINE动作更新查询以更好地反映用户的信息需求,由当前检索上下文引导。每次REFINE后,使用更新的查询qt+1调用检索器获取新的候选文档。如果检索到的任何文档尚未出现在Dt中,则将它们附加到当前列表的末尾,确保检索状态的有意义演化而不丢弃现有上下文。

RERANK动作调整文档列表的顺序而不修改查询。它在初始检索不完美时细化文档排名,允许更好的相关性估计同时保持查询固定。为了解决重新排序过程中可能出现的幻觉问题,研究者对输出施加结构约束。如果重新排序的列表包含原始Dt中不存在的文档,这些条目将被丢弃;如果列表遗漏了原始集中的任何文档,则按原始顺序重新附加缺失项,确保跨转换保持检索状态的完整性。

STOP动作终止推理过程,返回当前状态st = (qt, Dt)作为最终输出。这允许系统在达到足够检索质量后避免不必要的步骤,提高令牌效率并防止语义漂移。除了语义等价外,还设置了推理步骤的硬上限(通常为16步)来控制推理成本,确保在资源有限的部署场景中的稳健性。

在每个推理步骤中,系统根据当前状态(qt, Dt)选择三个可用动作之一。研究者采用基于提示的策略,由LLM本身作为评估当前推理上下文并选择最合适下一步的评委。提示描述了代理的角色——负责改善检索结果质量的决策者,并以结构化格式呈现当前查询及其关联文档。

图2展示了整个流程的工作方式。从初始查询"什么是LLM?"开始,通过初始检索获取文档[d1, d2]。在第一步中,模型选择REFINE动作,将缩写扩展为完整名称,并给出理由"使用完整名称"。这导致了新查询"什么是大型语言模型?"并检索到更多文档[d1, d2, d3, d4]。接着,模型执行RERANK动作,注意到"d3看起来最相关",将文档重新排序为[d3, d1, d2, d4]。最后,模型选择STOP动作,理由是"我们已经有足够的信息",终止推理过程。

四、实验验证:SMR在实际检索任务中的表现

研究团队在两个基准测试上验证了SMR的有效性:BRIGHT和BEIR。BRIGHT是一个专为评估推理密集型检索场景设计的最新基准,包含12个子集,涵盖多样化领域如StackExchange论坛、编程问题和STEM问答任务,查询通常需要领域特定推理来识别相关段落。BEIR则是一个广泛使用的基准,包括多样化领域(如事实问答、生物医学搜索和以实体为中心的检索),主要衡量一般检索性能。

研究者使用nDCG@10作为主要评估指标,遵循标准IR实践。实验中比较了SMR与多种基线:传统稀疏检索器BM25、为通用推理任务专门训练的最先进密集检索器ReasonIR、基于CoT的推理模型Rank1和Rank-R1,以及基于RL的方法O1-Pruner。为确保公平比较,团队在不同能力的LLM(Qwen2.5-32B和QwQ-32B)上进行了实验。

表1和表2展示了在BRIGHT基准上使用不同检索器(BM25和ReasonIR)的实验结果。在所有12个领域中,SMR一致优于标准和压缩的CoT基线。特别是,SMR在使用稀疏检索器时平均nDCG@10提高了5.4%,在使用密集检索器时提高了2.1%,证明了其结构化推理框架在复杂检索场景中的高效性,无论底层LLM如何。

图3呈现了SMR在BRIGHT基准上选择的推理动作分布。每个条形代表REFINE和RERANK动作的相对频率。研究者观察到SMR并不遵循固定模式或静态启发式,而是根据每个任务的不同推理需求调整动作选择。在初始检索结果相对信息丰富的领域(如Bio、Earth、Econ),模型主要使用RERANK调整文档排序,同时保持原始查询不变。相比之下,在初始检索结果最差的领域(如TheoT、AoPS、Pony、TheoQ),表现出更高比例的REFINE动作,在某些情况下高达70%。

这种模式与底层检索难度强烈相关。面对有限的初始证据,SMR自适应地运行多轮查询细化,尝试在停止前呈现更好的文档。这种行为表明,行动策略不是基于简单的基于规则的启发式,而是利用上下文线索做出明智决策。

在令牌效率方面,如图4所示,SMR在BRIGHT基准上的五个代表性数据集(Bio、Earth、Econ、Pay、Rob)中始终消耗显著少于先前基线的令牌,包括Rank1、Rank-R1和O1-Pruner。平均而言,SMR减少了74.4%的推理令牌使用量,其性能甚至优于CoT压缩方法如O1-Pruner,后者仅实现了不到5%的边际减少。

图5展示了SMR在BRIGHT基准上的转换统计。每个条形指示达到推理动作中每一步的查询数量,使用累积计数计算。研究者观察到25%的查询在3步内终止,50%在6步内终止,表明系统快速收敛,验证了早期停止机制的有效性。同时,25%的查询(绿色条)表现出12个或更多动作,特别是对于复杂或模糊的输入,这些受益于额外的细化和重新排序,说明SMR有选择地分配计算资源的灵活性。

为评估SMR在标准检索场景中的一般适用性,研究者在BEIR基准上进行了实验。表3展示了在三个BEIR数据集(DBpedia、SciFact和FiQA)上的nDCG@10结果。SMR在所有方法中实现了最高的平均性能,优于标准CoT和压缩推理方法,证明其结构化推理方法不仅专门用于推理密集型场景,还有效地转移到标准检索场景。

五、SMR的局限性与未来方向

尽管SMR提供了令牌级推理的模块化和令牌高效的替代方案,但当前的状态表示仅限于表示查询和检索到的前k个文档,不包含用户交互信号,如点击率或参与度指标。研究者指出,合并这类行为反馈可能进一步增强状态保真度和推理质量。

此外,虽然研究者将推理动作限制为REFINE、RERANK和STOP,但框架的模块化性质允许集成额外操作,如领域特定检索模块、文档过滤器或其他工具,无需架构更改。这为未来研究提供了扩展SMR框架的广阔空间。

通过实验证明,SMR成功解决了信息检索中的过度思考问题,提供了一种更高效、更有效的推理方法。它在提高检索性能的同时大幅减少了计算资源使用,并且在不同检索器和语言模型之间表现出强大的泛化能力,无需任务特定的调整。

总的来说,这项研究代表了信息检索推理方法的重要进步,为未来更高效、更有效的信息检索系统铺平了道路。通过将思维过程从令牌级生成转变为结构化状态转换,SMR提供了一种实用的解决方案,可以无缝集成到各种检索系统中,不需要模型特定的调整。

好文章,需要你的鼓励

-

如何让AI像电影配乐师一样创作完整的长篇音频故事——腾讯ARC实验室团队AudioStory突破性进展

腾讯ARC实验室推出AudioStory系统,首次实现AI根据复杂指令创作完整长篇音频故事。该系统结合大语言模型的叙事推理能力与音频生成技术,通过交错式推理生成、解耦桥接机制和渐进式训练,能够将复杂指令分解为连续音频场景并保持整体连贯性。在AudioStory-10K基准测试中表现优异,为AI音频创作开辟新方向。

-

Meta与特拉维夫大学联手打造VideoJAM:让AI生成的视频动起来不再是奢望

Meta与特拉维夫大学联合研发的VideoJAM技术,通过让AI同时学习外观和运动信息,显著解决了当前视频生成模型中动作不连贯、违反物理定律的核心问题。该技术仅需添加两个线性层就能大幅提升运动质量,在多项测试中超越包括Sora在内的商业模型,为AI视频生成的实用化应用奠定了重要基础。

-

上海AI实验室重磅发布:让AI看图"说人话"的神奇训练法,解决多模态AI与人类价值观对齐难题

上海AI实验室发布OmniAlign-V研究,首次系统性解决多模态大语言模型人性化对话问题。该研究创建了包含20万高质量样本的训练数据集和MM-AlignBench评测基准,通过创新的数据生成和质量管控方法,让AI在保持技术能力的同时显著提升人性化交互水平,为AI价值观对齐提供了可行技术路径。

-

谷歌研究团队发布超级预测模型:让AI像天气预报员一样预测全球大气变化

谷歌DeepMind团队开发的GraphCast是一个革命性的AI天气预测模型,能够在不到一分钟内完成10天全球天气预报,准确性超越传统方法90%的指标。该模型采用图神经网络技术,通过学习40年历史数据掌握天气变化规律,在极端天气预测方面表现卓越,能耗仅为传统方法的千分之一,为气象学领域带来了效率和精度的双重突破。