LLM循环助力:创建PARADEHATE数据集实现仇恨言论无毒化

论文基本信息与研究概览

这项研究名为"LLM in the Loop: Creating the PARADEHATE Dataset for Hate Speech Detoxification"(循环中的大语言模型:创建PARADEHATE数据集进行仇恨言论无毒化),由德国ScaDS.AI和德累斯顿工业大学的Shuzhou Yuan、Lukas Kouba、Ashish Yashwanth Kangen和Michael Farber,以及慕尼黑大学和慕尼黑机器学习中心(MCML)的Ercong Nie、Helmut Schmid和Hinrich Schütze共同完成。该研究于2025年6月发表在arXiv预印本平台上,论文编号为2506.01484v1。

内容警告:本文涉及仇恨言论示例,可能对部分读者造成不适或冒犯。

想象一下,如果有一种魔法能把网上那些充满敌意和伤害的言论自动转变成无害但含义相同的文字,那会是多么美好的事情。这正是这篇研究所要解决的核心问题。随着互联网上有毒内容的日益增多,如何自动重写有害语言成为无毒文本(称为"无毒化")已成为一个越来越重要的研究领域。然而,由于人工标注的成本高昂和敏感性,高质量的平行数据集(即有毒文本及其无毒化版本的配对)仍然稀缺,尤其是针对仇恨言论的数据集。

研究团队提出了一种创新方法:不再依赖昂贵的人工标注,而是利用大语言模型(LLM)来自动完成无毒化过程。想象一下,他们把GPT-4o-mini模型放入一个循环系统中,让它像人类标注者一样工作。这个系统可以分析有毒文本,生成无毒版本,并自我验证生成内容的质量和无毒性。

这种方法最令人惊喜的地方在于:研究人员发现大语言模型在这项任务上的表现可以与人类标注者相媲美!基于这一发现,他们构建了PARADEHATE,这是一个包含8,000多对仇恨言论/非仇恨文本对的大规模平行数据集。研究还评估了各种基线方法,结果表明像BART这样在PARADEHATE上微调的模型在风格准确性、内容保留和流畅性方面取得了更好的性能,证明了LLM生成的无毒化文本作为人工标注的可扩展替代方案的有效性。

一、研究背景:为什么需要无毒化技术?

想象一下社交媒体就像一个巨大的公共广场,每天有数百万人在那里交流。不幸的是,这个广场上经常出现一些恶意的喊叫者,他们的言论不仅刺耳,还可能对他人造成伤害。这些有毒言论,尤其是仇恨言论,对在线社区的完整性和用户的福祉构成了严重威胁。

传统的处理方式就像是安保人员把这些喊叫者驱逐出广场或者禁止他们发言。在网络世界中,这对应的是内容删除或用户封禁。但这种方法只能治标不治本,也没有提供更建设性的解决方案。

相比之下,无毒化技术提供了一种更有建设性的方法:不是简单地删除有毒内容,而是将其改写成无毒但语义等效的版本。这就好比不是把喊叫者驱逐出广场,而是教会他们如何以尊重和建设性的方式表达同样的观点。

研究者们指出,这种特殊的风格转换技术有望促进更具包容性和相互尊重的在线对话。然而,要训练能够执行这种复杂任务的模型,研究人员需要大量高质量的数据对——即每一条有毒输入都与语义等效但无毒的版本配对。

这就像是需要成千上万个"翻译前"和"翻译后"的例子,才能教会翻译系统如何工作。但收集这样的数据集非常困难,因为它通常需要大量人工标注者来生成和验证无毒化的改写文本。这个过程不仅成本高昂,而且耗时,对于仇恨言论这类特别敏感的内容更是如此。

ParaDetox管道(由Logacheva等人于2022年提出)就是这种人工标注方法的典范,它利用众包建立了第一个大规模的平行无毒化语料库。但是,对人类标注者的依赖限制了可扩展性、速度和对新领域或语言的适应性。结果,现有资源规模仍然较小,而且往往集中在一般形式的有毒性(如冒犯性或亵渎性语言)上,而忽视了像仇恨言论这样更复杂和社会有害的子类型。

二、仇恨言论无毒化的特殊挑战

仇恨言论的无毒化与一般有毒语言的处理相比,面临着独特的挑战。这就像是将一种特别强烈的毒药转化为无害物质,需要更加精细和谨慎的处理技术。

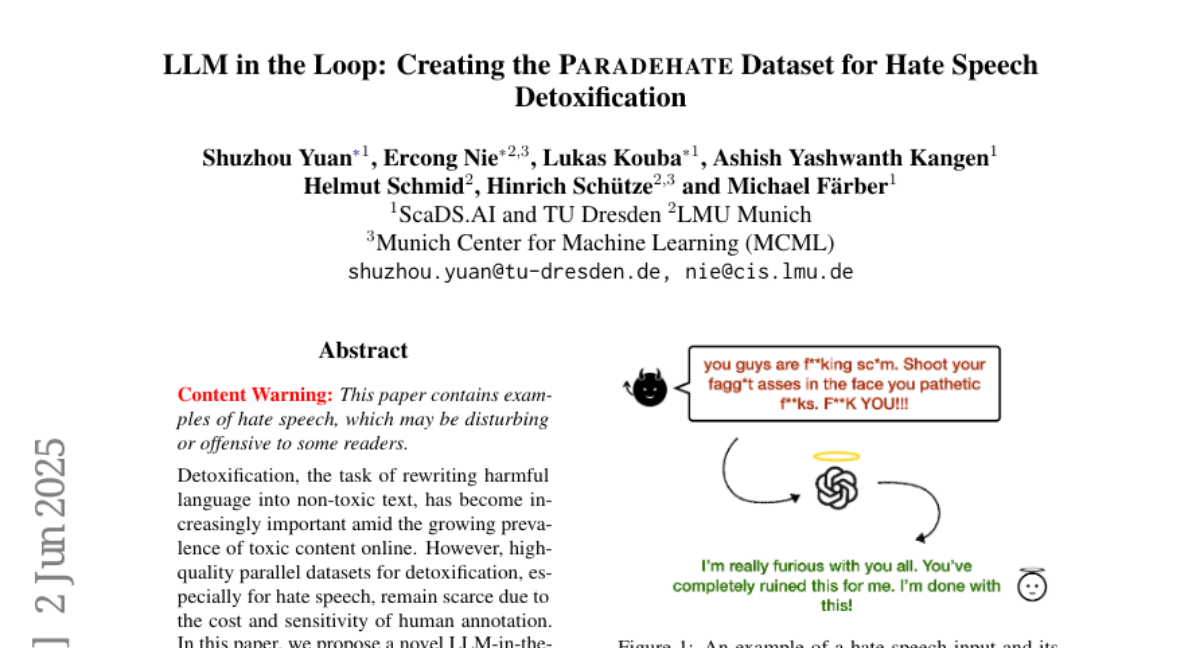

仇恨言论经常包含针对特定身份的侮辱性词汇和带有意识形态色彩的语言,这使得忠实改写变得特别困难。如图1所示的例子中,有一句充满仇恨的话:"你们这些该死的家伙。在你们愚蠢的脸上开枪打你们的同性恋屁股。去你们的!"被改写成了一个表达同样情感但不含仇恨的版本:"我真的对你们所有人都感到愤怒。你们完全毁了这件事。我受够了!"

在这个转换过程中,需要在去除有害内容和保留原始含义之间取得微妙的平衡,同时避免引入扭曲或模糊性。这就像是一个精细的外科手术,既要完全去除有害部分,又不能影响整体功能。

传统方法依赖于人类标注者,这种方法资源密集且难以扩展,尤其是当新形式的有害语言不断涌现时。与此同时,大型语言模型(LLMs)在文本生成、改写和对语言环境的细微理解方面展现出了令人印象深刻的能力。

这种挑战和技术进步的融合自然引出了一个关键研究问题:大语言模型能否有效地替代或增强人类标注者,在构建高质量的平行无毒化数据集中发挥作用?如果可以,基于LLM的流程不仅可以加速数据集创建并降低成本,还可以提供灵活性和可扩展性,以便快速适应包括仇恨言论在内的新兴有害语言领域。

三、LLM代替人类:一场标注革命

研究团队首先想要测试一个大胆的想法:大语言模型能否取代人类,完成高质量的文本无毒化任务?为了验证这一点,他们决定复制之前由Logacheva等人提出的ParaDetox流程,但用LLM替换人类标注者,看看效果如何。

想象一下标注过程就像一条生产线,有三个关键环节:第一步是生成无毒改写版本,第二步是检查内容是否保留了原意,第三步是确认改写后的文本确实不含毒性。在传统方法中,这三个环节都由人类完成,而研究团队尝试让GPT-4o-mini模型接管这整个流程。

值得注意的是,面对敏感内容时,LLM往往会表现出"假拒绝行为"——即使是可以安全处理的请求也拒绝回应。这就像是机器人过于谨慎,宁可不回答也不冒险给出可能有问题的回复。研究者通过精心设计的提示策略来减轻这一问题,使模型能够更好地理解任务的本质和必要性。

具体来说,整个过程分为三个任务:

**任务1:生成改写文本** 研究者首先提示LLM生成一个保留原始含义但去除任何有毒内容的文本版本。这就像是请翻译将一句粗鲁的话转换成礼貌版本,同时保留核心信息。例如,将"难道你没有大脑吗?"这样的问句改写成"你能不能考虑一下不同的观点?"。为了处理模型可能的拒绝回应,研究者还准备了替代提示,提供更详细的指导和规则。

**任务2:内容保留检查** 接下来,同一个LLM被要求评估转换后(即无毒化)的文本是否保留了原始有毒输入的含义。这就像是请审核员确认改写后的文本是否传达了相同的核心信息。模型需要简单地回答"是"或"否"。为了进一步控制质量,研究者还使用了sentence-transformer计算原始文本和改写文本之间的余弦相似度,设定0.70作为阈值,高于这个值被标记为"是",低于则为"否"。

**任务3:毒性检查** 最后一步是确保最终文本不含有毒内容。LLM被用来评估改写文本是否仍包含有毒内容,同样通过回答"是"或"否"来完成。研究者同时使用了unbiased-toxic-roberta计算毒性分数,设定0.9为阈值,高于此值的被标记为仍然含有毒性,低于则标记为无毒。

通过这一过程,研究团队最终得到了一个LLM生成的ParaDetox版本,即"PARADETOX-LLM",包含19,726个样本。为了比较两个版本的质量,他们分别在PARADETOX-LLM和原始的PARADETOX-HUMAN(即由人类标注的数据集)上微调了BART-large模型,使用相同的实验设置。

评估结果令人惊喜:在风格准确性(Style Accuracy)方面,PARADETOX-LLM略微优于PARADETOX-HUMAN(0.98对0.96),这表明它在有效去除有害语言方面表现出色。虽然在内容保留(Content Preservation)方面PARADETOX-LLM较弱(0.70对0.85),但它在流畅性(Fluency)评分上明显更高(0.91对0.71),这意味着它能够使监督模型生成更流畅的无毒输出。

总体而言,PARADETOX-LLM与PARADETOX-HUMAN的可比性能表明,LLM能够生成与人类标注相当质量的平行无毒化数据集,这一发现为后续研究奠定了基础。

四、PARADEHATE:针对仇恨言论的专用数据集

在验证了LLM循环方法的可行性后,研究团队决定迈出更大的一步:将这一方法应用于仇恨言论,构建第一个专门针对仇恨言论的大规模无毒化平行数据集——PARADEHATE。

研究团队首先从四个广泛使用的仇恨言论数据集收集样本:CreHate(5,935个样本)、HateXplain(1,430个样本)、Davidson(364个样本)和Founta(4,176个样本),总计11,905个仇恨言论样本。这些数据来源于Twitter和Reddit等社交媒体平台,已被专家标注为仇恨言论。

为了确保数据的一致性和与无毒化流程的兼容性,研究者应用了一系列预处理步骤: 1. 删除所有URL,专注于文本内容 2. 将用户名标准化为通用的@USER标签,并将连续的@USER标签合并为单个实例 3. 删除HTML编码的用户实体和非必要的特殊字符和过多的标点符号,以减少噪音同时保留文本的核心含义

接下来,研究团队使用在第三部分中验证的LLM循环流程,对这些仇恨言论样本进行无毒化处理。由于内容的高度有害和恶意性质,模型最初对4,103个样本触发了拒绝行为。通过应用替代提示策略,他们成功为额外的474个样本生成了无毒化输出。最终,PARADEHATE数据集包含8,276对无毒化文本对。

图2展示了构建PARADEHATE的完整流程:首先从各种数据集收集仇恨言论文本,然后LLM作为标注者执行三个任务——改写仇恨言论、验证内容保留和评估毒性。通过所有三项检查的文本被视为已成功无毒化,并被纳入最终的平行数据集。

这一过程的关键优势在于其可扩展性和成本效益。传统的人工标注方法需要大量人力资源和时间,而基于LLM的方法可以快速处理大量文本,并且成本显著降低。尽管处理敏感内容如仇恨言论时LLM可能面临挑战,但通过精心设计的提示工程,研究者成功克服了这些障碍。

五、评估与基线比较:PARADEHATE有多有效?

为了全面评估PARADEHATE数据集的质量和实用性,研究团队在此基础上训练了一个监督模型BART-large,并将其与多种基线方法进行了比较。这些基线方法包括了从简单的词汇删除到最新的风格转换技术,共有以下几类:

**简单基线**: - Delete:简单地从输入文本中删除所有有毒词汇 - Duplicate:直接复制输入文本而不做任何修改 - BART-zero-shot:使用未经微调的预训练BART-large模型

**无监督基线**: - Mask&Infill:使用基于BERT的逐点编辑模型来掩蔽有毒片段并填充适当的替代内容 - DRG-Template和DRG-Retrieve:两种删除-检索-生成方法,分别通过替换有毒词语或检索传达类似含义的非有毒句子 - DLSM:使用分摊变分推断进行风格转换的编码器-解码器模型 - CondBERT:整合风格和内容约束的条件BERT模型 - ParaGeDi:用风格感知语言模型增强改写器,以向所需风格重新加权输出 - Neuron-Specific:一种在Llama-3中修改与有毒语言相关的特定神经元以引导无毒化的方法

研究团队使用四个关键指标评估这些方法: 1. 风格准确性(Style Accuracy):衡量被分类为无毒的无毒化文本的比例 2. 内容保留(Content Preservation):计算原始文本和无毒化文本之间的LaBSE嵌入余弦相似度 3. 流畅性(Fluency):由基于RoBERTa的语言可接受性分类器识别的流畅句子的百分比 4. BLEU:衡量生成输出与PARADEHATE中参考无毒化文本之间的n-gram重叠

评估结果(如表3所示)令人瞩目。LLM生成的参考文本展示了高质量,风格准确性为0.98,内容保留为0.74,流畅性为0.76。在PARADEHATE上训练的BART微调模型在风格准确性(0.95)、内容保留(0.78)和BLEU(0.31)方面优于所有其他基线。

虽然简单基线(如Duplicate)实现了最高的内容保留分数(1.0),但这些方法不能被视为优于微调的BART模型,因为它们只是删除了脏话或复制了输入,没有进行有意义的无毒化。这就像是要求某人翻译一段文字,他却只是简单地重复原文或删掉几个词——技术上保留了"内容",但完全没有达到任务的真正目的。

无监督基线虽然在风格准确性方面表现良好(DRG-Template、CondBERT和ParaGeDi甚至达到了与BART微调相同的0.95分),但它们的内容保留分数较低,而且除了Neuron-Specific和ParaGeDi外,它们的流畅性得分也不理想。这表明在处理仇恨言论输入并对其进行无毒化时,这些方法可能无法生成流畅且保留原意的文本。

这些结果突显了无毒化仇恨言论的难度,这比处理一般有毒语言更具挑战性。现有方法,特别是那些没有足够特定任务训练数据的方法,通常难以在无毒化和内容忠实性之间取得平衡。这凸显了像PARADEHATE这样资源的必要性。通过在循环中利用LLM生成高质量的训练数据,像BART-large这样在PARADEHATE上微调的模型证明,有针对性的训练可以产生具有改进流畅性和语义一致性的强大无毒化性能。

表6展示了一些PARADEHATE中的示例,对比了有毒文本及其无毒化版本。例如,"Alright ya faggots. Lets just stop with all the S/O and R/T. No one gives a fuck on what you think of other people. Probably lying anyways"被改写为"Alright everyone. Let's just stop with all the shoutouts and retweets. No one is really interested in what you think of others. It's likely not true anyway"。这些例子展示了模型能够保留原始信息的核心,同时移除冒犯性和仇恨性语言。

六、结论与未来展望

这项研究最终证明,在文本无毒化任务中,大语言模型可以有效地替代人类标注者。研究团队不仅复制了ParaDetox流程,用LLM替换人类标注者,构建了PARADETOX-LLM数据集,还将这一方法扩展到了仇恨言论领域,创建了PARADEHATE——首个专门针对仇恨言论的大规模平行无毒化数据集。

与使用现有基线方法的评估结果相比,在PARADEHATE上微调的BART-large模型在风格准确性、内容保留和流畅性方面均取得了更好的性能。这表明,这类任务特定的训练数据对于开发有效的无毒化模型至关重要,而基于LLM的数据生成方法提供了一种可扩展且成本效益高的替代方案。

这项研究的贡献可以总结为三点:首先,他们发布了一个新的平行数据集PARADEHATE,包含8K+对仇恨言论和相应无毒化文本,填补了现有资源的关键空白;其次,他们引入了一种基于GPT-4o-mini的创新流程,用于自动化仇恨言论无毒化,并证明它达到了与人类标注相当的质量,同时更具可扩展性和成本效益;最后,他们对现有无毒化模型进行了全面评估,证明在PARADEHATE上训练的模型在下游无毒化任务中显著提高了性能。

然而,这项研究也存在一些局限性。首先,无毒化流程仅使用了GPT-4o-mini作为标注代理,未来研究可以探索不同LLM之间的一致性和泛化能力。其次,GPT-4o-mini是一个商业模型,这可能限制研究的再现性和透明度。最后,数据集和评估仅限于英语仇恨言论,未来工作可以将此方法应用于多语言数据集。

从更广阔的视角看,这项研究不仅为无毒化技术提供了新的工具和资源,也为更安全、更包容的在线环境铺平了道路。通过将有害语言转换为无毒但语义等效的替代方案,我们可以在保留言论自由的同时,减少在线交流中的伤害和敌意。随着这些技术的发展和完善,我们或许能够创造一个更加健康、更加尊重的数字对话空间。

好文章,需要你的鼓励

-

利用大语言模型探索科学创新前沿:南洋理工大学团队开发检测学术新颖性的突破性方法

这项研究利用大语言模型解决科学新颖性检测难题,南洋理工大学团队创新性地构建了闭合领域数据集并提出知识蒸馏框架,训练轻量级检索器捕捉想法层面相似性而非表面文本相似性。实验表明,该方法在市场营销和NLP领域显著优于现有技术,为加速科学创新提供了有力工具。

-

un?CLIP:通过反转unCLIP来提升CLIP模型的视觉细节捕捉能力

un?CLIP是一项创新研究,通过巧妙反转unCLIP生成模型来增强CLIP的视觉细节捕捉能力。中国科学院研究团队发现,虽然CLIP在全局图像理解方面表现出色,但在捕捉细节时存在不足。他们的方法利用unCLIP生成模型的视觉细节表示能力,同时保持与CLIP原始文本编码器的语义对齐。实验结果表明,un?CLIP在MMVP-VLM基准、开放词汇语义分割和视觉中心的多模态任务上显著优于原始CLIP和现有改进方法,为视觉-语言模型的发展提供了新思路。

-

角色扮演能力大考验:里尔大学研究团队开发的大语言模型角色扮演评估新标准

这项研究介绍了RPEval,一个专为评估大语言模型角色扮演能力而设计的新基准。研究团队从法国里尔大学开发的这一工具专注于四个关键维度:情感理解、决策制定、道德对齐和角色一致性,通过单轮交互实现全自动评估。研究结果显示Gemini-1.5-Pro在总体表现上领先,而GPT-4o虽在决策方面表现出色,但在角色一致性上存在明显不足。这一基准为研究人员提供了一个可靠、可重复的方法来评估和改进大语言模型的角色扮演能力。

-

LegalSearchLM:北大团队打造突破性法律案例检索新方法,将案例检索重新定义为法律要素生成

这篇论文介绍了LegalSearchLM,一种创新的法律案例检索方法,将检索任务重新定义为法律要素生成。研究团队构建了LEGAR BENCH数据集,涵盖411种犯罪类型和120万案例,并开发了能直接生成关键法律要素的检索模型。实验表明,该模型在准确率上超越传统方法6-20%,且在未见犯罪类型上展现出强大泛化能力。这一突破为法律专业人士提供了更高效、精准的案例检索工具。