超越上下文学习:通过任务内在属性指导对齐大型语言模型的长文本生成能力

**长文本生成研究新突破:新加坡国立大学和A*STAR团队提出的LongGuide算法彻底改变大模型表现**

在2025年6月发表于arXiv预印本网站(arXiv:2506.01265v1)的这项研究中,来自新加坡国立大学、南洋理工大学、A*STAR资讯通信研究所以及Salesforce AI研究院的研究团队,包括Do Xuan Long、Duong Ngoc Yen、Do Xuan Trong、Luu Anh Tuan、Kenji Kawaguchi、Shafiq Joty、Min-Yen Kan和Nancy F. Chen,提出了一种全新的方法来改善大型语言模型(LLM)在长文本生成任务中的表现。

想象一下,你有一个非常聪明的朋友,但每当你让他复述一个长故事时,他总是丢失故事的某些关键元素或风格。这正是大型语言模型目前面临的问题。虽然它们在简短的问答中表现出色,但在需要生成连贯的长篇文本(如摘要或对话)时,往往难以保持一致的质量和风格。本研究团队发现了这个问题的根本原因,并提出了一个巧妙的解决方案。

**为什么现有的方法行不通?上下文学习的局限性**

在研究世界里,大型语言模型通常采用一种称为"上下文学习"(In-context Learning,简称ICL)的方法来适应新任务。这就像给模型展示几个示例,说:"看,这是问题,这是答案,现在你也这样做。"这种方法在简单的问答中效果很好,但研究团队发现,当任务变成生成长篇内容时,这种方法就显得力不从心了。

通过一系列实验,研究人员发现,即使给模型展示了完美的示例,它们仍然难以捕捉和保持长文本所需的语言特性和格式要求。就像教一个朋友烹饪一道复杂的菜肴,仅仅让他观看你做几次是不够的,他需要明确的食谱和指导原则。

研究团队将这个问题形象地称为"文本属性转移"(text property transfer,PT)问题:模型无法从少量示例中充分学习并在生成过程中保持关键的文本属性。他们不仅通过实验验证了这一点,还从理论上证明了这一现象的存在。

**LongGuide:一种革命性的解决方案**

针对这一问题,研究团队开发了一种名为LongGuide的算法,它就像是为大型语言模型提供的一套定制食谱和烹饪技巧。LongGuide不只是给模型看几个例子,而是自动学习并生成两种互补的指导原则:

1. **度量指导原则(Metric Guidelines,MG)**:这些原则指导模型优化自我评估的度量标准。想象一下,不只是告诉朋友"做一道美味的菜",而是具体指导"菜应该有多咸、多辣、质地应该是怎样的"。MG告诉模型应该如何评价和优化自己生成的内容质量。

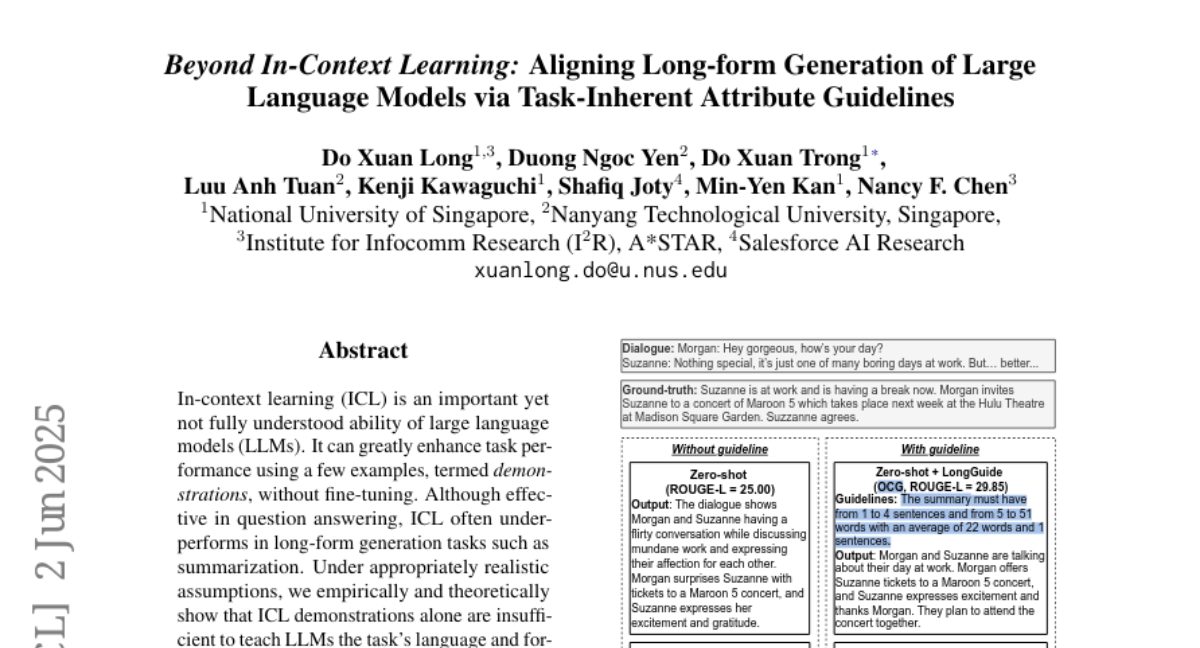

2. **输出约束指导原则(Output Constraint Guidelines,OCG)**:这些原则在句子和词语层面约束生成内容。比如指定"这道菜应该有三种主要配料,总共不超过10种食材"。OCG告诉模型生成内容应该遵循的格式和结构规则。

这两种指导原则共同作用,帮助模型生成既符合特定质量标准又遵循特定格式要求的长文本内容。

**LongGuide如何工作?简单又高效的五步法**

LongGuide的工作流程就像是一位专业烹饪导师,通过五个步骤教会大模型如何"烹饪"出优质的长文本:

首先,**度量收集与选择**。算法会从一组预定义的评估指标中,选择最适合当前任务的关键指标。比如,对于对话摘要任务,它可能会选择"简洁性"、"准确性"和"相关性"等指标。

其次,**度量分数收集**。算法让模型自我评估示例答案在这些选定指标上的表现,给每个指标打分。这就像让厨师品尝并评价示范菜肴的各个方面。

接着,**生成度量指导原则**。根据收集到的分数,算法生成自然语言描述的指导原则,告诉模型应该如何优化这些指标。例如:"摘要应该非常简洁,没有任何不必要的细节。"

同时,**生成输出约束指导原则**。算法分析示例答案的句子数量和词语数量等统计信息,生成明确的格式约束。比如:"摘要必须有1到4个句子,5到51个词,平均22个词和1个句子。"

最后,**选择最佳指导原则组合**。算法会测试不同的指导原则组合(单用MG、单用OCG或组合使用MG-OCG),选择在验证集上表现最好的组合作为最终输出。

这整个过程高效且自动化,只需要少量的训练数据就能为任何长文本生成任务定制出有效的指导原则。

**实验证明:LongGuide带来显著提升**

研究团队在七种不同的长文本生成任务上测试了LongGuide,包括摘要生成、文本简化、机器翻译、对话生成和表格到文本生成等。实验结果令人印象深刻:

无论是开源还是闭源的大型语言模型,在零样本(没有示例)和少样本(有少量示例)设置下,使用LongGuide后的表现都显著提升。平均而言,模型在ROUGE-L评分上提高了约6%,在GPT-4o-Judge评分上提高了0.8分。

有趣的是,LongGuide在少样本设置下的改进比零样本设置下更显著,这表明它能够与传统的上下文学习方法协同工作,相辅相成。而且,LongGuide比现有的提示词优化算法(如APO)在大多数基准测试中表现更好,尤其是在零样本设置下。

人类评估也证实了LongGuide的有效性。评估者更喜欢使用LongGuide生成的输出,认为它们在质量上有显著提升,特别是在"准确性"和"清晰度"方面。

**LongGuide的通用性与灵活性**

LongGuide展现出了惊人的通用性和灵活性:

1. 它可以从示例中学习指导原则,进一步增强上下文学习的性能。 2. 它能够改善非指令微调模型的表现。 3. 由弱模型学习的指导原则可以用来增强更强大的模型。 4. 它可以与提示词优化算法结合使用,进一步提升性能。

而且,LongGuide比提示词优化算法更加成本效益,至少便宜3.75倍,因为它只需要在验证集上测试四种提示词变体,就能获得更好的性能。

**未来展望与局限性**

尽管LongGuide取得了显著成功,研究团队也坦诚地指出了它的局限性:

1. 它目前是基于任务级别和平均统计数据生成指导原则,而不是针对特定样本定制,这在某些高度变化的任务中可能效果有限。 2. 它依赖于模型具有一定的任务知识来进行有效的自我评估,并且需要模型具有强大的指令遵循能力。 3. 对于模型已经在训练数据中充分学习过的任务,这些指导原则可能不会带来显著改进。

然而,随着人工智能语言模型的不断发展,这些限制预计将在不久的将来得到克服。

**总结:为长文本生成开辟新路径**

归根结底,LongGuide的研究表明,仅依靠示例来教导大型语言模型生成长文本是不够的。模型需要明确的指导原则来捕捉和保持文本的关键属性。通过自动学习和生成这些指导原则,LongGuide为改善长文本生成开辟了一条新路径。

这项研究不仅提高了大型语言模型在长文本生成任务中的表现,还深化了我们对这些模型学习和生成能力的理解。它表明,即使是最先进的模型也能从明确的指导中受益,就像一位天才厨师也需要一本详细的食谱来烹饪一道前所未有的复杂菜肴。

对于普通用户来说,这意味着未来的AI助手将能够生成更加连贯、准确和格式一致的长文本内容,无论是会议摘要、文档简化还是创意写作。而对于AI研发人员,LongGuide提供了一种高效、成本效益高的方法来提升模型性能,无需大规模的模型重训练。

有兴趣深入了解这项研究的读者可以通过arXiv:2506.01265v1访问原论文,或者关注新加坡国立大学WING研究组和A*STAR的后续研究进展。

好文章,需要你的鼓励

-

如何让AI像电影配乐师一样创作完整的长篇音频故事——腾讯ARC实验室团队AudioStory突破性进展

腾讯ARC实验室推出AudioStory系统,首次实现AI根据复杂指令创作完整长篇音频故事。该系统结合大语言模型的叙事推理能力与音频生成技术,通过交错式推理生成、解耦桥接机制和渐进式训练,能够将复杂指令分解为连续音频场景并保持整体连贯性。在AudioStory-10K基准测试中表现优异,为AI音频创作开辟新方向。

-

Meta与特拉维夫大学联手打造VideoJAM:让AI生成的视频动起来不再是奢望

Meta与特拉维夫大学联合研发的VideoJAM技术,通过让AI同时学习外观和运动信息,显著解决了当前视频生成模型中动作不连贯、违反物理定律的核心问题。该技术仅需添加两个线性层就能大幅提升运动质量,在多项测试中超越包括Sora在内的商业模型,为AI视频生成的实用化应用奠定了重要基础。

-

上海AI实验室重磅发布:让AI看图"说人话"的神奇训练法,解决多模态AI与人类价值观对齐难题

上海AI实验室发布OmniAlign-V研究,首次系统性解决多模态大语言模型人性化对话问题。该研究创建了包含20万高质量样本的训练数据集和MM-AlignBench评测基准,通过创新的数据生成和质量管控方法,让AI在保持技术能力的同时显著提升人性化交互水平,为AI价值观对齐提供了可行技术路径。

-

谷歌研究团队发布超级预测模型:让AI像天气预报员一样预测全球大气变化

谷歌DeepMind团队开发的GraphCast是一个革命性的AI天气预测模型,能够在不到一分钟内完成10天全球天气预报,准确性超越传统方法90%的指标。该模型采用图神经网络技术,通过学习40年历史数据掌握天气变化规律,在极端天气预测方面表现卓越,能耗仅为传统方法的千分之一,为气象学领域带来了效率和精度的双重突破。