RefEdit:一项突破性研究,让AI编辑图像时能准确理解「这个人」「那只猫」到底是指谁

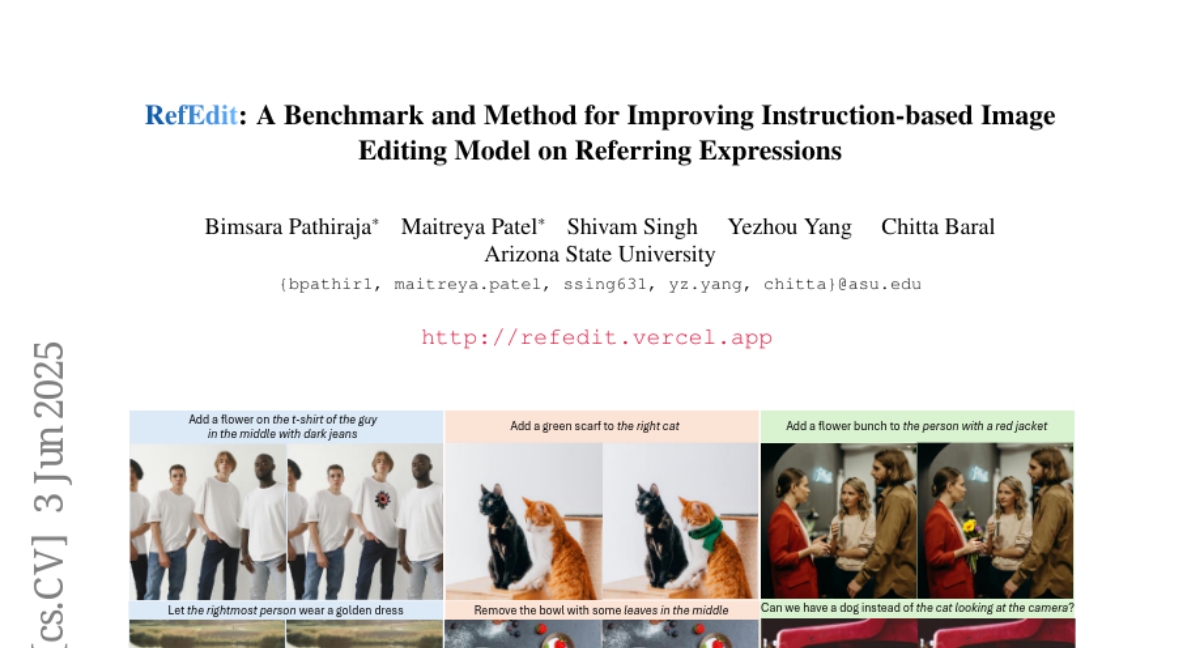

亚利桑那州立大学的研究团队带来了一项令人瞩目的突破。这项由Bimsara Pathiraja、Maitreya Patel(这两位作者贡献相同)、Shivam Singh、Yezhou Yang和Chitta Baral共同完成的研究于2025年6月3日发表在arXiv(arXiv:2506.03448v1)上,并建立了专门的项目网站http://refedit.vercel.app。有兴趣深入了解的读者可以通过这个网站获取更多信息和模型资源。

一、研究背景:当AI不明白你说的"那个人"是谁

想象一下这个场景:你有一张合家欢照片,里面有爸爸、妈妈和两个穿着相似衣服的孩子。你想用AI工具只给"左边那个孩子"的衣服变个颜色,结果AI却把所有人的衣服都改了。令人沮丧,对吧?

这正是目前AI图像编辑技术面临的核心问题。虽然像InstructPix2Pix、MagicBrush这样的工具在编辑单个主体物体时表现不错,但一旦图像中出现多个相似物体(比如两个人、三只猫或者几把椅子),AI就会"迷惑",不知道你指的是哪一个。

亚利桑那州立大学的研究团队将这个问题定义为"指代表达挑战"(referring expression challenge)。简单来说,就是AI需要理解人类自然语言中的指代词和描述性语言,比如"左边那个戴眼镜的人"、"中间穿深色牛仔裤的那位"等。

研究团队发现,即使是那些训练了数百万样本的最先进模型,面对这种场景时的表现也非常糟糕。为了量化这一问题,他们首先建立了一个名为RefEdit-Bench的基准测试,专门用来评估AI在处理指代表达时的表现。然后,他们提出了一种解决方案——RefEdit模型,这是一个经过特殊训练的图像编辑模型,能够准确理解指代表达并执行精确的编辑。

二、为什么现有的AI图像编辑技术会"迷糊"?

要理解这个问题,我们需要先了解当前AI图像编辑技术的工作方式。目前主流的方法主要分为两大类:基于反转(inversion-based)的技术和基于指令(instruction-based)的技术。

想象一下基于反转的技术就像是一位画家需要先把一幅画拆解成素描草图(这就是"反转"过程),然后在草图上修改,最后重新上色完成编辑。这类方法包括Prompt-to-Prompt、Null-Text Inversion和DDPM-inversion等。虽然创新,但这些方法计算量大、处理时间长,而且需要大量的参数调整。最关键的是,它们在定位具体区域时表现不佳,容易"漏改"或"多改"。

基于指令的方法则像是给画家一本使用说明书,直接告诉他如何修改画作。这类方法包括InstructPix2Pix、UltraEdit和OmniEdit等,它们通常通过在数百万图像编辑样本上微调扩散模型来实现。这些模型虽然更高效,但因为它们通常使用基于反转技术生成的训练数据,所以也继承了基础方法的局限性。

这两类方法都面临一个共同的问题:当图像中有多个相似物体时,它们难以精确定位用户想要编辑的特定对象。就像你告诉一个近视的画家"把那个人的帽子改成红色",但他看不清哪个是你指的"那个人"。

三、RefEdit-Bench:一个测试AI"理解力"的新基准

为了系统评估这个问题,研究团队创建了RefEdit-Bench,这是一个专门用于测试AI在处理指代表达时的图像编辑能力的基准测试。

这个基准测试的独特之处在于它重新利用了RefCOCO数据集,这是一个包含大量带有指代表达注释的真实世界图像的数据集。每张图像都经过精心挑选,确保场景、物体和上下文的多样性。研究团队还为每张图像手工制作了详细多样的编辑指令,包括改变颜色、更换物体、添加物体、移除物体和改变纹理等任务。

基准测试分为"简单"和"困难"两个类别,每个类别包含100张图像: - 简单类别:图像中主要有一个物体,或者即使有多个相同类型的物体,目标物体也占据图像的显著部分或容易识别。 - 困难类别:图像中有多个相同类型的物体,而且这些物体占据图像的相似区域,使得正确识别特定实例变得困难。

研究结果令人吃惊:即使是那些在标准基准测试上表现出色的顶级模型,在RefEdit-Bench上的表现也非常糟糕。这清晰地表明了当前AI图像编辑技术在处理指代表达方面存在严重不足。

四、RefEdit:让AI真正理解你指的是"哪一个"

为了解决这个问题,研究团队提出了RefEdit,这是一个专门针对指代表达挑战进行训练的模型。这个模型的独特之处在于它的训练数据生成方式和训练策略。

### 训练数据生成:巧妙的四步曲

研究团队开发了一个可扩展的合成数据生成流程,这个流程主要包括四个关键步骤:

首先,使用GPT-4o生成所有文本数据,包括图像提示、编辑后的提示、编辑指令、被编辑的物体、指代表达以及更详细的指代表达版本。研究团队将图像编辑任务分为五个不同类别:改变颜色、更换物体、添加物体、移除物体和改变纹理。每个类别都专注于指代表达。

其次,使用FLUX生成1024×1024的图像。研究团队在模板中指定如何生成图像提示,例如如果图像中有两个或更多相同物体但有一些差异。这些差异可能是由于颜色("白衬衫"或"黑衬衫")、单独的物品("拿刀的人"或"拿包的人")或活动(比如"切菜的厨师"或"搅拌锅的厨师")造成的。

第三,使用Grounded SAM生成精确的物体掩码。Grounded SAM结合了Segment Anything和Grounding DINO,能够根据指代表达准确地生成物体掩码。

最后,使用初始图像、编辑指令和掩码生成编辑后的图像。研究团队使用Inpaint Anything进行物体移除,使用FlowChef进行其他编辑任务。添加物体的数据是通过交换初始图像和编辑后的图像创建的。

通过这个流程,研究团队创建了一个包含超过20,000对训练数据的数据集。每张图像都包含多个相似实体,需要某种形式的指代表达来精确定位。

### 模型训练:少而精的策略

RefEdit的训练策略也非常独特。为了避免过度拟合并确保模型能够泛化到其他任务,研究团队将自己生成的RefEdit数据与MagicBrush数据结合起来进行训练。这样,最终的训练数据量为30,000,远少于其他方法使用的数百万样本。

具体来说,研究团队训练了两个变体: - RefEdit(基于Stable Diffusion v1.5):在2个80GB NVIDIA A100 GPU上训练了24个epoch。 - RefEdit-SD3(基于UltraEdit):在8个80GB NVIDIA A100 GPU上训练了6000次迭代。

这种"少而精"的训练策略证明非常有效,在各种基准测试上的表现都优于那些使用数百万样本训练的模型。

五、研究结果:小数据集也能超越大模型

研究团队进行了广泛的评估,包括在RefEdit-Bench和PIE-Bench上的定量评估,以及人类评估。

在RefEdit-Bench上,RefEdit(SDv1.5变体)在简单和困难两个类别上都显著优于基线模型。有趣的是,使用少量人工注释数据训练的MagicBrush的表现与使用120万合成数据的OmniEdit相似。而RefEdit则始终在基准测试中名列前茅,这表明高质量但规模较小的数据集的重要性。

更令人惊讶的是,那些基于更大、更先进架构(如SDXL、SD3)的模型表现反而不如基于SDv1.5的方法,甚至出现了严重的性能下降。研究团队将这种现象归因于可能的过度拟合。由于现有的训练数据集不包含需要指代表达的复杂图像编辑,较大的模型可能会过度拟合。重要的是,仅添加20,000个合成数据就显著提高了UltraEdit在两个类别上的性能。

在标准图像编辑任务的PIE-Bench上,RefEdit也表现出色。OmniEdit使用120万数据集获得了5.12的分数,而RefEdit仅使用20,000个额外训练数据就获得了5.21的分数。RefEdit-SD3变体实现了最先进的性能。

人类评估结果更加显著。研究团队从RefEdit-Bench中随机选择了400对样本,让人类评估者进行A/B测试。结果显示,RefEdit-SD3模型显著优于所有基线模型,并且始终受到青睐。

六、这项研究意味着什么?

对于普通用户来说,RefEdit代表了AI图像编辑工具的一个重要进步。它解决了一个长期困扰用户的问题:当你说"把左边那个人的帽子变成红色"时,AI现在能更准确地理解你指的是哪个人。

对于研究界来说,这项工作有几个重要启示: 1. 指代表达在生成式AI领域与在判别式任务(如分割)中同样重要,但长期以来被忽视。 2. 高质量的合成数据生成策略可以显著提高模型性能,即使数据量相对较小。 3. 简单但针对性强的方法有时可以超越更复杂、规模更大的模型。

更广泛地说,这项研究表明,为了使AI工具在现实世界中更有用,它们需要更好地理解人类的语言和意图,特别是在涉及多个相似实体的复杂场景中。

RefEdit不仅在技术上代表了一个突破,它还朝着使AI工具更符合人类直觉和期望的方向迈出了重要一步。随着这类技术的发展,我们可以期待未来的AI图像编辑工具将变得更加精确、直观和易于使用。

好文章,需要你的鼓励

-

北航大学团队推出Easy Dataset:让普通人也能制作AI训练数据的神奇工具

北航团队推出Easy Dataset框架,通过直观的图形界面和角色驱动的生成方法,让普通用户能够轻松将各种格式文档转换为高质量的AI训练数据。该工具集成了智能文档解析、混合分块策略和个性化问答生成功能,在金融领域实验中显著提升了AI模型的专业表现,同时保持通用能力。项目已开源并获得超过9000颗GitHub星标。

-

网络安全AI助手:让电脑漏洞危险等级一秒识别的RoBERTa智能系统

卢森堡计算机事件响应中心开发的VLAI系统,基于RoBERTa模型,能够通过阅读漏洞描述自动判断危险等级。该系统在60万个真实漏洞数据上训练,准确率达82.8%,已集成到实际安全服务中。研究采用开源方式,为网络安全专家提供快速漏洞风险评估工具,有效解决了官方评分发布前的安全决策难题。

-

人工智能评判官:xVerify如何解决复杂推理模型的评估难题

中国电信研究院等机构联合开发的xVerify系统,专门解决复杂AI推理模型的评估难题。该系统能够准确判断包含多步推理过程的AI输出,在准确率和效率方面均超越现有方法,为AI评估领域提供了重要突破。

-

只需输入音频就能生成说话人视频?昆仑集团推出的Skywork R1V让AI同时看懂图片和推理数学

昆仑公司Skywork AI团队开发的Skywork R1V模型,成功将文本推理能力扩展到视觉领域。该模型仅用380亿参数就实现了与大型闭源模型相媲美的多模态推理性能,在MMMU测试中达到69.0分,在MathVista获得67.5分,同时保持了优秀的文本推理能力。研究团队采用高效的多模态迁移、混合优化框架和自适应推理链蒸馏三项核心技术,成功实现了视觉理解与逻辑推理的完美结合,并将所有代码和权重完全开源。