自由飞翔的3D高斯:浙大研究团队打造高效动态场景重建新方法

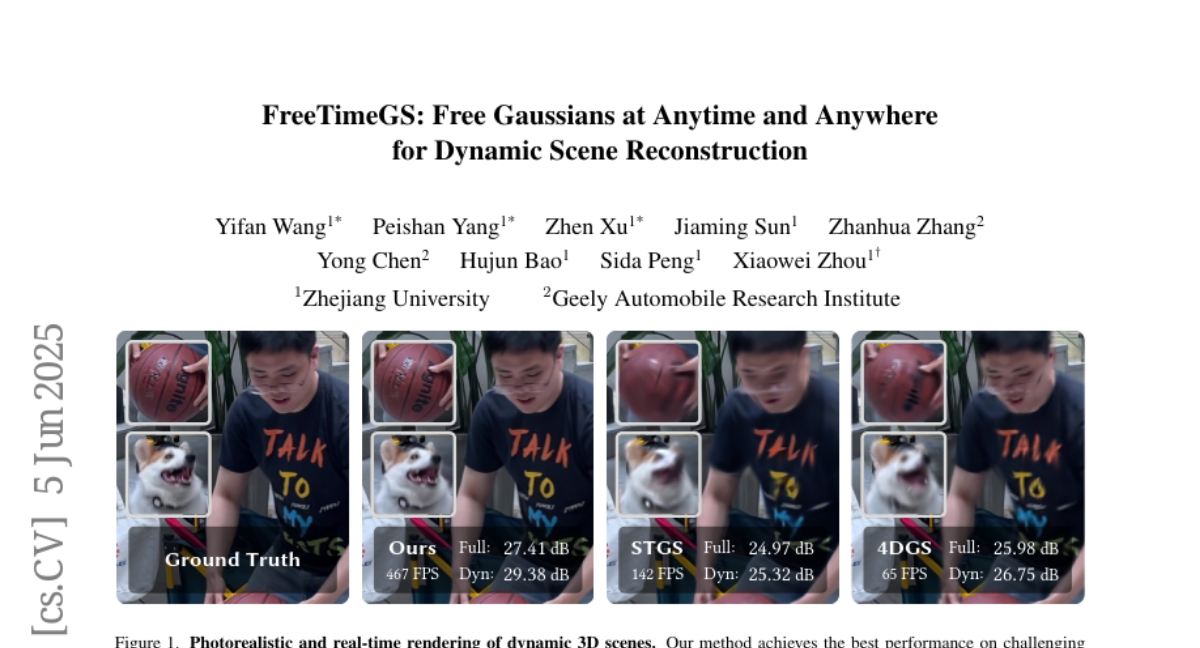

近日,浙江大学和吉利汽车研究院的联合研究团队发表了一项突破性研究,为动态3D场景重建领域带来了全新解决方案。这项名为"FreeTimeGS: Free Gaussians at Anytime and Anywhere for Dynamic Scene Reconstruction"(自由时空高斯:用于动态场景重建的任意时空高斯)的研究由王一帆、杨佩珊、徐震、孙加明、张占华、陈勇、包华军、彭思达和周晓巍共同完成,周晓巍教授担任通讯作者。论文于2024年6月在计算机视觉领域发表。

一、研究背景:为何我们需要更好的动态场景重建技术?

想象一下,你正在观看一场足球比赛的直播。现在的技术只能让你从固定的几个摄像机角度观看比赛,但如果你能随意切换到任何视角——比如从守门员背后看球飞来的轨迹,或者从球员视角体验进球瞬间,那该有多酷?这正是动态视图合成技术的魅力所在,它能让我们从任意角度观看真实世界中发生的动态场景。

这项技术不仅对电影制作、视频游戏和虚拟现实具有广泛应用,还可能彻底改变我们观看体育赛事、音乐会和其他现场活动的方式。传统方法使用纹理网格序列来表示动态3D场景,但这需要复杂的硬件设置才能实现高质量重建,因此仅限于受控环境使用。随后,基于NeRF(神经辐射场)的方法在动态视图合成方面取得了令人印象深刻的成果,但这些表示在计算上非常昂贵,导致渲染速度慢,阻碍了实际应用。

近期,一种流行的动态视图合成方法是将3D高斯基元(想象成3D空间中的小气泡)与变形场结合,来模拟动态场景。这些方法在规范空间中基于高斯基元模拟场景的几何和外观,然后使用神经网络来模拟场景运动,将规范空间中的场景变形到特定时刻的观察空间场景。虽然这些方法在小运动场景上实现了实时高质量渲染,但它们常常难以处理具有复杂运动的场景。

二、研究创新:高斯基元的自由化与时空革命

浙大团队认为,当前方法之所以难以处理复杂运动场景,一个合理的原因是:当物体在场景中大幅移动时,这些方法需要在规范空间和观察空间之间建立长距离对应关系,而这种关系很难从RGB观察中恢复,正如之前研究中所讨论的那样。

针对这个问题,研究团队提出了一种新颖的4D表示方法,名为FreeTimeGS,用于重建具有复杂运动的动态3D场景。与之前仅在规范空间定义高斯基元的方法不同,FreeTimeGS允许高斯基元在任意位置和时间步骤出现,具有强大的灵活性。

这就像是从固定的演员阵容到可以随时加入演出的自由艺人。传统方法就像一个戏剧团,所有演员(高斯基元)都必须从头到尾参与整个表演,即使某些演员只在特定场景中短暂出现。而FreeTimeGS则像是一个开放的街头表演,演员可以在任何时间点加入或离开,根据需要灵活地参与表演,这大大提高了表演(场景重建)的质量和效率。

此外,研究团队为每个高斯基元分配了一个明确的运动函数,使其能够随时间移动到相邻区域,这促进了高斯基元沿时间维度的重用,并减少了表示冗余。简单来说,就是让每个"演员"不仅可以在特定时间出场,还能按照预定的轨迹在场景中移动,这样一个演员就能担任多个角色,大大提高了效率。

通过赋予高斯基元高度的自由度,这种表示方法有两个显著优势:首先,它显著提高了模拟动态3D场景的能力和渲染质量,这一点在实验中得到了充分证明。其次,与基于变形的方法相比,该方法只需要模拟高斯基元和观察场景之间的短距离运动。因此,他们的运动函数可以实现为简单的线性函数,缓解了病态优化问题。

三、技术挑战与巧妙解决:高透明度高斯的"遮光"问题

在实验过程中,研究团队发现,仅用渲染损失优化FreeTimeGS容易在快速移动区域陷入局部最小值,导致渲染质量下降。为解决这个问题,他们深入分析了高斯基元的不透明度分布,发现其中相当一部分接近1(完全不透明)。

这就像是给舞台上的演员穿了过于鲜艳的服装,导致站在前排的演员完全遮挡了后排演员,使观众无法看到完整的表演。研究结果表明,一些高斯基元的高不透明度可能阻止梯度传播到所有高斯基元,从而阻碍优化过程。

受此启发,研究团队设计了一种简单的正则化策略,在优化早期阶段对高斯基元的高不透明度进行惩罚。这就像是要求所有演员穿半透明的服装,确保站在后排的演员也能被观众看到,直到每个演员都找到了自己的最佳位置。这一策略有效缓解了局部最小值问题,提高了渲染质量。

四、实验验证:从数字到视觉的卓越表现

为验证方法的有效性,研究团队在多个广泛使用的多视图动态新视图合成数据集上评估了FreeTimeGS,包括Neural3DV和ENeRF-Outdoor。他们的方法与现有最先进方法相比,在这些公共数据集上取得了最高质量的结果。

更值得注意的是,为了进一步评估和展示方法在具有挑战性场景中的能力,研究团队还收集了一个名为SelfCap的数据集,与Neural3DV相比,该数据集包含了更快、更复杂的运动场景。在这个数据集上,他们的方法在质量和效率方面均大幅超越了最先进的方法。

具体来看,与当前最先进的方法4DGS和STGS相比,他们的方法在SelfCap数据集上的PSNR(峰值信噪比,一种衡量图像质量的指标)提高了2.4dB和1.4dB。对于动态区域,PSNR提升更为显著,分别提高了4.1dB和2.6dB。更令人印象深刻的是,他们的方法支持1080p分辨率的实时渲染,使用单个RTX 4090 GPU能达到450 FPS的渲染速度。

五、技术实现:FreeTimeGS的核心机制详解

FreeTimeGS的核心是其特殊的4D表示方法。每个高斯基元由八个可学习参数组成:位置、时间、持续时间、速度、尺度、方向、不透明度和球谐系数。

想象一下,每个高斯基元就像是一个特殊的气球,它可以在特定时间出现在3D空间的任何位置,并按照预定义的轨迹移动。这个气球有特定的大小(尺度)、方向、透明度(不透明度)和颜色(由球谐系数决定)。

为了计算任意时间点t和位置x处高斯基元的不透明度和颜色,系统首先根据其运动函数移动高斯基元,获取其在时间t的实际空间位置。基于移动后的高斯基元,系统通过球谐模型计算其颜色,并通过结合原始不透明度、时间不透明度和空间距离计算其不透明度。

时间不透明度是一个关键创新,它控制高斯基元随时间的影响。为了使高斯基元的时间和持续时间能够通过渲染梯度自动调整,时间不透明度被建模为具有缩放参数的高斯分布。

在训练过程中,研究团队采用了多种优化策略:

1. 4D正则化:设计了一个正则化损失来约束高斯基元的高不透明度值。时间不透明度作为正则化损失的权重,代表高斯基元在特定时间的影响。对于影响较小的高斯基元,减少对它们的惩罚。

2. 周期性重定位:设计了一个周期性重定位策略,将低不透明度的高斯基元移动到需要更多基元的区域。具体来说,他们为每个高斯基元设计了一个采样分数,衡量需要更多基元的区域。每隔N次迭代,他们将不透明度低于阈值的高斯基元移动到采样分数高的区域。

3. 表示初始化:提出了一种策略来初始化高斯基元的位置、时间和速度。对于每个视频帧,首先使用ROMA获取多视图图像之间的2D匹配,然后通过3D三角测量计算3D点。这些3D点及其对应的时间步骤用于初始化高斯基元的位置和时间。随后,通过k最近邻算法匹配两个视频帧的3D点,将点对之间的平移作为高斯基元的速度。

在优化过程中,他们进一步根据训练进度调整速度的优化率,这有助于在早期阶段模拟快速运动,在后期阶段模拟复杂运动。

六、消融实验:FreeTimeGS各组件的重要性

为了验证各个提出组件的有效性,研究团队在SelfCap数据集的60帧dance1序列上进行了消融实验,并进一步报告了10帧最快运动子序列的结果,以评估方法在高运动场景中的性能。

实验结果表明:

1. 运动表示:与4DGS使用的运动表示相比,FreeTimeGS提出的运动表示显著提高了模拟动态3D场景的能力,尤其是在具有快速和复杂运动的区域。

2. 4D正则化:没有4D正则化,具有大不透明度的高斯会阻碍优化过程,导致细节区域的次优结果。研究团队还测试了不同正则化权重值的效果,最终选择λreg = 1e-2作为所有实验的设置。

3. 周期性重定位:没有周期性重定位,模型倾向于使用更多低不透明度的高斯来模拟场景,当高斯数量有限时导致次优结果。

4. 4D初始化:提出的4D初始化方法显著提高了模型对场景中快速运动的建模能力。

这些实验证明了FreeTimeGS各个组件的重要性,每个组件都对最终的高质量结果做出了贡献。

七、局限性与未来展望:迈向更完美的动态场景重建

尽管取得了令人印象深刻的成果,FreeTimeGS仍有一些局限性。首先,该方法仍然需要对每个动态场景进行漫长的重建过程。未来的工作可能通过在提出的表示上整合生成式先验,实现无优化重建来缓解这一问题。

另一个局限是当前表示不支持重光照,仅专注于新视图合成。未来的工作可以扩展当前表示,加入表面法线和材质属性,以扩展其在重光照方面的适用性。

总的来说,FreeTimeGS为动态3D场景重建提供了一种新颖的4D表示方法,通过允许高斯基元在任意时间和位置出现,结合可优化的显式运动函数和时间不透明度函数,该表示能够更加忠实和灵活地表示动态场景。此外,提出的简单正则化策略有效缓解了优化过程中的局部最小值问题。实验结果表明,FreeTimeGS在多个广泛使用的多视图动态新视图合成数据集上实现了更高的渲染质量和渲染速度。

好文章,需要你的鼓励

-

利用大语言模型探索科学创新前沿:南洋理工大学团队开发检测学术新颖性的突破性方法

这项研究利用大语言模型解决科学新颖性检测难题,南洋理工大学团队创新性地构建了闭合领域数据集并提出知识蒸馏框架,训练轻量级检索器捕捉想法层面相似性而非表面文本相似性。实验表明,该方法在市场营销和NLP领域显著优于现有技术,为加速科学创新提供了有力工具。

-

un?CLIP:通过反转unCLIP来提升CLIP模型的视觉细节捕捉能力

un?CLIP是一项创新研究,通过巧妙反转unCLIP生成模型来增强CLIP的视觉细节捕捉能力。中国科学院研究团队发现,虽然CLIP在全局图像理解方面表现出色,但在捕捉细节时存在不足。他们的方法利用unCLIP生成模型的视觉细节表示能力,同时保持与CLIP原始文本编码器的语义对齐。实验结果表明,un?CLIP在MMVP-VLM基准、开放词汇语义分割和视觉中心的多模态任务上显著优于原始CLIP和现有改进方法,为视觉-语言模型的发展提供了新思路。

-

角色扮演能力大考验:里尔大学研究团队开发的大语言模型角色扮演评估新标准

这项研究介绍了RPEval,一个专为评估大语言模型角色扮演能力而设计的新基准。研究团队从法国里尔大学开发的这一工具专注于四个关键维度:情感理解、决策制定、道德对齐和角色一致性,通过单轮交互实现全自动评估。研究结果显示Gemini-1.5-Pro在总体表现上领先,而GPT-4o虽在决策方面表现出色,但在角色一致性上存在明显不足。这一基准为研究人员提供了一个可靠、可重复的方法来评估和改进大语言模型的角色扮演能力。

-

LegalSearchLM:北大团队打造突破性法律案例检索新方法,将案例检索重新定义为法律要素生成

这篇论文介绍了LegalSearchLM,一种创新的法律案例检索方法,将检索任务重新定义为法律要素生成。研究团队构建了LEGAR BENCH数据集,涵盖411种犯罪类型和120万案例,并开发了能直接生成关键法律要素的检索模型。实验表明,该模型在准确率上超越传统方法6-20%,且在未见犯罪类型上展现出强大泛化能力。这一突破为法律专业人士提供了更高效、精准的案例检索工具。