大模型在数学题自我修正中的困境:NAVER与KAIST联合揭示的新基准

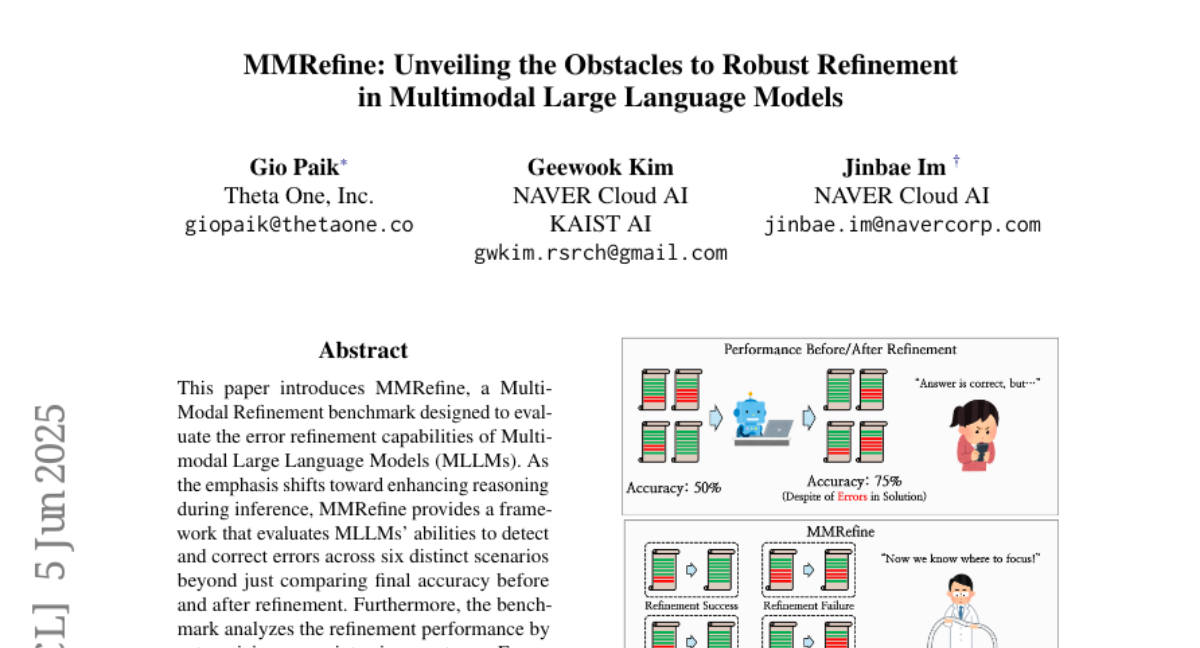

这项由NAVER Cloud AI和韩国科学技术院(KAIST)的Gio Paik、Geewook Kim和Jinbae Im领导的研究发表于2025年6月,论文题为"MMRefine: Unveiling the Obstacles to Robust Refinement in Multimodal Large Language Models"。有兴趣深入了解的读者可以通过arXiv:2506.04688v1访问完整论文。

想象一下,你正在辅导一个孩子做数学题。这个孩子很聪明,能解出很多复杂的题目,但当你让他检查自己的答案时,他却经常犯一个奇怪的错误:要么把本来正确的答案改错了,要么明明答案有问题却坚持说没错。这种现象其实也出现在当今最先进的人工智能模型身上。

我们都知道,大型语言模型(就像ChatGPT、Claude这样的AI助手)在解决数学问题方面已经相当出色了。但是,就像那个聪明的孩子一样,这些AI在"自我反省"和"修正错误"方面却表现得让人意外。当我们要求它们重新检查自己的答案并进行改进时,结果往往不如人意。

这就像一个厨师,他能做出美味的菜肴,但当你要求他品尝自己的菜并调整口味时,他却经常越调越糟。这种现象在AI领域被称为"自我完善"或"自我修正"能力的不足,它直接影响了AI系统在实际应用中的可靠性。

为了深入理解这个问题,NAVER和KAIST的研究团队就像是给AI做了一次全面的"体检",专门检查它们在数学题修正方面的能力。他们发现,虽然AI在初次解题时表现不错,但在重新审视和改进答案时却经常出现问题。这个发现对于我们理解AI的局限性,以及如何让AI变得更加可靠,都具有重要意义。

更有趣的是,研究团队发现不同大小、不同架构的AI模型在处理错误修正时展现出了完全不同的"性格特点"。有些模型像是过于谨慎的学生,总是怀疑自己的正确答案;有些则像是过于自信的学生,明明错了却死不承认。这种发现不仅揭示了当前AI技术的瓶颈,也为未来的技术改进指明了方向。

一、揭开AI自我修正的神秘面纱

要理解AI在自我修正方面的困难,我们首先需要明白什么是"自我修正"。想象你在做一道复杂的数学题,做完后你会重新检查每一步,看看是否有计算错误或逻辑漏洞,然后修正这些问题。这个过程对人类来说很自然,但对AI来说却充满挑战。

传统的研究方法就像是只看考试成绩,只关注AI修正前后的最终答案是否正确。但NAVER团队意识到,这种方法就像只看病人的体温而不做全面检查一样,无法真正诊断问题所在。他们决定创建一个更加细致的"诊断工具",能够深入分析AI在修正过程中的每一个环节。

这个诊断工具被称为MMRefine,它就像是一个超级精密的显微镜,能够将AI的修正过程分解为六个不同的场景。这六个场景就像是六种不同的"病症类型",帮助研究人员准确定位AI在哪个环节出了问题。

首先是"错误检测失败",就像一个学生明明算错了,但他自己却浑然不觉。在这种情况下,AI根本没有意识到自己的答案有问题,自然也就不会去修正。这是最基础也是最致命的问题,因为如果连错误都发现不了,后续的一切修正都无从谈起。

其次是"虚假错误检测",这就像一个过度焦虑的学生,明明答案是对的,却总觉得哪里不对劲,结果把正确答案改错了。这种情况特别令人沮丧,因为AI不仅没有改进,反而越改越糟。

然后是"错误检测成功",AI能够发现问题所在,就像学生能够指出"这里的计算有误",但这只是第一步。发现问题并不意味着能够解决问题。

接下来是"错误纠正成功",AI不仅能发现错误,还能正确修正它,就像学生不仅能说"这里算错了",还能给出正确的计算结果。但即使到了这一步,也不能说大功告成。

最后是"完美修正",这是最理想的情况,AI不仅能发现并纠正错误,还能基于这个修正继续完成剩余的解题步骤,最终得到正确答案。这就像学生不仅改正了中间的计算错误,还能基于正确的中间结果继续完成整道题。

还有一种情况是"验证成功",即AI正确识别出原本答案就是对的,不需要修改。这看似简单,但实际上需要AI具备很强的判断能力。

通过这种细致的分析框架,研究团队能够准确定位每个AI模型的具体问题所在,就像医生能够准确诊断病人是哪个器官出了问题一样。

二、构建AI修正能力的检测实验室

为了全面测试AI的修正能力,研究团队精心构建了一个"实验室环境"。这个实验室包含了200道精心挑选的数学题,就像是为AI准备的一套标准化考试。这些题目不是随便挑选的,而是经过深思熟虑的设计。

想象一下,如果你要测试一个学生的数学修正能力,你会怎么做?你可能会给他一些他能做对的题目,一些他可能做错的题目,还有一些涉及不同数学领域的题目。研究团队的思路也是如此,他们从两个重要的数学题库中挑选了题目:一个专注于纯文字数学题(MathOdyssey),另一个包含图形和视觉元素的数学题(MathVision)。

这种设计非常巧妙,就像同时测试学生的"纯计算能力"和"图形理解能力"。纯文字题目主要考查AI的逻辑推理和计算能力,而包含图形的题目则额外考查AI是否能正确理解和分析视觉信息。这样的设计确保了测试的全面性。

更重要的是,研究团队意识到,要真正测试修正能力,他们需要的不是标准答案,而是真实的"学生答案"。就像要测试老师的批改能力,你不能只给他标准答案,而要给他真实学生的答卷一样。

因此,他们让四个不同的AI模型(GPT-4O、Gemini-1.5-Pro、Claude-3.5-Sonnet和Llama-3.2-Vision-11B)先做这200道题,产生了800个"学生答案"。这些答案有对有错,有的错误很明显,有的错误很隐蔽,完美模拟了真实的学习场景。

接下来的步骤更加精妙。研究团队为每道题准备了"标准批改意见",就像优秀的数学老师会给出的详细批改一样。这些批改意见不是简单的"对"或"错",而是详细指出了错误在哪里,应该如何修正。

为了确保这些"标准批改意见"的质量,研究团队采用了多重验证的方法。他们首先让最先进的AI系统OpenAI O1生成初始的批改意见,然后让三个不同的AI模型根据这些意见尝试修正答案。只有当所有三个模型都能基于这个批改意见成功修正答案时,这个批改意见才被认为是合格的。如果有任何一个模型无法基于批改意见完成修正,研究团队就会重新生成或手动修正批改意见。

这个过程就像是反复校对教学材料,确保每一个指导意见都是清晰、准确、可操作的。通过这种严格的质量控制,研究团队确保了实验的可靠性和公正性。

三、六种错误类型的深度解析

在深入分析AI的修正能力时,研究团队发现了一个有趣的现象:AI犯的错误并不是随机的,而是可以分类的。就像医生能够将疾病分类一样,研究人员将AI在数学解题中的错误分为了六个主要类型。

第一种是"问题理解错误",这就像学生拿到题目后完全理解错了题意。比如题目问的是"小明有多少个苹果",但AI理解成了"小明有多少个橙子"。这种错误通常发生在题目描述复杂或者有歧义的时候。有趣的是,AI在这方面的表现往往反映了它对语言细节的敏感程度。

第二种是"逻辑推理错误",这类似于学生理解了题意,但在推理过程中出现了逻辑漏洞。比如知道"如果A大于B,B大于C,那么A大于C"这个基本逻辑,但在具体应用时却搞混了。这种错误往往出现在需要多步推理的复杂题目中。

第三种是"计算错误",这是最直观的错误类型,就像学生在做加减乘除时算错了。你可能会觉得AI在这方面应该不会出错,但实际上,当计算变得复杂,特别是涉及多个步骤时,AI也会像人类一样出现计算失误。

第四种是"方程错误",这涉及到代数操作的错误。比如在解方程时,AI可能会在移项、化简或者代入数值时出现错误。这就像学生知道解方程的基本步骤,但在具体操作时出现了手误。

第五种是"视觉感知错误",这是多模态AI特有的错误类型。当题目包含图形、图表或者几何图形时,AI可能会错误识别图中的信息。比如把圆形看成椭圆形,或者读错图表中的数值。这就像学生看图时眼花了。

第六种是"空间推理错误",这涉及到对几何关系和空间概念的理解。比如在处理立体几何问题时,AI可能会搞混前后、左右的空间关系,或者错误理解角度和距离的关系。

通过对这六种错误类型的深入分析,研究团队发现了一个令人惊讶的规律:不同大小和类型的AI模型在这些错误类型上表现出了明显的"个性差异"。

大型模型(参数量超过70B的模型)在处理前四种主要与文字和逻辑相关的错误时表现更好,就像数学基础扎实的优等生。但在处理最后两种与视觉和空间相关的错误时,它们的表现却不如预期。

相反,一些较小的模型(参数量在7B左右)在处理视觉和空间推理错误时表现得出人意料地好。这就像一些在传统数学上可能不是最强的学生,在空间想象和图形理解方面却展现出了特殊的天赋。

这个发现颠覆了"模型越大越好"的简单认知。研究团队发现,在空间推理能力方面,甚至一些中等规模的开源模型(如Llava-Next-7B和Qwen2-VL-7B)的表现超过了某些闭源的大型模型。

四、令人意外的实验结果

当研究团队完成了对17个不同AI模型的全面测试后,结果令人既惊讶又担忧。这就像对一群被寄予厚望的优等生进行考试,结果发现他们在某些基本技能上的表现远不如预期。

首先,最令人关注的发现是,即使是最先进的闭源商业模型,在修正能力方面的表现也存在明显的局限性。GPT-4O在修正方面的综合得分(RefScore)为22.5分,这意味着它能成功修正约23%的错误答案,同时避免将正确答案改错。这个数字听起来可能不算太糟,但考虑到这是目前最先进的AI系统之一,这样的表现确实让人担忧。

更令人意外的是Gemini-1.5-Pro的表现。虽然它的修正成功率达到了45%,看似表现不错,但它却有一个致命的弱点:经常把正确答案改错。这就像一个过于"勤奋"的学生,总是觉得自己的答案有问题,结果越改越糟。在包含视觉元素的数学题上,Gemini-1.5-Pro甚至出现了负分,意味着它的修正行为弊大于利。

开源模型的表现更是让人担忧。大部分开源模型的修正成功率都在20%以下,这意味着它们在80%以上的情况下要么发现不了错误,要么无法正确修正错误。特别是那些参数量较小的模型,如InternVL2.5-1B,修正成功率仅有1.88%,几乎完全不具备自我修正的能力。

但是,实验结果中也有一些亮点。Qwen2-VL-7B这个中等规模的开源模型在某些方面的表现甚至超过了Claude-3.5-Sonnet这样的闭源模型。这就像班级里一个不太起眼的学生在某次考试中突然超常发挥,让人刮目相看。

研究团队还发现了一个有趣的现象:模型的错误检测能力(mRecall)普遍好于其错误修正能力。大部分模型都能在70%以上的情况下正确识别出答案是对是错,但真正能够修正错误的比例却要低得多。这就像学生们都有一双"火眼金睛",能看出答案有问题,但却不知道该如何修正。

为了验证MMRefine基准的有效性,研究团队进行了一个巧妙的验证实验。他们让同样的AI模型在其他数学基准测试(MATH-500和MathVista)上进行自我反省,然后对比这些结果与MMRefine得分的相关性。结果发现,MMRefine得分与模型在其他测试中的自我修正能力呈现出强烈的正相关关系(相关系数达到0.82),这证明了MMRefine确实能够有效预测AI的修正能力。

五、效率与性能的权衡困境

除了修正能力本身,研究团队还关注了一个现实问题:修正过程的效率。毕竟,在实际应用中,我们不仅要考虑AI能否修正错误,还要考虑这个过程是否值得。

想象一下,如果让学生重新检查作业需要花费原本做题时间的两倍,而最终只能提高20%的正确率,这样的投入产出比是否合理?研究团队发现,AI的修正过程确实存在类似的效率问题。

测试结果显示,执行修正过程通常会增加60%到100%的计算时间。这就像原本5分钟能解完的题目,现在需要8到10分钟。对于需要快速响应的应用场景,这种时间延迟可能是不可接受的。

更有趣的是,不同模型在修正效率上表现出了显著差异。GPT-4O虽然修正能力不是最强的,但它的修正效率却是最高的,每增加一分钟的计算时间能带来0.33分的性能提升。相比之下,Claude-3.5-Sonnet的修正效率只有0.15,意味着同样的时间投入,GPT-4O能带来更多的性能改进。

这个发现对于实际应用具有重要意义。在资源有限的情况下,选择修正效率高的模型可能比选择修正能力最强的模型更加明智。这就像在选择交通工具时,有时候选择速度适中但油耗低的车型比选择最快但最耗油的车型更加合理。

研究团队还发现,修正过程的效果很大程度上取决于初始答案的质量。当初始答案来自能力较弱的模型时,修正的成功率往往更高。这个现象很容易理解:错误越明显,越容易被发现和修正。相反,当初始答案来自高水平模型时,其中的错误往往更加隐蔽,修正的难度也更大。

六、不同错误类型的修正难度差异

通过对六种错误类型的深入分析,研究团队揭示了一个重要规律:并非所有错误都是平等的。就像有些病容易治,有些病很难治一样,AI在修正不同类型的错误时表现出了明显的能力差异。

在处理"问题理解错误"时,大型闭源模型表现出了明显优势。GPT-4O和Gemini-1.5-Pro在这类错误的修正上得分都超过了30分,而大部分开源模型的得分都在10分以下。这说明理解复杂语言描述并识别理解偏差需要强大的语言处理能力,这正是大型模型的强项。

在"逻辑推理错误"方面,模型之间的差异更加明显。Gemini-1.5-Pro在这方面表现突出,得分接近50分,而一些小型模型的得分甚至不到5分。这种差异可能反映了不同模型在训练过程中接触的逻辑推理训练数据的差异。

"计算错误"的修正呈现出有趣的两极分化。要么模型能够很好地处理(如Gemini-1.5-Pro得分超过60分),要么就几乎完全无法处理(很多模型得分低于10分)。这可能是因为计算错误相对直接,要么能发现和修正,要么就完全漏掉。

最令人意外的发现出现在"空间推理错误"上。在这个领域,传统的"大模型更好"规律完全被打破了。一些中等规模的模型,如Qwen2-VL-7B,在空间推理错误修正上的得分(34.6分)甚至超过了所有闭源大型模型。Llava-Next-7B在这方面的表现(26.9分)也相当出色。

这个现象就像发现班级里一些平时成绩中等的学生在空间想象测试中突然表现优异一样令人惊讶。研究团队推测,这可能与不同模型的视觉编码器架构和训练策略有关。某些模型可能在视觉-空间信息处理方面采用了更适合的架构设计。

"视觉感知错误"的修正也呈现出类似的规律,中等规模的视觉专门模型在这方面往往比大型通用模型表现更好。这提醒我们,在特定任务上,专门化的设计可能比简单的规模扩大更加有效。

通过相关性分析,研究团队发现大部分错误类型之间存在较强的正相关关系,这意味着在某种错误类型上表现好的模型,在其他类型上通常也表现不错。但"空间推理错误"是个例外,它与其他错误类型的相关性都很低,这进一步证实了空间推理能力可能需要特殊的架构设计和训练策略。

七、基准测试的可靠性验证

为了确保研究结果的可靠性,研究团队进行了多重验证,就像科学实验需要重复验证一样。他们面临的最大挑战是如何客观评判AI的修正过程,这就像需要一个"超级老师"来批改AI的作业。

由于数学修正过程的复杂性和主观性,传统的自动评估方法往往不够准确。研究团队采用了GPT-4O作为"评判员",让它来判断AI的修正是否正确。但这种方法的可靠性如何呢?

为了验证这种评估方法的准确性,研究团队进行了人工验证和OpenAI O1验证的对比实验。结果显示,GPT-4O的判断与人类专家的判断一致性达到72%,与OpenAI O1的判断一致性达到73%。虽然不是完美的,但考虑到数学修正过程的复杂性,这样的一致性已经相当不错了。

更重要的是,研究团队发现,即使存在一些判断差异,这些差异在统计上是随机分布的,不会系统性地偏向某个特定模型。这意味着虽然个别判断可能有误差,但整体的比较结果仍然是可靠的。

为了进一步验证基准的有效性,研究团队将MMRefine的结果与其他标准数学基准测试的自我反省结果进行了对比。他们发现,在MMRefine上表现好的模型,在MATH-500和MathVista的自我反省测试中通常也表现更好,相关系数达到0.82,这强有力地证明了MMRefine的预测能力。

研究团队还进行了一个有趣的实验:他们测试了过程奖励模型(Process Reward Models)在修正任务上的表现。过程奖励模型是专门用来评估推理过程质量的AI系统,理论上应该具备一定的错误检测能力。

实验结果显示,过程奖励模型确实具有一定的错误检测能力,但它们的表现特点是"宁可放过,不可错杀"。它们在识别正确答案方面表现很好(验证成功率高),但在发现错误方面表现较差(错误检测率低)。这就像一个过于谨慎的老师,很少会把对的改成错的,但也经常漏掉真正的错误。

八、深层问题的揭示与思考

通过这项全面的研究,NAVER和KAIST团队不仅提供了一个评估AI修正能力的工具,更重要的是揭示了当前AI技术面临的深层问题。

首先,这项研究表明,当前AI的"自我意识"能力仍然非常有限。就像一个学生可能很会做题,但缺乏反思和自我批评的能力一样,现在的AI模型在自我评估和自我改进方面存在根本性的不足。这个问题的根源可能在于训练过程中缺乏足够的"自我反省"训练数据和相应的训练策略。

其次,研究揭示了AI能力发展的不平衡性。我们通常认为更大的模型应该在各个方面都更强,但实际情况要复杂得多。在某些特定任务上,专门化的小模型可能比通用的大模型表现更好。这提醒我们,AI的发展不应该只追求规模的扩大,还需要考虑架构的优化和任务的专门化。

第三,修正过程的低效率问题揭示了当前AI推理过程的局限性。AI在修正过程中往往需要重新进行完整的推理,而不能像人类那样只针对问题部分进行局部修正。这种"全盘重来"的修正方式不仅效率低下,还可能引入新的错误。

研究团队还发现了一个值得深思的现象:AI在处理自己生成的内容时表现得比处理其他AI生成的内容更差。这就像学生在检查自己作业时往往不如检查别人作业时那么仔细一样。这个现象可能反映了AI在处理信息时存在某种"盲点"或"惯性思维"。

最后,这项研究还揭示了多模态AI发展中的一个重要问题:视觉理解和空间推理能力的发展滞后于文本处理能力。虽然现在的多模态AI能够"看到"图像,但它们对视觉信息的理解和推理能力显然还有很大提升空间。

说到底,这项研究就像是给当前的AI技术做了一次深度体检,结果发现我们这些"AI学生"虽然在某些方面表现出色,但在自我反省和错误修正这些更高层次的认知能力上还有很长的路要走。NAVER和KAIST团队创建的MMRefine基准不仅为我们提供了一个评估工具,更重要的是为未来AI技术的发展指明了方向。

这个发现对普通人意味着什么呢?简单来说,当我们在使用AI助手时,不应该盲目相信它们的"自我修正"能力。如果你要求AI重新检查它的答案,结果可能并不会更好,甚至可能更糟。因此,在重要的决策或复杂的问题求解中,人类的监督和验证仍然是必不可少的。

这项研究也提醒AI开发者们,仅仅追求模型规模的扩大是不够的,还需要在训练策略、架构设计和能力平衡方面进行更深入的思考和创新。只有这样,我们才能开发出真正可靠、可信的AI系统,让它们成为人类更好的助手和伙伴。

如果读者对这项研究的技术细节感兴趣,可以通过arXiv:2506.04688v1查阅完整的论文,其中包含了更详细的实验设计、数据分析和技术讨论。

好文章,需要你的鼓励

-

大语言模型为什么老是"胡编乱造"?OpenAI团队揭开AI幻觉的真相

OpenAI团队的最新研究揭示了大语言模型产生幻觉的根本原因:AI就像面临难题的学生,宁愿猜测也不愿承认无知。研究发现,即使训练数据完全正确,统计学原理也会导致AI产生错误信息。更重要的是,现有评估体系惩罚不确定性表达,鼓励AI进行猜测。研究提出了显式置信度目标等解决方案,通过改革评估标准让AI学会诚实地说"不知道",为构建更可信的AI系统指明方向。

-

ByteDance AI实验室发布重磅研究:让计算机学会"逆向思考",解决创意写作难题

字节跳动AI实验室提出"逆向工程推理"新范式,通过从优质作品反推思考过程的方式训练AI进行创意写作。该方法创建了包含2万个思考轨迹的DeepWriting-20K数据集,训练的DeepWriter-8B模型在多项写作评测中媲美GPT-4o等顶级商业模型,为AI在开放性创意任务上的应用开辟了新道路。

-

电脑终于学会了像人类一样用键盘鼠标:ByteDance推出会玩游戏的AI助手

ByteDance Seed团队开发的UI-TARS-2是一个革命性的AI助手,能够通过观看屏幕并用鼠标键盘操作电脑,就像人类一样完成各种任务和游戏。该系统采用创新的"数据飞轮"训练方法,在多项测试中表现出色,游戏水平达到人类的60%左右,在某些电脑操作测试中甚至超越了知名AI产品,展现了AI从对话工具向真正智能助手演进的巨大潜力。