清华大学团队推出突破性3D预训练框架:让计算机像人类一样"看懂"立体世界

这项由清华大学自动化系王子一、张彦然、周杰和吕建伟教授团队完成的研究发表于2025年6月的arXiv预印本平台,论文编号为arXiv:2506.09952v1。这项研究首次提出了一个真正"通用"的3D点云预训练方法UniPre3D,突破了以往方法只能处理特定规模数据的局限。有兴趣深入了解的读者可以通过https://github.com/wangzy22/UniPre3D访问项目代码和完整论文。

想象一下,如果你要教一个从未见过世界的孩子认识物体,你会怎么做?你可能会先给他看一个苹果的照片,然后让他从不同角度观察真实的苹果,最后他就能理解什么是"苹果"。计算机学习3D世界的过程其实也很相似,但问题在于,过去的方法就像是用不同的教学方式分别教孩子认识"玩具"和"房子"——对于小物件用一套方法,对于大场景又用另一套完全不同的方法。这就造成了一个尴尬的局面:专门认识玩具的"学生"看到房子就懵了,而专门认识房子的"学生"看到玩具也不知所措。

清华大学的研究团队意识到了这个问题的关键所在。在我们的日常生活中,无论是拍摄一个茶杯还是拍摄整个客厅,照片的像素数量和信息密度都相对接近。但是在3D世界里,一个茶杯可能只包含1000多个点,而一个完整的室内场景却可能包含超过10万个点——相差上百倍。这就像是要求同一个老师既要教幼儿园的简单算术,又要教大学的高等数学,难度差异实在太大。

现有的3D学习方法因此被迫"分工合作"。处理小物件的方法擅长捕捉精细的几何结构,就像显微镜一样能看清楚细节,但面对庞大的场景数据就力不从心。而处理大场景的方法善于把握整体关系,就像望远镜一样能看到全景,但处理小物件时又会丢失重要的细节信息。更关键的是,目前还没有一种预训练方法能够同时适用于这两种截然不同的数据规模。

研究团队的突破性想法是:既然2D图像不存在这种规模差异问题,为什么不把3D数据"翻译"成2D图像来处理呢?就像把复杂的立体拼图投影到墙上的影子,然后通过分析这些影子来理解原本的立体结构。他们选择了一种叫做"3D高斯喷射"的技术作为这个"翻译器",这种技术就像是有一台神奇的投影仪,能够把3D点云数据变成逼真的2D图像。

这个想法听起来简单,但实现起来却充满挑战。想象你要把一座山的地形图转换成不同角度的风景照片,你需要知道每个位置的高度、颜色、材质等信息,还要考虑光照、阴影等因素。3D高斯喷射技术的巧妙之处在于,它用一系列"高斯原语"来描述3D空间中的每个区域,每个原语都包含位置、形状、透明度和颜色等属性,就像是用无数个半透明的彩色气球来重建整个3D世界。

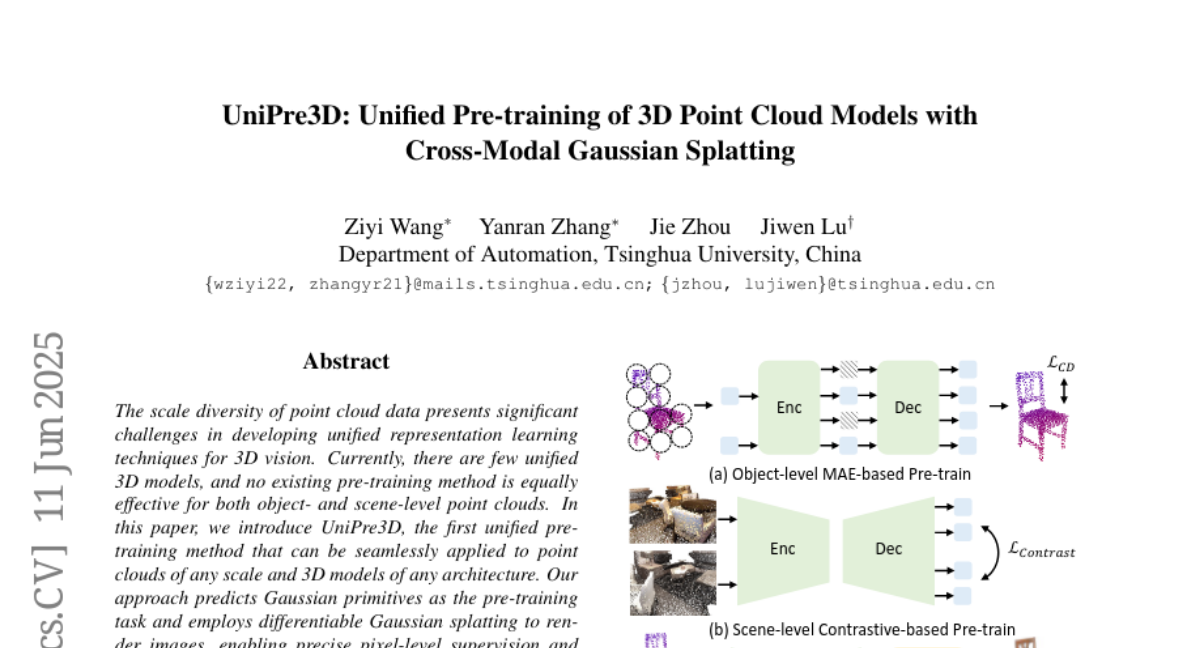

但是仅仅有这个"翻译器"还不够。研究团队发现,对于不同规模的数据,需要采用不同的融合策略。对于小物件,比如一把椅子或一个花瓶,由于缺乏颜色信息(通常只有几何形状数据),他们设计了"特征融合"策略,就像给黑白照片上色一样,从预训练的图像模型中借用颜色和纹理知识。而对于大场景,比如整个房间或办公室,由于数据过于稀疏和复杂,他们采用了"点融合"策略,相当于在原有的3D点云中添加更多的"虚拟点"来增加密度,让整个场景变得更加丰富和易于处理。

在具体实现过程中,整个系统就像一个精密的工厂流水线。首先,3D点云数据进入"特征提取车间",由专门的骨干网络提取基本特征。同时,参考图像进入"图像处理车间",由预训练的图像模型提取颜色和纹理信息。接下来,这两路信息在"融合车间"中巧妙结合,根据数据规模选择不同的融合策略。最后,融合后的特征送入"高斯预测车间",生成描述3D场景的高斯原语参数,再通过"渲染车间"生成最终的2D图像进行监督学习。

研究团队还解决了一个重要的技术细节:如何建立2D图像像素和3D点云点之间的对应关系。对于物体级别的数据,由于缺乏深度信息,他们采用了"从3D到2D"的投影方法,就像用手电筒照射物体在墙上产生影子,然后根据影子的位置找到对应的3D点。而对于场景级别的数据,由于有真实的深度图,他们可以直接使用"从2D到3D"的反投影方法,就像通过GPS坐标准确定位地面上的每个位置。

为了验证这个方法的有效性,研究团队进行了极其全面的实验验证。在物体级别的任务中,他们选择了从传统的Transformer架构到最新的Mamba3D等多种不同的骨干网络进行测试。在ScanObjectNN数据集的分类任务中,UniPre3D在最具挑战性的PB_T50_RS分割上达到了87.93%的准确率,显著超越了之前的方法。更令人印象深刻的是,即使在已经具有很高基线性能的Mamba3D模型上(92.6%),UniPre3D仍然能够将其提升到93.4%,这种持续的改进能力充分说明了方法的鲁棒性。

在场景级别的任务中,实验结果同样令人振奋。在ScanNet20语义分割任务中,使用SparseUNet作为骨干网络的UniPre3D达到了75.8%的mIoU,超越了大多数现有的对比学习方法。特别值得注意的是,在更具挑战性的ScanNet200数据集上,UniPre3D表现出了卓越的性能,这个数据集包含200个类别且呈现长尾分布,对方法的泛化能力提出了极高要求。当使用更先进的PointTransformerV3作为骨干网络时,UniPre3D将ScanNet200上的性能从35.2%提升到36.0%,这种提升在如此高的基线上尤为珍贵。

研究团队还进行了详尽的消融实验来验证设计选择的合理性。他们发现,对于物体级别的预训练,在最后一个解码器层进行特征融合效果最佳,过多的融合层反而会降低性能,这可能是因为模型过度依赖2D特征而限制了3D骨干网络的学习能力。对于场景级别的预训练,点融合策略显著优于特征融合策略,这证实了不同规模数据需要不同处理策略的设计理念。此外,他们还验证了参考视图数量的影响,发现8个参考视图是最优选择——太少会使预训练任务过于复杂,太多则会使任务过于简单。

从技术创新的角度来看,UniPre3D的最大突破在于首次实现了真正意义上的"统一"3D预训练。过去的方法就像是专门的工具,螺丝刀只能拧螺丝,榔头只能敲钉子。而UniPre3D更像是一把瑞士军刀,不同的功能模块可以根据任务需求灵活组合使用。这种设计哲学的转变意义深远,它不仅解决了当前3D视觉领域的技术痛点,更为未来的通用人工智能发展提供了重要思路。

在实际应用方面,这项技术的潜在影响面极其广泛。在自动驾驶领域,车辆需要同时理解小到路边的标志牌、大到整个道路场景的3D信息,UniPre3D的统一处理能力将大大提升感知系统的效率和准确性。在机器人技术中,家用机器人需要能够识别桌上的杯子,也要能够理解整个房间的布局,这种跨尺度的理解能力正是UniPre3D所提供的。在虚拟现实和增强现实应用中,用户既需要与小物件进行精细交互,也需要在大场景中自由移动,统一的3D理解能力将带来更加流畅和自然的用户体验。

从方法学的角度来看,UniPre3D的成功还体现了跨模态学习的强大潜力。通过巧妙地结合3D几何信息和2D视觉信息,研究团队展示了如何让不同模态的数据相互补充、相互促进。这种思路不仅适用于3D视觉任务,也为其他多模态学习问题提供了宝贵的参考。特别是在当前大模型时代,如何有效融合不同类型的数据已经成为AI发展的关键问题,UniPre3D的设计理念具有重要的启发意义。

研究团队还特别关注了方法的效率问题。相比于之前的一些方法,UniPre3D在保证性能的同时显著提升了训练效率。使用3D高斯喷射技术相比于NeRF渲染方法,速度提升了约一倍,这使得大规模预训练变得更加实际可行。在物体级别的预训练中,只需要一张NVIDIA 3090Ti GPU就能完成训练,而场景级别的预训练也只需要8张GPU,这种相对较低的计算需求使得更多的研究团队和开发者能够使用这项技术。

值得一提的是,研究团队在实验设计上也体现了科学研究的严谨性。他们不仅在多个标准数据集上进行了测试,还选择了从经典到最新的各种骨干网络架构进行验证,确保结论的普适性。从传统的PointNet++到最新的Mamba3D,从经典的SparseUNet到先进的PointTransformerV3,UniPre3D都能带来一致的性能提升,这种广泛的适用性是该方法实用价值的重要体现。

在可视化结果中,我们可以清楚地看到UniPre3D的学习效果。对于物体样本,即使只有一个参考视图提供颜色线索,系统也能准确预测其他视角的几何形状和颜色信息,这说明3D骨干网络确实学会了提取robust的几何特征。对于场景样本,虽然渲染输出相对模糊,但重要的几何关系都得到了有效学习,这对于下游的语义分割和实例分割任务来说已经足够。

当然,这项研究也有一些局限性需要注意。首先,方法仍然需要同时使用点云和图像数据,这增加了数据收集的复杂性。其次,虽然提出了针对物体和场景的不同融合策略,但策略选择仍需要手动决定,这在一定程度上限制了"统一"的程度。此外,该方法目前主要针对物体和场景两个尺度,对于其他可能的尺度(比如城市级别的超大场景)的适用性还有待进一步验证。

从长远发展来看,UniPre3D代表了3D视觉领域向统一化方向发展的重要一步。在人工智能向通用智能发展的大趋势下,能够处理多种类型、多种规模数据的统一方法将变得越来越重要。正如人类视觉系统能够无缝地在不同尺度间切换注意力——从观察手中的书本到欣赏远山的景色,未来的AI系统也需要具备这种跨尺度的理解能力。

研究团队在论文中还提到了一个有趣的观察:2D图像领域不存在显著的尺度差异问题,这启发了他们使用图像作为中间表示来减少3D数据的尺度差异。这种"借力打力"的思路体现了科学研究中的智慧——不是硬碰硬地解决问题,而是巧妙地利用已有的成熟技术来化解难题。这种方法学思路对于其他领域的研究也具有启发意义。

在技术实现层面,UniPre3D的成功还得益于对细节的精心处理。比如在建立2D-3D对应关系时,针对有无深度信息的不同情况采用不同的策略;在损失函数设计中,对前景和背景区域采用不同的权重;在数据增强策略中,根据参考视图和渲染视图的关系进行限制。这些看似微小的技术细节,实际上是方法成功的重要保障。

说到底,UniPre3D的成功不仅仅是一个技术突破,更是一种思维方式的创新。它告诉我们,面对复杂的现实问题,有时候最好的解决方案不是设计更复杂的算法,而是重新审视问题的本质,找到更巧妙的解决路径。就像这项研究一样,通过将3D问题转化为2D问题来解决,既保持了原问题的本质特征,又避开了直接处理的技术难点。

对于3D视觉领域的研究者和从业者来说,UniPre3D提供了一个全新的研究方向和实用工具。它不仅解决了当前的技术痛点,还为未来的发展奠定了基础。我们有理由相信,随着这类统一方法的不断发展和完善,3D人工智能将在更多领域发挥重要作用,让机器真正学会像人类一样理解和感知我们生活的三维世界。这项由清华大学团队完成的研究,无疑为这个目标的实现迈出了坚实而重要的一步。有兴趣进一步了解技术细节的读者,可以访问项目主页https://github.com/wangzy22/UniPre3D获取完整的代码和实验结果。

好文章,需要你的鼓励

-

利用大语言模型探索科学创新前沿:南洋理工大学团队开发检测学术新颖性的突破性方法

这项研究利用大语言模型解决科学新颖性检测难题,南洋理工大学团队创新性地构建了闭合领域数据集并提出知识蒸馏框架,训练轻量级检索器捕捉想法层面相似性而非表面文本相似性。实验表明,该方法在市场营销和NLP领域显著优于现有技术,为加速科学创新提供了有力工具。

-

un?CLIP:通过反转unCLIP来提升CLIP模型的视觉细节捕捉能力

un?CLIP是一项创新研究,通过巧妙反转unCLIP生成模型来增强CLIP的视觉细节捕捉能力。中国科学院研究团队发现,虽然CLIP在全局图像理解方面表现出色,但在捕捉细节时存在不足。他们的方法利用unCLIP生成模型的视觉细节表示能力,同时保持与CLIP原始文本编码器的语义对齐。实验结果表明,un?CLIP在MMVP-VLM基准、开放词汇语义分割和视觉中心的多模态任务上显著优于原始CLIP和现有改进方法,为视觉-语言模型的发展提供了新思路。

-

角色扮演能力大考验:里尔大学研究团队开发的大语言模型角色扮演评估新标准

这项研究介绍了RPEval,一个专为评估大语言模型角色扮演能力而设计的新基准。研究团队从法国里尔大学开发的这一工具专注于四个关键维度:情感理解、决策制定、道德对齐和角色一致性,通过单轮交互实现全自动评估。研究结果显示Gemini-1.5-Pro在总体表现上领先,而GPT-4o虽在决策方面表现出色,但在角色一致性上存在明显不足。这一基准为研究人员提供了一个可靠、可重复的方法来评估和改进大语言模型的角色扮演能力。

-

LegalSearchLM:北大团队打造突破性法律案例检索新方法,将案例检索重新定义为法律要素生成

这篇论文介绍了LegalSearchLM,一种创新的法律案例检索方法,将检索任务重新定义为法律要素生成。研究团队构建了LEGAR BENCH数据集,涵盖411种犯罪类型和120万案例,并开发了能直接生成关键法律要素的检索模型。实验表明,该模型在准确率上超越传统方法6-20%,且在未见犯罪类型上展现出强大泛化能力。这一突破为法律专业人士提供了更高效、精准的案例检索工具。