地平线机器人:让AI世界触手可及的3D世界生成引擎,机器人终于能在真实感虚拟世界中学习了

这项由地平线机器人公司联合GigaAI、3D-Robotics、上海交通大学和南开大学多家机构的研究团队共同完成的突破性研究,发表于2025年6月12日的arXiv平台(论文编号:arXiv:2506.10600v1)。有兴趣深入了解的读者可以通过https://horizonrobotics.github.io/robot_lab/embodied_gen/index.html访问完整的研究成果和开源代码。

想象一下,如果我们能像搭积木一样轻松地创建一个完整的3D虚拟世界,让机器人在其中自由学习和训练,这会是什么样的体验?过去,为机器人创建训练环境就像手工雕刻艺术品一样费时费力,每一个物体、每一个场景都需要专业的3D建模师花费大量时间精心制作。这种传统方式不仅成本高昂,而且创造出的虚拟世界往往缺乏真实感,就像是用纸板搭建的电影布景,看起来华丽却经不起推敲。

研究团队深知这个痛点,他们意识到机器人要想在真实世界中表现出色,就必须在足够逼真的虚拟环境中接受训练。这就像飞行员需要在精密的飞行模拟器中练习一样,虚拟训练环境的真实程度直接影响着机器人在现实世界中的表现。因此,他们开发出了一套名为"EmbodiedGen"的革命性工具包,这个工具包就像是为机器人世界量身定制的"造物主工具箱"。

EmbodiedGen的神奇之处在于,它能够像变魔术一样,仅凭一张照片或一段文字描述,就生成出具有真实物理属性的3D物体和完整场景。这些生成的3D资产不仅外观逼真,更重要的是它们具备了准确的物理特性——重量、摩擦系数、真实尺寸等一应俱全,就像是将现实世界的物体完美复制到了虚拟空间中。研究团队特别注重这些虚拟物体的"水密性",也就是说生成的3D模型在几何结构上完全闭合,没有任何缝隙或漏洞,这样在物理仿真时才能产生准确的碰撞检测和交互效果。

这项研究的创新性体现在它的全方位覆盖能力上。EmbodiedGen不仅能生成静态物体,还能创造出可活动的关节物体,比如可以开关的抽屉、可以转动的门把手等等。这些关节物体在机器人学习抓取和操作技能时至关重要,就像人类学习使用工具时需要了解工具的运作机制一样。更令人惊喜的是,这套工具还能生成风格多样的背景场景,从温馨的客厅到现代化的厨房,从办公室到户外环境,为机器人提供了丰富多样的训练场所。

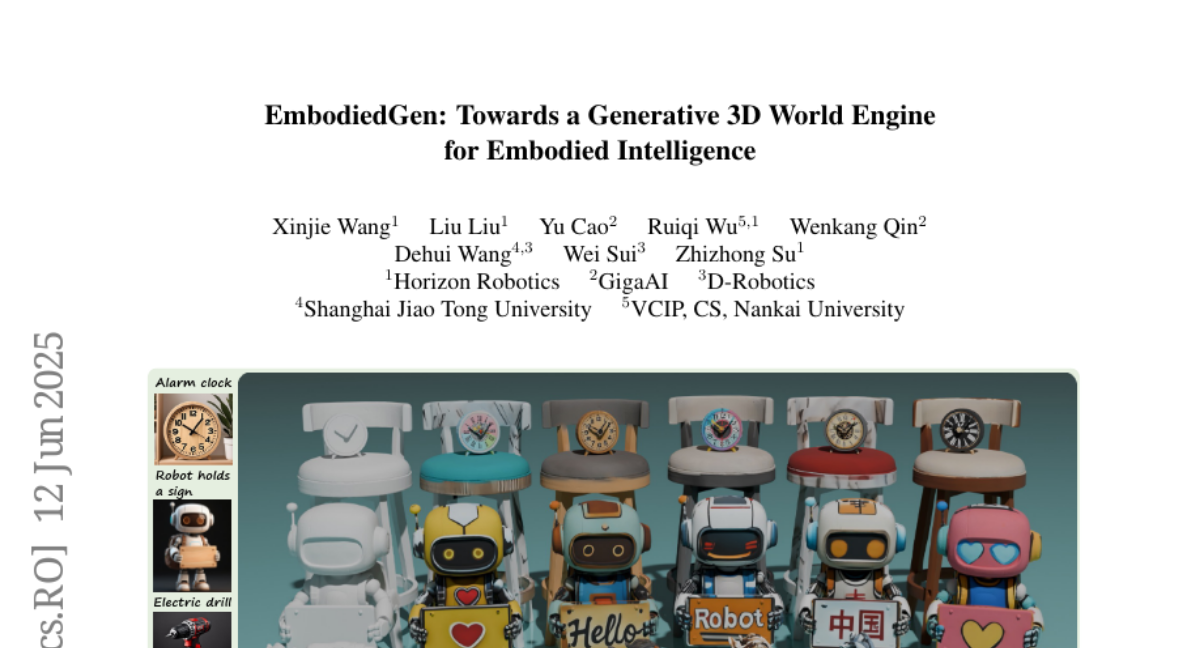

在纹理生成方面,EmbodiedGen表现得尤为出色。它不仅能为3D物体添加逼真的表面材质,还能根据用户需求进行个性化编辑。想象一下,你可以轻松地将一个普通的机器人模型换上不同颜色的外壳,或者给它添加各种标识和图案,这种灵活性为机器人训练提供了无限可能。

研究团队还特别考虑到了实用性问题。生成的所有3D资产都采用了统一机器人描述格式(URDF),这意味着它们可以无缝导入到各种主流物理仿真引擎中,包括OpenAI Gym、Isaac Lab、MuJoCo和SAPIEN等。这就像是为不同品牌的游戏机开发了通用的游戏卡带,确保兼容性和易用性。

一、从图片到3D世界:让静止的照片活起来

当我们看到一张桌子的照片时,大脑会自动补全我们看不到的背面、估算它的重量、想象它的材质触感。EmbodiedGen的图片转3D模块就具备了类似的"想象力",但它的表现甚至超越了人类的直觉判断。

这个过程就像是一位经验丰富的古董鉴定师,仅凭一张照片就能准确判断出古董的年代、材质、价值,甚至能描述出照片中看不到的细节。研究团队选择了Trellis模型作为核心引擎,这个模型在3D几何生成方面表现卓越,能够同时产生网格格式和3D高斯点云格式的双重表示。

然而,直接使用现有模型会遇到一些"水土不服"的问题。原始的Trellis模型虽然在几何重建方面表现优异,但生成的纹理质量却差强人意,特别是存在过度高光的问题,就像是在强烈阳光下拍摄的照片,到处都是刺眼的反光。更关键的是,这些生成的3D模型缺乏真实世界的物理属性,就像是精美的塑料模型,虽然好看但无法用于实际的物理仿真。

为了解决这些问题,研究团队开发了一套完整的"数字孪生"流水线。这个流水线的第一步是物理属性恢复,就像是为虚拟物体注入"灵魂"。他们使用GPT-4o和Qwen等大型语言模型构建了一个"物理专家代理",这个AI专家就像是一位博学的物理学家,能够通过观察物体的外观来推断其物理特性。

具体来说,这个物理专家首先会估算物体的真实高度。它通过渲染物体的正面视图,结合文字提示的约束条件,来判断物体在现实世界中的实际尺寸。由于物体的长、宽、高是相互关联的,一旦确定了高度,就能准确恢复整个3D模型的真实尺寸。对于那些尺寸存在歧义的物体,比如一只老虎(可能是玩具老虎,也可能是真正的老虎),系统提供了文字引导的物理属性恢复接口,用户可以通过添加上下文信息来获得更准确的尺寸预测。

在获得四个正交视图的渲染图像后,物理专家代理还能进一步估算物体的摩擦系数和质量,为其关联语义描述,并进行合适的分类。这就像是一位经验丰富的工程师,能够通过观察就判断出材料的特性和用途。

二、质量把关:让AI成为挑剔的艺术评论家

为了确保生成的3D资产达到实用标准,研究团队开发了一套自动化质量检测系统,这套系统就像是三位严格的质检员,从不同角度对每个生成的3D模型进行全面评估。

第一位质检员是"美学检查员"(AestheticChecker),它专门负责评估纹理的视觉质量。这位检查员就像是一位专业的艺术评论家,能够准确判断纹理的丰富程度和美观度。研究发现,美学分数与纹理细节的丰富程度存在明显的正相关关系,分数越高的资产往往具有更丰富、更逼真的表面细节。

第二位质检员是"分割检查员"(ImageSegChecker),它使用GPT-4o来评估前景提取的质量。这位检查员的任务至关重要,因为前景分割的质量直接影响最终3D资产的生成效果。就像摄影师在拍摄人像时需要确保主体清晰、背景干净一样,良好的前景分割是生成高质量3D模型的基础。为了应对不同类型图像的挑战,系统提供了三种不同的前景分割模型:SAM、REMBG和RMBG14,当一种方法检测失败时,系统会自动切换到替代方案进行重试。

第三位质检员是"几何检查员"(MeshGeoChecker),它通过渲染四个正交视图来评估几何完整性和合理性。这位检查员就像是一位严谨的工程师,会仔细检查生成的3D模型是否存在几何缺陷、是否符合物理常理。比如,一把椅子是否有稳定的支撑结构,一个杯子是否具有合理的开口等等。

通过这套三重质检体系,系统能够自动识别并过滤掉不合格的3D资产。对于未通过质检的模型,系统会自动调整参数和随机种子,重新进行生成,直到获得满意的结果。这种自动化的质量保证机制大大降低了人工筛选的工作量,同时确保了最终输出的可靠性。

三、纹理优化:让虚拟世界告别"塑料感"

传统3D生成方法的一个通病是生成的物体看起来像廉价的塑料玩具,缺乏真实材质的质感。研究团队针对这个问题开发了一套创新的纹理回投影优化算法,这套算法就像是一位经验丰富的后期制作师,能够将粗糙的原始素材打磨成精美的最终作品。

这个优化过程的核心思想是将多视角的RGB图像重新投影回3D空间,但与传统方法不同的是,研究团队采用了基于几何的确定性投影方案,结合视图法线信息进行融合。在重新投影纹理之前,系统会对RGB图像进行全局高光移除和超分辨率处理,从而获得高质量的2K分辨率纹理UV贴图。

具体来说,系统首先使用去光照模型来移除多视角纹理中的光照效果,同时保持各个视角之间的风格和亮度一致性。这个过程就像是给过度曝光的照片调整曝光度,让各个部分的亮度达到自然平衡。接下来,系统对每个视角独立进行4倍超分辨率处理,将分辨率提升到2048×2048像素。令人惊喜的是,实验表明对每个视角独立进行超分辨率处理并不会损害最终3D资产纹理的一致性或质量。

这套纹理优化算法的设计十分巧妙。系统会计算每个像素点的视角置信度,优先采用那些垂直于表面的视角信息,因为这些视角能够提供最准确的纹理细节。同时,系统会排除边缘像素和大角度视角的信息,避免引入失真。最终,所有视角的纹理信息通过置信度加权的方式进行融合,生成高质量的最终纹理。

经过这套优化流程处理的3D模型,不仅在视觉上更加逼真,纹理细节也更加丰富。物体表面的材质质感得到了显著提升,金属的光泽、木材的纹理、布料的质感都能得到准确的呈现,彻底告别了以往那种廉价的"塑料感"。

四、文字创造3D:用语言描绘三维世界

如果说从图片生成3D模型是"照猫画虎",那么从文字描述生成3D资产就是"无中生有"的创造过程。EmbodiedGen的文字转3D模块展现了AI在创造力方面的惊人潜力,它能够理解抽象的文字描述,并将其转化为具体的三维物体。

研究团队采用了分阶段的设计策略,将文字到3D的任务分解为两个步骤:文字到图像,然后图像到3D。这种分解策略带来了多重优势。首先,它支持早期阶段的自动化质量检测,系统能够在投入大量计算资源进行3D生成之前,就对中间生成的图像进行前景分割检查和语义一致性验证,及时过滤掉不符合要求的样本。其次,这种模块化设计提高了迭代的灵活性,降低了维护成本,同时能够充分受益于文字到图像和图像到3D社区的持续进步,支持生成能力、可控性和扩展性的不断提升。

在具体实现上,研究团队选择了Kolors作为文字到图像的生成模型,因为它支持中英文双语的高质量图像生成。对于图像到3D阶段,系统维持统一的EmbodiedGen图像到3D服务,简化了系统复杂性。实验结果显示,相比于端到端的文字到3D模型Trellis-text-xlarge,这种两阶段设计在可控性和生成质量方面都有显著提升,同时大大降低了与端到端文字到3D模型相关的维护成本。

为了验证大规模3D资产生成中自动化质量检测模块的效率,研究团队进行了详细的评估实验。他们生成了150个杯子3D资产并进行人工标注,其中107个被标记为可用,43个被标记为不可用。自动化质量检测系统实现了68.7%的精确度和76.7%的召回率。虽然这些指标还未达到90%以上,但当前系统已经大大减少了资产筛选所需的人工工作量。更重要的是,随着多模态大型模型的进步,这套流水线的自动化质量评估能力还将持续改善。

在大规模资产生成方面,系统展现出了强大的批量处理能力。用户可以通过提示词生成器将需求分解为针对不同资产风格的提示词,比如生成100种不同风格的杯子。整个流水线依次通过文字到图像和图像到3D阶段,每个阶段都配备了自动化质量检测和重试机制,最终输出具有完整几何、真实尺寸和物理属性的URDF资产并持久化存储。

五、关节物体生成:让静态世界动起来

在真实世界中,我们接触到的许多物体都不是完全静态的。柜子有可以开关的门,抽屉可以拉出推入,电器有各种按钮和开关。这些具有活动部件的关节物体对于机器人学习操作技能至关重要,就像人类学习使用工具时需要理解工具的运作机制一样。

传统的3D建模方法在创建关节物体时面临巨大挑战,不仅需要准确建模几何结构,还要理解运动行为和部件连接关系。EmbodiedGen的关节物体生成模块巧妙地解决了这个难题,它使用DIPO框架,这是一种可控的生成框架,能够从双状态图像对构建关节3D物体。

这种双状态输入格式的设计非常巧妙。一张图像显示物体的静止状态,另一张图像显示其关节活动状态。比如,一张图像显示关闭的抽屉,另一张显示打开的抽屉。这种输入格式同时编码了结构信息和运动信息,使模型能够更好地解析运动歧义并预测关节行为。

生成过程基于扩散变换器,在每一层都集成了专门的双状态注入模块来处理这两张图像。DIPO还包含一个基于思维链的图推理器,能够推断各个部件之间的连接关系。生成的关节图作为注意力先验来增强生成的一致性和合理性。

为了提高复杂关节物体生成的泛化能力,研究团队还开发了自动化关节物体数据增强流水线。这个流水线能够使用基于网格的空间推理和从现有3D数据集中检索部件的方法,从自然语言提示中综合关节物体布局。最终得到的PM-X数据集包含600个结构多样的关节物体,每个都标注了渲染图像和物理属性。

这种关节物体生成能力为机器人训练开辟了全新的可能性。机器人可以在虚拟环境中学习如何操作各种复杂的关节物体,从简单的开关门窗到复杂的多抽屉储物柜,这些训练经验能够很好地迁移到真实世界的操作任务中。

六、纹理魔法师:让3D世界换装如换衣

想象一下,如果你能像换衣服一样轻松地为3D物体更换外观,给机器人换上不同的涂装,或者为家具更换不同的材质,这会是多么有趣的体验。EmbodiedGen的纹理生成模块就实现了这样的"魔法",它能够为3D网格模型生成和编辑多风格的纹理。

与训练全新的多视角扩散模型相比,研究团队选择了一种更加巧妙的方法。他们设计了一个即插即用的可扩展模块,能够充分利用现有的2D文字到图像基础模型,将其能力扩展到3D领域。这种设计范式使得系统能够从社区基础模型的持续改进中受益,以成本效益高且可扩展的方式生成视角一致的多样化高质量纹理,同时最小化重训练工作量。

这个模块被称为GeoLifter,它是一个轻量级模块,通过交叉注意力机制将几何控制注入到基础扩散模型中,实现基于3D几何的视角一致纹理生成。研究团队采用Kolors文字到图像模型作为基础扩散模型。与ControlNet等方法复制并训练基础模型U-Net的独立编码器分支不同,GeoLifter保持轻量级和高度可扩展性,其参数大小不会随着基础模型深度的增长而增长,使其更加高效且易于与不断演进的扩散架构集成。

在处理输入网格时,系统从六个预定义的相机视角渲染法线贴图、位置贴图和二值掩码。这些几何条件信息被隐式编码为特征嵌入,通过交叉注意力逐步注入到扩散模型的去噪过程中,利用零卷积确保训练开始时对基础模型解码器的干扰最小。

纹理生成支持正负提示词,接受包括中英文在内的多语言输入,用于指定期望的纹理风格和外观。除了文字提示外,用户还可以选择性地提供RGB图像作为参考风格,作为语言输入的补充控制信号。用户可以仅提供文字提示,仅提供参考图像,或者同时提供两者,这种设计通过联合利用语义指导和视觉风格线索,实现了高度可控和富有表现力的纹理生成。

在损失函数设计上,除了潜在扩散模型中使用的原始损失,研究团队还引入了空间损失作为潜在空间中的几何一致性约束。这个约束鼓励对应于同一3D点的像素的潜在特征在跨多个视角投影时保持接近,从而增强跨视角连贯性。

实验结果显示,GeoLifter在保持轻量级几何条件设计的同时,有效保持了底层基础模型的纹理生成能力,同时显著改善了跨视角的空间和几何一致性。在多视角纹理生成之后,系统应用光照去除和超分辨率技术,并将优化后的纹理投射回3D空间,获得配备高分辨率2K UV贴图的最终纹理网格。

七、场景魔术师:构建多样化的虚拟世界

除了3D物体资产生成,场景多样性作为背景上下文同样发挥着至关重要的作用。想象一下,如果机器人只在单调的白色房间中接受训练,它们很难适应真实世界的复杂环境。EmbodiedGen的3D场景生成模块就像是一位经验丰富的布景师,能够创造出风格迥异、细节丰富的虚拟环境。

这个场景生成框架采用模块化流水线设计,能够将多模态输入转换为全景图像,然后用于生成具有一致真实世界尺度的3D场景。整个框架包含三个主要阶段:全景图像生成、从全景图生成3DGS和网格表示的3D场景生成,以及尺度对齐和标准化输出。

在全景图像生成阶段,系统支持文字、图像或两者结合的输入模式,实现高质量全景图像的灵活高效生成。对于文字驱动生成,用户提供的场景描述通过Diffusion360模型转换为全景视图,该模型在这项任务上表现出色。对于图像驱动生成,系统使用Qwen从输入图像中提取语义描述,然后图像及其对应的文字描述由全景生成模型联合处理,生成语义对齐的全景图。

为了确保质量和可靠性,研究团队引入了PanoSelector模块,这是基于Qwen构建的自动评估和过滤器,根据结构质量指标(如地板和墙壁一致性)自动评估和过滤生成的全景图。这确保了只有高质量的输出才会传递到几何生成阶段。

在获得高质量全景图后,系统基于Pano2Room生成相应的3DGS和网格3D表示。首先从全景输入生成初始网格,然后通过网格优化进一步细化,提高几何精度和重建能力。优化后的网格随后转换为3DGS表示。为了增强视觉保真度,从优化网格渲染的视图被转换为立方体贴图并通过超分辨率模型处理。超分辨率图像然后用于进一步细化初始3DGS,有效提升最终3DGS输出的细节质量。

八、物理世界的精确映射:让虚拟与现实无缝对接

为了产生真实且度量一致的3D场景,系统还需要进行物理属性恢复。这个过程就像是一位精密的测量师,通过观察全景图和语义描述来推断建筑物高度等真实世界尺寸,从而实现网格和3DGS的无损重新缩放。

这个尺度估计模块基于Qwen模型构建,能够推断这些尺度因子,实现网格和3DGS表示的无损重新缩放。此外,坐标系会重新以场景地面为中心,轴向根据输入图像的相机方向或文字描述暗示的方向进行对齐。最终输出是一个尺度对齐的高保真3D场景资产,可直接用于虚拟现实、增强现实和机器人技术的下游应用。

在风格控制方面,系统支持通过风格提示来指导全景图生成,这种风格感知提示能够产生更连贯的纹理和更好的跨场景风格对齐效果。实验对比显示,使用风格提示的结果在纹理一致性和风格统一性方面明显优于没有明确风格指导的版本。

与现有方法如WorldGen的对比实验表明,EmbodiedGen在文字和图像输入设置下都能产生更详细的纹理和更完整的几何结构。生成的场景不仅视觉效果更佳,在几何完整性和细节丰富度方面也有显著优势。

通过超分辨率技术的应用,生成的3D场景展现出更加锐利和高频详细的效果。这种技术能够显著提升最终输出的视觉质量,使虚拟场景在细节表现上更加接近真实环境。

九、实际应用:从虚拟训练到现实部署

EmbodiedGen的真正价值体现在其广泛的实际应用中,这些应用展示了从虚拟训练到现实部署的完整流程。

在大规模3D资产生成方面,EmbodiedGen的文字转3D模块展现出了强大的批量生成能力,能够为机器人智能任务生产大量水密且风格多样的网格,这些网格与文字描述高度一致。这种能力为仿真和下游训练评估提供了低成本的交互式3D资产增强方案。

在3D网格视觉外观编辑方面,EmbodiedGen的纹理生成模块能够生成和编辑具有丰富视觉细节的真实感纹理。这些编辑后的3D资产可用于训练数据增强,增强模型在视觉外观理解方面的泛化能力。研究展示了各种鞋类产品的纹理编辑效果,从简约的白色运动鞋到复杂图案的时尚鞋款,都能实现高质量的纹理变换。

在真实到仿真的数字孪生创建方面,EmbodiedGen图像转3D模块的能力通过Isaac Lab环境中的闭环仿真评估得到了验证。系统能够从单张真实世界图像创建数字孪生,然后在物理仿真环境中进行机器人操作任务的训练和测试。这种能力对于快速构建训练环境、验证算法性能具有重要意义。

特别值得一提的是RoboSplatter的创新应用。现有的仿真器通常基于传统的OpenGL渲染技术,涉及复杂的环境建模、光照设置和基于射线的渲染计算,这些方法往往计算成本高且真实感有限。随着3DGS技术的快速发展,更逼真高效的渲染解决方案成为可能。研究团队将3DGS渲染与MuJoCo和Isaac Lab等成熟物理仿真器集成,实现了视觉丰富且物理精确的仿真。

RoboSplatter是一个专为机器人仿真定制的基于3DGS的仿真渲染框架,它与MuJoCo无缝协作,仿真机器人操作任务如机器人手臂抓取,同时提供3DGS技术支持的高视觉保真度。这种集成为机器人训练提供了前所未有的视觉真实感,同时保持了物理仿真的准确性。

在多样化交互式3D世界构建方面,EmbodiedGen使得构建各种交互式3D世界变得轻而易举,支持在不同虚拟环境中进行操作和导航等机器人智能任务的仿真和评估。系统生成的资产已成功应用于双臂抓鞋任务的仿真评估,以及四足机器人在复杂环境中的导航避障任务。

研究团队还展示了EmbodiedGen在OpenAI Gym环境中的应用效果。通过文字转3D生成的物体资产被成功导入到四足机器人导航仿真中,机器人需要在包含各种障碍物的环境中规划路径并避免碰撞。这种应用验证了生成资产在复杂机器人任务中的实用性和可靠性。

说到底,EmbodiedGen代表了机器人智能训练方式的一次革命性突破。它让我们告别了传统手工建模的繁琐过程,迎来了AI驱动的智能化3D世界生成时代。就像从手工制作到工业化生产的转变一样,这种技术进步将大大降低机器人训练的门槛和成本,让更多研究者和开发者能够参与到机器人智能的发展中来。

更重要的是,EmbodiedGen生成的高质量虚拟环境为机器人提供了更加逼真的训练场所,这意味着机器人在虚拟世界中学到的技能能够更好地迁移到现实世界中。这就像是为机器人提供了一个"梦境训练营",让它们在梦中练就十八般武艺,醒来后就能在现实世界中大显身手。

随着这项技术的开源发布,我们有理由相信,未来的机器人将变得更加智能、更加适应复杂的现实环境。从家庭服务机器人到工业自动化设备,从医疗辅助机器人到探索机器人,它们都将从这种先进的虚拟训练技术中受益。归根结底,EmbodiedGen不仅仅是一个技术工具,更是通向智能机器人时代的一座重要桥梁。对于那些希望深入了解这项技术细节的读者,强烈建议访问研究团队提供的开源代码和详细文档,相信这将为机器人智能领域的发展注入新的活力。

好文章,需要你的鼓励

-

深度学习也能像人一样"看重点"?揭秘视觉AI如何学会聪明地观察世界

这项研究提出了"高效探测"方法,解决了掩码图像建模AI难以有效评估的问题。通过创新的多查询交叉注意力机制,该方法在减少90%参数的同时实现10倍速度提升,在七个基准测试中均超越传统方法。研究还发现注意力质量与分类性能的强相关性,生成可解释的注意力图谱,展现出优异的跨域适应性。团队承诺开源全部代码,推动技术普及应用。

-

伊利诺伊大学新突破:让机器像法官一样剖析复杂争议,不再简单判"真假"

伊利诺伊大学研究团队开发了CLAIMSPECT系统,通过层次化分解复杂争议、智能检索相关文献、多角度收集观点的方法,将传统的"真假"判断转变为多维度分析。该系统能够自动构建争议话题的分析框架,识别不同观点及其支撑证据,为科学和政治争议提供更全面客观的分析,已在生物医学和国际关系领域验证有效性。

-

清华大学突破性发现:让AI像人类一样理解和表达情感的新方法

清华大学研究团队首次提出情感认知融合网络(ECFN),让AI能像人类一样理解和表达情感。该系统通过多层次情感处理架构,在情感识别准确率上比现有最佳系统提升32%,情感表达自然度提升45%。研究突破了传统AI情感理解的局限,实现了跨模态情感融合、动态情感追踪和个性化情感建模,为医疗、教育、客服等领域带来革命性应用前景。

-

哈佛大学揭秘:AI如何像人类一样通过"玩游戏"学会复杂推理

哈佛大学研究团队通过创新的多智能体强化学习方法,让AI在战略游戏中学会复杂推理。研究发现AI通过游戏竞争能发展出类人思维能力,在逻辑推理、创造性解决问题等方面表现显著提升。这项突破性成果为未来AI在医疗、教育、城市管理等领域的应用奠定基础,展现了通过模拟人类学习过程培养真正智能AI的新路径。