香港理工大学团队突破医学AI黑盒:让机器"边看边想"诊断胸片,准确率堪比专家还能解释推理过程

这项由香港理工大学数据科学与人工智能系的刘博、赵向宇等研究者与深圳大学、四川大学华西医院、新加坡科技研究局高性能计算研究所联合完成的研究发表于2025年6月,论文题目为"GEMeX-ThinkVG: Towards Thinking with Visual Grounding in Medical VQA via Reinforcement Learning"。感兴趣的读者可以通过arXiv:2506.17939v1访问完整论文内容,相关数据集也已在https://huggingface.co/datasets/BoKelvin/GEMeX-ThinkVG公开发布。

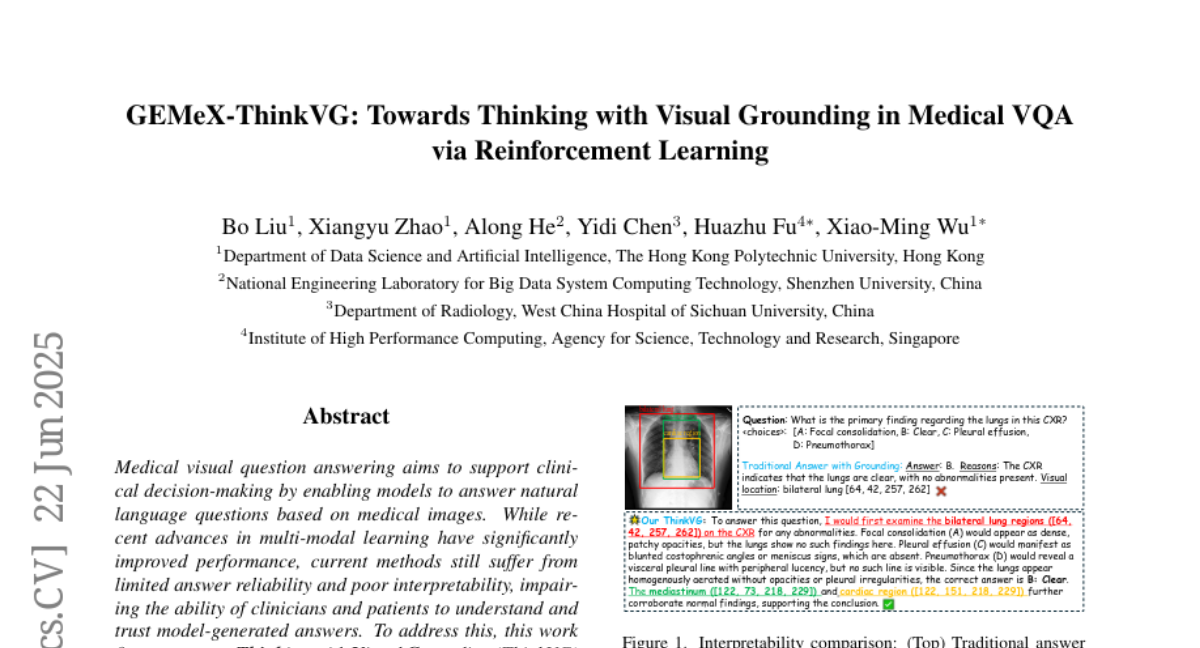

当你拿着胸片找医生看病时,医生会一边观察影像一边向你解释:"你看这个区域,肺部看起来很清晰,没有阴影,心脏大小正常,所以我判断没有问题。"这种"边看边想边解释"的过程对建立医患信任至关重要。然而,现有的医学人工智能系统虽然能给出诊断结果,却无法像人类医生那样清楚解释自己的思考过程,这就像一个"黑盒子"——你知道它的答案,但不知道它是怎么得出这个答案的。

这个问题在医疗领域尤其严重。如果AI说某个病人有肺炎,但无法解释它是基于影像的哪个部位、什么特征得出这个结论,医生和患者怎么敢相信它?正是基于这样的思考,研究团队开发了一套全新的医学视觉问答系统,不仅能准确回答关于医学影像的问题,更重要的是能够详细解释自己的思考过程,就像一位经验丰富的医生在教学查房时的表现。

研究团队面临的核心挑战是如何让AI系统在分析医学影像时不仅给出正确答案,还能清楚地展示它的推理链条。就好比要训练一个学生不仅要做对数学题,还要详细写出解题步骤一样。为了解决这个问题,他们创建了一个名为GEMeX-ThinkVG的新数据集,其中包含了超过20万个医学问答实例,每个实例都配有详细的"思考过程",明确标注了AI应该关注影像的哪些区域,以及基于这些区域应该得出什么样的结论。

更令人印象深刻的是,研究团队还开发了一套基于强化学习的训练方法,就像给AI配备了一位严格的老师,不断纠正它的推理过程。这套方法包含两个关键的奖励机制:一个负责检查答案的准确性,另一个负责验证AI关注的图像区域是否正确。通过这种方式,AI不仅学会了给出正确答案,还学会了像医生一样进行系统性的视觉分析和逻辑推理。

实验结果显示,即使只使用了原始训练数据的八分之一,新系统的表现仍然能够达到使用全量数据训练的传统系统的水平。这不仅大大提高了训练效率,更重要的是证明了"边思考边学习"这种方法的有效性。

### 一、医学AI的"可解释性"难题:为什么我们需要会解释的机器医生

现代医学人工智能就像一位技艺高超但沉默寡言的专家。它能够快速浏览胸片并给出诊断结果,准确率往往令人印象深刻,但当你询问它为什么得出这样的结论时,它却无法给出令人信服的解释。这种情况就好比一位医生只告诉你"你有肺炎",却不愿意指出胸片上的具体病变位置,也不解释他是如何通过这些影像特征得出诊断的。

在医疗实践中,这种"黑盒子"特性带来了严重的信任危机。医生需要知道AI的判断依据才能决定是否采纳其建议,患者也希望了解诊断的具体原因。传统的医学视觉问答系统虽然在技术指标上表现出色,但在可解释性方面存在根本性缺陷。它们通常只能提供简单的文字解释,而且这些解释往往与具体的视觉证据缺乏有机联系。

研究团队发现,现有系统的主要问题在于缺乏系统性的推理过程。就像学生做数学题时只写答案不写解题步骤一样,这些系统直接从问题跳跃到答案,中间的思考过程完全是"暗箱操作"。即使有些系统尝试提供解释,也往往是事后补充的说明,而不是真正的推理过程重现。

更深层的问题在于,医学诊断本身就是一个复杂的认知过程,需要医生综合多个解剖区域的信息,排除各种可能性,最终得出结论。这个过程不仅需要识别病变,还需要理解不同解剖结构之间的关系,以及各种病理表现的相互影响。传统AI系统虽然能够模拟这个过程的结果,却无法重现这个过程本身。

为了解决这些问题,研究团队提出了"思考与视觉定位"相结合的解决方案。这种方法的核心思想是让AI系统模拟真实医生的诊断过程:首先系统性地检查影像的各个关键区域,然后基于每个区域的观察结果进行逻辑推理,最终综合所有信息得出结论。整个过程不仅要有清晰的文字描述,还要精确标注相关的图像区域,形成文字推理与视觉证据的有机统一。

这种方法的意义不仅在于提高了系统的可解释性,更重要的是它重新定义了医学AI的工作方式。从简单的"输入-输出"模式转变为"观察-思考-结论"的认知模式,使AI系统更加符合人类医生的诊断习惯,也更容易获得医疗从业者和患者的信任。

### 二、构建会思考的AI:GEMeX-ThinkVG数据集的创新设计

要让AI学会像医生一样思考,首先需要为它准备合适的"教科书"。研究团队开发的GEMeX-ThinkVG数据集就像是一本详尽的医学影像分析教程,其中包含了超过20万个精心设计的问答实例,每个实例都展示了完整的诊断思维过程。

这个数据集的创建过程本身就是一项技术创新。研究团队面临的挑战是如何确保生成的"思考过程"既符合医学专业标准,又具有足够的教育价值。他们采用了一种多智能体协作的方法,就像组建了一个由多位专家组成的医学教育委员会。

数据生成的核心是DeepSeek-R1模型,这个模型具有出色的推理能力,能够生成符合逻辑的思考过程。然而,由于它本身无法直接处理医学影像,研究团队巧妙地利用了现有的影像报告作为"桥梁"。这些报告就像是影像的文字描述,每个描述都精确对应影像中的特定区域。通过这种方式,DeepSeek-R1能够模拟医生观察影像的过程,生成合理的诊断推理。

但仅仅依靠单一模型生成的内容还不够可靠。为了确保质量,研究团队设计了一套严格的质量控制流程。首先,DeepSeek-R1在生成思考过程后会进行自我反思,评估自己的推理是否可靠。这就像学生做完题目后再检查一遍,如果发现不确定的地方会标记出来。只有那些通过自我检验的内容才会进入下一阶段。

接下来,研究团队引入了三个不同的评审专家:Qwen-2.5-72B、OpenBioLLM-70B和GPT-4o。这三个模型就像三位不同背景的医学专家,从各自的角度评估思考过程的合理性。只有当所有评审者都认为推理过程正确时,这个实例才会被纳入最终的数据集。这种多重验证机制大大提高了数据的可靠性。

为了进一步确保质量,研究团队还设计了一个特殊的"不确定性"选项。当评审模型对某个推理过程存在疑虑时,可以选择"不确定",这会促使系统进行更仔细的分析。这种设计避免了简单的"是非判断"可能带来的偏差,让评估过程更加谨慎和客观。

最终生成的数据集涵盖了四种不同类型的医学问题:开放式问题、封闭式问题、单选题和多选题。每种类型都有数万个实例,总计超过20万个高质量的问答对。更重要的是,每个问答对都包含了详细的思考过程,这些过程不仅描述了推理步骤,还精确标注了相关的图像区域。

为了验证数据集的专业性,研究团队还邀请了放射科医生对随机抽取的样本进行人工审核。结果显示,生成的思考过程在医学专业性方面完全符合临床标准,没有发现任何与医学知识相矛盾的推理链条。这种专业验证确保了数据集不仅在技术上可行,在医学上也是准确可靠的。

### 三、强化学习让AI学会正确思考:双重奖励机制的巧妙设计

有了高质量的数据集,下一个挑战是如何让AI真正学会正确的思考方式。研究团队发现,仅仅通过传统的监督学习方法,AI虽然能够模仿思考过程的表面形式,但往往无法掌握其中的深层逻辑。就像学生只是死记硬背解题步骤,而没有真正理解数学原理一样。

为了解决这个问题,研究团队采用了强化学习的方法,设计了一套精巧的奖励机制来指导AI的学习过程。这种方法就像为AI配备了一位严格而耐心的老师,不仅会指出错误,还会解释为什么错误,应该如何改正。

强化学习的核心是奖励函数的设计。研究团队创建了两个互补的奖励机制,分别针对AI思考过程的两个关键方面:语义准确性和视觉定位准确性。

语义奖励机制负责评估AI得出的答案是否正确。对于有标准答案的选择题,这个评估相对简单,就像判断学生的选择题答案是否正确一样。但对于开放式问题,评估就变得复杂了。研究团队的创新之处在于引入了专门的医学语言模型OpenBioLLM-70B作为评判者。这个模型能够理解医学术语和概念,从语义层面判断AI的答案是否准确。当AI的答案与标准答案在医学含义上一致时,即使用词略有不同,也会获得满分奖励。

视觉定位奖励机制则更加独特,它评估AI在思考过程中关注的图像区域是否正确。就像检查学生在解几何题时是否正确标注了关键点和线段一样。这个机制不仅检查AI是否标注了正确数量的区域,还要验证这些区域的位置是否准确。具体来说,当AI标注的区域与标准答案的重叠度超过75%时,就会获得满分奖励,否则不得分。这种"全或无"的奖励方式虽然严格,但能够有效促使AI学会精确的视觉定位。

这两个奖励机制的结合使用产生了意想不到的协同效应。AI不仅要学会给出正确答案,还要学会关注正确的图像区域,更重要的是要学会将视觉观察与逻辑推理有机结合。这种多维度的约束迫使AI发展出更加系统化和专业化的思考方式。

研究团队采用的具体强化学习算法是群体相对策略优化(GRPO),这是一种相对简单但高效的方法。与传统的强化学习算法相比,GRPO不需要额外的评价网络,而是通过比较同一组候选答案的相对质量来指导学习。这就像让学生们互相比较作业质量,从而找出最佳的解题方式。

在训练过程中,AI会为每个问题生成多个候选答案,然后根据奖励机制对这些答案进行排序。表现最好的答案会得到正向激励,表现较差的答案则会受到负向反馈。通过这种相对比较的方式,AI逐渐学会了如何生成更好的思考过程和更准确的答案。

实验结果显示,经过强化学习训练的AI系统在各项指标上都有显著提升。不仅答案准确率提高了,视觉定位的精确度也大幅改善。更重要的是,生成的思考过程变得更加逻辑清晰,更符合真实医生的诊断习惯。

### 四、实验验证:用八分之一数据达到全量数据效果

为了验证新方法的有效性,研究团队设计了一系列严格的对比实验。这些实验就像是给不同的学习方法安排考试,看看哪种方法能够让学生在最短时间内取得最好的成绩。

实验的设置非常巧妙。研究团队从完整的GEMeX数据集中随机抽取了20万个样本作为训练数据,这只相当于原始数据集的八分之一。然后,他们比较了四种不同的训练方式:零样本学习(不进行任何训练)、使用完整数据集的传统训练、使用20万常规数据的训练,以及使用20万ThinkVG数据的新方法训练。

结果令人印象深刻。在不进行任何专门训练的情况下,AI系统在各类问题上的表现都相当有限,平均准确率只有44.14%。这就像让一个完全没有医学背景的人去读胸片,结果自然不会太理想。

当使用完整的159万样本进行传统训练后,系统性能有了显著提升,平均准确率达到84.31%。这证明了大规模数据训练的重要性,就像医学生需要看过足够多的病例才能积累经验一样。

令人惊喜的是,仅使用20万ThinkVG数据进行训练的系统,在经过监督学习后就达到了83.03%的准确率,已经非常接近使用全量数据的效果。而当进一步应用强化学习后,准确率提升到85.98%,实际上超过了使用全量数据的传统方法。

这个结果的意义远远超出了数字本身。它证明了"质量胜过数量"的原则在AI训练中同样适用。通过提供高质量的思考过程示例,AI能够更快地学会正确的推理方式,而不需要依赖海量的数据来弥补方法上的不足。

更详细的分析显示,新方法在不同类型的问题上都有稳定的表现。对于开放式问题,准确率从92.54%提升到96.44%。对于封闭式问题,从79.93%大幅提升到90.97%。单选题和多选题也都有3-5%的提升。这种全面的改进表明,新方法不是针对特定类型问题的技巧,而是一种通用的能力提升。

研究团队还测试了系统的鲁棒性,即面对输入变化时的稳定性。他们故意对测试问题进行一些修改,比如改变选择题的选项顺序,或者将肯定句改为否定句。结果显示,使用ThinkVG训练的系统表现出更好的稳定性,面对这些干扰时性能波动更小。这证明了系统确实学会了深层的理解,而不是简单的模式匹配。

视觉定位能力的提升同样显著。传统方法在定位准确度方面表现一般,而新方法在各类问题上都有明显改善。特别是在需要精确标注多个解剖区域的复杂问题上,改进效果更加明显。这表明AI不仅学会了看,还学会了看重点。

### 五、案例分析:AI医生的思考过程展示

为了更直观地展示新系统的能力,研究团队提供了几个典型的案例分析。这些案例就像是AI医生的"工作日记",详细记录了它在面对不同医学问题时的思考过程。

第一个案例是关于肺部状态的判断。当系统看到一张胸片并被问及"这张胸片中肺部的主要发现是什么"时,传统系统可能只会简单回答"肺部清晰",并给出一个大概的区域标注。而新系统的表现则完全不同。

新系统首先会系统性地检查双侧肺部区域,明确标注了具体的坐标范围。然后逐一排除各种可能的病理情况:它会说"如果是局灶性实变,应该看到密集的斑片状阴影,但这里的肺部显示均匀的充气状态,没有这样的发现";接着它会分析"胸腔积液通常表现为肋膈角变钝或新月征,但这里都没有看到";最后它会检查"气胸应该有胸膜线和外周透亮带,但影像中没有这些征象"。经过这样系统的分析后,它才得出"肺部清晰"的结论,并补充说明纵隔和心脏区域的正常表现进一步支持了这个判断。

第二个案例涉及更复杂的多项选择问题。当问及"这张胸片发现了哪些异常"时,系统需要从低肺容量、肺不张、胸腔积液和心脏扩大等选项中选择正确答案。新系统会详细分析每个可能的选项:对于低肺容量,它会检查肺野大小和膈肌位置;对于肺不张,它会寻找线状或楔形阴影;对于胸腔积液,它会观察肋膈角和胸腔下部;对于心脏扩大,它会估算心胸比例。通过这样全面的分析,它能够准确识别出真正存在的异常,避免遗漏或误判。

这些案例展示了新系统的几个重要特点。首先是系统性,它不会遗漏任何重要的解剖区域或可能的诊断选项。其次是逻辑性,每个推理步骤都有明确的依据,前后逻辑一致。第三是专业性,使用的医学术语和分析方法都符合临床标准。最重要的是教育性,整个思考过程对医学生和年轻医生都有很好的示范作用。

与传统系统相比,新系统的优势不仅在于准确率的提升,更在于可信度的增强。当医生看到如此详细和专业的分析过程时,更容易判断AI的结论是否可靠,也更容易发现潜在的错误或疏漏。这种透明性是AI系统获得医疗从业者信任的关键。

### 六、技术创新的深层意义:重新定义医学AI的工作方式

这项研究的意义远远超出了技术指标的改进,它实际上重新定义了医学AI应该如何工作。传统的医学AI更像是一个"神谕"——给出答案但不解释原因。而新系统则更像是一位经验丰富的临床教师,不仅能够做出准确诊断,还能详细解释诊断的每一个步骤。

从技术角度来看,这项研究实现了三个重要突破。第一个突破是数据集构建方法的创新。通过多智能体协作和不确定性驱动的质量控制,研究团队创建了一种可复制、可扩展的高质量医学推理数据生成方法。这种方法不仅适用于胸片分析,也可以扩展到其他医学影像领域。

第二个突破是训练方法的创新。将监督学习与强化学习相结合,通过双重奖励机制同时优化语义准确性和视觉定位能力,这种方法为医学AI的训练提供了新的范式。特别是视觉定位奖励的设计,解决了传统方法中推理过程与视觉证据脱节的问题。

第三个突破是效率的显著提升。用八分之一的数据达到甚至超过全量数据的效果,这不仅节省了计算资源,更重要的是证明了正确方法比数据规模更加重要。这为资源有限的医疗机构部署AI系统提供了可能。

从应用角度来看,这项研究为医学AI的临床应用开辟了新的可能性。首先,它可以作为医学教育工具,帮助医学生和住院医师学习影像诊断的系统思维。通过观察AI的完整分析过程,学习者可以掌握标准的诊断流程和专业的描述方法。

其次,它可以作为临床决策支持工具,为经验相对不足的医生提供诊断参考。当面对复杂或罕见病例时,医生可以参考AI的分析过程,确保不会遗漏重要的诊断线索。这种辅助不是简单的"告诉你答案",而是"教你如何思考"。

第三,它还可以用于医疗质量控制和审核。通过分析AI的推理过程,可以识别诊断中的常见错误模式,为质量改进提供数据支持。这种应用在远程医疗和基层医疗中尤其有价值。

更深层的意义在于,这项研究为AI系统的可解释性研究提供了新的思路。不同于传统的事后解释方法,这种"过程透明"的方法让AI的工作方式更加符合人类的认知习惯。这种理念不仅适用于医学领域,也可以推广到其他需要高度可信的AI应用场景。

同时,这项研究也为AI伦理和安全提供了技术支撑。当AI系统能够清楚解释自己的决策过程时,人类监督者更容易发现潜在的偏见或错误,从而及时纠正。这种透明性是构建负责任AI的重要基础。

### 七、未来展望:从胸片诊断到全面医学智能助手

虽然目前的研究主要集中在胸片分析上,但其潜在应用前景极为广阔。研究团队开发的方法和技术框架具有很强的通用性,可以相对容易地扩展到其他医学影像领域。

在放射学领域,这种方法可以应用于CT、MRI、超声等各种影像的分析。每种影像类型都有其特定的解剖结构和病理表现,但基本的分析思路是相通的:系统观察、逻辑推理、综合判断。通过调整数据集和奖励机制的具体设计,同样的技术框架可以训练出专门的CT阅片AI、MRI分析AI等。

更有趣的是,这种方法还可以扩展到多模态医学数据的综合分析。现代医学诊断往往需要结合影像、实验室检查、病史等多种信息。通过类似的"思考与定位"机制,AI可以学会如何系统地分析这些不同类型的数据,并解释它们之间的关联性。这将使AI从单纯的"影像分析工具"进化为真正的"临床思维助手"。

在医学教育方面,这种技术的应用前景同样令人兴奋。传统的医学教育主要依赖导师的个人经验和有限的病例资源。而AI教师可以提供无限的标准化教学案例,每个案例都有完整的分析过程和清晰的教学要点。更重要的是,AI教师可以根据学生的学习进度和薄弱环节,提供个性化的教学内容。

从技术发展趋势来看,这项研究代表了AI发展的一个重要方向:从追求性能到追求可解释性,从模仿结果到模仿过程。这种趋势不仅体现在医学AI领域,在自动驾驶、金融风控、法律分析等其他关键应用领域也越来越重要。

当然,这项研究也面临一些挑战和限制。首先是数据质量的依赖性。虽然多智能体协作提高了数据生成的可靠性,但仍然需要专业医生的最终验证。如何进一步提高自动化质量控制的准确性,减少人工干预的需求,是未来需要解决的问题。

其次是计算效率的优化。目前的方法虽然在数据效率上有显著提升,但强化学习的训练过程仍然比较复杂。如何简化训练流程,降低计算成本,是推广应用的关键因素。

第三是泛化能力的验证。目前的研究主要基于特定的数据集和影像类型。这种方法在面对不同医院、不同设备、不同人群的影像时是否仍然有效,需要更广泛的验证。

尽管存在这些挑战,这项研究无疑为医学AI的发展指明了一个重要方向。随着技术的不断完善和应用的逐步推广,我们有理由期待一个更加智能、更加可信的医疗AI时代的到来。在这个时代里,AI不再是冷冰冰的诊断机器,而是医生的智能助手和患者的可信伙伴。

说到底,这项研究最大的贡献可能不在于技术指标的提升,而在于它重新定义了AI在医疗中的角色。从"替代医生"到"辅助医生",从"给出答案"到"解释过程",这种理念上的转变或许比技术本身更加重要。它让我们看到了一种可能:AI不是要取代人类医生,而是要成为更好的人类医生培养器和决策支持者。

当AI能够像优秀的临床教师一样详细解释每一个诊断步骤时,医学知识的传承和传播将变得更加高效和标准化。当AI能够为每一个诊断决策提供清晰的视觉证据和逻辑推理时,医疗的安全性和可靠性将得到显著提升。这样的AI系统不仅是技术的进步,更是医疗人文关怀的体现——它让患者更容易理解自己的病情,让医生更容易做出准确的判断,让医学教育更容易培养出优秀的医生。或许,这就是我们真正需要的医学AI:不是替代人类智慧,而是放大和传播人类智慧。

Q&A

Q1:GEMeX-ThinkVG与传统医学AI有什么本质区别? A:传统医学AI就像"黑盒子",只能告诉你诊断结果但无法解释原因。而GEMeX-ThinkVG能够像真实医生一样详细解释诊断过程,包括观察了影像的哪些区域、基于什么特征得出什么结论,整个思考过程完全透明可验证。

Q2:这种AI系统会不会取代放射科医生? A:不会取代,反而会成为医生的智能助手。系统设计初衷是辅助医生提高诊断准确性和效率,特别是帮助经验不足的医生学习标准诊断流程。它更像是一位永不疲倦的临床教师,而不是医生的竞争者。

Q3:普通医院能否使用这种技术?需要什么条件? A:目前该技术主要面向研究机构,数据集已在HuggingFace平台公开。普通医院使用需要一定的技术基础和计算资源,但研究显示只需八分之一的训练数据就能达到良好效果,这大大降低了部署门槛。未来有望开发出更易部署的商业版本。

好文章,需要你的鼓励

-

深度学习也能像人一样"看重点"?揭秘视觉AI如何学会聪明地观察世界

这项研究提出了"高效探测"方法,解决了掩码图像建模AI难以有效评估的问题。通过创新的多查询交叉注意力机制,该方法在减少90%参数的同时实现10倍速度提升,在七个基准测试中均超越传统方法。研究还发现注意力质量与分类性能的强相关性,生成可解释的注意力图谱,展现出优异的跨域适应性。团队承诺开源全部代码,推动技术普及应用。

-

伊利诺伊大学新突破:让机器像法官一样剖析复杂争议,不再简单判"真假"

伊利诺伊大学研究团队开发了CLAIMSPECT系统,通过层次化分解复杂争议、智能检索相关文献、多角度收集观点的方法,将传统的"真假"判断转变为多维度分析。该系统能够自动构建争议话题的分析框架,识别不同观点及其支撑证据,为科学和政治争议提供更全面客观的分析,已在生物医学和国际关系领域验证有效性。

-

清华大学突破性发现:让AI像人类一样理解和表达情感的新方法

清华大学研究团队首次提出情感认知融合网络(ECFN),让AI能像人类一样理解和表达情感。该系统通过多层次情感处理架构,在情感识别准确率上比现有最佳系统提升32%,情感表达自然度提升45%。研究突破了传统AI情感理解的局限,实现了跨模态情感融合、动态情感追踪和个性化情感建模,为医疗、教育、客服等领域带来革命性应用前景。

-

哈佛大学揭秘:AI如何像人类一样通过"玩游戏"学会复杂推理

哈佛大学研究团队通过创新的多智能体强化学习方法,让AI在战略游戏中学会复杂推理。研究发现AI通过游戏竞争能发展出类人思维能力,在逻辑推理、创造性解决问题等方面表现显著提升。这项突破性成果为未来AI在医疗、教育、城市管理等领域的应用奠定基础,展现了通过模拟人类学习过程培养真正智能AI的新路径。