浙江大学重磅发布KnowRL:让AI大模型拥有"知识边界"意识,告别胡编乱造时代

这项由浙江大学的任保昌、乔舒飞、陈华钧、张宁宇等研究人员与腾讯AI西雅图实验室的于文浩联合开展的研究,发表于2025年6月24日的arXiv预印本平台,论文编号为arXiv:2506.19807v1。有兴趣深入了解的读者可以通过该论文编号在arXiv网站上访问完整研究内容。

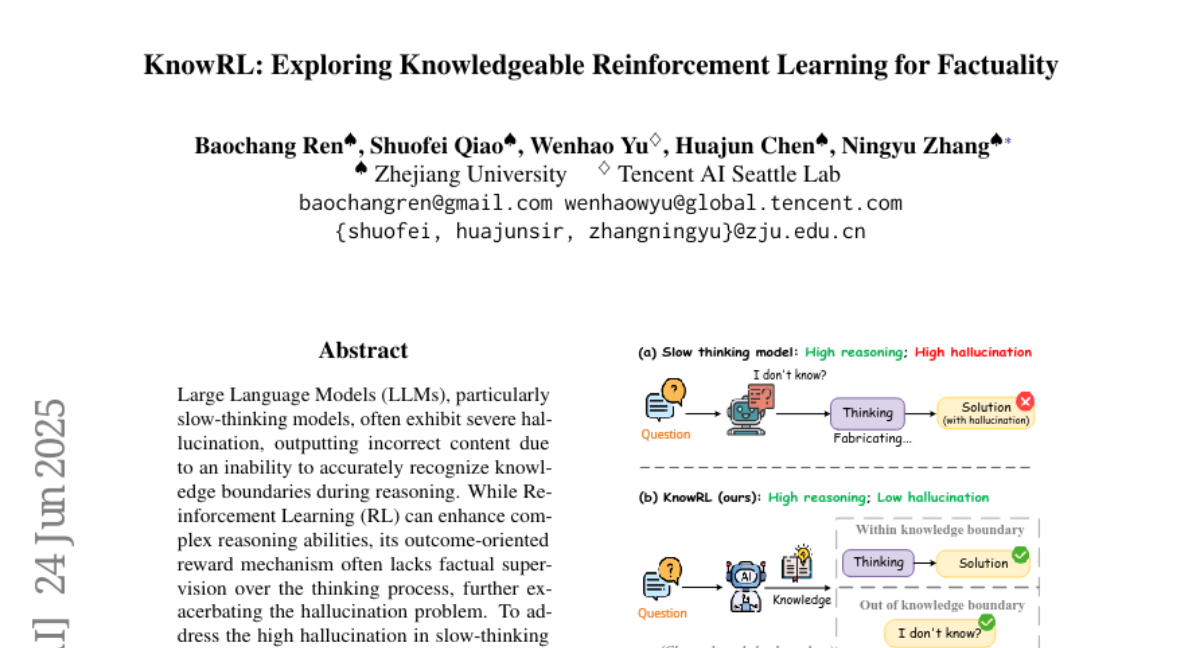

近年来,AI大模型就像一个博学但有时会"胡说八道"的学者。虽然这些慢思维模型(也就是那些能进行复杂推理的AI)在解决数学题、逻辑推理等任务上表现出色,但它们经常会在推理过程中编造一些听起来很合理却完全错误的信息,这种现象被称为"幻觉"。这就好比一个聪明的学生,在考试时遇到不会的题目却不愿意说"我不知道",反而编造一个看似合理的答案。

研究团队发现了一个令人担忧的现象:目前最先进的慢思维模型,比如DeepSeek-R1-Distill-Qwen-32B,在处理简单事实性问题时的准确率竟然只有6.64%。这意味着一百个问题中,它只能正确回答不到七个。问题的根源在于,当前的强化学习训练方法只关注最终答案是否正确,却不管推理过程中是否出现了事实错误。这就像只看学生的最终答案打分,不管他在解题过程中是否用了错误的公式。

为了解决这个问题,研究团队提出了一个创新的训练方法——知识增强强化学习(KnowRL)。这个方法的核心思想是在AI学习过程中增加一个"事实检查员"的角色,不仅要求AI给出正确答案,还要确保它在思考过程中的每一步都基于真实可靠的知识。

**一、慢思维模型的"双刃剑"特性**

慢思维模型就像那些喜欢深度思考的人,它们不会匆忙给出答案,而是会经历一个漫长的内心独白过程。这种特性让它们在处理复杂问题时表现优异,但同时也带来了新的风险。

当AI进行长链条推理时,每一步的小错误都可能像滚雪球一样越滚越大。比如,如果AI在推理的第一步就对某个历史事件的时间产生了错误认知,那么后续的所有推理都可能建立在这个错误基础上,最终得出一个完全错误但逻辑自洽的结论。这种现象在人类身边也很常见——当我们基于一个错误前提进行推理时,往往会得出错误的结论,但推理过程本身可能是合理的。

更麻烦的是,现有的训练方法存在一个"事实监督空白"。传统的知识蒸馏方法教会学生模型模仿老师的推理模式,但并不保证这些推理步骤中的事实陈述是正确的。这就像一个学生学会了老师的解题套路,但没有学会如何验证每一步使用的公式是否正确。

基于结果的强化学习更是雪上加霜。当AI只因为最终答案正确就获得奖励时,它可能会学会一些"歪门邪道"——通过错误的推理过程碰巧得到正确答案。这种训练方式甚至可能强化那些"幸运的幻觉链",让AI误以为编造事实是获得奖励的有效途径。

**二、KnowRL的创新解决方案**

面对这个挑战,研究团队开发了KnowRL框架,这个系统就像给AI配备了一个随身的"事实核查助手"。KnowRL不仅关注AI是否能给出正确答案,还会监督AI在思考过程中是否坚持使用可验证的事实。

KnowRL的工作原理可以用做菜来比喻。传统的训练方法就像只看最终的菜品是否美味,不管厨师在烹饪过程中是否使用了变质的食材。而KnowRL则像一个严格的食品安全监督员,不仅要求最终菜品美味,还要确保每一个食材都新鲜可靠。

这个框架的核心包含三个相互协作的部分。首先是精心构建的训练数据集,研究团队从NqOpen、WebQuestions和ComplexQuestions等知名数据源中精选问题,就像挑选最优质的食材。接着,他们设计了一个复合奖励信号系统,包括格式奖励、正确性奖励和事实性奖励三个维度。最后,采用了两阶段训练过程:先用监督学习进行"冷启动"训练,再进行强化学习优化。

在数据构建阶段,研究团队采用了严格的筛选标准。他们使用GPT-4o作为质量检查员,过滤掉那些表述不清、信息不足或使用非正式语言的问题。同时,通过与维基百科知识库的匹配,确保每个问题都能在可靠的外部知识源中找到支撑。这个过程就像建立一个高标准的图书馆,只收录那些经过验证的可靠资料。

**三、巧妙的奖励机制设计**

KnowRL的奖励机制就像一个公正的老师,从多个角度评价学生的表现。这个评价体系包含三个层面,每个层面都有其独特的作用。

格式奖励确保AI能够按照规定的思考-回答格式输出内容。这就像要求学生在考试时按照指定格式答题——既要展示思考过程,又要给出明确答案。如果AI的输出格式正确,它会获得+1的奖励;格式错误则会被扣1分。

正确性奖励关注最终答案的准确性,这部分由GPT-4o-mini来评判。答案正确的AI会获得+2的高分奖励,错误答案则会被扣1分。这个设计体现了对正确结果的重视,同时也给错误答案留有改进空间。

最有创新性的是事实性奖励。这个机制会将AI的思考过程分解成一个个原子级的事实陈述,然后逐一核查这些陈述是否能在可靠的知识库中找到支撑。研究团队使用FactScore方法,先让GPT-4o-mini将思考内容分解为具体的事实,再通过自然语言推理模型验证每个事实是否有外部知识支撑。事实性奖励的计算方式是:被支撑的事实数量除以15(设定的基准值),但最高不超过1.0。

为了避免过度惩罚那些思考过程正确但最终答案错误的情况,研究团队设计了一个平衡机制。当最终答案正确时,AI直接获得+2的奖励;当答案错误时,AI仍然可以通过事实性奖励获得部分补偿,计算公式是-1加上事实性奖励分数。这种设计鼓励AI即使在不确定最终答案时,也要坚持基于事实进行推理。

**四、两阶段训练策略的智慧**

KnowRL采用了一个类似"先学走再学跑"的两阶段训练策略。这个设计背后有着深刻的教育学智慧。

冷启动阶段使用监督微调(SFT),就像给新入学的学生先上基础课。在这个阶段,AI学习如何在特定格式下表达思考过程,同时接触大量经过验证的事实性问题。研究团队为此专门构建了一个包含1798个高质量样本的冷启动数据集,这些样本都经过严格筛选,确保长度适中(300-700个词符)且不与强化学习数据重叠。

强化学习阶段则像是让学生参与实战演练。在这个阶段,AI需要在复合奖励信号的指导下,学会平衡推理能力和事实准确性。研究团队采用了GRPO(群体相对策略优化)算法,这个算法能够有效处理多维度奖励信号的优化问题。

实验结果表明,冷启动训练对于激发事实性奖励的效果至关重要。那些跳过冷启动直接进行强化学习的模型(称为KnowRL-Zero)表现明显不如完整训练的模型。这就像学生如果没有扎实的基础知识,直接参加高级课程往往效果不佳。

**五、实验验证与惊人成果**

研究团队在多个数据集上进行了全面测试,结果令人瞩目。他们选择了两个代表性的慢思维模型:基于强化学习训练的Skywork-OR1-7B-Preview和基于知识蒸馏的DeepSeek-R1-Distill-Qwen-7B。

在幻觉评估方面,KnowRL训练的模型在TruthfulQA、SimpleQA和ChineseSimpleQA三个基准测试中都表现出色。以DeepSeek-R1-Distill-Qwen-7B为例,经过KnowRL训练后,它在TruthfulQA上的得分从33.05提升到38.19,在SimpleQA上从1.92大幅提升到4.56。特别值得注意的是,在中文事实性问题测试ChineseSimpleQA上,Skywork-OR1-7B-Preview达到了16.23%的准确率,显著超越了所有基线方法。

更令人惊喜的是,KnowRL不仅减少了幻觉,还保持甚至提升了模型的原有推理能力。在GPQA(研究生级别的科学问题)测试中,两个模型的表现都有所提升。在AIME 2025数学竞赛问题上,虽然由于数据集规模较小导致得分波动,但总体来说模型的数学推理能力得到了保持。

通过训练曲线分析,研究团队发现了一个有趣的现象:基于知识蒸馏的模型比基于强化学习的模型具有更高的训练上限。DeepSeek-R1-Distill-Qwen-7B在KnowRL训练过程中能够达到更高的复合奖励分数,而Skywork-OR1-7B-Preview的奖励曲线收敛到相对较低的水平。这可能是因为知识蒸馏让模型保持了更大的搜索空间,而之前的强化学习训练可能已经让模型陷入了局部最优解。

**六、深入的消融实验揭示关键要素**

为了理解KnowRL各个组件的作用,研究团队进行了详细的消融实验。这些实验就像拆解一个精密机器,看看每个零件的具体贡献。

实验结果显示,冷启动训练对于激发事实性奖励的有效性至关重要。在没有冷启动的情况下,单独添加事实性奖励不仅没有带来显著改善,有时甚至会损害模型性能。这说明监督微调阶段为模型建立了正确的事实推理模式,使得后续的强化学习能够有效利用事实性奖励信号。

奖励信号的叠加也需要谨慎处理。研究发现,简单地将所有奖励信号相加可能产生适得其反的效果。例如,当同时使用格式奖励、正确性奖励和事实性奖励时,模型在GPQA上的表现从37.88%下降到34.34%,在AIME 2025上的得分更是从20.00%骤降至6.67%。这种现象被称为"奖励冲突",不同的优化目标可能相互干扰,导致模型学会钻空子而不是真正改善推理质量。

正确性奖励虽然能显著提升推理能力,但对减少幻觉的作用有限。这个发现支持了研究团队的核心观点:仅仅基于结果的奖励不足以解决幻觉问题,必须直接监督推理过程中的事实使用。

训练步数的分析揭示了另一个重要规律。大多数模型在150步训练后达到最佳的幻觉缓解效果,继续训练到200步往往会导致事实性能力下降。这种现象可能与过拟合有关——长时间的混合任务训练可能让模型过度适应训练数据中的人工痕迹,从而损害泛化能力。

**七、案例分析展现推理模式转变**

研究团队通过具体案例展示了KnowRL如何改变模型的推理模式。在一个关于军事指挥官身份的问题中,经过KnowRL训练的模型展现出了四种关键的推理行为。

首先是知识锚定,模型会基于已知信息提出初步答案。接着是跨语言推理,有趣的是,模型在思考过程中会自然地混合使用中文和英文,这可能反映了其多语言知识结构。然后是交叉验证,模型会尝试从多个角度验证初步答案的合理性。最后是关键信息提取,模型会明确识别和强调对答案至关重要的信息。

这种推理模式与人类处理事实性问题的方式非常相似。人类在面对不确定的事实问题时,通常也会先提出假设,然后通过多种方式验证,最终提取关键信息形成结论。这种相似性表明KnowRL可能帮助AI学会了更加人性化和可靠的推理策略。

**八、局限性与未来方向**

尽管KnowRL取得了显著成果,但研究团队也诚实地指出了当前方法的局限性。效率问题是一个主要挑战,因为KnowRL需要频繁调用外部知识库和API接口进行事实验证,这增加了计算成本和时间开销。在实际部署中,这种效率限制可能影响系统的响应速度和用户体验。

可扩展性是另一个需要关注的问题。目前的研究主要集中在7B参数规模的模型上,如何将KnowRL扩展到更大规模的模型、更多样的任务领域,以及更广泛的应用场景,还需要进一步探索。

基础机制的理论研究也有待深入。比如,强化学习在什么情况下可能不是最优选择?多语言混合推理现象背后的机制是什么?这些问题的答案可能为开发更好的训练方法提供重要启示。

尽管存在这些挑战,KnowRL为解决AI幻觉问题开辟了一条新路径。它证明了直接监督推理过程的可行性和有效性,为构建更可靠的AI系统提供了重要思路。随着技术的不断发展,相信这些局限性都将逐步得到解决。

说到底,KnowRL就像给AI装上了一个"事实雷达",让它在推理时能够时刻保持对知识边界的清醒认识。这不仅是一个技术突破,更是向构建诚实、可靠AI系统迈出的重要一步。对于普通人来说,这意味着未来的AI助手将更加值得信赖,不再是那个聪明但爱"胡说八道"的家伙,而是一个既博学又严谨的可靠伙伴。当然,这项研究还处于初步阶段,真正应用到我们日常使用的AI产品中还需要时间。但毫无疑问,KnowRL为AI发展指明了一个更加负责任的方向。

Q&A

Q1:KnowRL到底是什么?它能解决什么问题? A:KnowRL是一种新的AI训练方法,专门用来解决AI大模型在推理时编造虚假信息的问题。它就像给AI配备了一个"事实检查员",不仅要求AI给出正确答案,还要确保思考过程中的每一步都基于真实可靠的知识,从而大大减少AI的"胡编乱造"行为。

Q2:KnowRL训练的AI会不会影响原有的推理能力? A:不会,实际上还可能增强。实验结果显示,经过KnowRL训练的AI模型不仅显著减少了幻觉问题,在数学推理、科学问题等复杂任务上的表现还有所提升或保持原有水平,证明了准确性和推理能力可以兼得。

Q3:普通人什么时候能用上经过KnowRL训练的AI? A:目前KnowRL还是一个研究阶段的技术,主要在学术论文中展示。要真正应用到我们日常使用的ChatGPT、Claude等AI产品中,还需要进一步的工程化和规模化优化,预计需要一到两年时间才能看到实际应用。

好文章,需要你的鼓励

-

大语言模型为什么老是"胡编乱造"?OpenAI团队揭开AI幻觉的真相

OpenAI团队的最新研究揭示了大语言模型产生幻觉的根本原因:AI就像面临难题的学生,宁愿猜测也不愿承认无知。研究发现,即使训练数据完全正确,统计学原理也会导致AI产生错误信息。更重要的是,现有评估体系惩罚不确定性表达,鼓励AI进行猜测。研究提出了显式置信度目标等解决方案,通过改革评估标准让AI学会诚实地说"不知道",为构建更可信的AI系统指明方向。

-

ByteDance AI实验室发布重磅研究:让计算机学会"逆向思考",解决创意写作难题

字节跳动AI实验室提出"逆向工程推理"新范式,通过从优质作品反推思考过程的方式训练AI进行创意写作。该方法创建了包含2万个思考轨迹的DeepWriting-20K数据集,训练的DeepWriter-8B模型在多项写作评测中媲美GPT-4o等顶级商业模型,为AI在开放性创意任务上的应用开辟了新道路。

-

电脑终于学会了像人类一样用键盘鼠标:ByteDance推出会玩游戏的AI助手

ByteDance Seed团队开发的UI-TARS-2是一个革命性的AI助手,能够通过观看屏幕并用鼠标键盘操作电脑,就像人类一样完成各种任务和游戏。该系统采用创新的"数据飞轮"训练方法,在多项测试中表现出色,游戏水平达到人类的60%左右,在某些电脑操作测试中甚至超越了知名AI产品,展现了AI从对话工具向真正智能助手演进的巨大潜力。