MIT实验室推出Radial Attention:让视频AI生成快如闪电的神奇技术

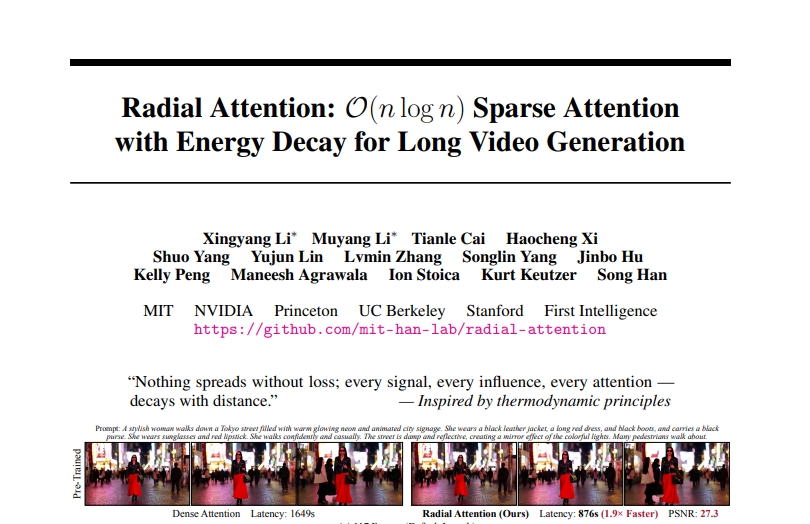

这项由MIT(麻省理工学院)、NVIDIA、普林斯顿大学、加州大学伯克利分校和斯坦福大学等多所顶尖院校联合开展的研究,发表于2025年6月的arXiv预印本平台(论文编号:arXiv:2506.19852v1)。感兴趣的读者可以通过https://github.com/mit-han-lab/radial-attention获取完整的研究代码和论文详情。这项研究的核心突破在于解决了AI视频生成中的一个关键难题:如何让计算机在生成长视频时既快又好。

想象一下,如果你正在用手机拍摄一段视频,手机需要同时处理每一个画面中的每一个像素点。现在AI生成视频面临的挑战就像这样:当视频变得越来越长时,计算机需要处理的信息量会呈爆炸性增长。就好比你原本只需要记住10个朋友的生日,现在突然要记住1000个人的生日,而且还要记住他们彼此之间的关系,这个任务就变得极其困难。

研究团队发现了一个非常有趣的现象,他们称之为"时空能量衰减"。这个概念听起来很学术,但其实很好理解。就像你在嘈杂的咖啡厅里和朋友聊天,坐得越近的人,你越能清楚地听到他们在说什么;距离越远,声音就越模糊。在AI视频生成中也是如此:视频中相邻的画面之间联系更紧密,而相距很远的画面之间的关系就相对较弱。

基于这个发现,研究团队开发了一种叫做"Radial Attention"(径向注意力)的新技术。这个名字可能听起来很复杂,但我们可以把它想象成一种智能的"注意力分配系统"。就像一个经验丰富的摄影师在拍摄时,会把主要精力集中在最重要的画面上,而不是试图同时关注所有细节。

这个径向注意力系统的工作原理非常巧妙。传统的AI视频生成方法就像一个强迫症患者,必须仔细检查视频中每一帧画面与其他所有画面的关系。这就好比你要写一篇文章,却坚持每写一个字都要回头检查与之前所有字的关系,这样效率自然很低。而径向注意力系统更像一个聪明的编辑,它知道哪些内容是真正重要的,应该重点关注,哪些内容可以适当忽略。

具体来说,这个系统采用了一种"指数衰减"的策略。想象你站在一个池塘边扔石头,石头激起的波纹会从中心向外扩散,越往外波纹越弱。径向注意力系统就是这样工作的:对于视频中的每一帧画面,它会重点关注时间上最接近的几帧,然后随着时间距离的增加,关注度会按照一定规律递减。这种方法既保证了重要信息不会丢失,又大大减少了不必要的计算。

研究团队通过大量实验证明了这种方法的有效性。他们使用了几个当前最先进的AI视频生成模型进行测试,包括HunyuanVideo、Wan2.1-14B和Mochi 1等。这些模型就像不同品牌的高端相机,各有特色但都代表了当前的技术水平。

实验结果令人印象深刻。在生成标准长度视频时,径向注意力技术能够将生成速度提升1.9倍,这意味着原本需要20分钟才能生成的视频,现在只需要大约10分钟就能完成。更令人惊喜的是,当生成4倍长度的视频时,这种技术的优势更加明显:训练成本降低了4.4倍,推理速度提升了3.7倍。

为了更好地理解这些数字的意义,我们可以这样比较:如果说传统方法生成一个长视频需要花费1000元的计算成本和10小时的时间,那么使用径向注意力技术只需要大约230元的成本和2.7小时的时间。这种改进对于实际应用来说意义重大,因为它让普通用户也有可能使用AI来生成高质量的长视频。

研究团队还解决了另一个重要问题:如何让已经训练好的AI模型适应更长的视频生成任务。传统上,如果你想让一个只能生成5秒视频的AI模型生成20秒的视频,就需要重新训练整个模型,这个过程既耗时又昂贵,就像为了学会做更大的蛋糕而重新学习整个烘焙技术。

为了解决这个问题,研究团队采用了一种叫做LoRA(低秩适应)的技术。这种技术就像是给现有的AI模型加装一个智能插件,而不需要重新构建整个系统。想象你有一台只能播放CD的音响,LoRA技术就像是给它连接一个蓝牙适配器,让它能够播放手机里的音乐,而不需要买一台全新的音响。

这种方法的巧妙之处在于,它只需要调整AI模型中的一小部分参数,就能让模型学会处理更长的视频。这就好比你要学习开更大的汽车,你不需要重新学习驾驶的所有基础知识,只需要适应新车的尺寸和操控感觉就可以了。

研究团队还发现,径向注意力技术与现有的各种AI模型插件完全兼容。这意味着如果你已经有一个能够生成特定风格视频的AI模型(比如动漫风格或者油画风格),你可以直接在上面应用径向注意力技术来生成更长的视频,而不会影响原有的风格特色。这就像是一个万能的加速器,可以安装在任何品牌的汽车上,让它们都跑得更快,但不会改变汽车本身的特色。

从技术实现的角度来看,径向注意力系统采用了一种静态的注意力掩码设计。这个概念听起来很技术化,但实际上可以理解为一张预先设计好的"关注地图"。就像你在看一场足球比赛时,摄像师会有一个预设的拍摄计划:什么时候关注球员,什么时候关注观众,什么时候给出全景镜头。径向注意力系统也有这样一张预设的"关注地图",告诉AI在处理视频时应该把注意力放在哪里。

这种静态设计的好处是效率很高,因为AI不需要在生成视频的过程中花时间去决定应该关注什么。这就像有一个经验丰富的导演提前制定好了拍摄计划,拍摄团队只需要按照计划执行就可以了,不需要临时做决定。

研究团队通过理论分析证明了他们方法的数学基础。他们发现,传统的注意力机制的计算复杂度是O(n?),这意味着当视频长度增加一倍时,计算量会增加四倍。而径向注意力技术的计算复杂度是O(n log n),这意味着计算量的增长速度要慢得多。用一个具体的例子来说明:如果视频长度从100帧增加到1000帧(增加10倍),传统方法的计算量会增加100倍,而径向注意力方法只增加大约33倍。

为了验证他们方法的准确性,研究团队还进行了误差分析。他们发现,径向注意力系统产生的误差会随着时空衰减参数的增大而指数级减少。简单来说,只要正确设置参数,这种方法产生的结果与传统方法几乎没有差别,但速度却快得多。

在实际测试中,研究团队使用了多个客观指标来评估视频质量,包括PSNR(峰值信噪比)、SSIM(结构相似性指数)和LPIPS(感知图像补丁相似性)等。这些指标就像是评判照片质量的不同标准:清晰度、色彩还原度、细节保留度等。测试结果显示,径向注意力技术在保持视频质量的同时显著提升了生成速度。

研究团队还与其他现有的加速技术进行了详细比较。他们发现,一些现有方法虽然也能提升速度,但往往会牺牲视频质量。有些方法只适用于特定类型的模型,而径向注意力技术具有更好的通用性。这就像比较不同的交通工具:自行车很快但只适合短距离,汽车适合中距离,飞机适合长距离,而径向注意力技术就像是一种能在各种距离都表现优秀的新型交通工具。

特别值得一提的是,研究团队还展示了他们方法在生成超长视频方面的能力。他们成功生成了长达21秒(509帧)的高质量视频,这在之前是很难实现的。要知道,在AI视频生成领域,能够生成5秒的连贯视频就已经很了不起了,而21秒的视频相当于提升了4倍的长度。

这种技术突破的意义不仅仅在于技术层面,更在于它可能带来的应用前景。随着生成视频长度的大幅增加和计算成本的显著降低,AI视频生成技术离实际应用又近了一大步。普通用户可能很快就能使用这种技术来创作自己的视频内容,而不需要专业的设备和技能。

研究团队还考虑了技术的环保影响。由于径向注意力技术大大减少了计算量,这意味着生成同样质量的视频需要消耗更少的电力,产生更少的碳排放。在当前越来越重视环保的背景下,这种技术改进具有重要的社会意义。

当然,这项技术也还有一些局限性。研究团队坦诚地指出,他们的方法基于时空能量呈指数衰减的假设,这个假设虽然在大多数情况下是合理的,但可能不适用于所有类型的视频内容。此外,虽然他们的方法在时间复杂度上有所改进,但对于空间复杂度(即图像分辨率)的处理仍然是二次的,这意味着在处理超高分辨率视频时仍可能遇到挑战。

展望未来,研究团队表示他们将继续改进这项技术,探索如何进一步提升效率和质量。他们也希望这项技术能够激发更多研究者投入到AI视频生成的优化工作中,共同推动这个领域的发展。

说到底,这项研究代表了AI视频生成技术发展的一个重要里程碑。它不仅解决了一个重要的技术难题,还为未来的应用开辟了新的可能性。随着这种技术的不断完善和普及,我们可能很快就会看到AI视频生成在教育、娱乐、营销等各个领域的广泛应用。对于普通用户来说,这意味着创作高质量视频内容的门槛将大大降低,每个人都可能成为自己故事的导演。当然,随着技术的进步,我们也需要思考如何负责任地使用这些强大的工具,确保它们能够真正造福社会。有兴趣深入了解技术细节的读者可以访问研究团队的GitHub页面或查阅完整的论文,那里有更详细的实验数据和实现细节。

Q&A

Q1:Radial Attention是什么?它有什么特别之处? A:Radial Attention是一种新的AI视频生成加速技术,它的特别之处在于能够智能地分配计算资源。就像聪明的摄影师会重点关注重要画面一样,它重点处理时间上相近的视频帧,对距离较远的帧采用递减的关注度,从而在保持视频质量的同时大幅提升生成速度。

Q2:这项技术能让AI视频生成快多少? A:根据实验结果,在生成标准长度视频时能提升1.9倍速度,生成4倍长度视频时能提升3.7倍速度,同时训练成本降低4.4倍。简单来说,原本需要10小时和1000元成本的任务,现在只需要2.7小时和230元左右。

Q3:普通人能使用这项技术吗?使用门槛高不高? A:这项技术主要面向AI研究者和开发者,普通用户无法直接使用。但随着技术的发展和应用,未来很可能会集成到各种视频生成应用中,让普通人也能受益于更快、更便宜的AI视频生成服务。研究代码已在GitHub开源,技术人员可以免费获取。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。