AI能否真正理解科学图表?耶鲁大学团队首次评估多模态模型的科学图表理解能力

科学研究中的图表就像是一张地图,能够帮助研究者快速理解复杂的研究框架。当你翻开一篇学术论文时,通常会先看那些精心设计的示意图——它们像是整个研究的"导航系统",让你在深入阅读之前就能把握研究的核心思路。但是,现在最先进的AI模型能否像人类专家一样准确解读这些科学图表呢?

这个问题的答案可能会让你感到意外。最近,耶鲁大学自然语言处理实验室的研究团队发表了一项突破性研究,他们构建了第一个专门评估AI模型科学图表理解能力的基准测试。这项研究由赵逸伦、王承烨、李楚寒和阿曼·科汉共同完成,发表于2025年7月的arXiv预印本平台。感兴趣的读者可以通过arXiv:2507.10787v1访问完整论文,相关数据和代码也已在GitHub上开源。

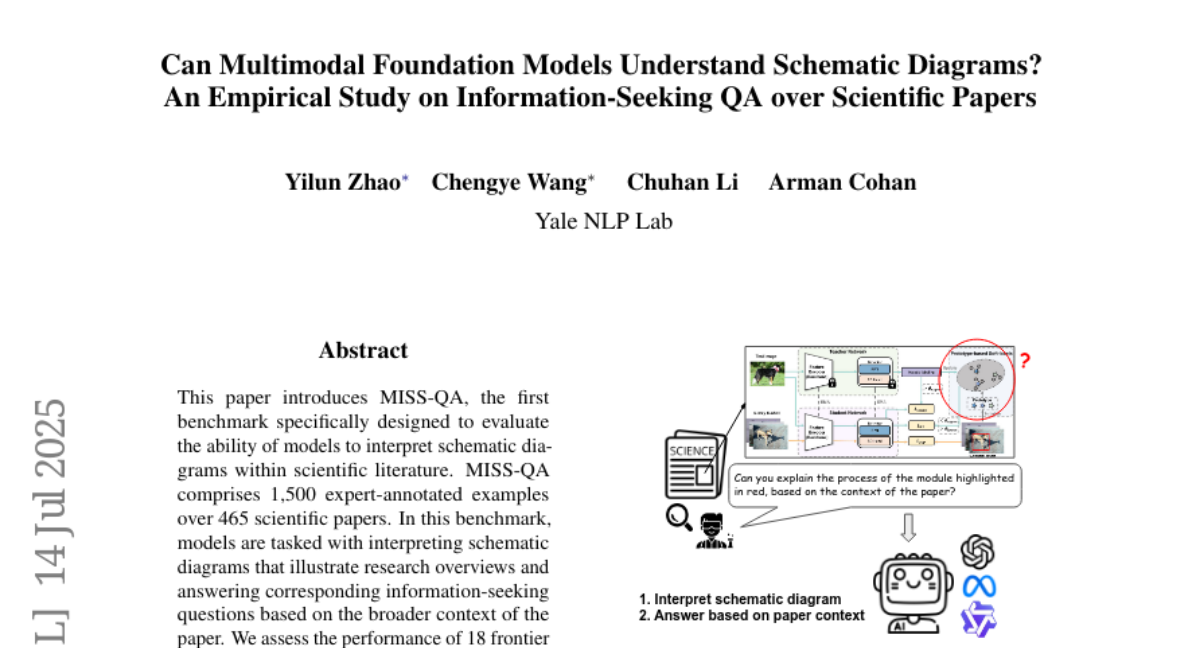

想象一下,你面对一幅复杂的科学研究框架图,需要回答关于其中某个特定模块功能的问题。这个过程需要你不仅能识别图中的视觉元素,还要理解它们之间的关系,并结合论文的具体内容给出准确答案。这正是研究团队设计的MISS-QA基准测试要评估的核心能力。

研究团队从近期发表的465篇AI相关论文中精心筛选出1500个专家标注的问答样本,涵盖了从设计理念到实验结果的各个方面。每个问题都像是一个小小的侦探任务:AI模型需要先理解图表中被彩色框标注的特定模块,然后在论文的海量文本中找到相关信息,最后给出准确的回答。

令人惊讶的是,即使是目前最先进的AI模型在这项任务上的表现也远不如人类专家。人类专家的准确率达到了89%,而表现最好的开源模型Qwen2.5-VL-72B仅达到61.6%。这就好比一个经验丰富的医生能够准确诊断复杂病症,而AI助手还在努力理解基础症状之间的关联。

**一、MISS-QA基准测试的创新设计**

传统的科学文献理解测试主要关注纯文本内容,就像只给学生看课本文字而不提供配图一样。但真实的科学研究中,图表往往承载着最核心的信息。研究团队意识到这个gap,决定专门针对科学图表理解能力进行评估。

MISS-QA的设计理念可以用一个生动的比喻来理解:如果把科学论文比作一本烹饪书,那么示意图就是菜谱的关键步骤图。仅仅阅读文字描述还不够,你需要能够理解图中每个步骤的具体操作,以及它们如何相互配合才能做出一道完整的菜。

研究团队招募了16位AI领域的专家作为标注者,他们每人都发表过至少3篇相关论文,确保了标注质量的专业性。这些专家需要完成一个复杂的三步标注过程:首先提出问题并在图表中标注相关区域,然后另一位专家验证问题质量并提供答案,最后第三位专家对整个样本进行质量检查。

为了确保AI模型确实需要理解图表而不是仅凭文字线索猜测答案,研究团队设计了一个巧妙的机制:每个问题都会用彩色边框标出图表中的关键区域,问题文本中只会提及"红色边框标注的模块"或"蓝色边框标注的模块",而不会直接说出模块名称。这就像是在地图上用不同颜色标注不同区域,然后询问这些区域之间的关系。

**二、五类信息寻求场景的深入探索**

研究团队通过初步调研发现,科学研究者在阅读论文时通常会关注五个核心方面的问题。这些问题类型就像是不同的"探索镜头",每个都有其独特的关注重点。

设计理念类问题关注的是"为什么要这样设计"。就像询问建筑师为什么要在房子的某个位置设计一个特殊结构一样,这类问题要求AI模型理解研究者的设计动机和逻辑。比如,为什么要在神经网络的特定位置加入注意力机制?这种设计选择背后的理论依据是什么?

实现细节类问题则更像是询问"具体怎么做"。如果说设计理念回答的是"为什么",那么实现细节就是"怎么做"。这类问题要求AI模型能够理解不同模块之间的具体交互方式和技术实现路径。比如,两个神经网络模块之间是如何传递信息的?数据在处理过程中经历了哪些具体的转换步骤?

文献背景类问题探讨的是"基于什么已有工作"。科学研究很少是凭空产生的,每个新方法都有其理论基础和技术传承。这类问题要求AI模型能够识别出特定模块与已有研究成果之间的关联。比如,当前使用的某个技术模块是基于哪个经典算法改进而来的?

实验结果类问题关注的是"效果如何"。研究者提出新方法后,需要通过实验验证其有效性。这类问题要求AI模型能够将图表中的技术组件与实验结果联系起来,理解不同模块对整体性能的贡献。比如,某个特定的优化模块在实验中带来了多大的性能提升?

其他类问题则涵盖了局限性、替代方案、伦理考量等方面。这类问题通常更加开放,要求AI模型具备更全面的理解能力和批判性思维。

**三、挑战性的无答案问题设计**

MISS-QA的一个独特之处在于,26.5%的问题被设计为无答案问题。这种设计反映了真实研究场景中的一个重要现实:并不是所有问题都能在现有信息基础上得到答案。

这就像是在侦探小说中,有些线索指向的方向可能是死胡同。一个优秀的侦探需要能够识别出哪些线索是有效的,哪些是无效的,而不是强行给出一个没有根据的结论。同样,一个理想的AI助手也应该能够诚实地说"我不知道",而不是编造一个听起来合理但实际上错误的答案。

研究团队发现,大多数AI模型在面对无答案问题时都表现出过度自信的倾向。它们往往会试图给出一个答案,即使这个答案并没有充分的支撑证据。这种行为模式在科学研究中是相当危险的,因为它可能导致错误信息的传播和研究方向的偏离。

有趣的是,人类专家在处理无答案问题时显示出更好的判断力。他们能够更准确地识别出哪些问题无法基于现有信息回答,这种能力对于科学研究的严谨性至关重要。

**四、18个前沿模型的全面评估**

研究团队选择了18个目前最先进的多模态AI模型进行测试,这些模型就像是不同技能水平的"学生",需要接受同样的考试。测试结果揭示了当前AI技术在科学图表理解方面的真实水平。

在专有模型中,OpenAI的o4-mini表现最佳,达到78.3%的准确率。这个结果虽然在AI模型中算是优秀的,但与人类专家的89%相比仍有不小差距。GPT-4.1紧随其后,达到77.8%的准确率。有趣的是,Gemini-2.5-Flash虽然在整体准确率上略逊一筹,但在处理无答案问题方面表现出色,这表明不同模型在不同任务上可能有各自的优势。

开源模型的表现同样令人关注。Qwen2.5-VL-72B以61.6%的准确率领跑开源模型,这个成绩虽然不及专有模型,但相比其前一代版本Qwen2-VL-72B的54.2%已有显著提升。InternVL3-38B达到60.4%的准确率,也展现了开源模型的进步潜力。

这些结果反映了一个有趣的现象:AI模型在不同类型的问题上表现差异很大。在相对简单的设计理念问题上,最好的模型能达到80%以上的准确率,但在需要深入理解技术细节的实现问题上,准确率会明显下降。这就像是学生在不同科目上的表现可能有很大差异一样。

**五、深入的错误分析:AI模型的五大弱点**

通过对100个错误案例的详细分析,研究团队发现了AI模型在科学图表理解方面的五个主要问题,这些问题就像是阻碍AI进步的"绊脚石"。

第一个问题是无法准确解读图表结构。这就像是一个人看地图时无法分辨哪里是道路,哪里是建筑物。AI模型经常无法正确识别图表中被标注的关键区域,或者无法理解这些区域在整个研究框架中的作用。比如,当问题询问某个用红色框标注的模块时,模型可能无法准确定位这个模块,或者误解了它的功能。

第二个问题是信息检索能力不足。即使AI模型能够理解图表,它们也经常无法在论文的大量文本中找到相关信息。这就像是在图书馆里找书时,虽然知道要找什么,但不知道该去哪个书架。模型可能会找到一些相关信息,但往往不是最准确或最完整的答案。

第三个问题是推理错误。有时候,AI模型能够找到正确的信息,但在综合分析时出现逻辑错误。这就像是拥有了所有拼图块,但无法正确组装成完整图案。模型可能会对技术细节产生误解,或者无法准确理解不同组件之间的相互作用。

第四个问题是对无答案问题的过度自信。当面对无法回答的问题时,AI模型往往不愿意承认"不知道",而是会编造一个听起来合理的答案。这种行为在科学研究中是相当危险的,因为它可能误导研究者。

第五个问题是过度依赖视觉信息。有些AI模型过分关注图表本身,而忽视了论文文本中的重要信息。这就像是只看菜谱的图片而不读具体的制作说明,结果自然会出现偏差。

**六、研究意义与未来展望**

这项研究的意义远不止于发现AI模型的不足。它为我们理解AI在科学研究中的潜力和局限提供了重要参考。当前,越来越多的研究者开始依赖AI助手来处理科学文献,理解这些工具的真实能力边界变得至关重要。

研究结果表明,虽然AI模型在某些方面已经表现出色,但在需要深度理解和复杂推理的任务上仍有很大提升空间。这就像是一个有潜力的学生,在基础知识方面已经不错,但在综合应用和创新思维方面还需要更多训练。

从技术发展的角度看,这项研究指出了几个重要的改进方向。首先,AI模型需要更好的视觉理解能力,能够准确解读复杂的科学图表。其次,模型需要更强的信息整合能力,能够将视觉信息与文本信息有效结合。最后,模型需要更好的自我认知能力,能够准确判断自己是否有足够信息来回答问题。

对于科学研究界来说,这项研究提醒我们在使用AI助手时需要保持适度的谨慎。AI可以成为很好的工具,但不应该完全替代人类的判断和思考。特别是在处理复杂的科学问题时,人类专家的经验和直觉仍然是不可替代的。

**七、开源数据集的价值**

MISS-QA作为开源数据集,为整个AI研究界提供了宝贵的资源。这就像是为所有研究者提供了一个标准化的"考试题库",让不同团队可以在相同基准上比较和改进他们的模型。

数据集的构建过程本身就是一个重要贡献。研究团队不仅提供了问答样本,还详细记录了标注过程、质量控制措施和评估方法。这些信息对于其他研究者理解数据集的特点和局限性非常重要。

更重要的是,这个数据集反映了真实科学研究中的信息需求。与许多人工构造的数据集不同,MISS-QA中的问题都来自于研究者在阅读科学论文时真正关心的内容。这使得在这个数据集上的改进更可能转化为实际应用中的进步。

研究团队还提供了详细的评估工具和基准测试结果,这为后续研究提供了重要参考。其他研究者可以基于这些基准来评估自己的模型改进是否有效,从而推动整个领域的进步。

说到底,这项研究就像是给AI的科学理解能力做了一次全面体检。结果显示,虽然AI在某些方面已经表现不错,但要真正理解科学图表并准确回答相关问题,还有很长的路要走。这并不意味着AI技术没有价值,而是提醒我们需要更清楚地认识其能力边界。

对于普通人来说,这项研究的启示是:当我们使用AI助手处理复杂信息时,保持适度的质疑和验证是明智的。AI可以成为很好的起点,但重要决策仍然需要人类的判断和专业知识。

随着技术的不断发展,我们有理由相信AI在科学图表理解方面会有显著改进。但就目前而言,人类专家在处理复杂科学问题时的优势仍然明显。这项研究为未来的改进指明了方向,也为合理使用AI工具提供了重要参考。

Q&A

Q1:MISS-QA是什么?它主要评估AI的什么能力? A:MISS-QA是耶鲁大学团队开发的首个科学图表理解评估基准,专门测试AI模型能否像人类专家一样准确理解科学论文中的示意图,并基于图表和论文内容回答相关问题。它包含1500个专家标注的问答样本,涵盖465篇AI论文。

Q2:目前最先进的AI模型在科学图表理解方面表现如何? A:表现远不如人类专家。人类专家准确率达89%,而最好的AI模型OpenAI o4-mini仅达78.3%,开源模型中最好的Qwen2.5-VL-72B只有61.6%。AI模型在理解图表结构、整合信息和处理无答案问题方面都存在明显不足。

Q3:这项研究对我们使用AI助手有什么启示? A:提醒我们在使用AI处理复杂科学信息时需要保持谨慎。AI可以作为很好的辅助工具,但在涉及重要决策时,仍需要人类专家的判断和验证。特别是在科学研究中,不应完全依赖AI的分析结果。

好文章,需要你的鼓励

-

浙江大学突破:让AI专家团队在考试时"动态组队",推理能力飙升

浙江大学团队提出动态专家搜索方法,让AI能根据不同问题灵活调整内部专家配置。该方法在数学、编程等任务上显著提升推理准确率,且不增加计算成本。研究发现不同类型问题偏爱不同专家配置,为AI推理优化开辟新路径。

-

清华大学新突破:AI模型居然能学会"少说话多做事",推理效率提升一倍还更准确

清华大学研究团队提出SIRI方法,通过"压缩-扩张"交替训练策略,成功解决了大型推理模型"话多且准确率低"的问题。实验显示,该方法在数学竞赛题上将模型准确率提升43.2%的同时,输出长度减少46.9%,真正实现了效率与性能的双重优化,为AI模型训练提供了新思路。

-

南洋理工大学突破性研究:用AI实现多分钟视频实时流式生成,就像看电视直播一样

南洋理工大学与腾讯联合研究团队开发出Rolling Forcing技术,实现AI视频实时流式生成的重大突破。该技术通过滚动窗口联合去噪、注意力锚点机制和高效训练算法三项创新,解决了长视频生成中的错误累积问题,可在单GPU上以16fps速度生成多分钟高质量视频,延迟仅0.76秒,质量漂移指标从传统方法的1.66降至0.01,为交互式媒体和内容创作开辟新可能。

-

华中科技大学团队突破性发现:让AI像几何学家一样思考,竟能大幅提升空间理解能力

华中科技大学研究团队发现,通过让AI模型学习解决几何问题,能够显著提升其空间理解能力。他们构建了包含约30000个几何题目的Euclid30K数据集,使用强化学习方法训练多个AI模型。实验结果显示,几何训练在四个空间智能测试基准上都带来显著提升,其中最佳模型达到49.6%准确率,超越此前最好成绩。这项研究揭示了基础几何知识对培养AI空间智能的重要价值。