博洛尼亚大学AI团队巧用情感分析,让AI更精准识别新闻中的主观表达

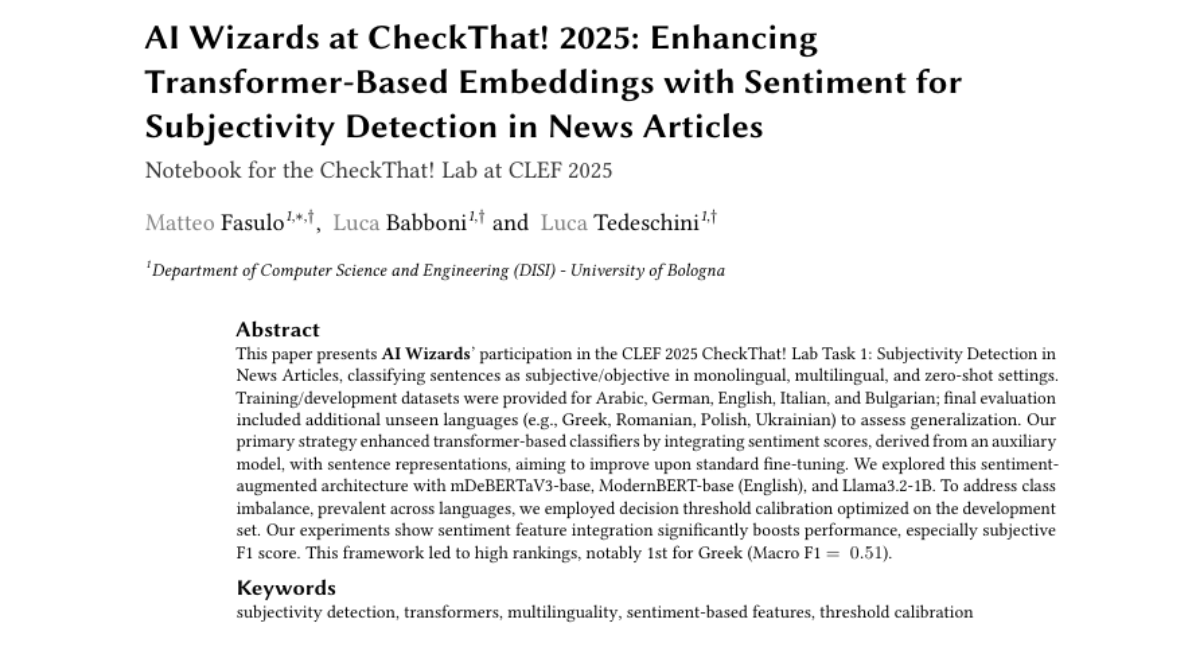

这项由博洛尼亚大学计算机科学与工程系的Matteo Fasulo、Luca Babboni和Luca Tedeschini团队完成的研究,发表于2025年CLEF CheckThat!实验室会议。该研究专注于开发一种能够准确识别新闻文章中主观性表达的AI系统。有兴趣深入了解的读者可以通过CLEF 2025 Working Notes获取完整论文。

当我们阅读新闻时,经常会遇到这样的困扰:哪些是客观事实,哪些是记者的主观观点?在信息爆炸的时代,能够准确区分新闻中的客观陈述和主观表达变得越来越重要。就像品酒师能够准确识别葡萄酒中的不同风味一样,AI系统也需要学会识别文本中的"主观味道"。

博洛尼亚大学的研究团队就像训练一位敏锐的文本品鉴师,他们开发了一套创新的方法来提升AI识别新闻文章中主观性表达的能力。这项研究的背景源于当今社会对抗虚假信息和改进事实核查的迫切需求。正如厨师需要区分食材的新鲜程度一样,事实核查系统需要能够准确区分客观事实和主观观点。

研究团队面临的挑战就像让一个从未品尝过不同菜系的人学会分辨川菜和粤菜的区别。他们需要让AI系统学会在没有完整文章语境的情况下,仅通过单个句子就判断其主观性。更复杂的是,这种判断需要跨越多种语言进行,包括阿拉伯语、保加利亚语、英语、德语和意大利语。

团队的核心创新在于将情感分析融入到传统的文本分类模型中。这就像给品酒师不仅提供视觉和嗅觉信息,还额外提供温度和湿度数据一样。他们发现,通过分析句子的情感倾向,可以显著提升AI识别主观性的准确度。

在实际应用中,这种技术可以帮助新闻聚合网站自动标记哪些内容是事实报道,哪些是评论观点。对于社交媒体平台来说,这项技术可以帮助用户更好地理解信息的性质,从而做出更明智的判断。

一、研究背景:为什么需要识别新闻中的主观性

在当今信息时代,新闻媒体扮演着信息传播的重要角色,但并非所有新闻内容都是纯粹的客观事实。记者在报道时往往会融入个人观点、情感倾向或分析评论,这些主观性表达与客观事实陈述混杂在一起,给读者的理解和判断带来挑战。

主观性检测就像训练一位敏锐的文本侦探,能够在句子中发现隐藏的观点线索。传统的主观性检测方法就像用放大镜逐字分析,主要依赖词典资源和规则系统。例如,早期的系统会查找"我认为"、"显然"、"令人震惊"等明显的主观性词汇。然而,这种方法就像只看表面症状的医生,无法处理语言的复杂性和多样性。

语言表达的主观性往往更加微妙和复杂。同样的事实,用不同的表达方式就可能带有不同的主观色彩。比如"政府宣布新政策"是客观陈述,而"政府终于宣布了这项期待已久的政策"就带有明显的主观倾向。这种差异对于传统的基于词典的方法来说极难捕捉。

随着深度学习技术的发展,基于BERT等变换器模型的方法开始展现出强大的能力。这些模型就像拥有丰富经验的老编辑,能够理解语言的深层含义和上下文关系。然而,在多语言环境下,这些模型仍然面临着巨大挑战。不同语言的主观性表达方式差异巨大,阿拉伯语中的委婉表达在英语中可能显得过于直接,而德语的严谨表达在意大利语中可能显得过于冷漠。

研究团队观察到,主观性检测与情感分析之间存在着天然的关联。就像品酒师通过酒的香气来判断年份和产地一样,句子的情感倾向往往能够揭示其主观性特征。带有强烈情感色彩的句子更可能是主观性的,而中性的情感表达往往对应客观陈述。

这种关联性为研究团队提供了灵感。他们意识到,如果能够将情感分析的结果作为额外的特征融入到主观性检测模型中,就可能显著提升检测的准确性。这就像给侦探提供了一个新的破案工具,通过分析犯罪现场的氛围来推断案件的性质。

二、核心创新:情感增强的文本分类方法

研究团队的核心创新就像给传统的文本分类器安装了一个"情感雷达"。传统的方法只是让AI阅读句子内容,而他们的方法还让AI感受句子的情感氛围。这种双重感知能力大大提升了AI判断句子主观性的准确度。

具体来说,他们的系统工作流程就像一个两步骤的分析过程。首先,每个输入的句子都会被送入一个专门的情感分析模型,这个模型就像一个情感温度计,能够测量出句子的积极、中性和消极情感的强度。他们选择了twitter-xlm-roberta-base-sentiment模型,这个模型虽然是在Twitter数据上训练的,但具有强大的多语言处理能力。

得到情感分析结果后,系统会将这三个情感分数与原始句子的文本表示进行融合。这个过程就像调鸡尾酒,将不同的成分按照特定比例混合,创造出全新的味道。在技术层面,这种融合是通过将情感分数与BERT模型输出的[CLS]标记表示进行连接实现的。

这种设计的巧妙之处在于,它让AI不仅能够理解句子说了什么,还能感受到句子是怎么说的。就像人类在判断一个人是否在开玩笑时,不仅听其言,还观其色一样。当AI发现一个句子带有强烈的消极情感时,它就更倾向于将其判断为主观性的。

研究团队在多个变换器模型上验证了这种方法的有效性。他们选择了mDeBERTaV3-base作为主要的基础模型,这个模型就像一个博学的多语言学者,能够处理多种不同的语言。同时,他们还测试了ModernBERT-base和Llama3.2-1B,以验证方法的普适性。

值得注意的是,研究团队还尝试了一种创新的数据预处理方法。针对阿拉伯语这种在实验中表现相对困难的语言,他们尝试将阿拉伯语文本先翻译成英语,然后再进行处理。这种方法就像给不同语言的文本穿上统一的"外衣",让AI更容易理解。然而,实验结果表明,这种预处理方法并没有带来预期的改善,反而略微降低了性能。

这个结果揭示了机器翻译在处理细微语言差异时的局限性。翻译过程中往往会丢失一些文化特定的表达方式和语言细节,而这些细节对于主观性判断来说可能是至关重要的。就像将一首诗翻译成另一种语言后,虽然意思大致相同,但韵律和意境往往会发生变化。

三、应对数据不平衡的策略

在实际的新闻数据中,研究团队遇到了一个像跷跷板失衡一样的问题:客观句子的数量远远超过主观句子。这种数据不平衡就像一个班级里有30个内向学生和5个外向学生,如果不加以处理,AI很容易形成"大部分句子都是客观的"这样的偏见。

研究团队通过详细分析发现,这种不平衡在所有语言中都存在,但程度不同。意大利语和阿拉伯语的数据集中,客观句子与主观句子的比例最为悬殊。这种不平衡如果不加处理,就像让一个从未见过雨天的人去预测天气,很可能总是预测晴天。

为了解决这个问题,研究团队采用了一种名为"决策阈值校准"的后处理技术。这种方法就像调节天平的平衡点,通过改变分类的判断标准来补偿数据不平衡的影响。具体来说,他们不再使用传统的0.5作为分类阈值,而是在开发集上通过网格搜索找到最优的阈值。

这个过程就像调节相机的曝光参数。摄影师在不同的光照条件下需要调节不同的曝光设置,才能拍出最佳效果。同样地,面对不同程度的数据不平衡,AI系统也需要调节不同的分类阈值才能达到最佳性能。

研究团队通过在0.1到0.9的范围内,以0.01为步长进行搜索,找到了能够最大化宏平均F1分数的最优阈值。这种方法的优势在于,它不需要改变模型的训练过程,只需要在最后的预测阶段进行调整,就像给眼镜换一副新镜片一样简单有效。

实验结果证明了这种方法的有效性。对于数据不平衡严重的语言,如阿拉伯语和意大利语,阈值校准带来了显著的性能提升。阿拉伯语的主观类F1分数从0.4184提升到0.5598,这相当于将识别准确率提高了约33%。意大利语的改善虽然相对较小,但也实现了从0.6237到0.6291的提升。

有趣的是,对于数据相对平衡的语言,如保加利亚语和德语,阈值校准的效果相对有限。这说明这种方法确实是在针对性地解决数据不平衡问题,而不是简单地提升所有情况下的性能。

除了阈值校准外,研究团队还探索了其他处理数据不平衡的方法。他们尝试了焦点损失函数(Focal Loss),这是一种专门设计用于处理不平衡数据的损失函数。然而,实验结果表明,焦点损失的效果与使用类别权重的交叉熵损失相似,并没有带来额外的优势。

这个发现提醒我们,在机器学习中,复杂的方法并不总是更好的选择。有时候,简单而直接的后处理方法可能比复杂的算法修改更加有效。就像烹饪中,有时候简单的调味比复杂的烹饪技巧更能提升菜品的味道。

四、多语言实验结果与分析

研究团队的实验就像在不同的语言花园中培育同一种植物,每种语言都呈现出不同的生长特点和挑战。他们设计了三种不同的实验设置:单语言任务、多语言任务和零样本任务,每种设置都像不同的园艺试验,检验AI系统在各种条件下的表现。

在单语言任务中,AI系统就像专门学习一种语言的学生,在每种语言上单独进行训练和测试。实验结果显示,情感增强的方法在大多数语言上都取得了显著的改善。以英语为例,使用情感特征后,主观类F1分数从0.4843跃升至0.5279,这相当于识别准确率提高了约9%。意大利语的改善更加明显,主观类F1分数从0.6291提升到0.6804,提升幅度达到8%。

这种改善就像给侦探提供了一个新的线索来源。当AI系统发现一个句子带有强烈的消极情感时,比如"这项政策简直是灾难性的",它就更倾向于将其判断为主观性的。相反,情感中性的句子,如"政府宣布了新的税收政策",则更可能被判断为客观陈述。

德语和保加利亚语的表现也相当不错,情感增强方法分别将其主观类F1分数提升了约1-2%。这种跨语言的一致性改善说明,情感与主观性之间的关联是一种普遍的语言现象,不局限于特定的语言或文化。

然而,阿拉伯语的表现成为了一个特殊的案例。虽然情感增强方法在阿拉伯语上也有所改善,但整体性能仍然相对较低。这种情况就像某种植物在特定的土壤条件下生长困难一样,阿拉伯语在当前的模型架构下表现出了独特的挑战。

为了理解这种差异,研究团队进行了深入的分析。他们发现,不同语言的情感分布模式存在显著差异。在英语中,主观句子往往表现出更强的负面情感倾向,这与新闻中的批评性观点和评论性表达相关。然而,在阿拉伯语中,这种模式并不明显,甚至在某些情况下出现了相反的趋势。

这种差异可能源于几个因素。首先,用于情感分析的模型是在Twitter数据上训练的,可能与新闻文本的语言风格存在差异。其次,不同文化背景下的情感表达方式不同,阿拉伯语新闻中的主观性表达可能采用了更加委婉或间接的方式。

在多语言任务中,研究团队将所有语言的数据混合在一起进行训练,这就像让AI学习成为一个多语言专家。结果显示,当包含所有语言时,模型的宏平均F1分数达到0.6942,主观类F1分数为0.6114。有趣的是,当将阿拉伯语从训练和测试中排除后,性能显著提升至宏平均F1分数0.7817,主观类F1分数0.6887。

这个结果就像发现团队中某个成员拖了后腿一样,阿拉伯语的加入似乎对整体性能产生了负面影响。这进一步证实了阿拉伯语在当前框架下的特殊挑战性。当加入情感增强功能后,排除阿拉伯语的多语言模型达到了最佳性能:宏平均F1分数0.7962,主观类F1分数0.7114。

零样本任务是最具挑战性的设置,就像让学生在没有复习特定科目的情况下参加考试。在这种设置下,模型需要在某些语言上训练,然后在完全未见过的语言上进行测试。实验结果显示,这种跨语言迁移的效果很大程度上取决于训练语言的选择和多样性。

当使用阿拉伯语、保加利亚语和德语作为训练语言时,模型在其他语言上的表现相对较好,宏平均F1分数达到0.7395。这种组合提供了足够的语言多样性,帮助模型学习到更加通用的主观性识别模式。

五、深入分析:情感特征的作用机制

为了深入理解情感增强方法的工作原理,研究团队进行了详细的分析,这个过程就像解剖一个精密的机械装置,要弄清楚每个零件是如何协同工作的。

他们发现,情感增强模型能够正确识别而基础模型错误分类的主观句子,往往具有更强的负面情感特征。这些句子的负面情感分数平均为0.51,远高于正面情感分数0.23和中性情感分数0.24。这种模式就像发现了一个隐藏的密码,负面情感成为了识别主观性的重要线索。

一个典型的例子是:"But then Trump came to power and sidelined the defense hawks, ushering in a dramatic shift in Republican sentiment toward America's allies and adversaries."这个句子的情感分析结果显示:正面情感0.109,中性情感0.035,负面情感0.856。强烈的负面情感帮助模型正确识别了这个句子的主观性质。

另一个例子是:"Boxing Day ambush & flagship attack Putin has long tried to downplay the true losses his army has faced in the Black Sea."这个句子的负面情感分数高达0.930,这种极端的情感倾向成为了主观性识别的强烈信号。

这种发现揭示了新闻写作中的一个有趣现象:主观性表达往往伴随着更强的情感色彩,特别是负面情感。这可能是因为新闻中的评论性内容经常涉及批评、质疑或担忧,这些情感自然会体现在语言表达中。

然而,研究团队也注意到,这种模式在不同语言中的表现并不完全一致。通过对比英语和阿拉伯语的情感分布图,他们发现了显著的差异。在英语中,主观句子确实表现出更强的负面情感倾向,这种模式清晰而一致。但在阿拉伯语中,这种模式变得模糊不清,甚至在某些情况下出现了相反的趋势。

这种差异可能解释了为什么情感增强方法在不同语言上的效果不同。当情感模式与主观性存在强相关时,额外的情感信息能够显著提升识别准确性。但当这种相关性较弱或不一致时,情感信息的作用就会减弱。

研究团队还分析了情感增强模型错误分类而基础模型正确分类的情况。在这些情况下,句子的情感分布相对更加均衡,负面情感分数降至0.32,而正面和中性情感分数则有所上升。这说明,当情感信息与主观性判断不一致时,额外的情感特征可能会误导模型做出错误的判断。

这种分析就像医生诊断疾病时不仅要看症状,还要考虑患者的整体健康状况。单一的情感信息虽然有用,但也可能在某些情况下产生误导。这提醒我们,在机器学习中,特征工程需要考虑特征之间的相互作用和适用条件。

六、挑战与限制

尽管研究取得了显著成果,但团队也坦诚地分析了研究的局限性,这种学术诚实就像一位经验丰富的工匠承认自己作品中的不完美之处。

首先,情感特征的来源存在一定的局限性。研究团队使用的情感分析模型是在Twitter数据上训练的,而实际应用的场景是新闻文章。这种领域差异就像用测量室内温度的温度计去测量室外温度,虽然基本原理相同,但可能存在系统性的偏差。Twitter上的语言表达通常更加随意和情绪化,而新闻文章的语言相对更加正式和克制。

其次,对于某些语言,特别是阿拉伯语,当前的方法显示出明显的性能瓶颈。这种语言特异性的挑战就像某种药物在不同人群中的效果差异,需要更加个性化的解决方案。阿拉伯语的挑战可能源于多个因素:文化背景下的不同表达习惯、语言结构的特殊性,以及训练数据中的表示不足。

计算资源的限制也影响了研究的深度探索。团队只能在有限的GPU资源下进行实验,这限制了他们对大型语言模型的深入研究。他们对Llama3.2-1B的实验需要使用量化和LoRA技术,这虽然使实验成为可能,但也可能影响了模型的最佳性能。

此外,研究采用的是晚期融合策略,即在模型的最后阶段才融入情感特征。这种方法虽然简单有效,但可能不如早期融合或在预训练阶段就融入情感信息的方法那样深入。就像在做菜时,有些调料需要在烹饪过程中早期添加才能充分发挥作用。

数据集的特性也带来了一些限制。虽然研究涵盖了五种语言,但这些语言主要集中在欧洲和中东地区,缺乏对其他语言家族的代表性。同时,数据来源于特定的新闻媒体,可能不能完全代表所有类型的新闻文本。

最后,研究的评估主要基于提供的数据集,在其他新闻来源或主观性定义下的泛化能力仍有待验证。不同的新闻媒体可能有不同的写作风格和主观性表达习惯,这种多样性需要在未来的研究中进一步探索。

七、实际应用前景与挑战赛成果

这项研究的实际应用前景就像播下的种子,正在各个领域生根发芽。在新闻聚合平台上,这种技术可以自动标记文章中的主观性内容,帮助读者更好地理解信息的性质。读者可以清楚地知道哪些段落是事实报道,哪些是记者的分析和观点。

对于社交媒体平台来说,这项技术可以成为打击虚假信息的有力工具。通过识别内容的主观性,平台可以为用户提供更加准确的信息标签,提醒用户注意区分事实和观点。这就像给每条信息贴上了一个"营养标签",帮助用户做出更明智的信息消费选择。

在教育领域,这种技术可以帮助培养学生的媒体素养。通过分析新闻文章的主观性分布,学生可以更好地理解新闻写作的技巧和偏见识别方法。这对于培养批判性思维和信息素养具有重要意义。

新闻机构自身也可以利用这项技术来提高内容质量。编辑可以使用这种工具来检查稿件中的主观性分布,确保事实报道部分保持客观中立,而评论部分则可以适当地表达观点。

在CLEF 2025 CheckThat!挑战赛中,研究团队的表现证明了方法的有效性。他们在多个评估类别中取得了优异成绩,特别是在希腊语零样本任务中获得了第一名,宏平均F1分数达到0.51。这个成绩就像在国际烹饪比赛中获得金奖,证明了他们的"烹饪秘方"的独特价值。

在其他语言的表现也相当不错。德语单语言任务中排名第5,意大利语单语言任务中排名第4,这些成绩都体现了方法的稳定性和有效性。值得注意的是,他们在多个零样本任务中都取得了前列排名,这特别重要,因为零样本任务更能反映方法的泛化能力。

然而,团队也遇到了一些挫折。在多语言任务中,由于提交过程中的错误,他们的成绩并不理想。这种经历就像精心准备的菜品在最后时刻出现了小差错,提醒我们即使是最好的技术也需要完善的实施流程。

团队后续的分析显示,如果没有提交错误,他们在多语言任务中的宏平均F1分数应该达到0.68,这将使他们排名第9位。这个结果虽然有些遗憾,但也展示了方法的实际潜力。

八、未来发展方向

展望未来,这项研究为多个发展方向奠定了基础,就像在科学探索的道路上点亮了几盏明灯。

首先,情感和情绪建模的深化将是一个重要方向。当前研究使用的情感模型相对简单,只区分了正面、中性和负面三种情感。未来的研究可以探索更加细致的情感分类,比如愤怒、讽刺、惊讶等具体情感类型。这种细化就像从黑白照片升级到彩色照片,能够捕捉更多的细节信息。

更进一步,研究团队建议开发专门针对新闻语料的情感分析模型。这种专业化的模型就像为特定场景定制的工具,能够更准确地理解新闻文本中的情感表达。通过在新闻数据上进行微调,这种模型可以更好地适应新闻写作的语言风格和情感表达习惯。

多任务学习框架的探索也是一个有前景的方向。研究团队提出可以同时训练主观性检测和情感分析两个任务,让模型在学习过程中发现两者之间的内在联系。这种方法就像让学生同时学习语文和历史,通过学科之间的交叉理解来提升整体的学习效果。

在技术架构方面,更大规模语言模型的应用将是不可避免的趋势。当前研究由于计算资源限制,只能使用相对较小的模型。未来随着计算能力的提升,使用更大规模的模型可能会带来显著的性能提升。这就像从小型工厂升级到大型工厂,生产能力和产品质量都会有质的飞跃。

融合机制的深化也值得探索。当前研究采用的是简单的特征连接方法,未来可以尝试更加复杂的融合策略,比如注意力机制融合。这种方法能够让模型动态地决定在什么情况下更多地依赖文本信息,什么情况下更多地依赖情感信息。

跨语言建模的改进是另一个重要方向。针对阿拉伯语等表现相对较差的语言,需要开发更加针对性的解决方案。这可能包括语言特定的预处理方法、文化背景的考虑,以及语言特异性特征的引入。

最后,可解释性的提升也是重要的发展方向。当前的模型虽然效果不错,但其决策过程相对黑箱化。未来的研究可以开发更加透明的模型,让用户理解AI是如何做出判断的,这对于新闻领域的应用特别重要。

说到底,这项研究就像在人工智能的花园中种下了一颗新的种子。博洛尼亚大学的研究团队通过巧妙地结合情感分析和文本分类,让AI系统学会了像人类一样感受文本的情感色彩,从而更准确地识别新闻中的主观性表达。

这种创新方法的意义远超技术层面。在信息爆炸的时代,能够准确区分事实和观点变得越来越重要。这项技术就像给每个读者配备了一副"智能眼镜",帮助他们更清晰地看到信息的本质。无论是新闻媒体、社交平台,还是教育机构,都可以利用这项技术来提升信息处理的质量和效率。

当然,这项研究也提醒我们,人工智能技术的发展需要考虑语言和文化的多样性。不同语言的表达习惯和文化背景都会影响AI系统的表现,这需要我们在技术开发中保持开放和包容的态度。

展望未来,随着计算能力的提升和算法的改进,这种情感增强的文本分类方法有望在更多领域发挥作用。从法律文档分析到医疗记录处理,从社交媒体监控到教育内容评估,这项技术的应用前景广阔而充满想象力。

对于那些对这项技术感兴趣的读者,研究团队已经将相关代码和模型公开发布,并提供了在线演示平台。这种开放的态度体现了学术研究的本质:通过分享知识来推动整个领域的进步。有兴趣的读者可以通过GitHub和Hugging Face平台体验这项技术,或者深入研究其技术细节。

Q&A

Q1:这项研究的核心创新是什么?它是如何工作的? A:核心创新是将情感分析融入文本分类中。系统首先分析句子的情感倾向(积极、中性、消极),然后将这些情感分数与文本内容一起输入分类模型。这样AI不仅能理解句子说了什么,还能感受到句子的情感色彩,从而更准确地判断是否为主观表达。

Q2:这项技术会不会在所有语言上都表现良好? A:不会。研究发现不同语言的效果差异很大。英语和意大利语改善明显,德语和保加利亚语表现稳定,但阿拉伯语的效果相对较差。这主要是因为不同语言的情感表达习惯和文化背景不同,需要针对性的优化。

Q3:普通人能否使用这项技术?有什么实际应用? A:可以。研究团队已经开放了代码和在线演示平台,任何人都可以体验。实际应用包括:新闻网站自动标记主观内容、社交媒体平台识别观点性信息、教育机构培养学生媒体素养、帮助读者更好地区分事实和观点等。

好文章,需要你的鼓励

-

浙江大学突破:让AI专家团队在考试时"动态组队",推理能力飙升

浙江大学团队提出动态专家搜索方法,让AI能根据不同问题灵活调整内部专家配置。该方法在数学、编程等任务上显著提升推理准确率,且不增加计算成本。研究发现不同类型问题偏爱不同专家配置,为AI推理优化开辟新路径。

-

清华大学新突破:AI模型居然能学会"少说话多做事",推理效率提升一倍还更准确

清华大学研究团队提出SIRI方法,通过"压缩-扩张"交替训练策略,成功解决了大型推理模型"话多且准确率低"的问题。实验显示,该方法在数学竞赛题上将模型准确率提升43.2%的同时,输出长度减少46.9%,真正实现了效率与性能的双重优化,为AI模型训练提供了新思路。

-

南洋理工大学突破性研究:用AI实现多分钟视频实时流式生成,就像看电视直播一样

南洋理工大学与腾讯联合研究团队开发出Rolling Forcing技术,实现AI视频实时流式生成的重大突破。该技术通过滚动窗口联合去噪、注意力锚点机制和高效训练算法三项创新,解决了长视频生成中的错误累积问题,可在单GPU上以16fps速度生成多分钟高质量视频,延迟仅0.76秒,质量漂移指标从传统方法的1.66降至0.01,为交互式媒体和内容创作开辟新可能。

-

华中科技大学团队突破性发现:让AI像几何学家一样思考,竟能大幅提升空间理解能力

华中科技大学研究团队发现,通过让AI模型学习解决几何问题,能够显著提升其空间理解能力。他们构建了包含约30000个几何题目的Euclid30K数据集,使用强化学习方法训练多个AI模型。实验结果显示,几何训练在四个空间智能测试基准上都带来显著提升,其中最佳模型达到49.6%准确率,超越此前最好成绩。这项研究揭示了基础几何知识对培养AI空间智能的重要价值。