阿里巴巴推出DeepPHY:首个专门测试AI视觉模型物理推理能力的综合评估平台

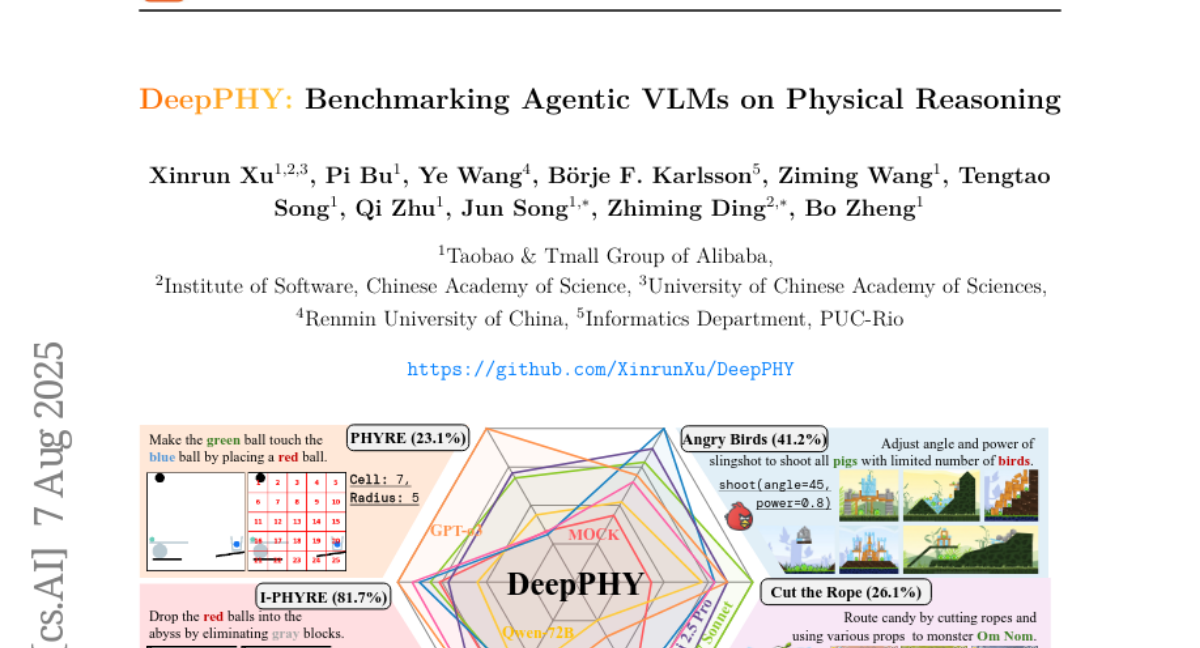

这项由阿里巴巴淘宝天猫集团的徐新润团队联合中科院软件所、中科院大学、人民大学以及巴西里约PUC大学共同完成的研究发表于2025年8月,论文标题为《DeepPHY: Benchmarking Agentic VLMs on Physical Reasoning》。有兴趣深入了解的读者可以通过GitHub项目地址https://github.com/XinrunXu/DeepPHY访问完整研究内容。

当我们看到小孩玩积木时,他们能够直觉地判断哪块积木放在哪里不会倒塌,或者预测球从斜坡滚下来会朝哪个方向。这种对物理世界的理解看似简单,但对于人工智能来说却是一项巨大的挑战。目前最先进的视觉语言模型虽然能够识别图片中的物体,甚至进行复杂的视觉推理,但当需要它们像人类一样进行物理推理并采取行动时,表现却令人失望。

为了系统性地评估这个问题,阿里巴巴的研究团队开发了DeepPHY这个全新的评估平台。这就像为AI模型设计了一套"物理课考试",通过六个不同难度的物理推理环境,全面测试AI模型是否真正理解物理世界的运作规律,而不仅仅是记住一些物理知识。

研究团队发现了一个有趣但令人担忧的现象:即使是当前最强大的AI模型,在这些物理推理任务中的表现也远远低于人类。更关键的是,AI模型能够准确描述物理现象,但却无法将这种描述性知识转化为有效的行动控制。这就像一个人能够完美地解释如何骑自行车的原理,但实际上车时却摔得七荤八素。

一、DeepPHY的诞生背景:AI物理推理的困境

当我们谈论AI的智能水平时,往往会想到它们在下棋、语言翻译或图像识别方面的卓越表现。然而,真正的智能不仅仅是静态的知识理解,更重要的是能够在动态环境中进行推理和行动。物理推理能力正是这种动态智能的核心体现。

目前的AI评估体系主要集中在静态的问答任务上。比如询问AI"如果一个球从10米高的地方掉下来会发生什么",AI能够给出标准的物理学答案。但这种评估方式就像只考察学生的理论知识而不测试实际操作能力一样,无法真正反映AI在实际物理环境中的表现。

研究团队注意到,现有的一些AI评估环境虽然也涉及交互,但它们往往过于简化了物理规律。比如一些游戏环境提供的是高层次的观察和动作空间,绕过了低层次的物理推理需求。而GUI环境虽然需要交互,但不涉及真实世界的物理动力学。至于机器人环境,虽然需要物理交互,但通常过分简化了物理动态过程。

这种评估体系的缺陷导致我们无法准确了解AI模型的真实能力边界。就像只通过书面考试来评估一个人的驾驶技术一样,缺乏实际的路况测试,我们永远不知道这个人在真实驾驶中会遇到什么问题。

二、六个物理世界的考验:DeepPHY的核心组成

DeepPHY评估平台的设计理念就像为AI模型准备了六个不同类型的"物理实验室",每个实验室都专注于测试不同方面的物理推理能力。这种多样化的设计确保了评估的全面性和深度。

PHYRE环境就像一个2D物理拼图游戏。在这个环境中,AI模型需要通过放置一个红球来触发连锁反应,最终让绿球接触到蓝球或紫球。这听起来简单,但实际上需要模型准确预测物体间的碰撞、重力效应和稳定性。研究团队选择了1000个不同难度的任务,涵盖了各种复杂的物理场景。结果令人震惊:即使是最强大的模型GPT-o3,成功率也仅有23.1%。

I-PHYRE环境增加了时间维度的挑战。这里的任务是通过在精确时间点移除灰色障碍物,让红球掉入深渊。这需要模型不仅理解物理规律,还要掌握精确的时间控制。有趣的是,顶级模型在这个环境中表现相对较好,GPT-o3达到了81.7%的成功率,说明某些AI模型在结构化的顺序推理任务中确实具备一定能力。

Kinetix环境像一个物理控制实验室,提供了从简单到极其复杂的各种物理控制任务。任务目标很直接:让绿色物体接触蓝色物体,同时避免接触红色物体。但实现这个目标需要协调控制多个马达和推进器。研究发现,随着任务复杂度的提升,所有模型的表现都急剧下降。即使在最简单的S级任务中,最好的模型成功率也只有60%左右,而在复杂的L级任务中,成功率跌至10%以下。

Pooltool环境是一个高精度的台球模拟器。任务是通过击打最小号码的球来将9号球打入袋中。这个环境特别有趣,因为一些模型表现出了令人误解的"完美"成绩。比如GPT-4o-mini达到了100%的成功率。但深入分析后发现,这种"成功"完全依赖于简单粗暴的策略:总是用最大力度直接击打目标球。这种方法在简单布局中有效,但完全忽略了台球的核心技巧——球的控制和旋转效应。

Angry Birds环境测试的是结构力学和抛射轨迹的综合理解。模型需要调整弹射角度和力度来摧毁所有绿色小猪。这个看似简单的游戏实际上需要对重力、惯性、结构弱点和连锁反应有深刻理解。最好的模型Claude 3.7 Sonnet只达到了41.18%的成功率,远低于人类玩家的64.71%。

Cut the Rope环境可能是最具挑战性的,因为它需要精确的时机控制和复杂的物理直觉。模型需要通过切断绳索、操控气泡和气垫等方式,让糖果最终到达绿色小怪物Om Nom的嘴里。这个环境暴露了AI模型在感知层面的根本问题——它们甚至难以准确识别卡通风格游戏中的绳索数量,更不用说进行复杂的物理推理了。

三、评估方法的创新:让AI模型公平竞争

为了确保评估的公平性和准确性,研究团队对每个环境都进行了精心的改造。这种改造就像为不同语言背景的学生准备统一的考试题目一样,需要在保持题目本质的同时,消除不必要的障碍。

在观察空间的处理上,研究团队意识到当前的视觉语言模型在细节感知方面存在显著缺陷。比如在Cut the Rope游戏中,即使是最先进的模型也无法准确计算场景中绳索的数量。为了公平评估物理推理能力而非感知能力,研究团队为每个环境添加了详细的视觉标注。在PHYRE中,他们在场景上叠加了5×5的网格;在I-PHYRE和Kinetix中,为交互元素添加了数字标签;在Pooltool中,将3D视图转换为更适合AI处理的2D俯视图。

动作空间的设计同样经过了深思熟虑的简化。研究团队发现,当前的视觉语言模型在生成连续动作参数方面表现很差。因此,他们将所有环境的连续动作空间都转换为离散的结构化格式。比如在PHYRE中,将连续的坐标放置转换为网格选择;在Pooltool中,将复杂的力度和旋转参数转换为预定义的选项组合。这种处理确保了AI模型能够专注于物理推理本身,而不是被动作生成的技术细节所困扰。

研究团队还设计了两种不同的提示策略来测试模型的能力。视觉-语言-动作(VLA)格式让模型直接基于环境规则、当前视觉观察和历史失败记录来输出动作。而世界模型(WM)格式则要求模型不仅输出动作,还要预测这个动作会产生的环境变化。这种对比设计旨在测试模型是否真正具备内在的物理预测能力。

四、令人震撼的实验结果:AI的物理推理盲点

当研究团队公布实验结果时,即使是最乐观的研究者也感到震惊。这些结果就像是给AI界泼了一盆冷水,让人们清醒地认识到当前AI技术在物理推理方面的严重不足。

在总体性能方面,几乎所有的开源模型都无法超越随机行动的基线水平。这意味着这些模型的表现还不如完全随机的选择。即使是最先进的闭源模型,表现也令人失望。在PHYRE环境中,表现最好的GPT-o3模型经过10次尝试后的成功率仅为23.1%。考虑到这个任务对人类来说并不困难,这个结果凸显了AI在物理直觉方面的巨大缺陷。

更令人担忧的是模型在学习适应方面的表现。在多次尝试的任务中,大多数模型都表现出了学习效率低下的问题。它们无法从失败的尝试中有效学习,也无法建立准确的内在世界模型来指导后续决策。这就像一个学生在数学考试中,即使告诉他前面几道题做错了,他也无法调整策略来正确解答后面的题目。

在Kinetix环境中,随着任务复杂度的增加,所有模型的表现都出现了断崖式下降。在简单的S级任务中,一些模型还能达到50-60%的成功率,但在复杂的L级任务中,几乎所有模型的成功率都跌至10%以下。这种急剧下降说明当前AI模型缺乏处理多组件协调控制的能力。

在比较不同提示策略时,研究团队发现了一个反直觉的现象:要求模型预测物理结果的世界模型(WM)策略并没有比直接输出动作的VLA策略表现更好,在很多情况下甚至更差。这个发现揭示了一个关键问题:即使模型能够生成看似正确的物理描述,这种描述性知识也无法有效转化为精确的控制行为。

研究团队还发现了一些有趣的细节。比如在Pooltool环境中,某些模型表现出了误导性的"完美"表现。GPT-4o-mini在设定温度为0.1时表现出完全确定性的行为,每次都输出相同的动作,恰好在第8次尝试时成功。这种成功完全依赖于环境的确定性和简单粗暴的策略,与真正的物理推理能力无关。

五、深层问题的揭示:描述与控制的鸿沟

通过详细分析模型的失败模式,研究团队发现了一个深层次的问题:当前AI模型的物理理解主要是描述性的,而非预测性和程序性的。这种差异就像理论驾驶和实际驾驶的区别一样根本。

在Kinetix环境的案例研究中,研究团队观察到一个典型的失败模式。某个模型能够准确预测第一次尝试的结果:"绿色物体将激活左侧和底部推进器,向右上方移动,远离红色地面和右侧红色垂直障碍物,接近右上角的蓝色目标。"这个预测完全正确,第一次尝试也确实成功了。但在第二次尝试时,模型重复了完全相同的动作,没有考虑到物体现在处于不同位置和具有不同动量的事实,结果直接撞上了障碍物。

这种失败模式揭示了一个关键问题:模型缺乏状态感知的控制能力。它们能够基于初始状态做出合理的预测,但无法根据动态变化的状态调整策略。这就像一个GPS导航系统只能在出发时规划路线,但无法根据实时交通状况进行调整。

在Cut the Rope环境中,问题变得更加明显。研究团队发现,即使是最先进的模型也无法准确感知游戏中的基本视觉元素。当要求模型计算场景中绳索的数量时,它们经常给出错误答案,即使在研究人员的提示下进行修正,准确率仍然很低。这种基础感知能力的缺陷严重限制了后续的推理过程。

更深层的问题在于时空推理能力的不足。在需要精确时机控制的任务中,模型往往要么过早行动,要么犹豫不决。它们无法像人类那样直觉地判断最佳行动时机,比如在绳索摆动到最高点时切断以获得最大水平距离。

六、对未来AI发展的深远启示

DeepPHY的研究结果对AI领域具有深远的启示意义。这些发现不仅暴露了当前技术的局限性,也为未来的研究方向提供了重要指引。

首先,这项研究证明了评估AI物理推理能力的重要性和紧迫性。传统的静态问答评估无法反映AI在动态环境中的真实表现。就像评估一个医生的能力不能仅仅通过笔试,还需要临床实践考核一样,评估AI的智能水平也需要更加全面和动态的测试环境。

研究结果还揭示了当前AI训练方法的一个根本缺陷:过分依赖描述性知识而忽视了程序性技能的培养。现有的大语言模型虽然掌握了大量的物理学知识,但这些知识主要以文本形式存储,无法有效转化为实际的控制行为。这就像一个人熟读了所有的游泳教程,但从未下过水一样。

对于未来的AI系统设计,这项研究强调了集成感知、推理和控制能力的重要性。单纯提升模型的语言理解能力或视觉识别能力是不够的,真正的智能需要这些能力的有机结合。这种集成不是简单的模块组合,而需要在系统层面进行深度融合。

研究还表明,当前的AI模型在处理物理世界的不确定性和动态性方面存在根本缺陷。真实世界中的物理过程往往涉及复杂的非线性动力学,需要系统能够处理意外情况和适应性调整。这要求未来的AI系统具备更强的鲁棒性和适应性。

从技术发展的角度来看,这项研究指出了几个关键的研究方向。首先是需要开发更好的物理仿真和推理能力,让AI系统能够建立准确的内在世界模型。其次是需要改进学习算法,使模型能够从交互经验中快速学习和适应。最后是需要探索新的架构设计,更好地整合感知、推理和控制功能。

对于AI安全和可靠性来说,这项研究也具有重要意义。如果AI系统要在真实世界中执行任务,特别是涉及物理交互的任务,那么准确的物理推理能力是基础前提。缺乏这种能力的系统可能会产生不可预测的行为,带来安全风险。

说到底,DeepPHY的研究让我们重新审视了AI智能的本质。真正的智能不仅仅是信息处理和模式识别,更重要的是能够在复杂的物理世界中进行有效的推理和行动。当前的AI系统虽然在某些任务上表现出色,但在物理推理这个基础能力上仍然远远落后于人类。这提醒我们,通往真正人工智能的道路还很漫长,需要更多的基础研究和技术突破。

这项研究也为我们提供了一个重要的评估工具。DeepPHY不仅是一个基准测试,更是一个研究平台,可以帮助研究者系统地分析和改进AI模型的物理推理能力。随着更多研究团队使用这个平台,我们期待看到AI在物理推理方面的持续进步。

最终,DeepPHY的价值不仅在于揭示了当前AI的不足,更在于为未来的发展指明了方向。只有真正理解和解决这些基础问题,AI才能真正走向成熟,在更广泛的应用场景中发挥价值。对于那些关心AI发展前景的人来说,这项研究既是一个警示,也是一个机遇——它告诉我们还有多少工作要做,同时也展示了未来可能的突破方向。

Q&A

Q1:DeepPHY是什么?它主要测试AI的哪些能力?

A:DeepPHY是阿里巴巴团队开发的首个专门评估AI视觉语言模型物理推理能力的综合平台。它通过六个不同的物理环境(包括PHYRE、I-PHYRE、Kinetix、Pooltool、Angry Birds和Cut the Rope)来测试AI模型是否能像人类一样理解物理世界的运作规律,并在动态环境中做出正确的物理推理和控制决策。

Q2:目前最先进的AI模型在DeepPHY测试中表现如何?

A:表现令人失望。即使是最强大的模型如GPT-o3,在不同环境中的成功率也远低于人类水平。比如在PHYRE环境中仅有23.1%的成功率,而在一些复杂任务中,大多数开源模型的表现甚至不如随机选择。更重要的是,研究发现AI模型虽然能描述物理现象,但无法将描述性知识转化为有效的控制行为。

Q3:DeepPHY的研究结果对AI发展有什么重要意义?

A:这项研究揭示了当前AI技术的一个根本缺陷:缺乏真正的物理推理和动态控制能力。它表明仅仅提升语言理解或视觉识别能力是不够的,真正的智能需要感知、推理和控制能力的深度整合。这为未来AI系统设计指明了方向,强调了开发更好的物理仿真能力、改进学习算法以及探索新架构设计的重要性。

好文章,需要你的鼓励

-

从“互联”到“智联”:荣耀MagicOS 10如何用“自进化”重构人机关系?

过去十年,终端厂商比拼的是“性能”和“参数”,如今,竞争的焦点正转向“智能程度”。

-

让AI学会深度搜索:Fractal AI Research实验室开发出能像侦探一样追踪真相的智能助手

Fractal AI Research实验室开发了Fathom-DeepResearch智能搜索系统,该系统由两个4B参数模型组成,能够进行20多轮深度网络搜索并生成结构化报告。研究团队创新了DUETQA数据集、RAPO训练方法和认知行为奖励机制,解决了AI搜索中的浅层化、重复性和缺乏综合能力等问题,在多项基准测试中显著超越现有开源系统,为AI助手向专业研究工具转变奠定了基础。

-

快手科技重磅突破:AI语言模型训练的"权重平衡术"让机器学习更聪明

快手科技与清华大学合作发现当前AI语言模型训练中存在严重的权重分配不平衡问题,提出了非对称重要性采样策略优化(ASPO)方法。该方法通过翻转正面样本的重要性权重,让模型把更多注意力放在需要改进的部分而非已经表现良好的部分,显著提升了数学推理和编程任务的性能,并改善了训练稳定性。