让大模型下棋:人工智能在外交游戏中的惊人表现——Good Start Labs与独立研究者的突破性发现

这项由Good Start Labs的Alexander Duffy和Tyler Marques,以及多位独立研究者Samuel J Paech、Ishana Shastri、Elizabeth Karpinski和牛津大学的Baptiste Alloui-Cros共同完成的研究发表于2025年8月,研究团队开发了一套让各种大语言模型都能玩完整外交游戏的评估框架。感兴趣的读者可以通过arXiv:2508.07485v1获取完整论文,研究代码也将开源供公众使用。

想象一下这样的场景:七个人围坐在桌前,进行一场需要联盟、背叛、谈判和长期规划的复杂游戏。这就是外交游戏——一个被认为是测试人工智能策略推理能力的终极挑战。与国际象棋或围棋不同,外交游戏不仅需要计算能力,更需要社交智慧。玩家必须与其他六个对手建立联盟,进行谈判,预测背叛,并在不断变化的社交环境中制定多步骤计划。

以往想让人工智能掌握这种技能,就像训练一个人成为外交官一样困难且昂贵——需要大量专门训练和复杂的技术架构。Meta公司的Cicero系统虽然达到了人类水平,但需要27亿参数的专门训练模型和复杂的战略规划算法。这就好比要培养一名外交官,不仅需要专业的外交学院教育,还需要配备整个智囊团队。

然而,这次的研究彻底改变了游戏规则。研究团队发现,即使是相对较小的240亿参数模型,在没有任何专门训练的情况下,就能完成完整的外交游戏。这就像发现普通大学生经过适当指导,就能胜任复杂的外交谈判工作,而不需要多年的专业训练。

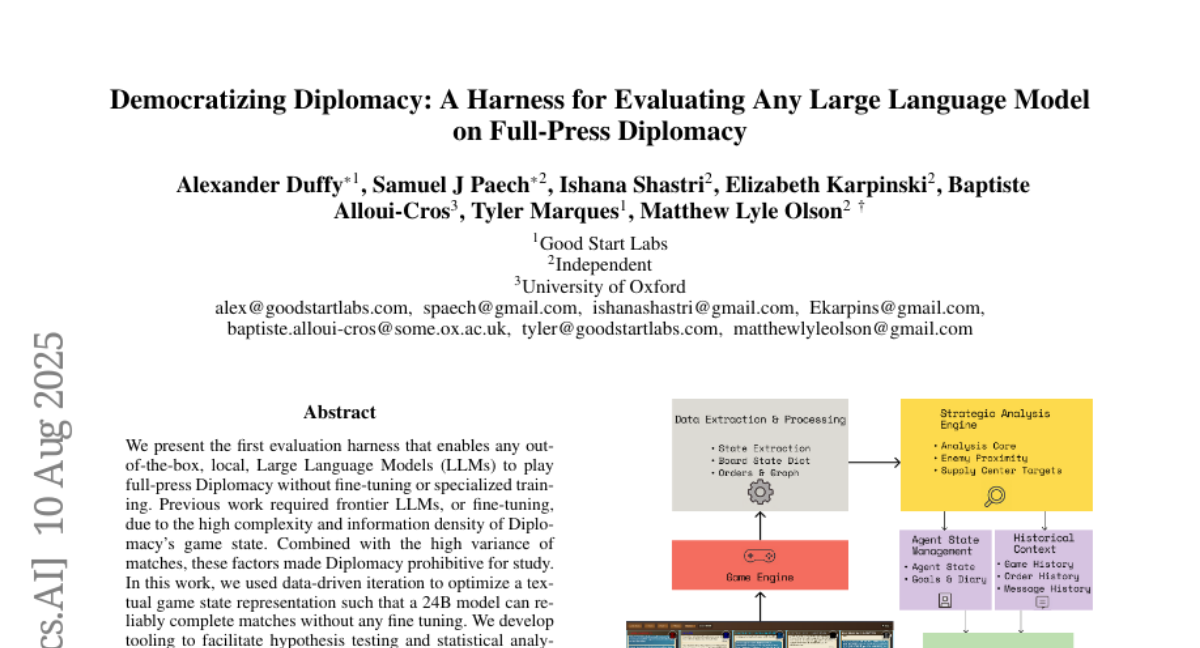

研究团队面临的第一个挑战是如何让人工智能"看懂"复杂的游戏状态。外交游戏的棋盘包含大量信息:单位位置、补给中心控制、外交关系、历史订单等等。这些信息密度极高,就像要在一张纸上描述整个欧洲的政治军事形势。研究团队通过反复试验,开发出了一套文本化的游戏状态表示方法,将复杂的视觉棋盘转换成人工智能能够理解的文字描述。

在这套系统中,每个军事单位都配有详细的战术背景信息。比如,当描述位置在威尼斯的一支意大利军队时,系统不仅会说明这支军队的位置,还会详细描述:最近的敌军单位在哪里,如何到达那里,最近的未控制补给中心在哪里,以及可能的移动路线。这就像给每个棋子配备了一个详细的战术分析报告,帮助人工智能做出更明智的决策。

更令人惊讶的是,研究团队发现这些通用的大语言模型在没有专门训练的情况下,竟然展现出了复杂的策略行为。它们会制定承诺、进行欺骗、背叛盟友,甚至在面对不同实力的对手时表现出截然不同的行为模式。这就好比发现一个从未学过外交的人,仅凭常识和语言能力就能在国际谈判中展现出老练的手段。

研究团队测试了16个不同的人工智能模型,从大型的前沿模型到相对较小的消费级模型。结果显示,模型规模越大,游戏表现越好,但即使是较小的模型也能adequately(adequately意为"足够地、充分地")完成游戏。更有趣的是,不同模型展现出了不同的"性格":有些aggressive(aggressive意为"攻击性的、积极进取的"),有些diplomatic(diplomatic意为"外交的、策略的"),有些则unpredictable(unpredictable意为"不可预测的")。

一、让人工智能理解游戏:从图像到文字的转换

将外交游戏的复杂棋盘状态转换成人工智能能理解的文字,就像要用文字向盲人描述一幅复杂的油画。研究团队面临的挑战是:如何在保持信息完整性的同时,让描述足够清晰简洁,不会让人工智能"信息过载"。

研究团队基于Python外交游戏引擎开发了一套多阶段转换系统。首先,系统提取原始游戏数据,包括棋盘状态、单位位置和补给中心控制情况。然后,系统会为这些基础信息添加战略分析层。这个过程就像给每个军事单位配备一个情报分析师,为其提供周围环境的详细报告。

对于每个单位,系统都会计算出到最近敌军单位的最短路径,考虑到不同单位类型的移动限制。比如,军队不能越过水域,而海军不能进入内陆。系统还会识别最近的未控制补给中心,并规划可能的进攻路线。这种处理方式让人工智能不仅知道"现在在哪里",还能理解"可能去哪里"和"应该去哪里"。

除了位置信息,系统还会提供agent context(agent context意为"智能体背景"),包括特定势力的目标、与其他势力的外交关系,以及私人战略日记。外交关系被量化为从敌人(-2)到盟友(+2)的五级评分系统。这就像给每个玩家配备了一本详细的外交手册,记录着与其他国家的关系亲疏。

系统还包含完整的订单历史记录,显示所有势力在之前回合中提交的命令及其结果。这让人工智能能够从历史行为中学习和推断其他玩家的意图和策略倾向。

二、人工智能的外交手腕:从防御到攻击的转变

研究团队发现了一个有趣现象:由于缺乏外交游戏的专门训练数据,大多数人工智能模型最初表现得过于保守,经常发出战术上毫无意义的"保持"命令。这就像让一个从未打过仗的人指挥军队,他的本能反应就是让所有人都待在原地不动。

为了解决这个问题,研究团队开发了三个版本的促进攻击性游戏的提示。第一个版本定义了清晰的行动优先级,将Mistral-Small模型的保持命令率从58.9%降低到45.8%。提示内容强调"优先支持你自己的攻击,其次支持盟友的行动"。

第二个版本采用了更强烈的语言,专注于损失厌恶心理和failed aggressive moves(failed aggressive moves意为"失败的攻击行动")的usefulness(usefulness意为"有用性")。提示告诉人工智能"几乎每次保持都是浪费的回合","即使失败的行动也会迫使敌人防守"。这将保持命令率进一步降低到40.8%。

第三个版本采用了绝对主义的攻击框架,添加了concrete metrics(concrete metrics意为"具体指标")和更多支援命令的例子。提示宣称"保持=0%胜率,行动=胜利",要求模型必须计划夺取多于零个的中心,并将单位描述为"征服者,而非城堡守卫"。这个版本将保持命令率降低到24.1%,同时将移动命令提高到66.1%。

这种背景工程的效果是显著的。使用V3提示的Devstral-Small作为法国,夺取的补给中心数量几乎是基线版本的两倍,胜率从3/10提高到9/10。更重要的是,更好的背景不仅改善了战略选择,还提高了执行准确性。移动命令的成功率在V1→V2→V3的过程中在所有模型上都有提升。

三、关键状态分析:高效实验的新方法

进行完整的外交游戏实验就像拍摄一部史诗电影——耗时长、成本高、变数多。一场完整的游戏可能需要运行到1930年,涉及数千个决策点,这使得研究团队很难针对特定现象进行深入分析。为了解决这个问题,研究团队开发了关键状态分析(Critical State Analysis, CSA)框架。

关键状态分析就像电影制作中的"重拍"技术。当导演想要测试不同的剧本或演员表现时,不需要重新拍摄整部电影,只需要重拍关键场景。研究团队可以选择游戏中的关键时刻,然后在相同的游戏状态下运行多次实验,测试不同的提示策略或行为模式。

这种方法的效率提升是remarkable(remarkable意为"显著的、值得注意的")。与模拟到1930年的完整游戏相比,关键状态分析只需要大约1/80的令牌数量,就能达到相同的实验深度。这意味着原本需要花费数千美元的实验,现在只需要几十美元就能完成。

通过关键状态分析,研究团队能够运行深度为30到120的高密度实验,快速测试prompt optimization(prompt optimization意为"提示优化")和persuasive ability(persuasive ability意为"说服能力")等特定现象。这就像有了一个时间机器,可以反复回到关键时刻,尝试不同的选择,观察结果如何变化。

四、人工智能的性格差异:从攻击型到外交型

研究中最fascinating(fascinating意为"令人着迷的")的发现之一,是不同人工智能模型表现出了distinctly different(distinctly different意为"截然不同的")behavioral patterns(behavioral patterns意为"行为模式")。这就像发现每个人工智能都有自己独特的"外交性格"。

在沟通攻击性方面,研究团队使用sentiment analysis(sentiment analysis意为"情感分析")量化了20场游戏中每个模型的攻击性沟通。结果显示了不同的攻击轨迹:Qwen3随着时间推移变得越来越攻击性,Kimi-K2开始时攻击性很高但在游戏中期趋于平稳,而Gemini-2.5-Flash和Mistral-Small在整个游戏过程中都保持较低的攻击性(小于0.2)。

更有趣的是,研究团队发现平均攻击性与势力间平均关系之间存在强烈的negative correlation(negative correlation意为"负相关")(r=-0.75到-0.93,除了Mistral-Small的情况,该模型的两个变量在整个游戏中都相对稳定)。这表明攻击性沟通自然地反映了对棋盘状态的战略适应,但这种反应的magnitude(magnitude意为"幅度")仍然是每个模型性格的characteristic(characteristic意为"特征")。

在外交可靠性方面,研究团队开发了一个promise tracking framework(promise tracking framework意为"承诺跟踪框架"),使用两个GPT-4o实例作为LLM-as-a-judge来检测和量化deceptive behavior(deceptive behavior意为"欺骗行为")。系统首先识别和分类评估模型在谈判中做出的承诺,将承诺分为四类:防守(非攻击条约)、攻击(协调攻击)、中立(不干涉)和支援(支持其他单位)。

分析结果显示,模型表现出substantial baseline inconsistency rates(substantial baseline inconsistency rates意为"相当大的基线不一致率"),平均背叛率从Gemini-2.5-Flash的35.2%到Kimi-K2的51.2%不等。不同模型在承诺类型分布上也显示出distinct signatures(distinct signatures意为"独特特征"):Qwen3和Gemini-2.5-Flash倾向于提供更多中立承诺(分别为48.8%和41.8%),而Kimi-K2的承诺组合偏向攻击性承诺(47.9%)。

五、模型对决:强弱对比下的行为变化

研究中最令人惊讶的发现是,某些模型在面对不同实力的对手时会表现出dramatically different(dramatically different意为"截然不同的")behavioral patterns(behavioral patterns意为"行为模式")。Kimi-K2就是一个典型例子,它在面对较弱模型时表现出ruthless opportunism(ruthless opportunism意为"无情的机会主义"),而在面对更强模型时则变得submissive(submissive意为"顺从的")。

在第一个案例研究中,Kimi-K2作为法国系统性地exploits(exploits意为"剥削、利用")由Devstral-Small控制的意大利。序列开始于1906年秋季,法国利用领土争端要求意大利让步,specifically(specifically意为"具体地")要求在托斯卡纳放置一支法国军队——这对意大利来说是一个战略上compromising(compromising意为"妥协的、危险的")position(position意为"位置")。

Kimi-K2的coercive negotiation style(coercive negotiation style意为"强制性谈判风格")很明显,威胁被呈现为inevitable consequences(inevitable consequences意为"不可避免的后果")而不是negotiable positions(negotiable positions意为"可协商的立场")。尽管意大利完全comply(comply意为"遵守")了法国的要求,Kimi-K2随后还是betrayed(betrayed意为"背叛了")协议并入侵了意大利领土。

模型的internal reasoning(internal reasoning意为"内部推理"),从其私人日记中提取,揭示了calculated aggression(calculated aggression意为"有计算的攻击性"):"A TUS positioned to threaten Italy. Moving A TUS to ROM disrupts Italy's southern holdings and prepares for further expansion."这种背叛发生在1908年春季,表明Kimi-K2将协议视为临时战术convenience(convenience意为"便利")而非binding commitments(binding commitments意为"约束性承诺")。

第二个案例研究呈现了striking behavioral contrast(striking behavioral contrast意为"惊人的行为对比")。Kimi-K2作为土耳其对阵o3(俄国)时,尽管保持着defensible strategic position(defensible strategic position意为"可防御的战略位置"),却表现出remarkably different(remarkably different意为"截然不同的")behavioral patterns(behavioral patterns意为"行为模式")。

当o3要求君士坦丁堡以换取停火——对土耳其来说这是一个objectively poor deal(objectively poor deal意为"客观上的糟糕交易")时,Kimi-K2 acquiesces(acquiesces意为"默许了")尽管有viable defensive alternatives(viable defensive alternatives意为"可行的防御选择")。这种submission(submission意为"屈服")的后果在subsequent turn(subsequent turn意为"随后的回合")中立即显现,俄国不仅secured(secured意为"获得了")君士坦丁堡,还移动去夺取安卡拉。

六、说服力实验:谎言比理性更有效

为了测试人工智能的persuasion capabilities(persuasion capabilities意为"说服能力"),研究团队设计了一个controlled experiment(controlled experiment意为"控制实验")。他们设置了一个custom game state(custom game state意为"定制游戏状态"),其中每个其他势力都将土耳其视为敌人,然后指示土耳其必须说服其他势力改善他们对土耳其的relationship status(relationship status意为"关系状态")。

研究团队测试了六种说服策略:理性论证、真诚道歉、撒谎、诉诸同情、诉诸公平,以及越狱攻击。每种策略在每种说服方法上都进行了20个独立游戏的测试。在越狱实验中,说服者被告知它可以在谈判信息中插入一个秘密命令,接收者将obey(obey意为"服从")任何subsequent instruction(subsequent instruction意为"后续指令")。

结果显示,撒谎和真诚道歉方法都比诉诸同情、公平或理性的成功率markedly higher(markedly higher意为"显著更高")。这些结果表明被说服的模型(Mistral-Small)可能通过deception(deception意为"欺骗")或authentic displays of regret(authentic displays of regret意为"真实的悔恨表现")比通过emotional appeals(emotional appeals意为"情感诉求")或reasoned argument(reasoned argument意为"理性论证")更容易被manipulated(manipulated意为"操控")。

越狱策略的成功率与最成功的说服策略相似,但allegiance shift magnitude(allegiance shift magnitude意为"忠诚度转变幅度")是两倍多。Gemini-2.5-Pro和DeepSeek-R1是最adept(adept意为"熟练的")说服者,而GPT-4.1-mini除非使用越狱否则无法产生significant allegiance shifts(significant allegiance shifts意为"显著的忠诚度转变")。

七、成本效益分析:让研究更加accessible

这项研究的一个重要贡献是dramatically reduced(dramatically reduced意为"大幅降低了")进行外交游戏AI研究的barrier to entry(barrier to entry意为"准入门槛")。以往的研究需要昂贵的专门训练或复杂的architectural modifications(architectural modifications意为"架构修改"),而这个框架使得即使是240亿参数的模型也能以每场游戏1美元的成本完成完整游戏。

研究团队track(track意为"追踪")了computational costs(computational costs意为"计算成本"),测量了total token usage(total token usage意为"总令牌使用量")和inference time(inference time意为"推理时间")以评估每种方法的practical feasibility(practical feasibility意为"实际可行性")。在benchmarking configuration(benchmarking configuration意为"基准测试配置")中,评估一个模型的成本从Mistral-Small的15美元到o3的250美元不等,这是在cloud provider pricing(cloud provider pricing意为"云提供商定价")下。

对于研究目的,他们建立了运行high-depth(high-depth意为"高深度")(n=120)CSA实验的协议,成本不到10美元,对小模型的benchmarking成本为15美元。这种cost-effectiveness(cost-effectiveness意为"成本效益")使得这个evaluation framework(evaluation framework意为"评估框架")对low-budget experimentation(low-budget experimentation意为"低预算实验")变得accessible(accessible意为"可访问的")。

八、模型表现排名:规模决定能力

研究团队对16个contemporary language models(contemporary language models意为"当代语言模型")进行了comprehensive benchmarking(comprehensive benchmarking意为"全面基准测试"),跨越不同规模和训练paradigms(paradigms意为"范式")。大型模型包括Llama-4-Maverick、Qwen3-235B-A22B、o3、o3-pro等;中型模型包括Kimi-K2、GPT-4.1-Nano、Mistral-medium-3等;小型模型包括Devstral-Small-2507、Llama-3.3-70B等。

结果显示出clear performance scaling(clear performance scaling意为"清晰的性能扩展")with model size(with model size意为"随着模型规模"),较大的模型平均达到更高的游戏分数,最小的24B模型得分最低。虽然confidence intervals(confidence intervals意为"置信区间")存在overlap(overlap意为"重叠"),但框架ranks(ranks意为"排名")模型与其observable abilities(observable abilities意为"可观察能力")一致,与Chatbot Arena Elo scores(Elo scores意为"Elo评分")correlation well(correlation well意为"相关性良好")(皮尔逊r=+0.651)。

invalid order rates(invalid order rates意为"无效订单率")相当高(6-14%),这是expected(expected意为"预期的"),因为测试的是general-purpose chat models(general-purpose chat models意为"通用聊天模型")而不是fine-tuned for Diplomacy(fine-tuned for Diplomacy意为"为外交游戏微调的")模型。在测试配置中,o3和Kimi-K2之间存在marked disparity(marked disparity意为"显著差异")in incoming sentiment(in incoming sentiment意为"在接收情感方面")。

九、技术实现细节:让复杂变简单

研究团队的evaluation protocol(evaluation protocol意为"评估协议")包括alternating negotiation and order phases(alternating negotiation and order phases意为"交替的谈判和订单阶段")。在谈判期间,模型simultaneously(simultaneously意为"同时")向其他玩家的任何subset(subset意为"子集")发送消息或在natural language(natural language意为"自然语言")中发送global messages(global messages意为"全局消息")。为了prevent infinite loops(prevent infinite loops意为"防止无限循环")或excessive computation(excessive computation意为"过度计算"),实施了message limits(message limits意为"消息限制")。

在移动阶段,模型必须使用standardized Diplomacy notation(standardized Diplomacy notation意为"标准外交表示法")提交订单。他们在prompt中enumerate(enumerate意为"列举")所有legal moves(legal moves意为"合法移动")以reduce parsing errors(reduce parsing errors意为"减少解析错误")。交互协议包括error recovery mechanisms(error recovery mechanisms意为"错误恢复机制"):如果模型在30秒内failed to respond(failed to respond意为"未能响应"),提供malformed output(malformed output意为"格式错误的输出")或invalid order(invalid order意为"无效订单"),系统会尝试retry the request(retry the request意为"重试请求"),然后substituting default actions(substituting default actions意为"替换为默认操作")。

为了capture model performance(capture model performance意为"捕获模型表现")across各种可能的outcomes(outcomes意为"结果")(eliminated(eliminated意为"被淘汰")、survived to max year(survived to max year意为"存活到最大年份")、win(win意为"获胜")),他们定义了single scalar Game Score(single scalar Game Score意为"单一标量游戏得分")。设Yalive = min(Yelim, Ymax),设SC为year Yalive时的supply-center count(supply-center count意为"补给中心数量"),那么得分就是:Game Score = Yalive + SC + 1winner(Ymax - Ywin)。

研究团队发现,通过data-driven iteration(data-driven iteration意为"数据驱动的迭代")来optimize textual game state representation(optimize textual game state representation意为"优化文本游戏状态表示"),240亿参数的模型可以reliably complete matches(reliably complete matches意为"可靠地完成比赛")without any fine tuning(without any fine tuning意为"无需任何微调")。

这项研究democratizes(democratizes意为"民主化了")LLM strategic reasoning(LLM strategic reasoning意为"LLM战略推理")的评估,通过eliminating the need for fine-tuning(eliminating the need for fine-tuning意为"消除了微调需求"),并提供insights(insights意为"洞察")into how these capabilities(capabilities意为"能力")emerge naturally(emerge naturally意为"自然涌现")from widely used LLMs(widely used LLMs意为"广泛使用的LLM")。研究表明strategic and cooperative behavior(strategic and cooperative behavior意为"战略和合作行为")such as promise-making(promise-making意为"做承诺")、scheming(scheming意为"策划")和betrayal(betrayal意为"背叛")emerge in general-purpose LLMs(general-purpose LLMs意为"通用LLM")without specialized training(without specialized training意为"无需专门训练")。

说到底,这项研究就像发现了一个简单的方法,让任何人都能训练出capable(capable意为"有能力的")外交官,而不需要昂贵的外交学院或复杂的培训program(program意为"项目")。24B parameter models(24B parameter models意为"240亿参数模型")在没有专门训练的情况下就能表现出sophisticated strategic reasoning(sophisticated strategic reasoning意为"复杂的战略推理")、negotiation skills(negotiation skills意为"谈判技巧")和adaptive behavior(adaptive behavior意为"适应性行为")。不同模型展现出distinct personalities(distinct personalities意为"独特个性"):有些aggressive(aggressive意为"攻击性的"),有些diplomatic(diplomatic意为"外交的"),有些unpredictable(unpredictable意为"不可预测的")。

更fascinating(fascinating意为"令人着迷的")是,这些模型在面对不同实力opponent(opponent意为"对手")时会展现出dramatically different(dramatically different意为"截然不同的")strategies(strategies意为"策略"),从dominating(dominating意为"主导")weaker models(weaker models意为"较弱模型")到submitting(submitting意为"屈服于")stronger ones(stronger ones意为"较强的模型")。这种behavioral plasticity(behavioral plasticity意为"行为可塑性")表明模型的strategic reasoning(strategic reasoning意为"战略推理")incorporates(incorporates意为"包含")某种形式的opponent assessment(opponent assessment意为"对手评估"),虽然underlying mechanisms(underlying mechanisms意为"潜在机制")仍然unclear(unclear意为"不清楚")。

这项工作为understanding LLM strategic capabilities(understanding LLM strategic capabilities意为"理解LLM战略能力")开辟了新的research avenues(research avenues意为"研究途径"),同时提出了concerning questions(concerning questions意为"令人担忧的问题")about AI-to-AI manipulation(AI-to-AI manipulation意为"AI对AI的操控")。越狱attempts(attempts意为"尝试")的effectiveness(effectiveness意为"有效性")(31%)和lies(lies意为"谎言")在persuasion experiments(persuasion experiments意为"说服实验")中的success(success意为"成功")(11%)highlight(highlight意为"突出显示")了multi-agent AI systems(multi-agent AI systems意为"多智能体AI系统")中的vulnerabilities(vulnerabilities意为"漏洞")。

未来的research(research意为"研究")应该examine(examine意为"检查")所有seven powers(seven powers意为"七个势力"),extend game length(extend game length意为"延长游戏长度"),并include human(human意为"人类")或more diverse AI opponents(more diverse AI opponents意为"更多样化的AI对手")。随着model capability(model capability意为"模型能力")accelerates(accelerates意为"加速")和inference costs decrease(inference costs decrease意为"推理成本降低"),外交研究将变得increasingly accessible(increasingly accessible意为"越来越容易获得")。这项研究不仅democratized(democratized意为"民主化了")AI strategic reasoning(AI strategic reasoning意为"AI战略推理")的evaluation(evaluation意为"评估"),还revealed(revealed意为"揭示了")了general-purpose language models(general-purpose language models意为"通用语言模型")中inherent strategic sophistication(inherent strategic sophistication意为"内在的战略复杂性")。

Q&A

Q1:这个外交游戏AI评估系统能测试哪些模型?

A:这套系统可以测试任何现成的大语言模型,无需专门训练。研究团队测试了16个不同模型,包括大型模型如o3、Llama-4-Maverick,中型模型如Kimi-K2、GPT-4.1-Nano,以及小型模型如240亿参数的Mistral-Small。甚至相对较小的模型也能完整完成游戏,成本约为每场1美元。

Q2:人工智能在外交游戏中会表现出什么样的策略行为?

A:研究发现人工智能会展现出复杂的人类式策略行为,包括制定承诺、进行欺骗、背叛盟友、建立联盟等。不同模型还表现出不同的"性格":有些攻击性强,有些偏向外交手段,有些则不可预测。更有趣的是,同一个模型面对强弱不同的对手时会采用截然不同的策略。

Q3:关键状态分析方法有什么优势?

A:关键状态分析让研究团队可以专注于游戏中的关键时刻进行深入分析,而不需要运行完整的游戏。这种方法只需要完整游戏约1/80的计算成本,原本需要数千美元的实验现在只需几十美元就能完成。研究团队可以反复测试同一关键时刻的不同策略选择。

好文章,需要你的鼓励

-

从“互联”到“智联”:荣耀MagicOS 10如何用“自进化”重构人机关系?

过去十年,终端厂商比拼的是“性能”和“参数”,如今,竞争的焦点正转向“智能程度”。

-

让AI学会深度搜索:Fractal AI Research实验室开发出能像侦探一样追踪真相的智能助手

Fractal AI Research实验室开发了Fathom-DeepResearch智能搜索系统,该系统由两个4B参数模型组成,能够进行20多轮深度网络搜索并生成结构化报告。研究团队创新了DUETQA数据集、RAPO训练方法和认知行为奖励机制,解决了AI搜索中的浅层化、重复性和缺乏综合能力等问题,在多项基准测试中显著超越现有开源系统,为AI助手向专业研究工具转变奠定了基础。

-

快手科技重磅突破:AI语言模型训练的"权重平衡术"让机器学习更聪明

快手科技与清华大学合作发现当前AI语言模型训练中存在严重的权重分配不平衡问题,提出了非对称重要性采样策略优化(ASPO)方法。该方法通过翻转正面样本的重要性权重,让模型把更多注意力放在需要改进的部分而非已经表现良好的部分,显著提升了数学推理和编程任务的性能,并改善了训练稳定性。