香港理工大学团队突破:让AI在分子世界里"边想边创造",推理过程也能看得见

药物发现本质上就像是一场高难度的拼图游戏,科学家需要根据文字描述,准确拼出一个能够发挥特定作用的分子结构。传统的人工智能就像一个熟练的拼图高手,能够快速给出答案,但你却看不到它的思考过程。而现在,香港理工大学的李嘉童、王韦达等研究团队,联合上海人工智能实验室、上海交通大学和复旦大学,开发出了一个名为Mol-R1的全新框架,让AI不仅能完成这个拼图游戏,还能完整展示它的推理过程,就像一位经验丰富的化学家在实验室里边思考边工作一样。

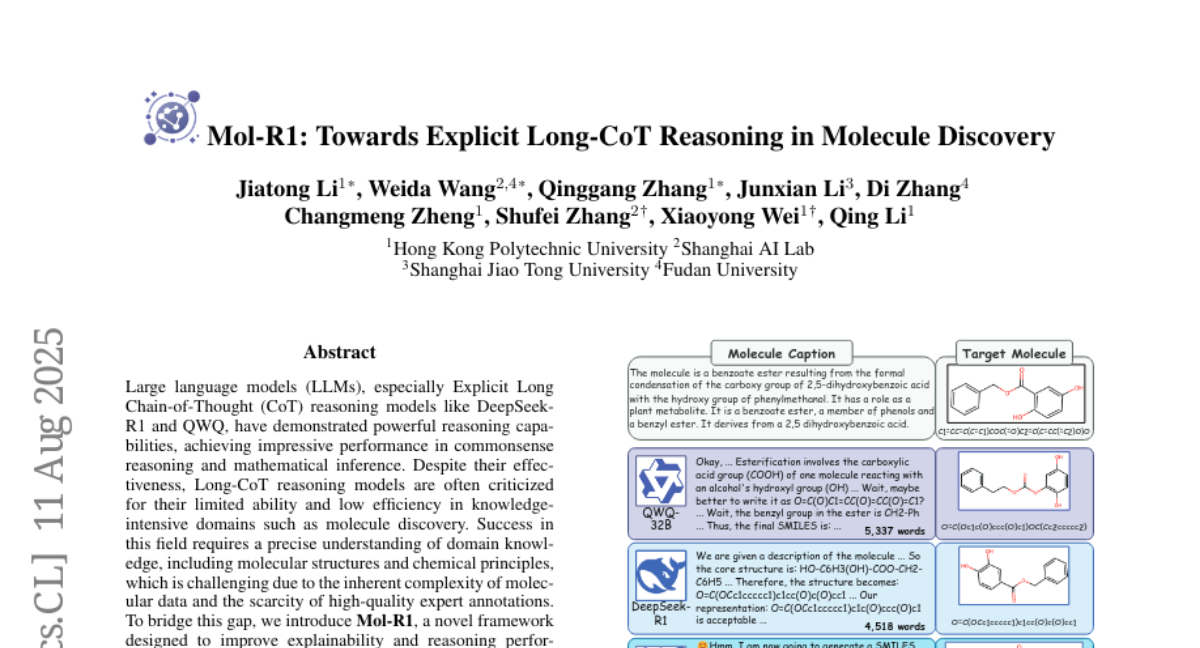

这项发表于2025年8月11日的研究(论文编号:arXiv:2508.08401v1),可以说是AI辅助分子发现领域的一次重要突破。想象一下,当化学家需要设计一种新药时,他们通常会这样描述目标分子:"我需要一个苯甲酸酯,由2,5-二羟基苯甲酸与苯基甲醇结合而成"。传统的AI系统就像一台神奇的转换器,输入这段描述后立即输出分子的SMILES表示(一种化学分子的字符串表示方法),但整个过程就像黑盒子一样无法观察。

研究团队发现,现有的长链思维推理模型,比如DeepSeek-R1和QWQ-32B,虽然在数学推理和常识推理方面表现出色,但在分子发现这个需要高度专业知识的领域却遇到了两个关键问题。第一个问题就像厨师没有食谱一样——这些模型缺乏高质量的推理数据来启动训练,现有的分子数据集比如ChEBI-20只包含分子描述和结构,却没有连接两者的推理过程。第二个问题则像是学生做题时只看结果不看过程——现有的训练方法只关注最终答案是否正确,而不管推理过程是否合理,这导致模型经常产生错误的推理路径。

Mol-R1框架就像给AI配备了一位经验丰富的化学导师,通过两个核心创新来解决这些问题。首先是"先验调节情境蒸馏"(PRID),这个方法就像让AI观摩一位专家化学家的完整工作过程。研究团队请专家手工编写了一个详细的推理示例,展示如何从分子描述一步步推导出分子结构。然后,AI通过观察这个示例,学会了如何进行类似的推理。这就像学习烹饪时,师傅先完整演示一道菜的制作过程,徒弟通过观察学会了烹饪的基本思路和方法。

第二个创新是"分子迭代适应"(MoIA),这个训练策略就像是一个循序渐进的学习过程。传统的训练方法要么是纯粹的监督学习(像填鸭式教育),要么是纯粹的强化学习(像完全自主探索)。而MoIA则巧妙地将两者结合起来,就像一个优秀的教育系统既有课堂教学,又有实践练习。在每个迭代周期中,AI首先通过监督学习巩固确定性知识,然后通过强化学习策略优化在更大数据集上的表现,最后通过拒绝采样来更新训练数据,形成一个不断提升的正向循环。

整个训练过程分为三个阶段,就像攀登一座高山。在T=0阶段,AI使用PRID方法生成的1053个高质量推理样本进行基础训练,掌握基本的推理模式。接着在T=1阶段,训练数据扩展到7285个样本,AI的推理能力得到进一步提升。最终在T=2阶段,训练数据达到8700个样本,AI的表现趋于稳定并达到最佳状态。

研究团队采用了多种评估指标来全面考察Mol-R1的性能。除了传统的BLEU分数、精确匹配率等准确性指标外,他们还创新性地引入了"一致性F1分数"来评估推理质量。这个指标就像请一位化学专家来审查AI的推理过程,判断这个推理是否能够逻辑一致地得出正确结论。如果推理过程本身是合理的,即使最终答案有误,也比答案侥幸正确但推理过程错误要更有价值。

实验结果令人印象深刻。与最先进的推理模型相比,Mol-R1在T=2迭代后实现了显著的性能提升。相比QWQ-32B,Mol-R1的BLEU分数提高了354%,而且在一致性F1分数上也达到了最高水平。更重要的是,Mol-R1生成的推理过程平均只有428个词,而QWQ-32B需要4518个词,DeepSeek-R1甚至需要5337个词。这意味着Mol-R1不仅更准确,而且更高效,就像一位经验丰富的专家能够用最简洁的语言解释复杂问题一样。

为了证明PRID方法的优越性,研究团队进行了详细的对比实验。他们发现,即使使用更少的训练数据(1053个样本),PRID方法的效果也明显优于传统的拒绝采样方法(使用2943个样本)。这就像精心设计的小班教学往往比大班填鸭式教育更有效果。传统的拒绝采样方法让AI自由探索,但在分子推理这个需要精确知识的领域,自由探索往往导致大量错误的推理路径,反而影响学习效果。

MoIA的迭代训练策略也展现出了明显的优势。研究团队发现,单纯使用强化学习会导致模型在约800步后就停止改进,而MoIA框架下的模型能够持续改进到2000步左右。这就像马拉松跑者需要合理分配体力一样,适当的节奏调整能够帮助达到更好的最终成绩。

在奖励函数的设计上,研究团队发现了一个有趣的权衡现象。当他们提高精确匹配奖励的权重时,模型确实能产生更多完全正确的分子结构,但同时会降低化学有效性。这就像学生为了考试高分而过度专注于标准答案,可能会忽视对基本概念的理解。研究团队最终选择了一个平衡的奖励策略,既保证准确性,又维持合理的化学有效性。

通过具体案例分析,研究团队展示了Mol-R1在不同迭代阶段的推理演化过程。以"O-甲基丙二酰肉碱"的一价阴离子为例,在T=0阶段,模型能够识别出基本结构但在去质子化处理上存在错误。到了T=1阶段,模型开始正确处理某些官能团的修饰,但仍有遗漏。最终在T=2阶段,模型成功生成了完全正确的SMILES表示,整个推理过程逻辑清晰、步骤合理。

这项研究的意义远不止于技术层面的突破。在药物研发领域,理解AI的推理过程对于确保药物安全性至关重要。当AI推荐一个新的药物分子时,研究人员需要知道AI是基于什么逻辑得出这个结论的,特别是涉及毒性或副作用等安全相关的特性。Mol-R1提供的透明推理过程就像给化学家提供了一个可视化的思维导图,帮助他们更好地理解和验证AI的建议。

研究团队还进行了理论分析,从信息论的角度证明了显式推理的有效性。他们证明了在理想情况下,完美的推理路径能够减少答案的不确定性,而即使是有缺陷的推理路径,只要能够提供关于答案的新信息,也比直接预测更有价值。这为显式推理方法提供了坚实的理论基础。

当然,这项研究也存在一些局限性。目前的工作主要集中在文本到分子的生成任务上,而在实际药物开发中,还需要考虑三维结构、蛋白质相互作用等更复杂的因素。此外,专家标注的推理示例虽然质量很高,但获取成本相对较高,如何进一步自动化这个过程也是未来研究的方向。

展望未来,Mol-R1框架为AI辅助科学发现开辟了新的可能性。这种"边思考边创造"的AI模式不仅适用于分子设计,也可能扩展到材料科学、生物工程等其他需要复杂推理的科学领域。随着AI推理能力的不断提升,我们有理由期待AI能够成为科学家们更加智能和可信赖的研究伙伴。

从更宏观的角度来看,这项研究体现了AI发展的一个重要趋势——从黑盒子走向透明化。就像医生需要解释诊断理由、律师需要阐述法律逻辑一样,AI系统特别是在高风险领域的应用,必须能够提供可解释、可验证的推理过程。Mol-R1在分子发现领域的成功实践,为构建更加透明和可信的AI系统提供了宝贵经验。

Q&A

Q1:Mol-R1与传统AI分子生成方法的主要区别是什么?

A:传统AI方法就像一个高速转换器,直接将分子描述转换为分子结构,但看不到思考过程。而Mol-R1就像一位化学家,会展示完整的推理过程——它会分析分子描述的每个部分,逐步推导出分子结构,让科学家能够理解和验证AI的思维逻辑。这种透明性对药物安全性评估特别重要。

Q2:PRID方法为什么比传统的拒绝采样更有效?

A:拒绝采样就像让学生完全自主学习,在分子推理这种需要精确专业知识的领域往往产生大量错误路径。而PRID方法就像让优秀老师先示范标准解题过程,AI通过观摩专家的推理示例学会正确的思维方式。实验显示,即使用更少的训练数据,PRID方法的效果也明显更好。

Q3:MoIA迭代训练与单纯强化学习相比有什么优势?

A:单纯强化学习就像让运动员只进行比赛而不进行基础训练,很快就会遇到瓶颈。MoIA方法则像科学的训练计划,既有基础知识巩固(监督学习),又有实战练习(强化学习)。实验表明,单纯强化学习在800步后就停止改进,而MoIA能持续改进到2000步,最终效果更好。

好文章,需要你的鼓励

-

大语言模型为什么老是"胡编乱造"?OpenAI团队揭开AI幻觉的真相

OpenAI团队的最新研究揭示了大语言模型产生幻觉的根本原因:AI就像面临难题的学生,宁愿猜测也不愿承认无知。研究发现,即使训练数据完全正确,统计学原理也会导致AI产生错误信息。更重要的是,现有评估体系惩罚不确定性表达,鼓励AI进行猜测。研究提出了显式置信度目标等解决方案,通过改革评估标准让AI学会诚实地说"不知道",为构建更可信的AI系统指明方向。

-

ByteDance AI实验室发布重磅研究:让计算机学会"逆向思考",解决创意写作难题

字节跳动AI实验室提出"逆向工程推理"新范式,通过从优质作品反推思考过程的方式训练AI进行创意写作。该方法创建了包含2万个思考轨迹的DeepWriting-20K数据集,训练的DeepWriter-8B模型在多项写作评测中媲美GPT-4o等顶级商业模型,为AI在开放性创意任务上的应用开辟了新道路。

-

电脑终于学会了像人类一样用键盘鼠标:ByteDance推出会玩游戏的AI助手

ByteDance Seed团队开发的UI-TARS-2是一个革命性的AI助手,能够通过观看屏幕并用鼠标键盘操作电脑,就像人类一样完成各种任务和游戏。该系统采用创新的"数据飞轮"训练方法,在多项测试中表现出色,游戏水平达到人类的60%左右,在某些电脑操作测试中甚至超越了知名AI产品,展现了AI从对话工具向真正智能助手演进的巨大潜力。