中科院团队让庞大的3D重建AI"瘦身":压缩75%体积却保持98%精度

2025年,中国科学院计算技术研究所的冯伟伦、杨传光、安竹林等研究人员,与ETH苏黎世联邦理工学院和上海交通大学的学者们合作,发表了一项名为《量化视觉几何基础变换器》的重要研究。这项研究于2025年9月30日发布在arXiv预印本平台,编号为arXiv:2509.21302v2,为解决大型3D重建模型的部署难题提供了创新性解决方案。

想象一下,你有一个超级精密的3D相机,能够仅仅通过拍摄几张照片就完整还原出一个立体场景。这样的"魔法"在AI世界里确实存在,它就是被称为VGGT(视觉几何基础变换器)的技术。VGGT就像一位经验丰富的建筑师,能从几张建筑物的照片中精确推算出整个建筑的3D模型、每个摄像机的位置,甚至追踪其中每个点的移动轨迹。

但是,这位"建筑师"有个大麻烦:它实在太"臃肿"了。VGGT模型包含12亿个参数,就像一本厚达几万页的百科全书,虽然知识渊博,但实在太笨重了,普通的计算机根本无法承载。更要命的是,运行一次就需要消耗巨大的电力和内存,就像开动一台耗电巨大的工厂机器仅仅为了制作一个零件。

中科院的研究团队意识到,如果不解决这个"减肥"问题,再优秀的技术也无法真正走进千家万户。他们的目标很明确:在保持VGGT几乎全部能力的前提下,让它"瘦身"到可以在普通设备上流畅运行的程度。

经过深入研究,团队发现了一个有趣的现象。传统的模型压缩技术(称为量化)在处理VGGT时会遇到两个独特的挑战。第一个挑战就像在一群正常体重的人中突然混入了几个特别胖的人,整个队伍的平均体重分布就变得极不均匀。在VGGT中,那些"特别胖的人"是一些特殊的数据节点,叫做相机令牌和注册令牌,它们的数值往往比普通图像数据大得多,导致整个模型的数据分布变得畸形。

第二个挑战则更加微妙。3D重建不同于普通的图像识别任务,它需要处理多个视角的复杂场景。这就像让AI同时理解同一座建筑从东南西北四个方向拍摄的照片,并且要完全理解它们之间的空间关系。在准备训练数据时,如果选择的样本不够多样化或者包含了太多"异常"样本,就会导致模型学习效果大打折扣。

为了解决这些问题,研究团队提出了一套创新的解决方案,他们称之为QuantVGGT。这套方案包含两个核心技术。

第一个技术叫做"双重平滑精细量化",就像给数据做了一次全身按摩和局部调理。首先,他们使用一种叫做哈达玛德变换的数学工具,这就像用一个特殊的"搅拌器"把那些极端的数值分散到整个数据空间中,让原本集中在某些位置的极端值变得更加均匀。这个过程就像把一滴浓稠的蜂蜜滴入一杯水中,然后充分搅拌,让甜味均匀分布到整杯水中,而不是仍然聚集在一个地方。

接下来,他们又进行了一次"局部调理"。在哈达玛德变换之后,数据的全局分布虽然变得更均匀了,但不同通道之间仍然存在局部的不平衡。研究团队设计了一个智能的缩放机制,就像给每个不同的数据通道配置了专门的"调色剂",让每个通道内部的数值分布都变得更加平滑合理。

第二个核心技术叫做"噪声过滤多样化采样",专门用来解决训练数据选择的问题。这个过程分为两个步骤。首先是"噪声过滤",研究团队开发了一套评分系统,能够自动识别并过滤掉那些可能干扰学习的异常样本。这就像在一堆照片中挑选出拍摄质量最好、最有代表性的照片,而不是被那些模糊、曝光异常的照片所干扰。

然后是"多样化采样",这一步更加巧妙。研究团队发现,VGGT有一个特殊的"偏好":它特别擅长理解第一张图片与后续图片之间的关系。基于这个发现,他们设计了一种基于帧间相关性的聚类方法,就像根据不同场景的特征将照片分类整理,然后从每个类别中均匀选择样本,确保训练数据既有足够的多样性,又能很好地代表真实世界的各种情况。

为了验证这套技术的效果,研究团队进行了大量的实验测试。他们选择了两个主要的测试任务:相机位置估计和点云地图生成。相机位置估计就像让AI在看到几张照片后,准确推算出每张照片的拍摄位置和角度。点云地图生成则是根据照片重建出密集的3D点云,就像用无数个小点重新"画"出一个立体场景。

在相机位置估计任务中,研究团队使用了Co3Dv2数据集进行测试。结果显示,在8位精度(W8A8)的设置下,QuantVGGT几乎完美保持了原始模型的性能,准确率保持在99.9%以上。更令人印象深刻的是,即使在更加激进的4位精度(W4A4)设置下,QuantVGGT仍然能够保持原始模型98%的性能。相比之下,其他现有的量化方法在4位精度下的性能都出现了显著下降,比如目前最先进的Quarot方法只能达到81.6的准确率,而QuantVGGT达到了88.2。

在点云地图生成任务中,研究团队使用DTU数据集进行了测试。令人惊喜的是,在某些指标上,8位精度的QuantVGGT甚至比原始的全精度模型表现更好。在4位精度下,虽然性能有所下降,但仍然远远超过其他量化方法。例如,在准确度指标上,Quarot方法只能达到1.593,而QuantVGGT达到了1.282,非常接近原始模型的1.185。

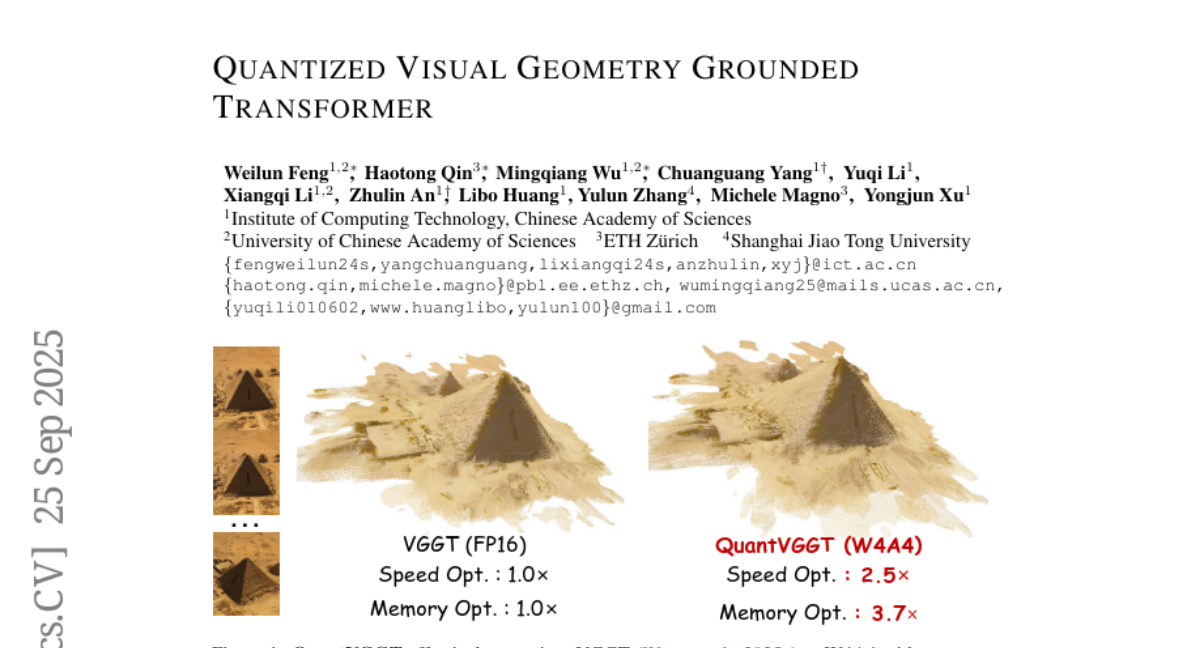

除了性能保持优异外,QuantVGGT在实际部署效率方面的表现更加令人振奋。在4位精度设置下,模型的内存占用减少了75%(压缩比达到3.7倍),推理速度提升了2.5倍。这意味着原本需要高端服务器才能运行的模型,现在可以在普通的消费级设备上流畅运行。

为了更深入地理解各个技术组件的贡献,研究团队还进行了详细的消融实验。他们发现,单独使用旋转或缩放技术虽然都能带来一定的改善,但只有将两者结合使用才能达到最佳效果。在校准数据选择方面,他们比较了随机采样、过滤采样、聚类采样等不同策略,结果表明他们提出的噪声过滤多样化采样策略不仅能提高平均性能,还能显著减少结果的波动性,使模型表现更加稳定可靠。

研究团队还特别关注了方法的计算开销问题。他们发现,相比于简单的量化方法,QuantVGGT只增加了0.2%的推理延迟,这个额外开销几乎可以忽略不计。在校准阶段,整个过程只需要大约2.67小时,就能在消费级GPU(如RTX4090)上完成,而额外的内存开销仅为0.02GB。

这项研究的意义远不止于技术层面的突破。在实际应用中,3D重建技术有着广泛的应用前景。在虚拟现实和增强现实领域,高效的3D重建能够让用户更快速地创建沉浸式体验。在自动驾驶汽车中,实时的3D场景理解对于安全导航至关重要。在文物保护和建筑设计领域,精确的3D重建能够帮助专家更好地分析和记录重要文化遗产。

从技术发展的角度来看,QuantVGGT代表了模型压缩技术在3D视觉领域的重要进展。以往的量化技术主要针对2D图像处理或自然语言处理任务进行优化,而3D重建任务的特殊性要求全新的技术路径。这项研究首次系统性地分析了大规模3D重建模型的量化难题,并提出了针对性的解决方案。

值得注意的是,这项研究还具有很强的通用性。虽然实验主要基于VGGT模型,但所提出的双重平滑精细量化和噪声过滤多样化采样技术原理上可以应用到其他类似的大规模3D视觉模型上。随着3D AI技术的快速发展,这套方法很可能成为该领域模型压缩的标准技术路线。

从工程实践的角度,QuantVGGT的成功也为AI模型的产业化部署提供了宝贵经验。它证明了通过精心设计的技术手段,可以在几乎不损失模型能力的前提下,显著降低部署成本和硬件要求。这对于推动AI技术从实验室走向实际应用具有重要意义。

不过,这项研究也有一些局限性需要进一步探索。目前的实验主要集中在特定的数据集和任务上,在更广泛的应用场景中的表现还需要更多验证。此外,虽然4位量化已经实现了很好的效果,但如何进一步降低到2位甚至1位精度,同时保持可接受的性能,仍然是一个开放的研究问题。

研究团队已经将QuantVGGT的代码开源,发布在GitHub平台上,为学术界和工业界的进一步研究提供了便利。这种开放的研究态度有助于加速整个领域的技术进步,让更多研究者能够在此基础上开发出更加优秀的解决方案。

说到底,QuantVGGT的成功表明,在AI技术快速发展的今天,仅仅追求模型性能的极致提升是不够的,如何让强大的AI能力真正服务于普通用户,成为了一个同样重要的技术挑战。中科院团队的这项研究为这个挑战提供了一个优雅的解决方案,让我们看到了AI技术普及化的更多可能性。有兴趣深入了解技术细节的读者可以通过arXiv:2509.21302v2查询完整的研究论文。

Q&A

Q1:QuantVGGT是什么?它解决了什么问题?

A:QuantVGGT是中科院团队开发的一种AI模型压缩技术,专门用于让庞大的3D重建模型"瘦身"。它解决的核心问题是VGGT这类12亿参数的3D重建AI模型太笨重,普通设备无法运行的问题。通过QuantVGGT技术,可以将模型体积压缩75%,速度提升2.5倍,同时保持98%的原始性能。

Q2:双重平滑精细量化技术是如何工作的?

A:双重平滑精细量化包含两个步骤。首先使用哈达玛德变换进行"全局搅拌",就像把蜂蜜均匀搅拌到水中一样,将极端数值分散到整个数据空间;然后进行"局部调理",为每个数据通道配置专门的缩放因子,让每个通道内部的数值分布都变得平滑合理。这样可以有效解决3D模型中数据分布不均的问题。

Q3:这项技术有什么实际应用价值?

A:QuantVGGT让原本需要高端服务器才能运行的3D重建AI可以在普通消费级设备上流畅运行,这为虚拟现实、增强现实、自动驾驶、文物保护等领域的应用普及铺平了道路。用户可以用普通手机或电脑就实现高质量的3D场景重建,而不需要昂贵的专业设备。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。