台湾交大团队用AI解决相机镜头眩光难题:让你的夜拍照片告别光斑困扰

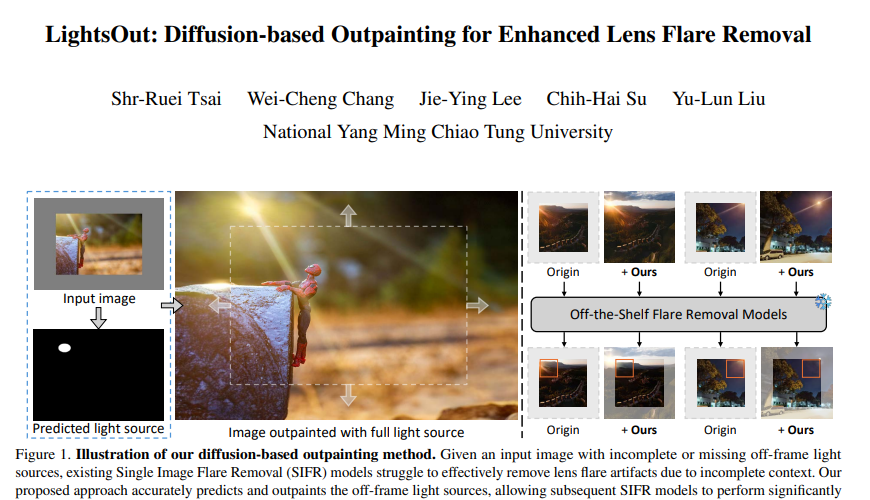

当你在夜晚或强光环境下拍照时,是否经常遇到照片中出现奇怪的光斑、光晕或条纹?这些让人头疼的现象在摄影界被称为镜头眩光。最近,台湾国立阳明交通大学的研究团队发表了一项突破性研究,他们开发出了一种名为"LightsOut"的AI技术,能够智能地修复这些讨厌的光斑问题。这项研究由蔡世瑞、张维成、李杰颖、苏志海和刘昱伦等研究人员共同完成,相关论文发表于2025年10月的arXiv预印本平台,论文编号为arXiv:2510.15868v1。

说到镜头眩光,这就像是相机的"近视眼"问题。当强烈的光源直射或间接照射到镜头时,光线在镜头内部的多个玻璃片之间反复折射和反射,最终在照片上形成各种形状的光斑、光晕或条纹。这种现象不仅会破坏照片的美观,更重要的是,它会严重影响自动驾驶汽车、安防监控等关键应用的准确性。

过去,研究人员已经开发出了多种去除镜头眩光的AI技术,这些技术就像是给照片做"美容手术",能够识别并消除大部分眩光痕迹。然而,这些现有方法有一个致命弱点:当照片中的光源不完整或者光源位于画面外部时,它们就像失去了"参照物"的医生一样,无法准确判断应该如何修复。

台湾交大的研究团队敏锐地发现了这个问题的核心所在。他们意识到,要想彻底解决眩光问题,不能仅仅专注于消除已有的光斑,而应该像侦探一样,先找到"案发现场"的完整信息——也就是那些造成眩光的光源到底在哪里,有多亮,范围有多大。

一、破解眩光之谜:为什么传统方法会"失明"

要理解这个问题,我们可以把拍照想象成在黑暗中用手电筒照明的过程。当手电筒的光束完全出现在照片中时,AI就能轻松识别光源的位置、强度和影响范围,从而准确地消除由此产生的眩光。但是,当手电筒只有一部分光束出现在画面中,或者手电筒完全在画面外部时,AI就像是只能看到案件的一部分线索的侦探,很难推断出完整的真相。

现有的单图像眩光去除技术,包括Zhou等人开发的方法、Flare7K++算法以及MFDNet网络,都遵循着"看到什么处理什么"的基本逻辑。它们在处理完整光源造成的眩光时表现出色,但面对不完整的光源信息时,就会出现"选择性失明"的问题。

研究团队通过大量实验发现,当照片中缺少完整的光源信息时,这些先进的AI算法的性能会显著下降。具体来说,在处理没有光源的场景时,图像质量评估指标PSNR(峰值信噪比)会从正常的28分降至26分,而感知质量指标LPIPS也会明显恶化。这种下降虽然在数字上看起来不大,但在实际应用中却意味着眩光残留、处理不彻底,甚至可能产生新的图像瑕疵。

二、LightsOut的三步走策略:像拼图一样重建完整画面

面对这个挑战,台湾交大的研究团队提出了一个巧妙的三步走解决方案,他们将整个过程比作侦探破案的完整流程。

第一步是"线索收集与分析"阶段。研究团队开发了一个多任务回归模块,这个模块就像一个经验丰富的侦探,能够仔细分析照片中的蛛丝马迹,推断出画面外部光源的可能位置、大小和亮度。这个模块的工作原理类似于我们在看到地面上的影子时能够推断出太阳的位置一样。

具体来说,这个模块会同时预测多个参数:光源的坐标位置(x, y)、光源的影响半径r,以及每个预测结果的可信度。由于真实场景中可能存在多个光源,系统被设计为能够同时预测最多4个光源的参数。为了确保预测的准确性,研究团队还引入了一个置信度评估机制,就像给每个推断结果打分一样,只有高分的预测才会被采用。

第二步是"场景重建"阶段。有了第一步的分析结果,系统开始像拼图一样重建完整的画面。这一步使用了基于扩散模型的外绘技术,这种技术就像是一个艺术大师,能够根据现有的画面内容,合理地"想象"并绘制出画面外部应该存在的内容。

研究团队在这一步中做了一个关键的技术创新:他们使用LoRA(低秩适应)技术对预训练的Stable Diffusion模型进行了专门的微调。这个过程就像是给一个通才画家进行专业的"眩光处理"培训,让它专门擅长绘制与光源和眩光相关的内容。

为了确保生成的内容既真实又准确,研究团队还开发了一个光源条件模块。这个模块的作用就像是给画家提供详细的作画指导,确保生成的光源位置、强度和效果都符合物理规律。

第三步是"最终修复"阶段。当完整的画面(包括原有内容和AI生成的外部区域)准备就绪后,现有的眩光去除算法就能发挥出它们的真正实力。这就像是给医生提供了完整的病历资料后,手术就能进行得更加精准和彻底。

三、技术创新的核心:让AI学会"脑补"

LightsOut技术的核心创新在于解决了AI的"想象力"问题。传统的图像修复技术只能处理看得见的内容,而LightsOut让AI学会了基于有限信息进行合理推断和补全。

在多任务回归模块的设计中,研究团队采用了一种类似于"专家会诊"的策略。系统不是简单地预测光源位置,而是同时预测位置、大小、亮度以及预测的可靠性。这种设计就像是让多个专家从不同角度分析同一个问题,然后综合所有意见得出最可靠的结论。

为了训练这个模块,研究团队使用了一种巧妙的损失函数设计。他们将预测任务分解为位置预测和置信度预测两个子任务,并使用不确定性加权机制来平衡这两个任务的重要性。这种方法就像是在训练一个学生时,不仅要求他给出答案,还要求他说明对答案的确信程度,从而培养更加谨慎和准确的判断能力。

在扩散模型的微调过程中,研究团队采用了LoRA技术,这是一种高效的模型适应方法。LoRA的工作原理类似于在原有的神经网络中插入一些"小抄",这些小抄包含了专门处理眩光问题的知识,而不需要重新训练整个巨大的模型。这种方法既保持了原模型的通用能力,又增加了专门的眩光处理技能。

噪声重注入技术是另一个关键创新。在扩散模型的去噪过程中,研究团队发现直接在潜在空间进行图像合成会导致生成区域和原始区域之间出现不自然的边界。为了解决这个问题,他们开发了一种噪声重注入策略,就像是在拼图过程中反复调整边缘pieces的位置,直到整幅图画看起来完全自然为止。

四、实验验证:数字说话的说服力

为了验证LightsOut技术的有效性,研究团队进行了大量的对比实验。他们使用Flare7K数据集作为测试平台,这个数据集包含了100张真实照片和100张合成照片,涵盖了各种复杂的眩光场景。

实验结果显示,LightsOut技术在所有测试场景中都显著提升了现有眩光去除方法的性能。以Flare7K++算法为例,在处理没有光源的真实图像时,PSNR指标从原来的26.29dB提升到了28.41dB,这相当于图像质量提升了约8%。更重要的是,感知质量指标LPIPS从0.0442改善到了0.0397,意味着处理后的图像在人眼看来更加自然和真实。

研究团队还特别测试了他们的光源预测模块的准确性。通过与传统的U-Net方法进行对比,他们发现多任务回归模块在光源定位的准确率上有显著优势。在真实图像测试中,mIoU(平均交并比)指标达到了0.6310,而U-Net方法只有0.6216。这个差异看似微小,但在实际应用中却意味着更准确的光源定位和更好的眩光去除效果。

为了验证技术的通用性,研究团队将LightsOut作为预处理步骤,分别与Zhou等人的方法、Flare7K++算法以及MFDNet网络进行了结合测试。结果表明,无论与哪种现有方法结合,LightsOut都能带来一致的性能提升,这证明了该技术的即插即用特性和广泛适用性。

五、消融实验:每个组件都至关重要

为了深入理解LightsOut技术中各个组件的贡献,研究团队进行了详细的消融实验。这些实验就像是拆解一台复杂机器,检查每个零件的作用。

噪声重注入机制的重要性通过对比实验得到了明确证实。当移除这个机制时,PSNR指标会下降约0.13dB,LPIPS指标会恶化0.0015。虽然这些数字看起来很小,但在图像处理领域,这样的差异足以影响最终的视觉效果。

RGB空间合成与潜在空间合成的对比实验揭示了另一个重要发现。研究团队发现,在RGB空间进行图像合成能够获得更好的结果,PSNR提升了0.18dB。这个发现颠覆了传统观念,证明了有时候看似简单的方法反而能够取得更好的效果。

LoRA微调技术的有效性也得到了验证。通过对比使用和不使用LoRA微调的结果,研究团队发现微调能够带来约0.30dB的PSNR提升。这证明了专门训练的重要性,就像专业的眼科医生在处理眼部疾病时比全科医生更有优势一样。

六、实际应用的广阔前景

LightsOut技术的意义远超学术研究范畴,它在实际应用中具有广阔的前景。在自动驾驶领域,夜间行驶时车载摄像头经常会受到对面车辆大灯或路灯的干扰,产生严重的镜头眩光。这些眩光可能会让AI系统误判路况,造成安全隐患。LightsOut技术能够有效清除这些干扰,提高自动驾驶系统的可靠性。

在安防监控领域,夜间监控摄像头同样面临着眩光干扰的问题。强烈的路灯或车灯可能会让关键区域变得模糊不清,影响安全监控的效果。LightsOut技术的应用能够确保监控画面的清晰度,提高安防系统的有效性。

对于普通摄影爱好者来说,这项技术同样具有重要价值。许多珍贵的照片因为镜头眩光而无法完美呈现,LightsOut技术能够让这些照片重新焕发光彩。特别是在夜景摄影、演唱会拍摄、婚礼摄影等场景中,这项技术能够大大提升照片的质量。

更重要的是,LightsOut技术的即插即用特性意味着它可以轻松集成到现有的各种图像处理软件和硬件系统中,无需大规模的系统改造就能享受到技术升级带来的好处。

说到底,台湾交大团队的这项研究解决的是一个看似简单却极其重要的问题。他们没有试图发明全新的眩光去除算法,而是巧妙地解决了现有算法的"盲点"问题。这种"补短板"式的创新思路值得我们深思:有时候,最大的突破不一定来自于全盘推翻重来,而可能来自于对现有方案薄弱环节的精准改进。

LightsOut技术的成功也展示了AI在解决实际问题时的巨大潜力。通过让AI学会"脑补"缺失的信息,研究团队实际上是在教会机器进行类似人类的逻辑推理。当我们看到部分光源时,大脑能够自然地推断出完整的光源信息,现在AI也具备了这种能力。

这项研究的另一个启发是团队合作的重要性。五位研究人员分别在不同的技术领域有所专长,他们的合作让这个复杂的技术方案得以顺利实现。从多任务回归到扩散模型微调,从噪声重注入到图像合成,每个环节都需要深厚的专业知识和精密的技术实现。

对于那些对这项技术感兴趣的读者,可以通过arXiv:2510.15868v1这个编号查找完整的技术论文。虽然论文中包含了大量的数学公式和技术细节,但研究团队承诺会将相关代码和模型开源,让更多的开发者和研究者能够在此基础上进一步改进和应用这项技术。

展望未来,LightsOut技术可能只是解决图像处理"残缺信息"问题的开始。随着AI技术的不断发展,我们有理由相信,机器将会在更多领域学会像人类一样进行合理的推断和补全,从而在信息不完整的情况下也能做出准确的判断和处理。

Q&A

Q1:LightsOut技术具体是如何工作的?

A:LightsOut采用三步走策略来解决镜头眩光问题。首先通过多任务回归模块分析照片中的线索,推断出画面外光源的位置和强度;然后使用微调的扩散模型重建完整画面,补全缺失的光源信息;最后将完整画面交给现有的眩光去除算法进行最终处理。整个过程就像是先找到问题根源,再修复问题一样。

Q2:这项技术比现有的眩光去除方法强在哪里?

A:现有方法在光源不完整或位于画面外时效果很差,而LightsOut技术能够智能推断并补全缺失的光源信息。实验显示,结合LightsOut后,现有算法的图像质量指标PSNR能够提升约8%,处理效果明显更好。关键是它可以作为预处理步骤与任何现有方法结合使用。

Q3:普通用户什么时候能用上这项技术?

A:研究团队承诺将相关代码和模型开源,开发者可以基于此开发应用软件。预计这项技术会首先在专业图像处理软件中出现,然后逐步普及到手机摄影应用中。由于其即插即用的特性,集成到现有系统中相对简单,普通用户有望在不久的将来通过各种摄影应用体验到这项技术。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。