伊利诺伊大学与谷歌联手:AI如何让视频合成像"拆积木再拼装"一样自然

这项由伊利诺伊大学香槟分校的欧兹古尔·卡拉(Ozgur Kara)与谷歌团队(包括陈宇佳、杨明轩、朱文胜、杜川等研究人员)共同完成的突破性研究,发表于2025年11月的《计算机视觉与模式识别》(CVPR)会议。感兴趣的读者可以通过论文编号arXiv:2511.20809v1查询完整研究内容。

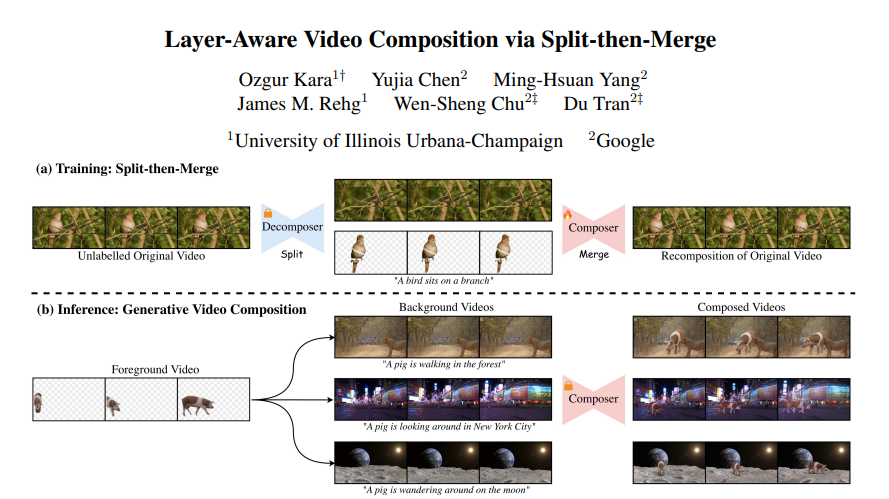

如果说现在的视频制作就像在厨房里做菜,那传统方法就是把所有食材混在一锅里炖煮,很难控制每种味道。而这项研究提出的"分离然后合并"(Split-then-Merge,简称StM)技术,就像是教会了AI先把每种食材分别处理好,然后再巧妙地组合在一起,做出既保持原味又和谐统一的美食。

这项研究要解决的核心问题其实我们在日常生活中经常遇到:当你想把一个视频中的人物或动物"搬到"另一个完全不同的场景中时,如何让这种合成看起来既自然又符合物理常识?比如,把一只在森林里奔跑的小猪放到纽约街头或者月球表面,不仅要让小猪的动作保持原样,还要让它看起来真的属于那个新环境——有合适的阴影、符合场景的光线,甚至要"知道"应该在人行道上跑而不是悬浮在空中。

过去的视频合成方法就像用胶水简单地把两张照片贴在一起——要么只能处理静态图片然后试图"想象"出动作,要么就是生硬地复制粘贴,完全不考虑新环境的特点。研究团队通过大量实验发现,即使是最先进的现有方法也存在严重缺陷:有些会让黑天鹅莫名其妙变成白天鹅,有些会把本该在水中游泳的天鹅放到陆地上,还有些干脆忽略了原始视频中的精彩动作。

一、革命性的"先拆解后组装"理念

研究团队的核心洞察就像一个经验丰富的厨师发现的秘诀:要做出完美的菜肴,最好的方法不是从零开始创造,而是先学会如何分解已有的美味佳肴,理解每种食材的作用,然后掌握重新组合的艺术。

StM技术的工作原理可以想象成这样一个过程:当你面对一段视频时,系统首先像一个精准的外科医生一样,将视频"手术式"地分解成两个独立的层次——前景层(比如视频中的主要角色)和背景层(比如场景环境)。这个分解过程完全自动化,就像有一双无形的巧手能够精确地从蛋糕中取出每一颗葡萄干,而不损坏蛋糕本身的结构。

这种分解不是简单的剪切粘贴,而是一个智能化的理解过程。系统会自动识别视频中的运动主体,比如一只奔跑的猎豹或一个跳舞的人,然后用先进的AI算法为这个主体生成精确的遮罩。同时,它还会智能地"修复"前景被移除后留下的空白区域,就像PS高手能够无痕地删除照片中的路人一样。最后,系统还会为整个视频生成一段描述性的文字说明。

更令人惊叹的是,这个过程可以处理大规模的视频数据集,完全不需要人工标注或手动干预。研究团队利用这种方法处理了超过5万个视频片段,创建了迄今为止最大规模的多层视频数据集——StM-50K。这就像建立了一个巨大的"视频食材库",为后续的合成工作提供了丰富的素材基础。

二、智能合成器:掌握"重新组装"的艺术

有了分解好的"食材",下一步就是学会如何重新组装。研究团队开发的合成器(Composer)就像一位经验丰富的调酒师,能够将不同来源的"原料"调配成既保持各自特色又和谐统一的"鸡尾酒"。

合成器的工作原理建立在先进的扩散变换器(Diffusion Transformer)架构之上,但研究团队对其进行了三个关键的创新改进。

首先是多层条件融合技术。传统的视频生成方法往往只关注单一输入源,而这里采用的策略更像是一个三维拼图游戏。系统同时考虑三个视频输入:原始的完整视频、背景场景视频,以及经过特殊处理的前景视频。这些不同的信息在模型内部通过巧妙的通道级连接方式进行融合,确保每一个像素点都能同时"看到"所有相关的上下文信息。这就像一个指挥家能够同时听到交响乐团中每一种乐器的声音,然后协调它们产生和谐的音乐。

其次是变换感知的数据增强策略。为了防止AI走"捷径"——比如简单地记住物体应该放在画面的固定位置——研究团队设计了一套"训练障碍课程"。在训练过程中,系统会随机对前景物体进行各种变换:水平翻转、随机裁剪、缩放调整,甚至改变颜色属性。这迫使模型不能依赖简单的位置记忆,而必须真正理解物体与环境之间的关系。这就像训练一个厨师,不是让他死记硬背菜谱,而是让他在各种不同的厨房条件下都能做出美味的菜肴。

第三个创新是身份保持损失函数。传统的训练方法对画面的每个区域都一视同仁,但这往往导致前景物体的特征在合成过程中被"稀释"或改变。新的方法就像给不同区域分配了不同的"重要性权重":对于前景区域,重点确保物体的外观和动作特征得到完整保留;对于背景区域,则重点关注与前景的和谐融合。这种精细化的控制机制确保了最终结果既保持了原始素材的真实性,又实现了自然的视觉融合。

三、突破传统方法的技术壁垒

为了真正理解这项技术的先进性,我们需要看看它与现有方法的根本区别。

传统的视频合成方法主要分为两大类,都存在显著局限性。第一类是"图片转视频"的级联方法,这些方法的工作流程就像先画一张静态的设计图,然后试图根据想象为它添加动画效果。比如,它们会先将两个视频的第一帧进行图像合成,得到一张静态图片,然后使用图像到视频的生成模型来"猜测"应该如何让这张图片动起来。这种方法的问题就像让一个从来没见过跑步的人描述奔跑的动作——因为完全丢失了原始视频中的运动信息,生成的动画往往僵硬不自然,或者与原始动作相去甚远。

第二类方法虽然能处理完整的视频输入,但却像一个不懂物理常识的搬运工。这些方法可能会机械地将一只天鹅放到草地上,完全不理解天鹅应该在水中;或者在处理过程中改变物体的基本特征,让黑天鹅变成白天鹅。更有甚者,一些方法在生成过程中会产生运动和外观的"漂移",就像复印机复印多次后图像逐渐模糊失真一样。

研究团队通过大量对比实验验证了StM技术的优越性。在定量评估中,他们使用了四个关键指标来衡量合成质量:身份保持度(衡量前景和背景的外观一致性)、语义动作对齐度(评估前景动作的保真度)、背景运动对齐度(评估相机和场景动态的保持程度)以及文本对齐度(衡量结果与描述文本的匹配程度)。

结果显示,StM在几乎所有关键指标上都显著优于现有方法。特别在运动保持方面,传统的图像转视频方法由于丢失了原始运动信息,在背景运动对齐度上的得分普遍在74到279之间,而StM的得分仅为16.36,数值越低表示性能越好。这意味着StM能够近乎完美地保持原始视频的相机运动和场景动态。

四、让AI理解"常识":情境感知能力的培养

StM技术最令人印象深刻的特性之一就是它的"情境感知"能力,这就像培养一个AI助手不仅知道如何执行任务,还能理解什么样的执行方式是合理的。

这种能力的培养主要通过变换感知训练实现。在传统训练方法中,AI往往会学会一些看似聪明实则偷懒的"捷径"。比如,如果训练数据中的动物总是出现在画面中央,AI可能就会简单地记住"把动物放在中间就对了",而不是真正理解动物与环境的关系。

为了打破这种惰性学习,研究团队设计了一套"刻意练习"方案。在训练过程中,系统会故意对前景物体进行各种随机变换:有时水平翻转,有时随机裁剪,有时调整尺寸,有时改变色调。这就像训练一个象棋选手,不是让他只记住开局定式,而是让他在各种不同的棋局中都能找到最佳走法。

通过这种训练方式,AI逐渐学会了真正的"情境理解"。当它看到一只天鹅时,不是机械地将其放置在固定位置,而是会根据背景环境做出合理判断:如果背景是湖泊,就让天鹅在水中优雅游弋;如果背景是草地,就可能让天鹅在陆地上行走。同样,当处理一辆汽车时,AI会自然地让它行驶在道路上而不是漂浮在空中,并且会根据环境光线调整车体的阴影和反射。

这种情境感知能力在实际应用中表现得淋漓尽致。比如,在一个展示案例中,系统成功将一只在森林中奔跑的小猪合成到三个完全不同的环境中:乡村道路、纽约街头和月球表面。在每种情况下,小猪不仅保持了原有的奔跑动作,还展现出了与新环境相适应的细节:在乡村道路上有自然的泥土阴影,在纽约街头有城市光线的反射效果,在月球表面则呈现出低重力环境下的特殊运动感觉。

五、从数据沙漠到绿洲:StM-50K数据集的创建

传统的视频合成研究面临一个严重问题:缺乏高质量的训练数据。这就像想要开办一所烹饪学校,却没有足够的食材供学生练习。大多数现有数据集要么规模太小,要么需要大量人工标注,这极大地限制了AI模型的学习能力。

研究团队的解决方案就像发明了一台自动化的"食材处理机"。他们开发的分解器(Decomposer)能够自动处理大规模的无标注视频数据,将其转换成适合训练的多层格式。这个过程包含几个精巧的步骤。

首先,系统使用先进的视频-语言模型为每个视频生成描述性文本标题,这就像为每道菜品写一份详细的菜单说明。然后,运动分割模型会自动识别和提取视频中的主要运动主体,生成精确的前景遮罩。这个过程不是简单的物体检测,而是基于运动模式的智能分析,能够准确区分真正重要的前景元素。

最后,也是最具挑战性的步骤,是背景修复。当前景被移除后,原始视频中会留下"空洞",就像从拼图中取走几块后留下的空白区域。系统使用最先进的视频修复算法来填补这些空白,不是简单地用周围的像素进行模糊填充,而是智能地推测和重建被遮挡的背景内容。这个过程需要理解场景的几何结构、纹理模式和时间连续性,确保修复后的背景看起来既自然又连贯。

通过这套自动化流程,研究团队处理了来自多个数据源的视频:对于Panda-70M和Animal Kingdom等未标注的大规模数据集,应用完整的分解流程;对于YouTube-VOS和LVOS等已有标注的数据集,则利用现有的前景遮罩信息,重点进行背景修复和文本生成。最终创建的StM-50K数据集包含约5万个视频片段,每个片段都包含完整的四层信息:原始视频、前景视频、前景遮罩和背景视频,以及对应的文本描述。

六、训练智慧:身份保持与和谐融合的平衡艺术

训练一个能够完美平衡身份保持和环境融合的AI模型,就像教一位演员既要保持自己的表演风格,又要完美融入不同的戏剧场景。这需要一套精巧的训练策略。

传统的训练方法通常采用"一刀切"的损失函数,对画面的每个区域给予相同的重视程度。但这种方法在视频合成任务中容易产生问题:如果过分强调整体和谐,前景物体的独特特征可能被削弱或改变;如果过分保持前景身份,整体画面可能看起来不协调,像是简单的拼贴作品。

研究团队设计的身份保持损失函数就像一个精明的导演,能够同时关注演员的个人表现和整体戏剧效果。这个函数将画面分为两个区域:前景区域和背景区域,并为每个区域设置不同的优化目标。

对于前景区域,损失函数主要关注身份一致性,确保合成后的物体在外观、动作和特征方面与原始前景高度一致。这就像确保一位明星演员无论出现在哪个场景中,都能保持其独特的表演风格和人格魅力。同时,系统还会特别关注动作的连续性和自然性,防止在合成过程中出现动作扭曲或不协调的情况。

对于背景区域,损失函数则重点关注融合的自然性。这包括光照的一致性、阴影的合理性、以及前景与背景之间的交互效果。比如,如果一个人在沙滩上行走,系统不仅要保持这个人的步态特征,还要确保脚印、阴影和光线反射等细节都符合沙滩环境的特点。

更重要的是,这两个损失项之间的权重是可调节的,允许根据具体应用场景的需求进行微调。当应用重点是角色表演时,可以增加前景损失的权重;当应用重点是场景融合时,可以增加背景损失的权重。这种灵活性使得StM技术能够适应各种不同的创作需求。

七、全面验证:从算法评估到人类感知

为了全面验证StM技术的有效性,研究团队设计了一套多维度的评估体系,就像为一款新产品设计全面的质量检测方案。

定量评估部分采用了四个核心指标。身份保持度通过计算原始输入层与分离输出层之间的ViCLIP嵌入相似性来衡量,分别评估前景和背景的视觉身份一致性。语义动作对齐度使用Video Swin模型分析前景的动作概率分布,通过KL散度来衡量输入和输出动作的一致性。背景运动对齐度通过光流场的均方误差来评估相机运动和场景动态的保持程度。文本对齐度则衡量最终合成视频与指导文本之间的语义匹配程度。

在所有定量指标中,StM都展现出了显著优势。特别值得注意的是在运动保持方面的表现:传统的图像转视频方法由于缺失原始运动信息,在背景运动对齐度上的得分通常在74-279之间,而StM仅为16.36,这意味着它能够近乎完美地保持原始视频的动态特征。

定性评估则采用了人类用户研究和大型视觉语言模型评估相结合的方法。研究团队在Prolific平台招募了50名评估者,对随机选择的25个测试样本进行成对比较。评估者需要根据五个维度对StM与各基线方法进行比较:前景和背景的身份保持度、前景和背景的运动对齐度、前景与背景的和谐性,以及整体视觉质量。

用户研究的结果令人印象深刻。在大多数比较中,StM的胜率都超过了70%,在某些维度上甚至达到90%以上。特别是在运动保持和身份一致性方面,StM显示出压倒性的优势,这验证了其核心设计理念的有效性。

为了进一步确保评估的客观性和规模化,研究团队还使用了Gemini 2.5 Pro作为自动化评审,对完整的测试数据集进行评估。有趣的是,AI评审的结果与人类评估者高度一致,这不仅验证了StM技术的优越性,也表明了评估方法的可靠性。

八、深入解析:关键组件的作用机制

为了更好地理解StM技术的有效性,研究团队进行了详细的消融研究,就像拆解一台精密仪器来了解每个零件的作用。

首先是变换感知数据增强的作用。当移除这个组件时,模型倾向于学习"复制粘贴"的捷径策略,虽然在前景身份保持方面得分很高(90.39),但这实际上是一种虚假的优势,因为模型只是机械地记住了前景物体的位置,而没有真正学会合成。这种捷径学习在背景运动对齐度上表现较差(18.59),说明模型无法很好地处理动态环境。

其次是身份保持损失函数的重要性。当移除这个组件时,虽然变换感知增强迫使模型进行真正的合成,但缺乏精细化的区域权重控制,导致前景身份保持度下降到82.01,背景运动对齐度也恶化到23.75。这表明精细化的损失函数设计对于平衡不同目标确实至关重要。

完整的StM模型结合了两个组件的优势:通过变换感知增强避免了捷径学习,通过身份保持损失实现了最佳的平衡点。虽然在某些单一指标上可能不是绝对最优,但在综合性能上达到了最佳的平衡,这正是实际应用中最需要的特质。

九、实际应用展示:从概念到现实

研究团队通过大量的实际案例展示了StM技术的强大能力和广泛适用性。这些案例就像一系列精彩的魔术表演,每一个都展现出技术的不同侧面。

在一个令人印象深刻的案例中,系统成功地将一只在草地上奔跑的山羊合成到了三个截然不同的环境中:森林小径、城市街道和海滩。在每种环境下,山羊不仅保持了原有的奔跑姿态和速度节奏,还展现出了与环境相匹配的细节效果。在森林环境中,阳光透过树叶在山羊身上形成斑驳的光影;在城市环境中,建筑物的反射光线让山羊的毛色呈现出不同的色调;在海滩环境中,海风似乎吹拂着山羊的毛发,整体画面充满了海边特有的明亮氛围。

另一个展示情境感知能力的精彩案例是船只的合成。当将一艘小船从平静的湖面合成到波涛汹涌的海面时,系统不仅调整了船只的姿态以匹配海浪的起伏,还巧妙地修改了船身在水中的深度和周围水花的形态。这种细致入微的调整体现了系统对物理规律的深度理解,就像一个经验丰富的电影特效师能够准确把握不同环境下物体的表现方式。

在动物合成方面,系统展现了对生物行为的精确理解。当将一只天鹅从陆地环境合成到水面环境时,系统不仅改变了天鹅的姿态——从陆地行走姿势转为水面游泳姿势——还添加了水波纹理、倒影效果和符合水面环境的光线反射。这种变化不是简单的图像叠加,而是基于对天鹅自然行为的深度理解。

人物合成案例则展示了系统处理复杂人体动作的能力。在一个网球运动员的合成案例中,系统将一个在室内练习场挥拍的运动员成功合成到了户外草地球场。不仅运动员的挥拍动作得到了完美保持,连细微的身体重心转移、肌肉紧张状态都保持了原有的真实感。同时,系统还根据户外环境的特点调整了光照效果,添加了草地上的阴影,甚至考虑了风力对运动员服装的影响。

十、技术实现与计算效率

StM技术的另一个重要优势在于其高效的计算架构设计,这就像设计一台既强大又节能的机器。

在训练阶段,研究团队采用了基于CogVideoX-I2V模型的架构,这是一个已经在大规模数据上预训练的强大基础模型。通过迁移学习的方式,StM在这个稳固基础上添加了专门的组件,而不是从零开始构建整个系统。这种设计策略大大减少了训练所需的计算资源和时间。

训练过程在16张NVIDIA H100 GPU上进行,总批次大小为64,使用了混合精度训练技术来进一步提高效率。整个训练过程需要2万次迭代,相比从头训练一个视频生成模型,这个训练周期相对较短。训练采用了AdamW优化器,配合余弦学习率调度策略,确保了训练过程的稳定性和收敛性。

在推理阶段,StM的计算效率表现尤为突出。由于系统严格保持了基础模型的架构,仅在输入阶段添加了轻量级的投影层,因此推理过程的计算复杂度与原始I2V模型几乎相同。这意味着用户能够以接近传统图像到视频生成的速度获得更高质量的视频合成结果。

唯一的额外计算开销来自于对多个视频层的编码过程,但这是一次性的预处理步骤,在实际的迭代去噪过程中不会产生额外负担。这种设计使得StM技术具有很强的实用性,可以在相对普通的硬件条件下实现高质量的视频合成。

十一、局限性与未来发展方向

正如任何突破性技术都有其发展边界,StM技术也存在一些当前阶段的局限性,这为未来的研究指明了方向。

最主要的局限来自于设计理念上的权衡。StM技术被设计为优先保持输入视频的运动和外观特征,这有时会以牺牲对文本描述的严格遵循为代价。在定量评估中可以看到,纯文本驱动的基线方法在文本对齐度上得分更高,而StM在这个指标上相对较低。这反映了一个根本性的设计选择:是优先保持视觉输入的真实性,还是优先满足文本描述的要求?

研究团队选择了前者,认为在大多数实际应用场景中,用户更希望保持原始视频素材的特色和魅力,而不是完全按照文本描述重新创造内容。但这确实意味着,在某些特别强调语义控制的应用中,StM可能需要进一步的改进。

另一个局限性来自于对分解器质量的依赖。StM的整体性能在很大程度上依赖于运动分割和视频修复等预处理步骤的质量。如果分解器在提取前景遮罩时出现错误,或者在背景修复时产生瑕疵,这些问题会被传递到最终的合成结果中。虽然合成器具有一定的容错能力,但它无法完全补偿前期处理中的重大错误。

从计算资源的角度来看,虽然推理阶段相对高效,但训练阶段仍然需要相当规模的计算资源。变换感知训练管道需要同时处理多个视频输入的编码,这在训练阶段会产生较大的内存和计算开销。对于资源受限的研究团队或个人开发者,这可能构成一定的门槛。

展望未来,研究团队指出了几个有前景的发展方向。首先是探索动态权重平衡机制,能够根据具体应用场景自动调整视觉保真度和语义控制之间的平衡。其次是改进分解器的鲁棒性,特别是在处理复杂场景和多主体视频时的表现。最后是探索更加高效的训练策略,可能通过知识蒸馏或参数高效微调技术来降低训练成本。

归根结底,这项由伊利诺伊大学香槟分校与谷歌联合开展的研究为视频合成领域带来了一个全新的解决方案。StM技术就像是视频制作工具箱中的一把精密瑞士军刀,不仅能够处理复杂的合成任务,还能保持结果的自然性和真实感。更重要的是,它开创了一种全新的思路:通过大规模自动化的数据处理来解决训练数据稀缺的问题,这种方法论很可能会影响整个AI视频生成领域的发展方向。

虽然技术还有改进空间,但StM已经展现出了在电影制作、广告创意、教育内容制作等领域的巨大应用潜力。随着技术的不断完善和计算资源的普及,我们有理由期待看到更多基于这种"分离然后合并"理念的创新应用,让视频创作变得更加灵活、高效和富有创意。

Q&A

Q1:Split-then-Merge技术相比传统视频合成有什么优势?

A:StM技术最大的优势是能够同时保持原始视频的动作特征和实现智能的环境适应。传统方法要么只能处理静态图像然后"猜测"动作,要么机械地复制粘贴而忽略物理常识。StM就像一个既懂得保持角色本色又能融入新环境的演员,能让一只在森林奔跑的小猪自然地适应纽约街头或月球表面,既保持原有动作又有合适的阴影和光照效果。

Q2:StM-50K数据集是怎么创建的?

A:研究团队开发了一套完全自动化的"分解器",就像一台智能的视频处理机。它能自动将普通视频分解成前景主体、背景场景和文字描述三个部分,无需人工标注。系统先用AI识别视频中的运动主体并生成精确遮罩,然后智能修复背景中的空白区域,最后生成描述文本。通过处理5万个视频片段,创建了目前最大规模的多层视频数据集。

Q3:普通用户什么时候能用上这种视频合成技术?

A:目前StM还是研究阶段的技术,但其核心理念和方法已经为商业化应用奠定了基础。考虑到技术的计算效率较高,推理速度接近传统方法,预计在硬件进一步普及和算法优化后,可能会首先出现在专业视频制作软件中,然后逐步普及到消费级应用。不过具体的商业化时间表还需要看产业界的技术转化进度。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。