超越简单描述:浙江大学研究团队为机器人打造"动作理解教科书"

这项由浙江大学刘大勇教授与三一重工AI团队等多家机构合作的研究发表于2025年11月的计算机视觉顶级会议,论文编号为arXiv:2511.18685v1。有兴趣深入了解的读者可以通过该编号查询完整论文。

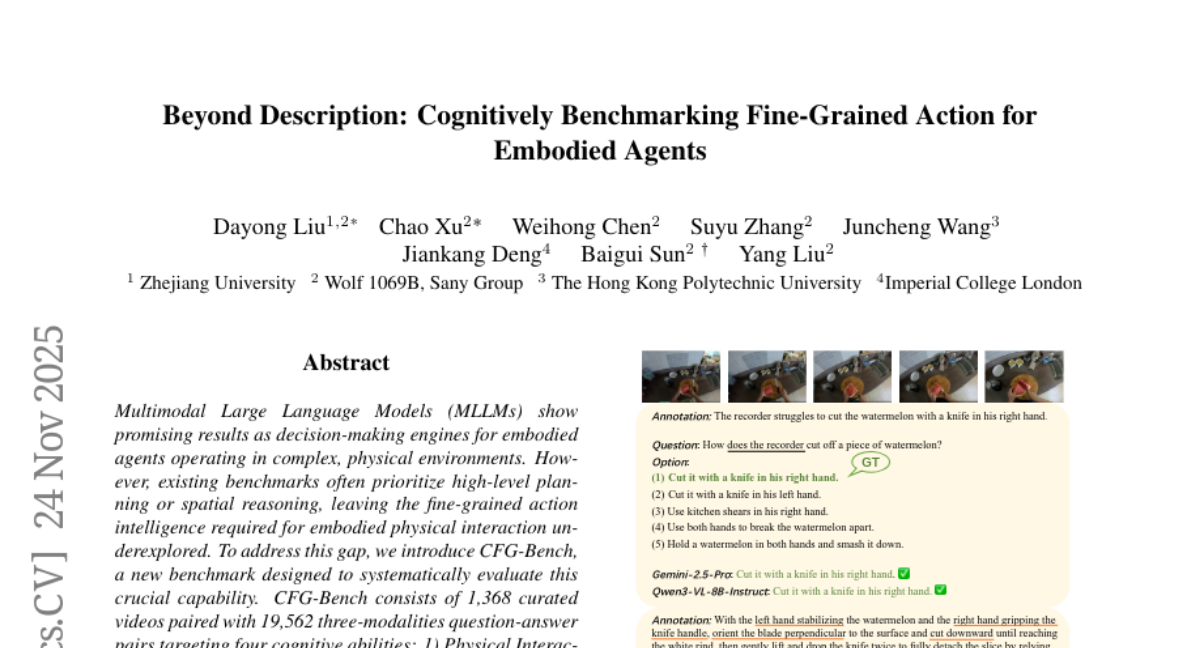

当我们看到一个人切西瓜时,我们不仅能看出"他在切西瓜",还能观察到更多细节:左手如何稳定西瓜,右手怎样握刀,刀刃如何垂直接触表面,甚至还能理解为什么要先轻压再用力,以及这种切法是否高效。这种对动作细节的深度理解正是机器人最欠缺的能力。

目前的AI大模型虽然能够识别视频中的基本动作,但它们就像只会说"有人在切西瓜"的观察者,无法理解切西瓜这个动作背后的精妙操作技巧。研究团队发现,这种缺陷严重限制了机器人在真实世界中的表现能力。当机器人需要完成复杂的物理操作时,仅仅知道"要做什么"是远远不够的,它们必须理解"如何做"和"为什么这样做"。

为了解决这个根本性问题,研究团队创建了一个名为CFG-Bench的全新评估体系。这个体系就像一本专门为机器人设计的"动作理解教科书",包含了1368个精心挑选的视频片段和19562组问答对,覆盖了从简单的日常动作到复杂的户外活动。

CFG-Bench的核心创新在于它建立了一个四层递进的认知框架,就像教孩子学习动作一样循序渐进。第一层是"物理交互",教会AI观察动作的具体执行细节,比如用哪只手、握住物体的哪个部位、以什么样的力度和方向进行操作。这就像教孩子观察大人如何正确握筷子一样。

第二层是"时间因果关系",让AI理解动作之间的先后顺序和因果联系。继续以切西瓜为例,AI需要明白为什么要先稳定西瓜再切割,以及每个步骤如何影响下一个步骤。这种理解对于机器人执行多步骤任务至关重要。

第三层是"意图理解",这要求AI能够推断动作背后的目的。当看到有人轻轻敲击西瓜时,AI需要理解这不是在切西瓜,而是在测试西瓜的成熟度。这种理解能力帮助机器人在面对新情况时做出合理的决策。

第四层是"评估判断",这是最高级的能力,要求AI能够评价动作的质量和效果。就像一个经验丰富的厨师能够判断切菜技巧的优劣一样,机器人也需要具备这种评估能力来不断改进自己的动作。

在数据收集和标注过程中,研究团队采用了极其严格的标准。他们花费了整整一个月的时间,组织十位专业标注员对视频进行细致入微的分析。每个动作的描述都要精确到具体使用哪个手指、如何施力、动作的节奏等细节。这种精细程度远超以往任何相关研究。

更有趣的是,为了确保AI真正理解而不是简单记忆答案,研究团队设计了"反事实"问题。这些问题故意包含错误信息,比如问"你是如何用脚踩踏板来刷链条的",而实际视频中是用手转动踏板。只有真正理解动作的AI才能识别出问题中的错误并给出正确答案。

当研究团队用CFG-Bench测试当前最先进的AI模型时,结果令人震惊。即便是表现最好的Gemini-2.5-Pro模型,在开放式问题上的平均得分也只有5.4分(满分10分),而人类的平均得分达到了9.05分。这个巨大差距揭示了当前AI在精细动作理解方面的严重不足。

特别值得注意的是,AI模型在不同类型任务上的表现呈现出有趣的模式。它们在识别动作的直接后果方面表现相对较好,但在理解复杂的时间序列和全局目标方面却显得力不从心。这就像一个人能看出打鸡蛋会让鸡蛋破碎,但却无法理解整个做蛋糕的流程。

研究团队还发现了一个被称为"莫拉维克悖论"的现象在AI领域的体现:对人类来说简单的物理动作识别对AI来说却极其困难,而对人类来说复杂的抽象推理对AI来说相对容易。这解释了为什么现有AI能够进行复杂的文本推理,却在理解简单的物理操作时频频出错。

为了验证CFG-Bench的实用性,研究团队进行了一个令人印象深刻的实验。他们使用CFG-Bench的数据对Qwen2.5-VL模型进行了专门训练,然后在两个不同的机器人任务上进行测试。结果显示,经过训练的模型在高层规划任务上的性能提升了106%,在低层控制任务上的性能提升了59%。这证明了精细动作理解能力的提升确实能够直接改善机器人的实际表现。

更有意思的是,经过CFG-Bench训练的AI模型在描述视频时也表现出了明显的改进。原本只能给出"机械臂接近玻璃和瓶子,机械臂拿起瓶子,机械臂倾斜瓶子并将液体倒入玻璃"这样简单描述的模型,现在能够生成"机械手定位在画面左侧,慢慢向桌上的玻璃瓶移动,然后用手指夹住瓶子的把手,稍微抬起瓶子离开桌面,接着逆时针旋转瓶子使瓶嘴对准下方的玻璃,然后倾斜瓶子将液体倒入玻璃"这样详细且准确的描述。

在分析AI模型的错误模式时,研究团队发现了几个普遍存在的问题。首先是"细节遗漏",AI经常能识别出主要动作但漏掉关键的执行细节。其次是"同时动作理解困难",AI很难理解两只手或多个身体部位同时进行的协调动作。第三是"过度简化的启发式判断",AI倾向于基于表面现象做出判断,而不是深入理解动作的真实目的。最后是"积极偏见",AI在评估动作质量时倾向于只关注最终结果,而忽视执行过程中的问题。

这项研究的意义远不止于技术层面的突破。在日常生活中,我们期待机器人能够承担更多复杂的家务劳动,比如做饭、清洁、照顾老人等。这些任务都需要精细的动作理解和执行能力。CFG-Bench为开发这样的机器人提供了重要的评估工具和训练资源。

在工业领域,精确的动作理解能力对于自动化生产线同样至关重要。传统的工业机器人只能执行预编程的固定动作,而具备了精细动作理解能力的AI系统将能够适应更复杂和变化的生产环境。

从更广阔的视角来看,这项研究代表了AI发展的一个重要方向转变。过去几年,AI主要在语言和图像识别等感知任务上取得突破,而现在正向着更深层的理解和交互能力发展。CFG-Bench正是这种发展趋势的重要体现。

研究团队也坦诚地指出了当前工作的局限性。由于资源限制,他们无法对所有先进的商业模型进行全面测试。此外,虽然数据集涵盖了广泛的日常活动,但对于某些高度专业化的技能(如外科手术或精密加工)还需要进一步扩展。另外,当前的评估方式主要依赖于语言表达,而一些AI可能具备正确的理解但无法准确表达出来。

尽管存在这些局限,CFG-Bench已经为机器人和AI领域提供了一个重要的新工具。它不仅揭示了当前技术的不足,更为未来的改进指明了方向。随着越来越多的研究团队使用这个基准测试,我们可以期待机器人在精细动作理解方面的快速进步。

说到底,这项研究解决的是一个看似简单却极其重要的问题:如何让机器真正理解人类的动作。虽然我们距离拥有真正智能的家用机器人助手还有一段路要走,但CFG-Bench为我们提供了衡量进步的清晰标准。当有一天机器人能够完美通过这些测试时,它们也就具备了在真实世界中协助人类的基本能力。

对于普通人来说,这意味着未来的机器人将不再是笨拙的自动化设备,而是真正能够理解和学习人类动作的智能伙伴。它们将能够观察我们如何完成任务,理解我们的操作意图,甚至能够根据不同情况调整自己的动作方式。这种能力的实现,正是通过像CFG-Bench这样的研究一步步积累而来的。

Q&A

Q1:CFG-Bench是什么?

A:CFG-Bench是浙江大学研究团队开发的机器人动作理解评估体系,就像为机器人设计的"动作理解教科书"。它包含1368个视频和19562组问答对,通过四层递进框架(物理交互、时间因果、意图理解、评估判断)来测试AI是否真正理解人类动作的执行细节、先后顺序、背后目的和质量评估,而不仅仅是识别"在做什么"。

Q2:现在的AI模型在CFG-Bench上表现如何?

A:表现很不理想。最好的Gemini-2.5-Pro模型在开放式问题上只得到5.4分(满分10分),而人类平均得分达到9.05分。AI模型普遍存在细节遗漏、无法理解同时进行的协调动作、过度简化判断等问题。这说明当前AI在精细动作理解方面还有巨大提升空间。

Q3:CFG-Bench对机器人发展有什么实际意义?

A:实验证明用CFG-Bench训练的AI模型在实际机器人任务上性能显著提升,高层规划任务提升106%,低层控制任务提升59%。这意味着精细动作理解能力直接影响机器人的实际表现,为开发能够胜任复杂家务、工业生产等任务的智能机器人提供了重要评估工具和训练资源。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。