台湾大学等机构解决AI视频理解最大痛点:如何让机器准确描述视频内容而不胡编乱造

这项由台湾大学通讯工程学研究所的张凯波、郑维元等研究者,以及英伟达公司的王宇祥等专家联合完成的研究,发表于2025年12月的arXiv预印本平台。有兴趣深入了解的读者可以通过论文编号arXiv:2512.04356v1查询完整论文。

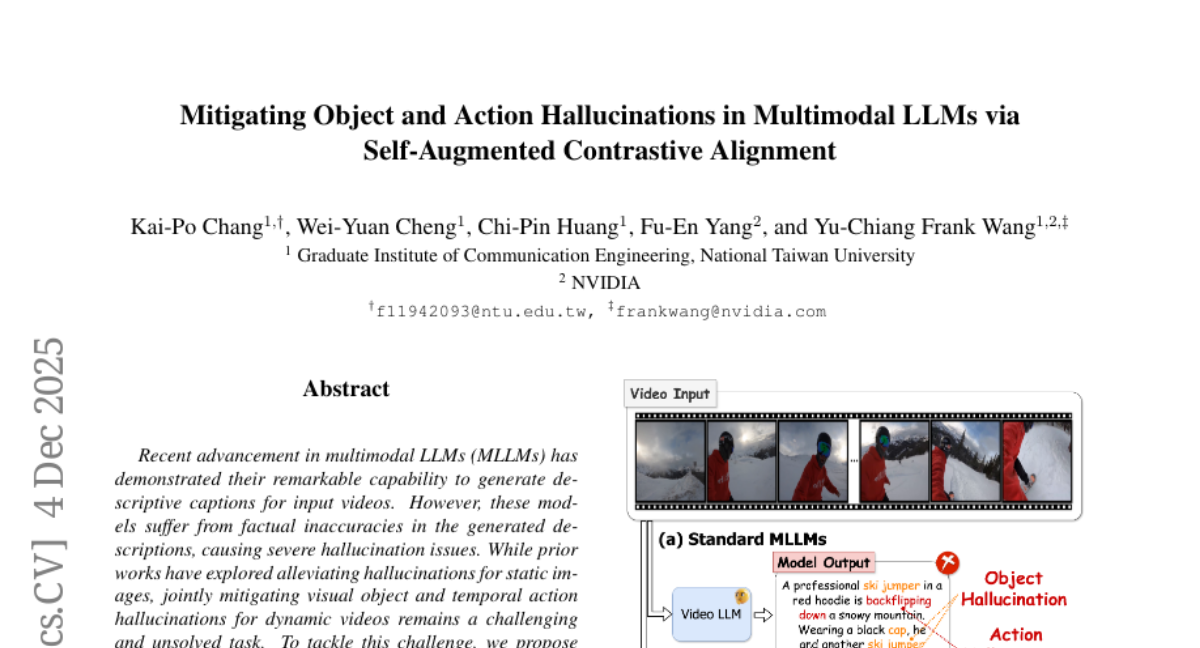

当我们看到一段视频时,能够准确描述其中的物体和动作似乎是理所当然的事情。但是对于人工智能来说,这个看似简单的任务却隐藏着巨大的挑战。目前的多模态大语言模型虽然能够生成流畅的视频描述,但经常出现严重的"幻觉"问题——也就是说,它们会描述视频中根本不存在的物体和动作。

考虑这样一个场景:当你要求AI描述一段滑雪视频时,它可能会告诉你视频中有人在跳伞,或者声称看到了根本不存在的雪橇。这种错误不仅仅是小问题,在医疗诊断或自动驾驶等需要高度准确性的领域,这样的错误可能带来严重后果。

传统的解决方案大多专注于静态图像的物体幻觉问题,但视频包含了时间维度,动作的准确识别成为了更加复杂的挑战。研究团队意识到,要解决这个问题,需要同时处理两个层面:一是让AI正确识别视频中的物体,二是准确理解这些物体之间的动作关系。

研究团队开发了一个名为SANTA的创新框架,这个名字代表"自增强对比对齐"。这个框架的核心思想类似于一个经验丰富的老师在纠正学生的错误:首先识别学生容易犯的错误类型,然后针对性地设计练习来纠正这些错误。

SANTA框架的第一个创新在于"幻觉性自增强"机制。这个机制的工作原理很像一个反面教材的收集器。当AI模型生成视频描述时,系统会故意让它选择那些虽然听起来合理但实际上错误的词汇。比如,当真实视频中有人在"站立"时,系统可能会记录下AI倾向于说成"坐着"的错误倾向。通过收集这些"反面教材",系统就能更好地理解AI容易在哪些地方出错。

更具体地说,这个过程就像制作一本"常见错误手册"。系统会让AI在每个生成步骤中选择概率最高但又不属于正确答案集合的词汇。正确答案集合包括视频中真实存在的物体和动作,以及它们的同义词和上位词。通过这种方式,系统可以系统性地发现AI的"思维盲区"。

SANTA的第二个核心创新是"轨迹-短语对比对齐"机制。传统方法往往将视频当作一系列独立的图片来处理,这样就无法捕捉物体在时间上的连续性和动作的完整过程。新的方法则像一个细心的观察者,不仅关注每个瞬间的画面,还追踪物体在整个视频过程中的运动轨迹。

这个轨迹追踪过程使用了最新的视觉定位技术,能够精确标记出每个物体在视频中的位置变化。同时,系统还引入了一个"动作压缩器"模块,专门负责从物体之间的关系变化中提取动作信息。这就像一个专门分析舞蹈动作的老师,不仅看每个舞者的位置,还要理解他们之间的配合关系。

动作压缩器采用了感知器架构,使用一组可学习的查询向量来捕捉不同类型的动作模式。当系统分析一个动作时,会让这些查询向量与相关物体的轨迹特征进行交互,然后选出最能代表当前动作的查询结果。这个过程确保了系统能够从复杂的空间-时间关系中提取出准确的动作信息。

整个训练过程采用了对比学习的策略,这种策略的工作原理类似于"正反对比"的教学方法。系统同时学习正确的描述应该是什么样的,以及错误的描述是什么样的。通过不断强化正确的关联,同时抑制错误的关联,AI模型逐渐学会生成更加准确和可靠的视频描述。

为了验证SANTA框架的有效性,研究团队在多个权威数据集上进行了全面的实验。他们使用了MiraData数据集进行训练,这个数据集包含了42715个高质量的视频-文本对,每个视频平均长度为72.1秒,描述文本平均长度达到318个词。

实验结果令人印象深刻。在MiraData-9k测试集上,SANTA在物体幻觉评估方面比现有最佳方法平均提升了4.02%,在动作幻觉评估方面提升了5.54%。更重要的是,在加权评估指标下,这些提升分别达到了3.77%和7.7%。

研究团队还在FactVC数据集上进行了验证,这个数据集专门用于评估视频描述的事实准确性。结果显示,SANTA在精确率、召回率和F1分数等关键指标上都达到了最佳表现。在视频问答任务VidHal上,SANTA在物体和动作相关的问题回答准确率上分别达到了86.3%和85.8%,超越了所有对比方法。

特别值得关注的是,研究团队通过t-SNE可视化技术展示了SANTA的工作机制。可视化结果清楚地显示,在应用SANTA之前,正确的视频-文本特征和错误的幻觉特征在特征空间中混杂在一起,界限不清。而在应用SANTA之后,这两类特征被明显分开,错误的幻觉特征被有效地从正确特征中分离出来。

为了测试方法的普适性,研究团队在不同的基础模型上进行了验证。除了在LLaVA-Video模型上取得显著提升外,在Qwen2.5-VL模型上也获得了一致的改进效果,证明了SANTA框架的通用性和稳定性。

研究还深入分析了各个组件的贡献。实验表明,仅添加物体级别的对齐就能带来显著提升,而进一步加入动作级别的对齐则能获得额外的改进。完整的SANTA框架在所有评估指标上都达到了最佳效果,证明了各个组件之间的协同作用。

值得一提的是,研究团队还测试了SANTA在通用视频描述任务上的表现。在Dream1k基准测试中,SANTA不仅减少了幻觉现象,还提升了整体的视频描述质量,从32.5分提升到32.7分。这证明了提高描述准确性并不会损害模型的表达能力,反而能够增强其整体性能。

对于物体轨迹质量的影响分析也很有启发性。即使在使用较低置信度阈值(从0.25降到0.15)导致更多误检的情况下,SANTA仍然能够保持稳定的性能提升,显示了其对噪声的鲁棒性。

从技术实现的角度来看,SANTA的训练过程相对高效。研究团队采用了6e-5的学习率,批次大小为64,使用64帧均匀采样,在2000个训练步骤内就能达到理想效果。动作压缩器模块采用了16个可学习查询,平衡了计算效率和表征能力。

这项研究的意义远远超出了技术层面的改进。在医疗影像分析中,准确的视频描述能够帮助医生更好地理解病理过程。在自动驾驶领域,可靠的场景理解对安全性至关重要。在教育技术中,准确的视频内容分析能够为个性化学习提供更好的支持。

当然,这项研究也有一些限制。目前的方法主要针对相对清晰的视频内容,对于极度模糊或复杂场景的处理能力仍有提升空间。此外,方法的计算复杂度虽然相对可控,但在处理超长视频时仍需要进一步优化。

展望未来,这项研究为多模态AI的发展指明了重要方向。通过结合自增强学习和细粒度对比对齐,SANTA框架不仅解决了当前的技术痛点,也为后续研究提供了宝贵的思路。随着视频内容的爆炸式增长和AI应用场景的不断扩展,这种能够准确理解和描述视频内容的技术将发挥越来越重要的作用。

说到底,让AI能够像人类一样准确理解视频内容,一直是人工智能领域的重要目标。SANTA框架通过巧妙的设计,让AI不仅能够"看见"视频中的物体,更能够"理解"它们之间的动作关系。这种进步不仅仅是技术上的突破,更是让AI更接近真正理解世界的重要一步。对于普通人来说,这意味着未来的AI助手将能够更准确地帮助我们分析视频内容,无论是整理家庭录像、协助工作汇报,还是辅助专业分析,都将变得更加可靠和实用。

Q&A

Q1:什么是SANTA框架?

A:SANTA是"自增强对比对齐"框架的简称,由台湾大学和英伟达联合开发,专门用于解决AI在描述视频时出现的"幻觉"问题。它能让AI准确识别视频中真实存在的物体和动作,避免描述不存在的内容。

Q2:AI视频描述中的"幻觉"问题有多严重?

A:这个问题相当严重,目前的AI经常会描述视频中根本不存在的物体和动作。比如看滑雪视频时说成跳伞,或者看到不存在的物品。在医疗诊断、自动驾驶等关键应用中,这种错误可能带来严重后果。

Q3:SANTA框架相比传统方法有什么优势?

A:SANTA的核心优势是同时处理物体和动作两个层面的准确性。它不仅能识别视频中的物体,还能理解物体间的动作关系。实验显示,它在物体准确性上提升4.02%,动作准确性上提升5.54%,显著超越现有方法。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。