为AI配上"眼睛"和"大脑",让机器真正学会空间推理

这项由中科院信息工程研究所、中科院自动化研究所与百度公司合作的研究发表于2025年,论文编号为arXiv:2512.04563v2。这是一项让人工智能真正学会"看懂"3D世界的突破性研究,对于普通人来说意义重大。

你是否曾经好奇,为什么小孩子看一眼就能知道哪个玩具离自己更近,而号称"聪明"的AI却经常在这种简单问题上犯糊涂?这就好比一个人有一双明亮的眼睛,却没有一个会分析距离和空间关系的大脑。当前的多模态大语言模型就面临着这样的困境——它们能看到图片,也能理解语言,但在判断物体的远近、大小和空间位置关系时,表现得像个"路痴"。

研究团队发现了问题的根源:现有的AI模型就像一个只看过平面照片、从没接触过真实3D世界的人。它们虽然能识别图片中的物体是什么,但对于"哪个更近"、"多大距离"这样的空间问题,往往答非所问。更关键的是,以往的解决方案要么只是给AI配上更好的"眼镜"(提升视觉感知),要么只是训练它的"逻辑思维"(加强推理能力),但从来没有人想过让这两者真正配合起来工作。

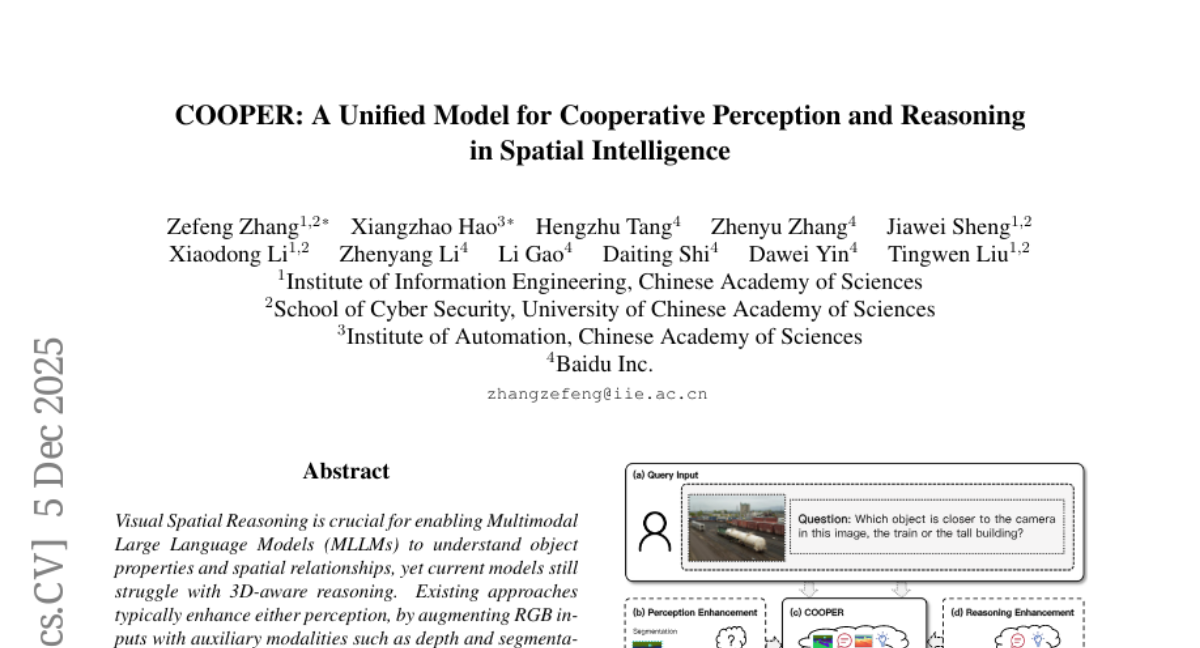

于是,研究团队开发了COOPER(Cooperative Perception and Reasoning的缩写)——一个革命性的AI模型。这个名字很有意思,"cooper"本身就有"合作者"的含义,正体现了这项技术的核心理念:让AI的"眼睛"和"大脑"真正学会协作。

**一、给AI装上"3D眼镜":让机器看懂空间深度**

要理解COOPER的创新之处,我们得先明白传统AI的"视觉缺陷"在哪里。普通的AI模型看图片,就像我们看一张平面海报——能识别出上面画的是什么,但完全感受不到距离和深度。如果你拿一张拍摄客厅的照片问AI:"沙发和电视哪个离拍照的人更近?"AI可能会根据物体在图片中的大小来猜测,但这种猜测往往是错的。

COOPER的第一个突破是教会AI生成"深度图"和"分割图"。深度图就像给每个像素标注了到相机的距离,用颜色深浅来表示远近——就像热成像仪显示温度一样,暖色调表示近,冷色调表示远。分割图则是用不同颜色给图片中的每个物体"贴标签",让AI清楚地知道哪些像素属于哪个物体。

这个过程面临一个技术难题:AI原本只会生成普通的彩色图片,现在要让它学会生成这些"特殊图片"。研究团队想出了一个聪明的办法——把深度信息和分割信息都转换成RGB彩色图片的格式。具体来说,他们把深度值通过数学变换映射到RGB颜色空间,把分割的不同区域用不同的RGB颜色来表示。这样,AI就可以用原来生成图片的方法来生成这些辅助信息,不需要大幅改造原有架构。

为了训练这个能力,研究团队收集了大量室内外场景的数据。室内数据来自Hypersim合成数据集,室外数据来自Virtual KITTI数据集。他们让AI学会识别"我要生成深度图"和"我要生成分割图"这样的指令,就像训练一个摄影师学会切换相机的不同拍摄模式。

**二、让AI学会"边看边想":自适应推理的奥秘**

仅仅会生成辅助视觉信息还不够,关键是要让AI知道什么时候该"看",什么时候该"想",以及如何把看到的和想到的结合起来。这就像一个优秀的医生,面对病人时知道什么时候该看X光片,什么时候该凭经验判断,什么时候需要综合各种信息做出诊断。

COOPER的第二个突破是实现了"自适应交错推理"。简单来说,就是让AI学会在回答空间问题时,自主决定是否需要生成辅助视觉信息,以及如何在文字思考和视觉分析之间灵活切换。

这个过程分为两个训练阶段。第一阶段是"监督微调",研究团队用GPT-4o创建了大量示例,展示AI应该如何一步步分析空间问题。这些示例就像是给AI看的"标准答案",教它学会在遇到距离判断问题时生成深度图,在需要计算物体数量时生成分割图,在进行几何推理时主要依靠文字逻辑。

第二阶段是"强化学习",这个阶段更像是让AI在实战中磨练技能。研究团队设计了一个复合奖励机制,叫做CPR奖励(Cooperative Perception-Reasoning Reward)。这个奖励机制包含三个部分:答案正确性奖励、格式规范性奖励和探索引导奖励。探索引导奖励特别巧妙,它根据题目特点来判断是否应该使用视觉辅助——如果是那种用视觉辅助能明显提升准确率的题目,AI选择生成辅助图就会获得奖励;反之,如果是纯逻辑推理就能解决的题目,AI滥用视觉辅助反而会被"扣分"。

这种训练方式让COOPER学会了"因题制宜"。面对询问相对距离的问题,它会主动生成深度图来辅助判断;面对需要计算特定区域物体数量的问题,它会生成分割图来精确定位;面对纯几何逻辑问题,它则会专注于文字推理,不被视觉信息"干扰"。

**三、实验验证:COOPER的"视力体检"结果**

为了验证COOPER的能力,研究团队在多个测试基准上进行了全面的"体检"。这就像给一个声称视力极佳的人做各种视力测试,从看远看近到辨别颜色,全方位检验真实水平。

在空间理解测试中,COOPER在三个主要基准上都表现出色。SIBench是一个综合性的空间推理测试,包含近20个开源基准的23种视觉空间推理设置,COOPER在这里取得了平均6.91%的提升。Q-SpatialBench专门测试距离和大小估计能力,COOPER的表现甚至超过了一些38B参数的大型开源模型,接近GPT-4o的水平。MMVP测试涵盖九种不同的视觉模式和模式,COOPER同样表现优异。

更令人惊喜的是,COOPER在提升空间推理能力的同时,并没有损害其通用能力。在MMBench和MM-Vet这两个测试通用多模态能力的基准上,COOPER相比基础模型还有4.47%的平均提升。这说明专门的空间推理训练实际上还提升了AI的整体理解能力。

研究团队还做了一个有趣的对比实验。他们分别测试了只强化"眼睛"的版本(Perception Enhancement,简称BAGEL-PE)和只强化"大脑"的版本(Reasoning Enhancement,简称BAGEL-RE)。结果发现,单独强化感知能力虽然在空间任务上有提升,但通用能力有所下降;单独强化推理能力则相反。而COOPER通过协调两者,实现了双赢。

特别值得一提的是,即使是只学会生成辅助视觉信息、还没有进行推理训练的版本,在距离和大小估计任务上就已经有了7.92%的提升。这表明仅仅是学会"看懂"3D信息,就已经显著提升了AI的空间理解能力。

**四、COOPER如何"思考":推理过程全解析**

COOPER的推理过程就像一个经验丰富的侦探破案。面对一个空间问题,它首先会仔细分析题目,判断这是什么类型的问题。如果是距离判断类问题,它会生成深度图,然后结合原图和深度图进行分析;如果是需要计算物体数量的情境问答,它会生成分割图来精确识别和计数;如果是纯几何推理问题,它会主要依靠逻辑思维,不被视觉信息"误导"。

举个具体例子,当被问到"从穿4号球衣的球员角度看,他左边有几个队友?"时,COOPER的思考过程是这样的:首先分析这是一个情境问答问题,需要准确识别球员位置和相对关系,于是决定生成分割图。生成分割图后,它能清楚地看到每个球员的位置,然后从4号球员的视角出发,数出左边的队友数量,最终给出准确答案。

整个过程中,COOPER会用"<think>...</think>"标签来进行文字思考,用"<depth-estimation>...</depth-estimation>"或"<segmentation>...</segmentation>"标签来生成视觉辅助信息,用"<answer>...</answer>"标签来给出最终答案。这种交错式的推理过程让AI的思考变得透明可追踪。

**五、技术创新的深层意义**

COOPER的创新不仅仅在技术层面,更在于它改变了我们对AI能力建构的理解。传统观点认为感知和推理是相互独立的能力,可以分别优化。但COOPER证明了,真正的智能来自于感知和推理的深度融合与动态协作。

从技术角度看,COOPER解决了几个长期困扰研究者的问题。首先是统一架构下的多模态生成,它证明了同一个模型可以既生成自然图像,又生成结构化的视觉信息。其次是自适应能力调度,它展示了如何让AI根据任务需求自主选择使用哪些能力。最后是协作式推理,它开创了感知增强推理的新范式。

从应用前景看,COOPER的技术有望在多个领域产生重大影响。在自动驾驶中,车辆需要精确判断与其他车辆和行人的距离关系;在机器人导航中,机器人需要理解复杂环境中的空间布局;在增强现实应用中,系统需要准确理解真实场景的3D结构来放置虚拟物体。

**六、挑战与展望**

尽管COOPER取得了显著成果,但研究团队也坦诚地指出了当前的局限性。目前的实验主要集中在单图空间推理任务上,而真实世界的应用往往需要处理视频流和长时间序列的空间推理。此外,COOPER目前只使用了深度和分割两种辅助模态,未来可能需要整合更多类型的视觉信息,如3D点云数据等。

另一个技术挑战是推理效率。当前版本的COOPER在每次需要生成辅助视觉信息时,都要运行完整的图像生成流程,这在实时应用中可能成为瓶颈。研究团队正在探索如何在保持推理质量的同时提升计算效率。

从更大的视角来看,COOPER开启了"协作式AI"的新方向。未来的AI系统可能不再是单一功能的叠加,而是多种能力的有机融合。这种融合不仅发生在感知和推理之间,还可能扩展到记忆、规划、创造等更多认知能力之间。

这项研究的另一个深远意义在于,它为AI的解释性提供了新思路。通过可视化的推理过程,我们不仅能看到AI得出了什么结论,还能理解它是如何得出这个结论的。这对于AI系统在关键应用场景中的部署具有重要意义。

最终,COOPER代表了AI发展的一个重要里程碑——从单一能力的优化转向多能力的协同,从被动的信息处理转向主动的策略选择,从黑盒式的推理转向可解释的思考过程。这不仅让AI更加智能,也让AI的行为更加可信和可控。有兴趣深入了解这项研究的读者,可以通过论文编号arXiv:2512.04563v2查询完整论文内容。

Q&A

Q1:COOPER和其他AI视觉模型有什么本质区别?

A:COOPER的核心区别在于实现了感知和推理的真正协作。传统AI模型要么只是看得更清楚(感知增强),要么只是想得更深入(推理增强),而COOPER让AI学会了根据问题类型自主决定什么时候该"看"、看什么,以及如何把看到的和想到的结合起来得出答案。

Q2:COOPER生成的深度图和分割图准确度如何?

A:研究显示COOPER生成的辅助视觉信息质量很高。在深度估计方面,它在NYUv2数据集上的表现可媲美专门的深度估计模型Marigold。在分割方面,COOPER往往能生成比原始标注更精细的边界和更清晰的物体区分。

Q3:COOPER技术什么时候能在实际产品中应用?

A:COOPER目前还处于研究阶段,主要在学术基准上验证效果。要真正应用到产品中,还需要解决计算效率、长视频处理等工程问题。不过,这项技术的核心思想——让AI的不同能力协作工作——已经为未来AI产品的设计指明了方向。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。