Google发布了“既要又要还要”的Gemini 3 Flash,工程师说只有他们的基建能力能做到

话说,Google在上个月发布了Gemini 3,先放出了Gemini 3 Pro和Gemini 3 Deep Think(深度思考)模式,反响挺热闹。紧接着,就在昨天,这次轮到Gemini 3 Flash 正式登场,Google团队把它形容成“为速度打造的前沿智能”。简单讲,就是既要又要还要,要速度,要智商,还要低成本。

Google Deepmind模型预训练部分的技术专家Vlad Feinberg在个人社交平台上(X)提到,之所以能实现“又快又好又便宜”,来自于多年坚定投资基础设施与科技领域的成果,他认为,没有任何其他机构能像Google这样训练模型。

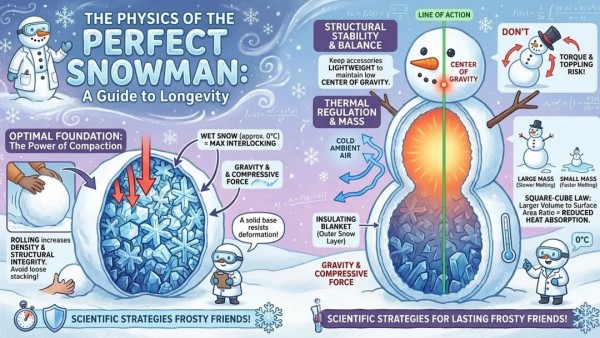

首先,它有多快?根据Artificial Analysis的测试,Gemini 3 Flash的速度是前代增强版模型(2.5 Pro)的3倍。

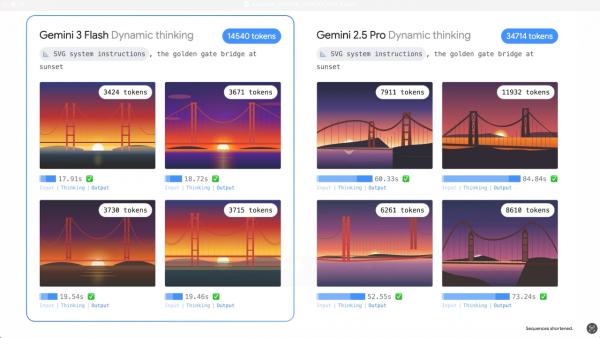

图:Gemini 3 Flash 在速度和质量上都优于 2.5 Pro

其次,它有多省?价格更是直接打骨折,在Gemini API和Vertex AI的定价里,输入成本是每百万token 0.5美元,输出是每百万token 3美元,音频输入成本是每百万token 1美元。

这还没完,它还自带两个省钱利器:上下文缓存(Context Caching),对于高频重复的指令和知识,成本最高能降低到原来的10%;对于非实时任务,走Batch API,成本还能再省50%。更关键的是,同场景下,它平均比Gemini 2.5 Pro少用约30%的token来达成更准确的结果。换句话说,推理更会“省字”,不是靠堆砌字数显得聪明。

看到这里,你可能会想,便宜又快,那智能肯定缩水了吧?

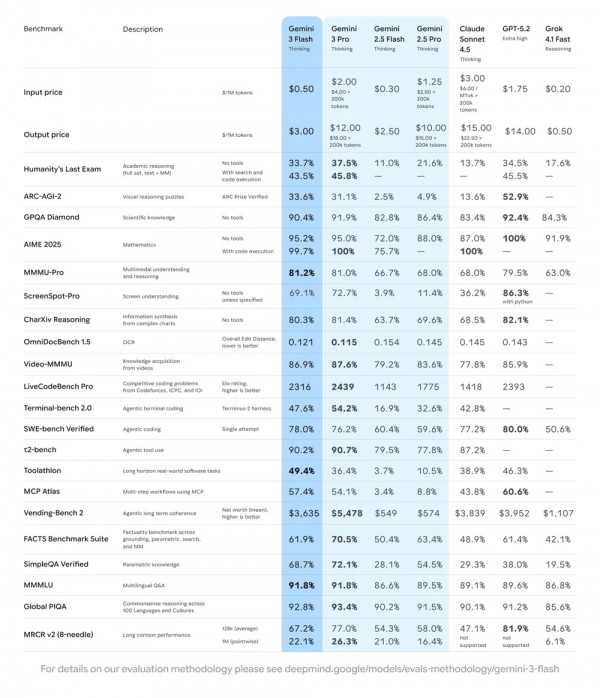

有意思的地方就在这里。Google说,不,它的智商几乎没降。在GPQA Diamond这类博士级推理基准上拿到90.4%,在Humanity’s Last Exam不带工具也能跑到33.7%,在MMMU Pro 这种多模态理解上达到81.2%,直追Gemini 3 Pro。

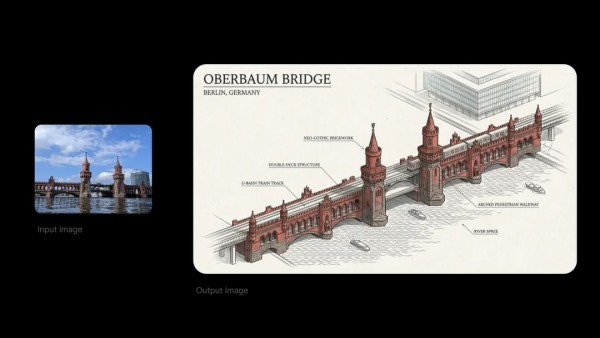

基准成绩能说明一部分,另一个关键是它的视觉与空间推理更强,还加上了「代码执行(Code Execution)」来处理图像的缩放、计数、编辑。过去你让模型数一数图里有多少小方块,它可能“想当然”,现在它会“看着数”,甚至会“跑一下代码再告诉你”,这一步在多模态任务里非常关键,避免了“黑箱幻觉”。

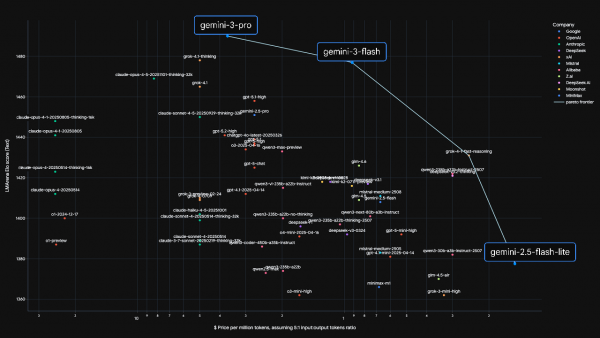

图:根据LMArena的 Elo 评分,Gemini 3 Flash 在性能与成本和速度的竞争上突破了帕累托的边界

这背后意味着什么?

如果你在做生产级应用,这三点叠加:平均成本下降,吞吐提升,响应时间缩短。工程与产品能谈的场景也变多了。

当Gemini 3 Flash这种“又快又好又便宜”的能力被应用到各个领域时,会发生什么化学反应,对不同行业或人群有什么增益?我们来看看。

对于开发者来说,写代码最怕的就是打断思路。你好不容易进入心流状态,结果AI助手卡了半天,或者给出的建议驴唇不对马嘴,那感觉别提多难受了。

Gemini 3 Flash在专门评估AI编程能力的SWE-bench测试中,拿到了78%的高分,甚至超过了自家老大哥Gemini 3 Pro。这意味着什么?这不仅仅是“会写”,更意味着它具备了初步的智能体(Agent)能力:会自己分解任务、调用工具、甚至修复bug,而且速度快到能跟上你的思路。

上个月我们已经提到过,Google的一个新平台叫Google Antigravity(谷歌反重力),它就是一个让AI帮你写代码的平台。用了Flash之后,开发者可以一边构思一边让AI实时把想法变成代码,整个过程行云流水。JetBrains(就是那个做各种编程神器的公司)的AI负责人说,Flash的质量接近Pro,但延迟和成本却低得多,这让他们的多步骤复杂AI智能体变得既快又可预测。

其次,在更多专业的应用场景,AI在专业领域的应用,最看重的就是“准确”。但我们通过一些实际反馈来看,各行业对Gemini 3 Flash反馈貌似都还不错。

在法律领域。法律公司Harvey发现,Gemini 3 Flash在处理海量法律文书时,在BigLaw Bench基准上准确率比前代提升了超过7%。对于律师来说,处理海量法律文书这类繁重工作变得更可托付。

做云存储的Box公司也发现,Gemini 3 Flash的准确率相对前代提升了整整15%,这个增益点发生在最难的处理“手写文字、长篇合同和复杂金融数据”这些高难度任务,含金量十足。

在内容安全领域。深度伪造检测公司Resemble AI反馈,Gemini 3 Flash的多模态分析速度是2.5 Pro的4倍,能把复杂的取证数据即时讲清楚,这对媒体核验和平台风控是刚需。

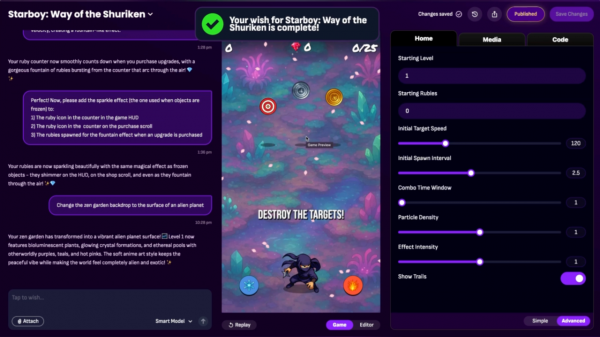

在游戏领域。Astrocade(号称全球首个许愿做游戏的平台)用Gemini 3 Flash从一个简单提示生成完整的游戏计划和可执行代码,快速把概念变成可玩的demo。

设计领域也一样。知名设计协作平台Figma设计总监说,用Gemini 3 Flash可以快速可靠地创建产品原型,而且能很好地理解设计师的具体指令。这意味着,从一个模糊的想法到一个看得见摸得着的设计原型,中间的距离被极大缩短了。

如果说上述应用还有点高大上,那么Gemini 3 Flash在消费级产品里的落地,就真的有点赛博朋克照进现实的味道了。

现在,它已经成为Gemini应用和谷歌搜索AI Mode(AI模式)的默认模型。在Gemini应用里,你可以选择“Fast”(快速模式)获得即时答复,也可以切换到“Thinking”(思考模式)解决复杂问题。Gemini 3 Pro也有“Pro”这一选项,它适用于高级数学和编程。这样一来,搜索出来的结果更像一份“整理过的方案与动作建议”,而不仅仅是“给你十个链接”。

Google还在扩大 Nano Banana Pro在搜索中的访问。现在,更多美国用户可以通过选择“Thinking with 3 Pro”模式并选择“Create Images Pro”,在 AI 模式下使用。

这里脑洞大开,随意想几个场景。

场景一,你的私人教练。你可以录一段自己打高尔夫的视频发给它,它会立刻分析你的挥杆动作,然后给你一个详细的改进计划。

场景二,你的灵魂画手。你可以在屏幕上画画,它会在你还没画完的时候,实时猜出你画的是什么,就像一个反应超快的猜画游戏搭子。

场景三,你的随身知识助教。你可以上传一段讲座的录音,它能帮你找出你知识上的盲点,然后为你量身定制一套小测验,还带详细讲解。

最绝的是,你甚至可以完全不懂编程,只是对着手机用语音描述一个你想要的应用,比如“帮我做一个记录每天喝水量的App”。几分钟后,Gemini 3 Flash就能把你的这些零散想法,变成一个真正可以运行的手机应用原型。

要知道,之前将一个想法变为现实,需要学习复杂的编程语言,需要设计繁琐的界面,需要漫长的开发周期。而现在,从一个念头到第一个可用的版本,中间的阻碍几乎只剩下你的想象力本身。

我们看到,无论是Salesforce、Workday这样的商业巨头,还是ClickUp、Replit这样的创新公司,都在用它来构建所谓的“智能体”(Agent),让AI更自主地完成复杂任务。

这或许才是“Flash”这个名字的真正含义:它不仅代表着速度,更代表着一道划破旧有模式、照亮全新可能性的光。

我们不用喊口号,只需要想象一个画面:当你走在路上,一个灵感闪现,你掏出手机,用最自然的语言把它说出来,几分钟后,一个能解决你当下问题的应用就出现在了屏幕上。

当想法和现实之间的摩擦力,被技术抹平到近乎为零时,下一个伟大的创造,会是什么样呢?

这个问题,或许比模型本身更值得我们思考。

好文章,需要你的鼓励

-

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的"稀疏化魔法"

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

-

不用再训练AI模型,香港科技大学团队发明"智能管家",让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

-

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的"语义迷宫"让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

-

华为诺亚方舟实验室新突破:不加内存也能让AI变聪明的神奇方法

华为诺亚方舟实验室提出VersatileFFN创新架构,通过模仿人类双重思维模式,设计了宽度和深度两条并行通道,在不增加参数的情况下显著提升大语言模型性能。该方法将单一神经网络分割为虚拟专家并支持循环计算,实现了参数重用和自适应计算分配,为解决AI模型内存成本高、部署难的问题提供了全新思路。