叙利亚黑客集团入侵Skype 大呼停止监视

当地时间本周三,叙利亚电子军队(Syrian Electronic Army)以网络电话Skype为攻击对象,向该聊天服务软件的博客及其Twitter和Facebook账户上发布了反监视信息。

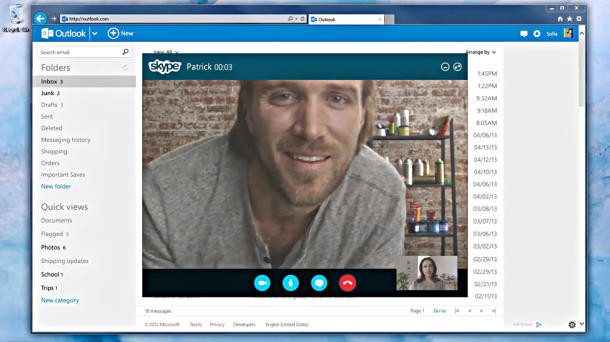

例如,在Skype的官方Twitter帐户上,出现了这样的消息:“停止对人民的监视吧!——叙利亚电子军队。”该微博一发出,美国科技网站The Next Web迅速注意到,这条消息在一个小时内很快被删除,但其纪录却着实在Skype网站上逗留了一段时间。(详见截图)

而在Skype的博客上也出现了类似的大标题:“叙利亚电子军队侵入……停止监视!”

同其他被广泛使用的互联网通信服务一样,在2013年中期由前国安局前合同工爱德华·斯诺登(Edward Snowden)引发的“棱镜门”事件中,微软的自有网络电话Skype也中枪了。据报道称,被泄露的消息中显示,Skype软件上安装有一个“后门”,允许政府监控Skype视频和音频通话,据悉,在Skype总部卢森堡,有官员正在审查Skype是否与国安局共享了其卢森堡用户的信息。

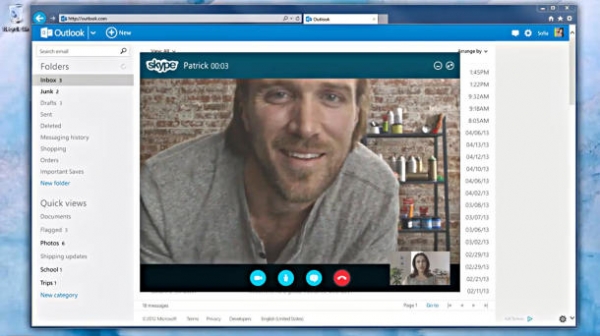

与此同时,在Skype的Facebook账户上,叙利亚电子军队周三发布了更多关于微软该通信服务的信息:“别再使用微软电子邮件了(hotmail和outlook),他们正在监视您的帐户并把它们卖给政府了。随后更新更多细节。#SEA。”当然,这则消息也很快被删除,不过在此之前,美国科技网站TNW(the Next Web)留下了截图。

好文章,需要你的鼓励

-

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的"稀疏化魔法"

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

-

不用再训练AI模型,香港科技大学团队发明"智能管家",让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

-

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的"语义迷宫"让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

-

华为诺亚方舟实验室新突破:不加内存也能让AI变聪明的神奇方法

华为诺亚方舟实验室提出VersatileFFN创新架构,通过模仿人类双重思维模式,设计了宽度和深度两条并行通道,在不增加参数的情况下显著提升大语言模型性能。该方法将单一神经网络分割为虚拟专家并支持循环计算,实现了参数重用和自适应计算分配,为解决AI模型内存成本高、部署难的问题提供了全新思路。