所有节目1秒钟变裸眼3D 今年国内或可见成品上市

裸眼3D技术已经推出多年,各种不同原理的技术纷纷出现在市场上,但整个3D市场一直都处于不温不火的状态,其中的原因,3D观看不舒服是一个方面,3D片源过少又是一个方面,在CES2014上,有一家厂商试图去解决这个问题,并且据了解他们已经和国内一些电视厂商展开合作,今年一些成品有可能将会陆续上市。

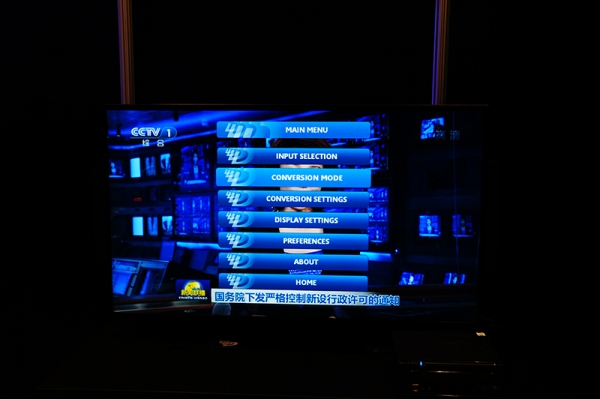

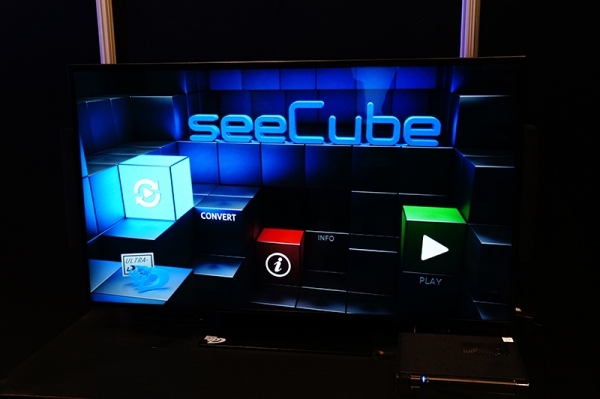

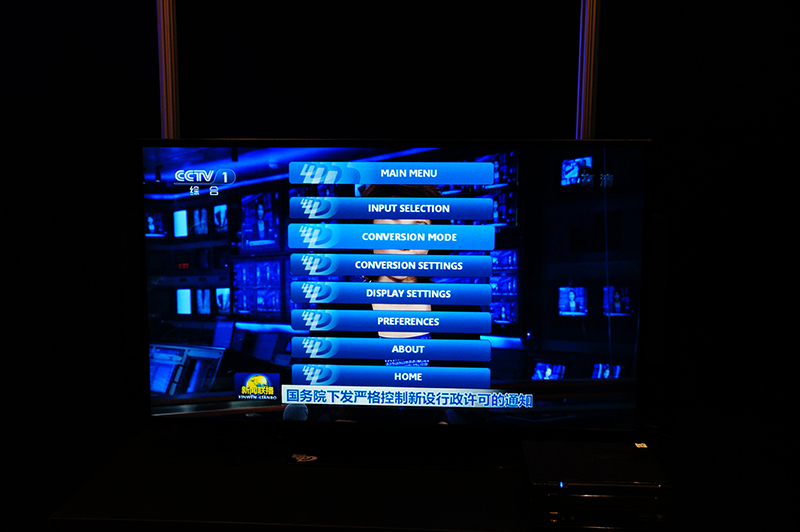

这家裸眼3D解决方案供应商叫做StreamTV Networks,他们采用柱状透镜式的裸眼3D原理,比较有特色的功能有几点:首先,我们可以自由的调节3D的景深,这个主要用于防止长期观看3D视频造成的眩晕,我们可以根据家庭电视摆放位置和每个人对景深的不同感受调节到最舒适的位置;其次是,它们可以实现将普通的2D电视节目信号实时的转换成为3D输出,经过我们的现场体验,效果还是比较明显的,尤其对于体育节目,立体感极强,当然效果仍然比不上3D片源的输出效果,配图就是我们在现场实时的将新闻联播转成3D信号,当然相机拍不出3D效果,从人眼角度看还是很不错的;第三是成本较低,我们了解到StreamTV Networks的技术不会给电视厂商带来过大的成本压力,他们可以用更低的成本向市场销售裸眼3D电视终端。

目前StreamTV Networks已经和一些电视厂商展开合作,今年这些厂商或许将会推出一些裸眼3D的成品。

[video]uu=dfa091e731&vu=5aebbf53b3&auto_play=0&width=600&height=450[/video]

好文章,需要你的鼓励

-

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

openGauss的目标是探索oGRAC和超节点深度融合的可能,打造超节点原生数据库。

-

清华团队让机器学会"透视眼":用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

-

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

-

上海AI实验室创造"无限视频世界",用键盘就能探索!

上海AI实验室团队开发的Yume1.5是一个革命性的AI视频生成系统,能够从单张图片或文字描述创造无限可探索的虚拟世界。用户可通过键盘控制实时探索,系统8秒内完成生成,响应精度达0.836,远超现有技术。该系统采用创新的时空通道建模和自强制蒸馏技术,支持文本控制的事件生成,为虚拟现实和内容创作领域开辟了新的可能性。