英特尔开发MXC光纤技术 带宽可达1.6Tbps

英特尔、康宁和US Conec日前公布了MXC光纤技术,数据传输速率可达1.6Tbps。MXC光纤技术将用于超级计算机和数据中心。

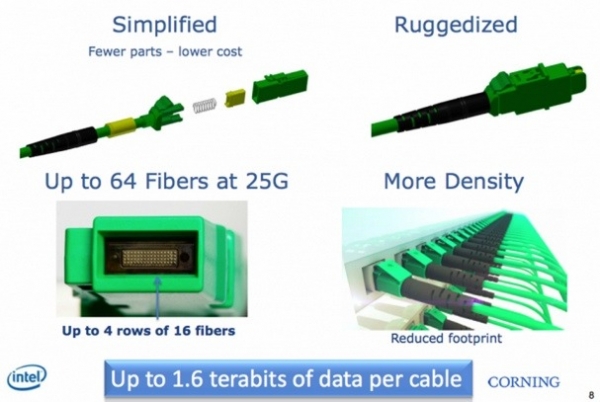

MXC集成有64根光纤,每根光纤的数据传输速率为25Gbps,因此MXC的数据传输速率可达1.6Tbps。由于MXC的半数光纤用于传输上行数据,半数用于传输下行数据,因此实际数据传输速率将削减至800Gbps。尽管如此,与当前10Gbps的数据传输速率相比,这也是一个巨大的飞跃。

MXC不仅数据传输速率高,而且坚固耐用,使用的元器件少,因此成本也较低。另外,MXC的防尘能力是现有光纤产品的10倍。

英特尔发表博文称,“一根MXC光缆的数据传输速率高达1.6Tbps。用它从iTunes下载一部2小时的高清电影仅需不到2秒钟时间。由于每天生成的信息量高达2.5 quintillion(相当于10的18次方)字节,因此没有人怀疑21世纪的数据中心需要MXC提供的更高带宽。”

英特尔称,“康宁已经向客户交付MXC光缆样品,MXC光缆将于今年第三季度投入批量生产。US Conec将向康宁等公司供应MXC连接器。”

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。