报告称绝大多数用户已接受云存储 但安全状况堪忧

市场研究公司Ponemon Institute今天发布的一份报告显示,大多数企业都在积极向云计算转移,甚至不惜在安全未能得到有效保障的情况下,将机密或敏感数据传至云端。

报告指出,企业在向云计算转移速度,远超出了企业云安全环境承载能力。调查称,大多数被调查者称他们已将敏感或机密数据上传至云端,仅有11%的被调查者称他们未将数据传至云端,而且也无上传计划。

值得关注的是,尽管有用户认为云存储具有一定的潜在安全风险,但即使是一些具有更高安全意识的组织或机构,同样也更有可能将敏感或机密数据传至云端。

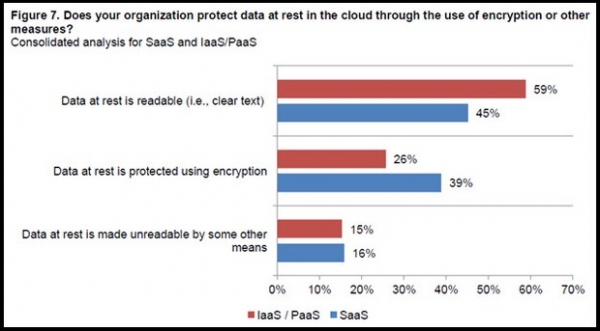

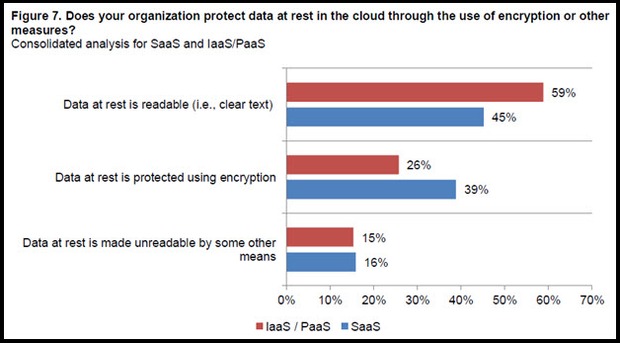

调查显示,大多数认为IaaS或PaaS类型的云服务器应对用户数据安全负有主要责任,22%的受访者认为上述服务器应单独承担数据安全责任,19%的被调查者认为SaaS服务器也应共同承担数据安全责任。

报告指出,云端服务器即使用了加密技术,但仍无法抵御像“心脏滴血”蠕虫入侵。理想的解决方案是,采用一个可以从数据内部执行加密、且不暴露外环境下的“硬件安全模块”设备。

这份报告在美国、英国、德国、法国、澳大利亚、日本、巴西和俄罗斯等国市场展开,共对4275名商务及IT经理进行了采访。

好文章,需要你的鼓励

-

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

openGauss的目标是探索oGRAC和超节点深度融合的可能,打造超节点原生数据库。

-

清华团队让机器学会"透视眼":用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

-

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

-

上海AI实验室创造"无限视频世界",用键盘就能探索!

上海AI实验室团队开发的Yume1.5是一个革命性的AI视频生成系统,能够从单张图片或文字描述创造无限可探索的虚拟世界。用户可通过键盘控制实时探索,系统8秒内完成生成,响应精度达0.836,远超现有技术。该系统采用创新的时空通道建模和自强制蒸馏技术,支持文本控制的事件生成,为虚拟现实和内容创作领域开辟了新的可能性。