经调查 苹果否认不雅照流出源于iCloud系统被攻破

苹果日前向科技网站Record表示,该公司正在“积极调查”其iCloud账户是否被黑,今天,苹果对近来发生的攻击事件和明星照片泄露发布了一份声明。

在当地时间周日,包括詹妮弗·劳伦斯和凯特·厄普顿等明星的不雅照及视频被发布到图片共享网站4chan后,苹果“动员了苹果旗下的工程师们探寻其泄露根源。”

在部分声明中,苹果表示:

“经过40多个小时的调查后,我们发现,某些明星的账户受损主要源于一个非常有针对性的攻击,这种攻击主要针对用户的用户名、密码和安全问题,而这种做法在互联网上已经非常普遍了。”

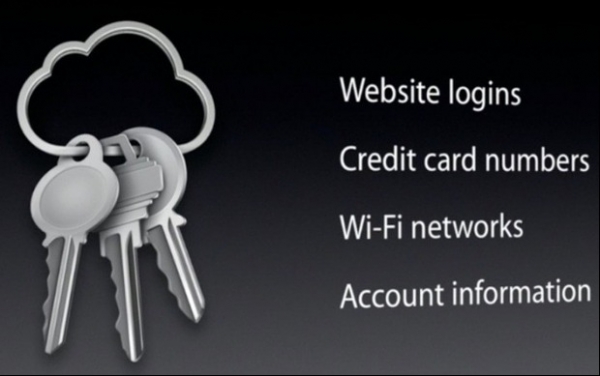

在这份声明中,苹果声称其iCloud和“找到我的iPhone”功能并未被攻破:

据我们调查,没有任何情况表明(本次泄露事件)是因任何苹果系统被攻破而造成的,包括iCloud和“找到我的iPhone”功能在内。

苹果精心地为这份声明进行了措辞,而且并没有直接否认这些数据来自iCloud或“找到我的iPhone”功能。相反,苹果表示在他们所调查的情况中,并未有原因表明苹果系统被攻破。这可以解释为,假设苹果的调查并不完整,那么到目前为止,调查并未发现有任何迹象指明iCloud被黑客攻破。

有人猜测,这些不雅照可能来自用户的iCloud备份(而非iCloud照片),因为这次泄露的数据中包含一些视频,而视频目前并不直接存储在iCloud中。

在图片共享网站4chan暗示这些不雅照可能来自“iCloud”后,苹果最初仅作为一个照片来源被提到。然而这很快便遭到了质疑,因为在几台非苹果设备上也发现了这些内容。

碰巧这些不雅照泄露的时间发生在周日,这也暗示着照片来源可能是苹果,因为HackApp在周六刚刚发布了一个iCloud漏洞的概念证明。苹果昨日修补了其FMF强力破解漏洞,并将在5次“找到我的iPhone”密码试验失败后关闭用户苹果ID。

好文章,需要你的鼓励

-

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的"稀疏化魔法"

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

-

不用再训练AI模型,香港科技大学团队发明"智能管家",让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

-

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的"语义迷宫"让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

-

华为诺亚方舟实验室新突破:不加内存也能让AI变聪明的神奇方法

华为诺亚方舟实验室提出VersatileFFN创新架构,通过模仿人类双重思维模式,设计了宽度和深度两条并行通道,在不增加参数的情况下显著提升大语言模型性能。该方法将单一神经网络分割为虚拟专家并支持循环计算,实现了参数重用和自适应计算分配,为解决AI模型内存成本高、部署难的问题提供了全新思路。