英特尔IDF2014:64位SoC至强D明年上半年投产

今日(美国时间9月10日)是英特尔IDF2014召开的第二天,在上午的主题演讲中,英特尔高级副总裁兼数据中心事业部总经理柏安娜称,有调查机构认为数据正以42%的速度增长。

柏安娜指出,虽然数据持续增长,但利用率却以50%速度下降,应用虚拟存储软件方法、统一硬件平台、硅光电传输等方法解决。

事实上在进入主题演讲大厅之前,记者在一展台上看到英特尔与柯达合作的流量分析解决方案,将两小时实路况信息压缩为一分钟显现,使之达到充分利用。

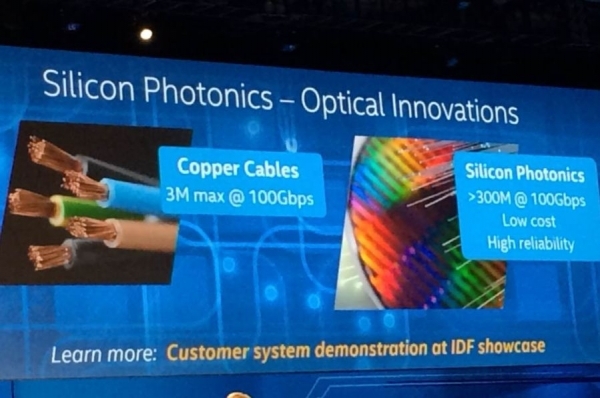

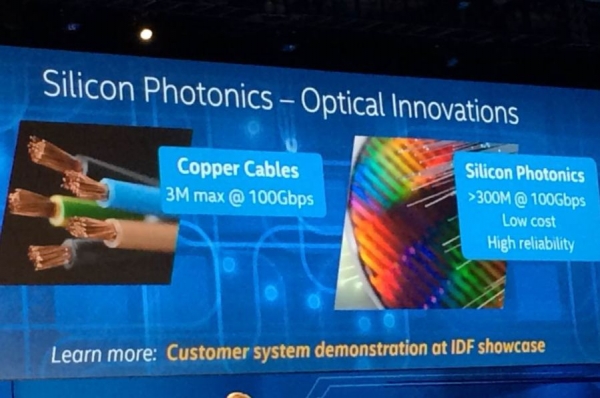

柏安娜认为,如果前端用凌动、酷睿,后台用至强,数据传输效率就自然提高;而铜缆传3M max@100Gbps用硅光电缆就会达到>300M@100Gbps,且可靠性相对高。即用铜传3米/100Gbps,而用硅光电则能传300米/100Gbps。

柏安娜指出,未来的基础架构将被软件定义。为此,英特尔正在大力推广软件定义基础设施的生态链建设。而英特尔在9月8日新发布的至强E5-2600 v3处理器,则是软件定义基础设施的基础。

在本届IDF上,7家公司展示了利用即将推出的英特尔硅光子光学模块开发的早期原型设备,该技术把光子模块的速度(100Gbps)和范围(目前最高300米,未来将达到2000米)与CMOS制造具体的批量和可靠性等优势相结合。

柏安娜在演讲中透露,英特尔正在向客户提供英特尔至强处理器D产品家族的样品。这款产品是第一款英特尔至强品牌的系统芯片(SoC),也是第三代面向数据中心的英特尔64位SoC。英特尔至强处理器D产品家族预计在2015年上半年投产。

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。