番茄土豆:帮你击败“拖延症” 有效提高工作效率

“拖延症”是当代人较为常见的“不治之症”,它大大影响了人们日常工作的效率,也影响了人们的生活品质。

为达到治疗“拖延症”的目的,人们就要学会更加适合自身的时间管理方法。由弗朗西斯科·西里洛于1992年创立的“番茄工作法”便是一种简单易行的时间管理方法,可以有效的提高工作效率。

而《番茄土豆》就是一款结合了“番茄工作法”与“To-do List”的时间管理应用。下面,我们就一同了解一下这款应用软件的使用方法吧。

什么是“番茄工作法”?

在开始评测前,我们首先需要了解下究竟什么是“番茄工作法”。简单的说,“番茄工作法”就是把每日待完成的工作任务分割成为若干个“番茄时间”来进行,每个“番茄时间”设为25分钟,在25分钟内专注工作,中途不允许做任何与该任务无关的事,直到番茄时钟响起。便可短暂休息一下(约5分钟),每完成4个番茄时段可以多休息一会儿(约15-30分钟)的工作方法。核心目的便是更好的管理我们的工作时间,从而极大的提高日常工作的效率。

简洁易上手的界面

了解了“番茄工作法”的具体内容后,就可以很好的来使用《番茄土豆》了。打开应用可以看到简洁的主操作界面。主界面共有土豆任务列表、月计划图表统计、系统设定等四个页面,用户可通过点击主界面下方的四个图标轻松进行切换,整体操作十分简单,上手容易。

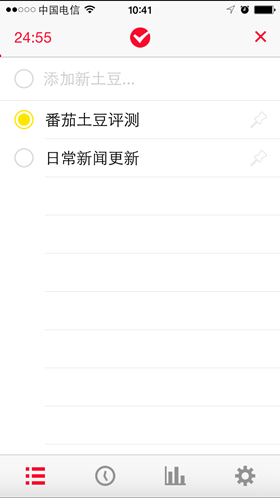

易用的土豆任务列表

在土豆任务列表页面用户可以轻松的添加每日的全部工作任务,优先级较高的任务可点击任务后面的钉针标志进行标记。然后点击右上角的开始标志开始第一个番茄时间的计时,并进入番茄工作法的循环。单项任务完成后可点击任务前面的圆形标志,将该任务添加到“完成的任务”列表。如果在现有任务进行中,突然收到新任务,可随时通过最上方“添加新土豆…”进行添加。这样的方式,用户便可简单直接的运用“番茄工作法”进行工作,可以有效地提高自身的工作效率。

省心的番茄时钟

在主界面任意分页下,点击最上方的软件图标便可进入番茄时钟界面。任务开始后,番茄时钟便会自动计时,无论是单个番茄时间的结束,还是休息时间的结束,番茄时钟都是自行提醒用户。整个过程中,用户无需分心查看时钟,专心工作与休息,从而达到工作效率及休息效果的最大化。在提高工作效率的同时,用户也不会产生额外的疲倦感。

清晰的统计数据

《番茄土豆》除了可以简化用户进行“番茄工作法”的流程外,还提供了统计数据的功能。统计数据共分为两个页面,其一是文字的统计页面,该页面中可清晰的显示出用户完成的每个番茄时间内进行的任务。其二则是总体的图表统计,在此页面中,用户除工作情况外,还可以看到系统根据用户完成工作的情况分析出的最佳工作日及最佳公共时段,从而使用户更好的了解自身的工作习惯,更合理的安排自身的工作计划,在有效时间内将工作效率进行最大化提升。

多平台的云同步功能

作为“云时代”中的个人工作助手APP,《番茄土豆》也拥有强大的云同步功能。用户仅需使用自定用户名与邮箱进行简单的注册,便可轻松实现该功能。目前《番茄土豆》的云同步功能已经实现ios、web及Andriod全平台的同步,用户可以随时在不同的平台查看自身的待办事项及番茄数据,使得番茄土豆的应用更加智能化。

个性偏好设置及总结

除了上述功能外,《番茄土豆》根据用户的工作环境、工作情况的不同,为用户提供了个人偏好的设定,其中包括了启用通知声音、启用震动、保持屏幕常亮等贴心的小功能,让用户使用起来更加得心应手。

总的来说,《番茄土豆》是一款成功结合“番茄工作法”与GTD任务管理方法的效率类APP。用户在使用过程中,有效提高自身工作效率的同时,还可更加清晰简单的了解自身的工作习惯,掌握高工作效率时段的所在,从而令自身的工作效率达到最大化,使用户的时间管理更加合理化,有效解决“拖延症”对用户工作的影响。

好文章,需要你的鼓励

-

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的"稀疏化魔法"

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

-

不用再训练AI模型,香港科技大学团队发明"智能管家",让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。

-

韩国KAIST让SVG动画脱胎换骨:AI如何破解矢量图形的"语义迷宫"让静态图标活起来

韩国KAIST开发的Vector Prism系统通过多视角观察和统计推理,解决了AI无法理解SVG图形语义结构的难题。该系统能将用户的自然语言描述自动转换为精美的矢量动画,生成的动画文件比传统视频小54倍,在多项评估中超越顶级竞争对手,为数字创意产业带来重大突破。

-

华为诺亚方舟实验室新突破:不加内存也能让AI变聪明的神奇方法

华为诺亚方舟实验室提出VersatileFFN创新架构,通过模仿人类双重思维模式,设计了宽度和深度两条并行通道,在不增加参数的情况下显著提升大语言模型性能。该方法将单一神经网络分割为虚拟专家并支持循环计算,实现了参数重用和自适应计算分配,为解决AI模型内存成本高、部署难的问题提供了全新思路。