情绪识别研究公司 Realeyes 获欧盟360万欧元拨款支持

来自 WSJ 的消息,位于伦敦的初创公司Realeyes近日获得了欧盟360万欧元(390万美元)的拨款奖励。

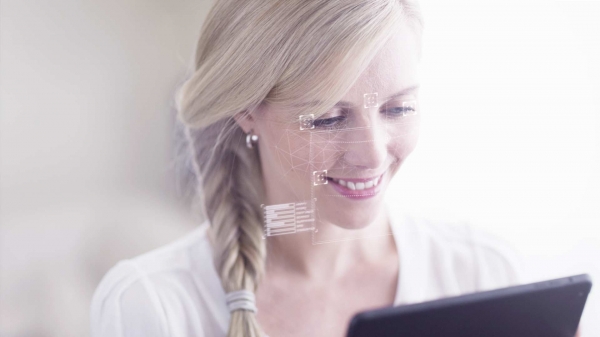

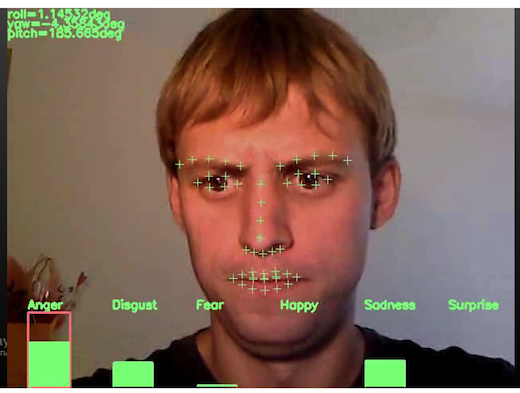

Realeyes 创立于2007年,利用图像处理、人工智能、计算机视觉等技术帮助,通过使用网络摄像头或智能手机监测追踪人的面部表情数据,以进行人的情绪识别和行为反 应分析。目前,Realeyes已建立起超过500万帧的人脸数据库,每一帧都有多达7个面部动作注解,比如皱眉意味着困惑,而眉毛向上抬起则表示惊讶。 此外还会有其他面部特征帮助一起进行情绪识别,使分析结果更有说服力。

此外,这项技术将会自动检测人的性别和年龄,并且还会与其他数据库信息进行合并,从而建立起更为具体的个人信息。

Realeyes近日获得的欧盟这笔资助将与来自伦敦帝国理工学院和德国帕绍大学的研究者、以及英国博彩公司PlayGen共同分享,以试图深入研究测量人的情绪,从而识别人们是否对于自己看到的事物表现出喜欢的态度。

Realeyes 的支持者认为这项技术将有非常好的应用前景,例如可以提升驾驶员的安全性,提高课堂教学效率,帮助警察测谎等。而在商业方面,可以帮助商家进行视频广告监 测和内容的重塑。比如AOL可以利用这项技术监测什么样的视频广告内容可以让用户产生兴趣并能够促使他们分享,从而制作提供更好的广告内容。

当然,Realeyes的这项技术也涉及到了个人隐私的问题,尤其是在欧洲个人隐私受到更为严格的法律保护。Realeyes方面表示,这项技术经过了严格的审查,而且只有得到用户非常明确的同意后他们才会进行视频录制和面部情绪研究。

CEO Mihkel Jäätma 认为,未来Realeyes将会进军其他领域,尤其是他想创建一款心理健康产品,可以帮助人们变得快乐并且保持快乐。

好文章,需要你的鼓励

-

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

openGauss的目标是探索oGRAC和超节点深度融合的可能,打造超节点原生数据库。

-

清华团队让机器学会"透视眼":用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

-

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

-

上海AI实验室创造"无限视频世界",用键盘就能探索!

上海AI实验室团队开发的Yume1.5是一个革命性的AI视频生成系统,能够从单张图片或文字描述创造无限可探索的虚拟世界。用户可通过键盘控制实时探索,系统8秒内完成生成,响应精度达0.836,远超现有技术。该系统采用创新的时空通道建模和自强制蒸馏技术,支持文本控制的事件生成,为虚拟现实和内容创作领域开辟了新的可能性。