爱奇艺用互联网思维开演唱会:原来你是这样的“尖叫之夜”

CNET科技资讯网 4月25日 北京消息(文/周雅):2016年11月23日,在北京工人体育场的爱奇艺办公楼里,爱奇艺龚宇接见了有着演唱会行业前辈名号的田京泉,两个人一起悄悄“密谋”着互联网+演唱会,这个点子只是当时俩人一拍脑袋想出来的,却在五个月之后的昨天,成为了爱奇艺的最新战略。

“线上演出具有巨大的生命力!”爱奇艺首席内容官王晓晖昨天在北京以这样的开场白,对外宣布,爱奇艺正式进入音乐演唱会领域——从2017年5月20日开始,透过大连、福州、深圳、北京、西安、上海、济南和南京8场“青岛纯生尖叫之夜”万人演唱会,打造一场线上到线下的音乐荷尔蒙共振。将“尖叫之夜”变成爱奇艺的一个品牌。

热闹的市场

王晓晖有理由相信线上演出市场是一个红海。

据CNNIC不久前发布《第39次中国互联网络发展状况统计报告》显示,2016年各类网络直播使用率当中,演唱会直播到2016年12月是15.1%,少于体育直播(20.7%)、游戏直播(20%)和真人聊天秀直播(19.8%),但增速却仅次于游戏直播。“演唱会直播”赛道从2012年到现在,达到惊人的千万量级。

于是爱奇艺、腾讯、乐视等视频平台加码音乐演出直播,野马直播、正在现场等布局垂直类的音乐直播平台,而数字王国、微鲸则试图则通过VR技术来进入演出直播领域......各家公司纷纷进场,砸钱,砸资源,市场整个都热气腾腾。

热闹的市场让玩家们意识到,除了拼技术之外,服务体验和商业模式更关键。

这时候你或许会问,互联网时代的演唱会和以前的演唱会到底有什么不一样?

“传统演唱会的受众规模往往受场地、安全、成本等多方因素的限制,存在一系列痛点。”爱奇艺市场副总裁陈宏嘉介绍,首先,买票亲临现场的观众即使有现场感,但是缺乏互动性;同时,那些在上网看直播的观众,虽然不用花太多的成本,但是体验感不足。

以上痛点给了爱奇艺两个方向,一是如何去创造一个无差别的现场感,这时候考验的是技术实力。二是要用更丰富的社交产品来达到现场互动,让整场演唱会不论线下还是线上都变得更好玩起来。

原来你是这样的互联网演唱会

具体到“尖叫之夜”演唱会怎么玩?用爱奇艺的话来说,是“最顶级的制作团队、全新媒体的思维推广、最新科技与交互的结合”。

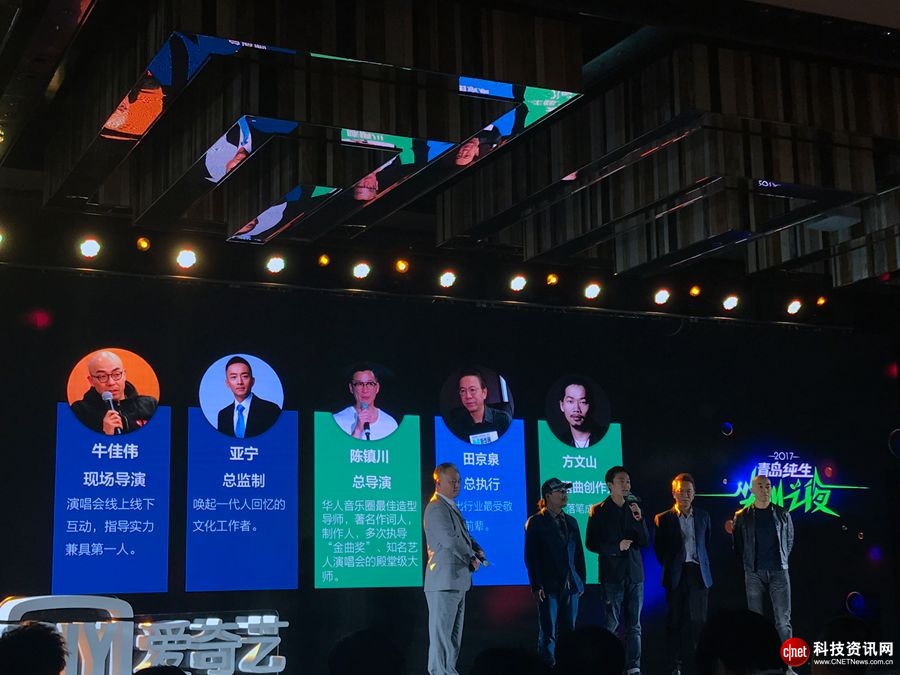

首先是制作团队方面。总导演陈镇川、现场导演牛佳伟、总监制亚宁、总执行田京泉、主题曲创作人方文山。首场演唱会阵容由汪峰、李健、A-Lin、陶晶莹等明星组成。

其次是科技和交互方面。1、除了在爱奇艺平台进行4K高清直播之外,现场会设置VR体验专属区域,同时打造PC和移动客户端VR模式观看直播,引入人工智能技术,尝试3D180度直播(移动端);2、爱奇艺首次在VR直播里采用电影级拍摄设备,并且引入了交互模式,区别于其他VR直播体验;3、推出了二次元虚拟偶像——双儿,据说利用大数据依据全球1000位最具魅力的女性形象所打造的。

爱奇艺二次元虚拟偶像——双儿

尽管现在谈演唱会的4K和VR直播已经不算是新尝试,因为任何商品内容的生产和消费的升级都得益于技术的进步,音乐内容也不例外,VR技术开始被应用到游戏、动漫、演出、影视等领域,特别是在演出市场——2014年汪峰演唱会首次尝试了4K直播,张北草原音乐节同样运用了4K机器,在2015年10月BIGBANG的直播中也有VR和多机位的尝试,去年12月王菲演唱会通过直播+VR创下近2150万在线观看人数纪录。

但爱奇艺为什么强调180度VR直播?爱奇艺副总裁段有桥是这样说的:

“大多数人看完VR的演唱会之后都有一个感觉,好像还不如普通的演唱会,有一个突出的缺点就是不清晰。不清晰的原理是因为,VR是360度的,任何一个视频内容的各个角度都需要用网络传输巨大的码流,意思是,同样的带宽之下,一个VR的清晰度只有普通电视视频的1/5或者1/4。因此,180度VR直播,也就是相当于给每个观众眼前画一个视角,视角区间在面对舞台左右180度放大90度之间,恰好是最清晰的跨度。”

最后,爱奇艺还将投入新媒体思维和新媒体资源来推广——与一级新媒体平台(新浪微博等等)一起投入10亿级的推广资源,覆盖至少200家以上的媒体进行推广,加上爱奇艺泡泡圈、奇秀直播等互动平台,设置AR抢礼物、网红派发虚拟红包、网红跟唱等互动环节,去迎合年轻用户的娱乐需求。

致力于成为“互联网时代的娱乐公司”的爱奇艺近来不断完善IP生态闭环,布局视频付费、视频技术、电影、动漫、游戏、VR、社交等领域,尽管“现象级”演唱会直播已经不新鲜,但爱奇艺的加入,还是掀起了一个不大不小的高潮。

好文章,需要你的鼓励

-

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

openGauss的目标是探索oGRAC和超节点深度融合的可能,打造超节点原生数据库。

-

清华团队让机器学会"透视眼":用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

-

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

-

上海AI实验室创造"无限视频世界",用键盘就能探索!

上海AI实验室团队开发的Yume1.5是一个革命性的AI视频生成系统,能够从单张图片或文字描述创造无限可探索的虚拟世界。用户可通过键盘控制实时探索,系统8秒内完成生成,响应精度达0.836,远超现有技术。该系统采用创新的时空通道建模和自强制蒸馏技术,支持文本控制的事件生成,为虚拟现实和内容创作领域开辟了新的可能性。