让机器会说更生动的句子,阿里巴巴论文入选计算机视觉顶级会议

CNET科技资讯网 7月28日 北京消息:今天,阿里巴巴的“NASA大脑”iDST(Institute of Data Science Technology)表示,《Hierarchical Multimodal LSTM for Dense Visual-Semantic Embedding》入选2017年国际计算机视觉大会ICCV,即计算机视觉领域的顶级会议之一。

这也是阿里巴巴本月内第三次公布论文入选国际顶级学术会议的好消息。

据了解,这篇论文涉及的是计算机视觉(Vision)和自然语言处理(Language)两个独立领域结合的学术研究,提出了对图像(或图像显著区域)更为细致精确的描述,显示出阿里巴巴在Vision&Language研究方向的持续挖掘。

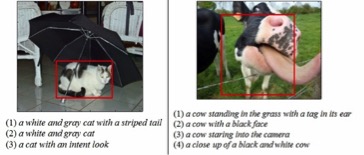

该论文通过创新的多模态、层次化的递归神经网络(Hierarchical Multimodal LSTM)方法,可以将整个句子、句子中的短语、整幅图像及图像中的显著区域同时嵌入语义空间,并且自动学习出“句子-图像”及“短语-图像区域”间的对应关系,生成包含更多形容词的稠密语义空间,对图像或图像区域进行更详细和生动的描述。

也就是说,计算机以后不仅能说“一只鸟站在树枝上”,还能说出“一只羽翼未丰的小鸟站在春天抽芽的树枝上”、“一只张嘴乞食的小鸟”、“一只小鸟站在抽芽的树枝上,扑腾翅膀学习飞翔”这样更为生动复杂的句子。

论文作者介绍,这一研究将被用于“看图说话(Image Captioning)”任务及其他颇有意义的应用场景。如应用于自动导盲系统,将拍摄的图像转换成文字和语音,以便提示盲人避障。

此外,还能用于“跨模态检索(Cross-media Retrieval)”任务,当用户在电商搜索引擎中输入一段描述性文字如“夏季宽松波西米亚大摆沙滩裙”,系统就能为用户提供最相关的商品。

ICCV全称为IEEE International Conference on Computer Vision,与CVPR(计算机视觉模式识别会议)和ECCV(欧洲计算机视觉会议)并称计算机视觉方向的三大顶级会议。

在本月早些时候,阿里巴巴先后发布三篇论文入选国际多媒体会议ACM MM,四篇论文入选国际计算机视觉与模式识别会议CVPR的消息。

今年3月,阿里巴巴宣布启动NASA计划,要为未来20年研发核心科技。在这一计划的号召下,阿里正在人工智能领域全面发力,在机器学习、视觉识别等领域不断追赶世界顶尖的学术水平。

好文章,需要你的鼓励

-

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

openGauss的目标是探索oGRAC和超节点深度融合的可能,打造超节点原生数据库。

-

清华团队让机器学会"透视眼":用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

-

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

-

上海AI实验室创造"无限视频世界",用键盘就能探索!

上海AI实验室团队开发的Yume1.5是一个革命性的AI视频生成系统,能够从单张图片或文字描述创造无限可探索的虚拟世界。用户可通过键盘控制实时探索,系统8秒内完成生成,响应精度达0.836,远超现有技术。该系统采用创新的时空通道建模和自强制蒸馏技术,支持文本控制的事件生成,为虚拟现实和内容创作领域开辟了新的可能性。