当AI看到男性,首先想到“官员”;看到女性,却先想到“微笑”

男性总爱用外表来评判女性。事实证明,计算机也会如此。

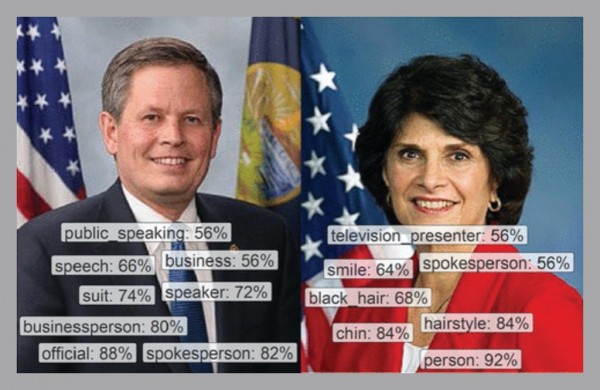

当美国及欧洲的研究人员向谷歌的云图像识别服务展示国会议员照片时,该服务给女性照片添加的外貌标签达到男性照片的3倍。男性图片中出现最多的标签是“官员”与“商人”;而在女性一边,最常出现的则是“微笑”和“下巴”。

德国科恩GESIS莱布尼茨社会科学研究所博士后研究员Garsten Schwemmer表示,“这是一种对女性地位的刻板印象——男性代表商业领袖,女性则只需要漂亮即可。”他本人也参与了此项研究,项目组成员还包括来自纽约大学、美国大学、都柏林大学学院、密歇根大学以及非营利性组织加州YIMBY的研究者。

研究人员对谷歌的人工智能图像服务以及竞争对手亚马逊及微软的方案进行了机器视觉测试。各位外包测试人员负责评审这些服务,在观察议员官方照片及其发布的推文图片后做出的评判结论。

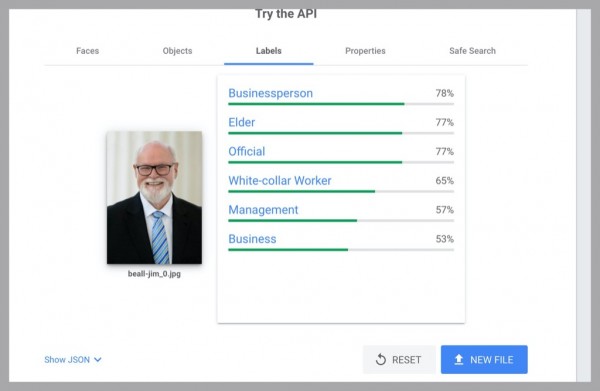

图:谷歌AI图像识别服务更倾向于将参议员Steve Daines视为商人,而对Lucille Roybal-Allard等女性议员则往往添加外观标签。

AI服务当然也能够看到人类评审员在照片中看到的东西,但其更倾向于关注男性与女性之间的差异,特别是更多增加外表信息设定为女性特征。女议员通常被贴上“女生”及“美女”等标签。事实上,这些服务往往根本不会深挖女性对象的其他特征,而单纯只做性别判断;这一点与处理男性照片时,形成了强烈的反差。

这项研究进一步增加了证据,即算法并不是真正从数学角度爬行世界,而更多是在复制甚至放大固有的文化偏见。2018年的Gender Shades项目早已得出过类似的结论,项目表明,微软与IBM的AI云服务在识别白人男性方面非常准确,但在识别黑人女性的性别时则准确率低下。

在此次最新研究当中,研究人员选择了加利福尼亚州参议院10位男性与10位女性官员的照片,并表明当初的结论仍然成立。

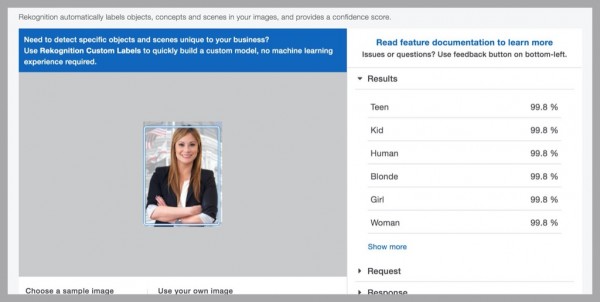

图:亚马逊的图像处理服务Rekognition将包括共和党人Ling Ling Chang在内的多位加利福尼亚州女性参议员照片标记为“女生”或“儿童”,但从未在男性议员照片上做出类似的标记。

这20位议员在照片中都面带微笑。从谷歌上出现频率最高的标签来看,其只将一位男性标记为“微笑”,但将七位女性标记为“微笑”。

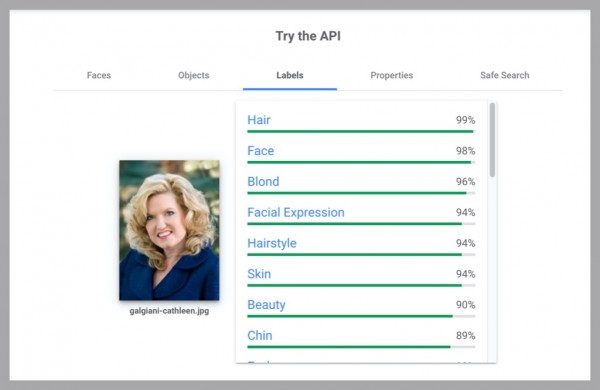

此外,谷歌的AI视觉服务将所有10位男性标记为“商人”,通常还带有“官员”或“白领”字样;但在女性方面,只有5位女参议员获得了一项或多项类似的标记。女性照片获得的外貌相关标签明显更多,例如“皮肤”、“发型”、“脖子”等等,这些在男性照片中均未出现。

亚马逊与微软的服务似乎并没有表现出明显的偏见,但亚马逊以高达99%的置信度认定,其中2位女性参议员为“女生”或者“儿童”,而并未对任何男性照片做出误判。微软的服务正确确定了所有男性照片的性别,但只成功确定8位女性的性别;其将1位女性误认为男性,而最后1位女性则未被添加任何性别标记。

谷歌在今年年初关闭了AI视觉服务中的性别检测功能,表示无法单凭一个人的外貌推断出性别。谷歌云部门AI执行董事Tracy Frey表示,该公司始终致力于减少偏见,并欢迎外界各方的参与。她指出,“我们一直在努力变得更好,并不断与外部利益相关方(例如学术研究人员)开展合作,希望在这一领域进一步开展工作。”亚马逊与微软则拒绝对此发表评论,目前双方的服务仍然只对性别做出二元判断。

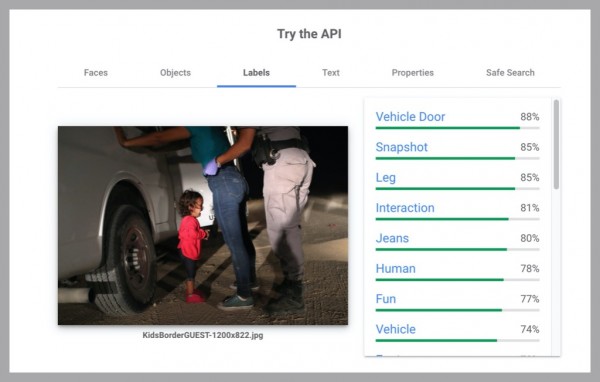

此次美国-欧洲联合研究的灵感,源自当初研究人员向谷歌视觉服务展示了一张屡获殊荣的惊人照片。这张照片拍摄于得克萨斯州,其中一名蹒跚学步的洪都拉斯儿童,因母亲被美国边境巡逻官拘留,而痛哭流涕。谷歌的AI建议为其添加了包括“有趣”(置信度为77%)在内的标签,甚至远高于“儿童”标签(置信度52%)。在周三将此照片上传至谷歌服务后,实际结果也验证了这一说法。

Schwemmer和他的同事们开始使用谷歌服务,希望借此衡量人们在网上使用图像谈论政治问题的方式。以此为基础,他开始揭露视觉服务中的性别偏见问题,也由此确认此项技术并未做好参与实际研究的准备,甚至有可能给轻易信任此类服务的企业带来惨重损失。他指出,“这可能会给用户带来完全错误的图像解读结果。”以帮助企业整理员工影像集为例,过度从外貌角度评判女性只会令对方受到强烈的冒犯。

图:当这张图片在2019年成为世界新闻杂志年度照片时,有人称其中表达出了“心理暴力”的意象。但谷歌的图像算法检测则认为其内容“有趣”。

此前的研究发现,用于训练视觉算法的标记照片等重要数据集,表现出明显的性别偏见。例如,大部分数据集,会展示女性烹饪与男性射击的画面。这种偏见的根源在于,研究人员通过在线方式广泛收集图像,而网络上的照片往往是社会偏见的直接体现。而使用这些数据集训练而成的机器学习软件,往往又会放大其中的偏见倾向。

Schwemmer认为训练数据中的偏见,可能解释了这项新兴研究在各科技巨头AI服务中出现的问题。但如果不全面探查其系统,仍无法得出最终结论。

近年来,诊断及修复AI系统中的缺陷与偏见/偏差已经成为一大热门研究议题。当AI软件将注意力集中在像素模式之上时,人们马上意识到,其中的小小偏差都有可能引发巨大的认知误解。随着算法在处理图像方面变得越来越强,这个问题也显然愈发紧迫。普林斯顿大学助理教授Olga Russakovsky表示,“现在,这类系统正部署在世界各地。因此,我们最好保证它们能够正确完成工作,而不至于引发出乎意料的后果。”

图:此次研究与测试发现,谷歌的图像识别服务会给加利福尼亚州参议员Cathleen Galgiani等女性添加与其外貌相关的标签;但却给她的同事Jim Beall等男性议员添加“商人”及“长者”等身份标签。

解决这个问题的一种重要方法,在于努力改进训练数据,从根本上扭转机器学习系统的偏见/偏差倾向。在普林斯顿大学的相关项目中,Russakovsky正努力开发一款名为REVISE的工具,用于自动标记出图像集内存在的某些偏见元素,包括与地理及性别相关的元素。

当研究人员将该工具应用于由谷歌维护的Open Images中的900万张图像时,他们发现,系统更容易在户外及运动场景下标记出男性(女性的标记概率明显更低)。而“运动服”标签对应的男性往往身在户外,而对应的女性则大多在室内进行篮球或游泳等运动。

谷歌及其AI领域各竞争对手本身也在积极研究AI公平性与偏见问题。其中包括建立标准化方法以将AI软件及数据集的局限性和内容,准确传达给开发人员(类似于AI模型版本的「食品营养表」)。

谷歌还开发出一种名为“模型卡”的格式,并为其云视觉服务的人脸及物体识别组件发布了相应卡。其模型卡宣称,谷歌的人脸识别软件在不同性别对象上的工作原理大致相同,但并未提及其他可能引发AI性别偏见的因素。

好文章,需要你的鼓励

-

利用大语言模型探索科学创新前沿:南洋理工大学团队开发检测学术新颖性的突破性方法

这项研究利用大语言模型解决科学新颖性检测难题,南洋理工大学团队创新性地构建了闭合领域数据集并提出知识蒸馏框架,训练轻量级检索器捕捉想法层面相似性而非表面文本相似性。实验表明,该方法在市场营销和NLP领域显著优于现有技术,为加速科学创新提供了有力工具。

-

un?CLIP:通过反转unCLIP来提升CLIP模型的视觉细节捕捉能力

un?CLIP是一项创新研究,通过巧妙反转unCLIP生成模型来增强CLIP的视觉细节捕捉能力。中国科学院研究团队发现,虽然CLIP在全局图像理解方面表现出色,但在捕捉细节时存在不足。他们的方法利用unCLIP生成模型的视觉细节表示能力,同时保持与CLIP原始文本编码器的语义对齐。实验结果表明,un?CLIP在MMVP-VLM基准、开放词汇语义分割和视觉中心的多模态任务上显著优于原始CLIP和现有改进方法,为视觉-语言模型的发展提供了新思路。

-

角色扮演能力大考验:里尔大学研究团队开发的大语言模型角色扮演评估新标准

这项研究介绍了RPEval,一个专为评估大语言模型角色扮演能力而设计的新基准。研究团队从法国里尔大学开发的这一工具专注于四个关键维度:情感理解、决策制定、道德对齐和角色一致性,通过单轮交互实现全自动评估。研究结果显示Gemini-1.5-Pro在总体表现上领先,而GPT-4o虽在决策方面表现出色,但在角色一致性上存在明显不足。这一基准为研究人员提供了一个可靠、可重复的方法来评估和改进大语言模型的角色扮演能力。

-

LegalSearchLM:北大团队打造突破性法律案例检索新方法,将案例检索重新定义为法律要素生成

这篇论文介绍了LegalSearchLM,一种创新的法律案例检索方法,将检索任务重新定义为法律要素生成。研究团队构建了LEGAR BENCH数据集,涵盖411种犯罪类型和120万案例,并开发了能直接生成关键法律要素的检索模型。实验表明,该模型在准确率上超越传统方法6-20%,且在未见犯罪类型上展现出强大泛化能力。这一突破为法律专业人士提供了更高效、精准的案例检索工具。