全球冠军!紫光展锐多媒体算法斩获MOT20榜单第一

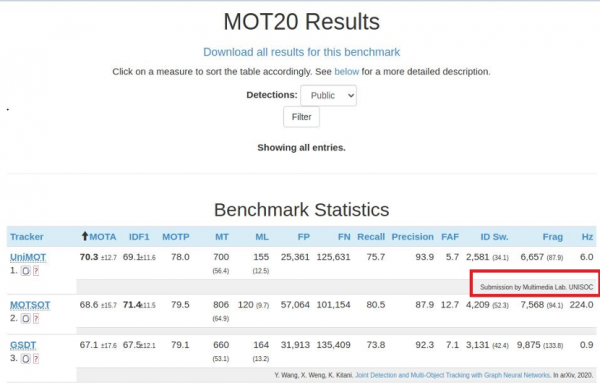

上海,中国 – 2021年1月19日- 在国际权威的多目标跟踪挑战(Multiple Object Tracking Challenge,MOT)MOT20榜单上,紫光展锐多媒体算法的mota指标超过70分,拿下全球冠军。这也是MOT20 Challenge榜单上唯一一家超过70分的企业,彰显了紫光展锐在多目标跟踪领域的业界领先水平。

MOT Challenge是多目标跟踪领域最权威的国际测评平台,由慕尼黑工业大学、阿德莱德大学、苏黎世联邦理工学院以及达姆施塔特工业大学联合创办。MOT Challenge 提供了非常准确的标注数据和全面的评估指标,用以评估跟踪算法、行人检测器的性能。

其中,MOT 20 benchmark包含8份新的视频序列、密集且极具挑战性的场景。这份数据集在4th BMTT MOT Challenge Workshop,CVPR 2019上首次发布,平均每帧高达246个行人,相比之前的挑战赛数据集增加了夜晚数据集,对现有SOTA的MOT算法在解决极端稠密场景、算法泛化性等方面提出了艰巨挑战。

紫光展锐在多媒体算法中针对网络结构设计、损失函数、训练数据处理等方面进行了大量的创新和探索。针对竞赛中训练集没有涉及到的场景,紫光展锐创新性的采用端到端同时检测、行人识别策略,保障了算法在实际落地时的实时性,同时针对不同的端侧算力灵活调整网络大小,可灵活配套多种芯片方案的部署。

同时参与本次竞赛的还包括牛津大学、卡耐基梅隆大学、清华大学、慕尼黑工业大学、中科院、微软等多家企业、大学和科研机构的相关团队。

多目标追踪技术作为承载监控、车载、无人机、赛事直播等应用的关键技术,可准确捕捉视频中的关键信息,为进一步的信息提取提供支持,将在智慧城市、物联网等领域得到越来越广泛的应用。

在智能监控场景中,算法可实现复杂场景下的目标自动提取、跟踪、识别,理解目标的活动状态,进而实现场景状态监测、识别等。多目标追踪技术的应用可大幅减少人工重复劳动、提高工作效率和监控系统的智能性、安全性;在赛事直播场景中,算法可自动提取运动员的运动状态,从而实现数据统计、自动导播等功能,挖掘更多的数据价值;在智能车载场景中,算法可获取道路中车辆、行人的运动信息,为自动驾驶、安全辅助等应用提供必要的决策数据支持。

图像算法正在深度融合到越来越多的垂直行业,形成乘法效应,衍生出创新的业务和应用,让人们的生活更加美好和便捷。

MOT challenge榜单官网:https://motchallenge.net/results/MOT20/?det=All

好文章,需要你的鼓励

-

Snowflake AI挑战传统语言学:万千茫茫文字中,LLM真的只是"随机鹦鹉"吗?

这项由Snowflake AI Research发表的研究挑战了传统语言学对大型语言模型的批评,通过引入波兰语言学家Mańczak的理论框架,论证了LLM的成功实际上验证了"频率驱动语言"的观点。研究认为语言本质上是文本总和而非抽象系统,频率是其核心驱动力,为重新理解AI语言能力提供了新视角。

-

Yale大学团队推出"免费博士劳工":让AI研究助手像真人团队一样工作的革命性框架

freephdlabor是耶鲁大学团队开发的开源多智能体科研自动化框架,通过创建专业化AI研究团队替代传统单一AI助手的固化工作模式。该框架实现了动态工作流程调整、无损信息传递的工作空间机制,以及人机协作的质量控制系统,能够自主完成从研究构思到论文发表的全流程科研工作,为科研民主化和效率提升提供了革命性解决方案。

-

德国马普所团队发明"智能大脑重新布线"技术:让AI专家模型学会即时调整自己

德国马普智能系统研究所团队开发出专家混合模型的"即时重新布线"技术,让AI能在使用过程中动态调整专家选择策略。这种方法无需外部数据,仅通过自我分析就能优化性能,在代码生成等任务上提升显著。该技术具有即插即用特性,计算效率高,适应性强,为AI的自我进化能力提供了新思路。

-

聊天机器人怎么不在线聊天中"迷路"?Algoverse AI研究团队的熵值导航新突破

Algoverse AI研究团队提出ERGO系统,通过监测AI对话时的熵值变化来检测模型困惑程度,当不确定性突然升高时自动重置对话内容。该方法在五种主流AI模型的测试中平均性能提升56.6%,显著改善了多轮对话中AI容易"迷路"的问题,为构建更可靠的AI助手提供了新思路。