浙江大学团队用高斯分布"教会"AI点击屏幕:让计算机像人类一样自然操作界面

这篇由浙江大学和蚂蚁集团联合完成的研究论文发表于2025年1月,题为《GUI-G2: Gaussian Reward Modeling for GUI Grounding》。有兴趣深入了解的读者可以通过GitHub项目页面(https://github.com/zju-real/GUI-G2)和项目主页(https://zju-real.github.io/GUI-G2)获取更多详细信息。

要理解这项研究的意义,我们可以从一个简单的场景开始。当你告诉朋友"帮我点击保存按钮"时,朋友会自然地扫视屏幕,找到那个按钮,然后准确点击。这个过程看似简单,但对计算机来说却充满挑战。计算机需要"理解"你的指令,在复杂的界面中找到正确的元素,然后精准定位点击位置。这就是GUI(图形用户界面)智能体需要解决的核心问题。

传统的计算机学习方法就像一个过分严苛的老师,对学生的答题只有两种评价:完全正确或完全错误。如果AI预测的点击位置哪怕偏离目标区域一个像素,就会得到零分;而完全准确命中目标,则得到满分。这种"非黑即白"的评价方式让AI很难从错误中学习。就像一个射箭初学者,如果教练只在命中靶心时给予鼓励,而对其他所有情况都保持沉默,学员就很难知道如何改进。

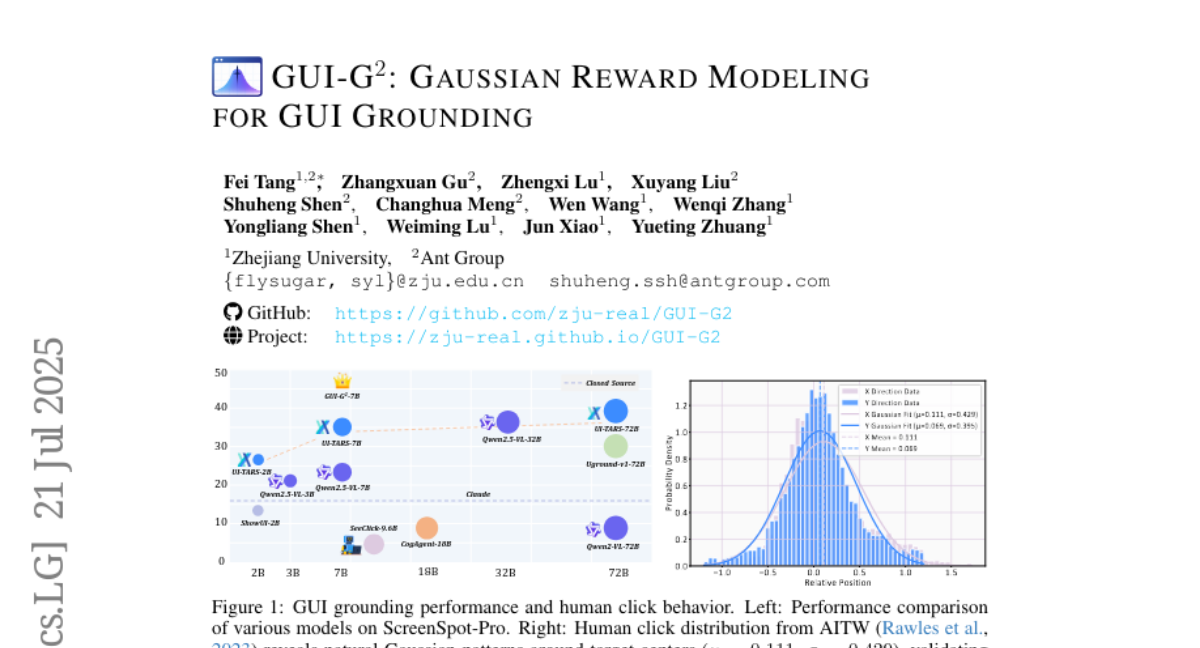

浙江大学的研究团队发现,人类点击屏幕的行为其实遵循着一种自然的规律。通过分析大量真实用户的点击数据,他们发现人们的点击位置并不是完全随机的,而是呈现出以目标元素中心为核心的高斯分布(也就是我们常说的正态分布或钟形曲线)。简单来说,人们更倾向于点击按钮的中心区域,距离中心越远,点击的概率越低,这种分布就像山峰一样,顶部(中心)最高,向两边逐渐降低。

基于这个发现,研究团队开发了一个名为GUI-G2的全新训练方法。与传统方法不同,这种新方法就像一位耐心的导师,会给予AI更加细致和连续的反馈。当AI的预测接近目标时,会得到相应的鼓励;即使没有完全命中,只要在正确的方向上,也能获得一定的正面反馈。这种方法让AI能够更好地理解"接近正确"和"完全错误"之间的差别。

GUI-G2方法包含两个相互补充的核心机制。第一个是"高斯点奖励",它专门评估AI预测的点击中心位置是否准确。就像投篮时评估球是否朝篮筐中心飞行一样,这个机制会根据预测位置与目标中心的距离给出连续的分数。距离越近,分数越高;距离越远,分数呈指数级下降,但不会突然归零。

第二个机制叫做"高斯覆盖奖励",它评估的是AI预测的区域与目标区域的重叠程度。这就像评估两个圆圈的重合面积一样,重合越多,说明预测越准确。这个机制确保AI不仅要找对位置,还要理解目标元素的大小和形状。

特别值得一提的是,研究团队还引入了自适应方差机制来处理不同尺寸的界面元素。在真实的软件界面中,有些按钮很小,像手机上的图标;有些区域很大,像整个菜单栏。对于大按钮,用户的点击容错性更高,稍微偏一点也能成功操作;而小按钮则需要更精确的定位。自适应机制就像一个智能的教练,会根据不同元素的特点调整评分标准,确保训练的合理性。

为了验证这种新方法的效果,研究团队在三个权威的测试数据集上进行了全面的实验。结果令人印象深刻:在ScreenSpot数据集上,GUI-G2达到了92.0%的准确率;在ScreenSpot-v2上达到93.3%;在更具挑战性的ScreenSpot-Pro专业软件界面测试中,达到了47.5%的准确率。这些成绩不仅超越了之前的最佳方法,更重要的是,新方法使用的模型参数量只有前者的十分之一,大大提高了效率。

研究团队还深入分析了为什么连续奖励比传统的二元奖励更有效。通过跟踪训练过程中AI预测位置与目标中心距离的变化,他们发现传统方法的训练曲线充满剧烈波动,AI的表现忽好忽坏,很难稳定改进。相比之下,GUI-G2方法展现出平滑的单调收敛特性,AI的表现稳步提升,从初始的290像素误差逐渐降低到150像素,展现出明显的学习轨迹。

实际应用中的测试结果更加证实了这种方法的价值。在处理高分辨率专业软件界面时,GUI-G2在文本元素定位上达到了64.7%的准确率,相比之前最好的方法提升了13.8个百分点。这种显著改进表明,连续的高斯奖励机制特别适合处理需要精细空间定位的复杂任务。

研究还揭示了一个有趣的发现:提供全空间连续奖励比仅在目标区域内提供连续奖励更有效。他们测试了一种"内部高斯"方法,即只在目标边界内使用高斯分布,边界外仍然给零分。结果显示,这种限制反而降低了4.9%的性能。这说明为AI提供全局的、连续的学习信号,能够创造出更平滑的优化路径,让AI从任何起始位置都能找到通向目标的方向。

团队还对比了显性推理和直接预测两种训练方式。令人意外的是,要求AI进行逐步推理反而降低了性能,从93.3%下降到88.7%。这个发现表明,GUI界面操作本质上是一种依赖即时视觉模式识别的感知任务,而不是需要逻辑分析的推理过程。过多的推理步骤可能会干扰AI对关键视觉特征的注意力,反而影响定位精度。

在处理奖励权重平衡方面,研究发现点奖励和覆盖奖励采用相等权重(各为1.0)时效果最佳,达到93.3%的准确率。当过分偏重点定位(权重0.8:0.2)时,准确率降至92.2%;过分偏重区域覆盖(权重0.2:0.8)时,准确率更是降至91.8%。这说明精确定位和空间理解需要同等重视,缺一不可。

自适应方差机制的重要性也得到了充分验证。研究团队测试了多种固定方差策略,包括1σ、2σ、3σ原则以及完全固定的方差设置。结果显示,自适应机制(α=0.5)实现了93.3%的最佳性能,比固定方差方法提高了5.5个百分点。有趣的是,自适应机制的最优参数与统计学中的2σ原则相近,这从理论上验证了方法的合理性。

为了验证方法的普适性,团队还对比了GUI-G2与其他连续奖励方法。SE-GUI是另一种基于欧几里得距离的连续奖励方法,但它将界面元素视为点目标,在边界处存在梯度不连续问题。实验结果显示,GUI-G2在ScreenSpot上比SE-GUI高出3.8个百分点,在ScreenSpot-v2上高出3.0个百分点。这种优势源于GUI-G2的统一高斯表示既考虑了定位精度,又兼顾了空间范围,更符合界面交互的真实特性。

研究团队还专门分析了失败案例,发现图标识别仍然是最大的挑战。在所有错误中,图标相关错误占76.9%,而文本错误仅占23.1%。这种差异反映了一个深层问题:图标需要AI从视觉表现推断抽象功能,而文本则提供了更直接的语义信息。此外,信息密集的界面(如在线地图或复杂软件界面)和视觉结构相似的元素也是常见的失败原因。

从技术实现角度来看,GUI-G2采用了Group Relative Policy Optimization(GRPO)算法进行策略优化。这种方法通过对比多个采样响应来估计优势值,确保训练过程的稳定性。具体来说,对于每个指令,系统会生成多个预测结果,然后通过相对比较来调整学习方向,避免了绝对奖励可能带来的偏差。

高斯点奖励的数学表达相对简洁,它使用二维高斯分布来评估预测中心与目标中心的匹配程度。奖励值随着距离呈指数衰减,确保了平滑的梯度信号。而高斯覆盖奖励则通过计算两个高斯分布的巴塔查里亚系数来量化空间重叠,这个指标能够同时考虑位置偏差和尺寸匹配。

实验还验证了一个重要假设:即使是随机奖励也无法为GUI任务提供有效学习信号。研究团队测试了均匀分布随机奖励和二元随机奖励两种"虚假"奖励策略。结果显示,这些随机信号不仅无法促进学习,反而导致性能逐步下降。连续随机奖励从90.6%降至87.9%,二元随机奖励从88.6%降至84.5%。这个发现证明了GUI任务对有意义空间反馈的严格要求,排除了随机奖励可能带来学习收益的可能性。

从计算复杂度来看,GUI-G2的高斯计算并不会显著增加训练开销。二维高斯分布的计算可以通过现有的深度学习框架高效实现,而巴塔查里亚系数也有闭式解。相比于复杂的多步推理或大规模参数搜索,这种方法在计算上相当优雅。

值得强调的是,这项研究不仅在技术上取得了突破,更重要的是它揭示了人机交互的一些基本规律。通过模拟人类自然的点击行为模式,AI系统能够更好地理解和执行界面操作任务。这种"向人类学习"的思路为未来的AI界面交互研究指明了方向。

研究团队使用了约10万个GUI操作实例进行训练,这些数据来自四个主要数据集,涵盖了移动端、桌面端和网页端的多种界面类型。训练采用Qwen2.5-VL-7B作为基础模型,在8块NVIDIA A100-80G GPU上进行,使用了多项优化技术如Flash Attention 2和梯度检查点来提高效率。

从实际应用价值来看,GUI-G2为构建更智能的数字助手奠定了基础。未来的AI助手将能够更准确地理解用户的操作需求,在复杂的软件界面中精确执行各种任务,从简单的文件保存到复杂的软件操作都能胜任。这种技术进步将显著降低普通用户使用复杂软件的门槛,让技术真正为人类服务。

说到底,这项研究的核心价值在于它找到了一种更自然、更有效的方式来训练AI进行界面操作。通过模拟人类的点击行为模式,结合连续的奖励反馈机制,GUI-G2不仅提高了AI的操作精度,还增强了训练过程的稳定性和效率。这种方法不再把界面操作看作简单的命中或错失,而是将其理解为一个连续的空间优化过程,更符合人类认知和操作的实际情况。

对于普通用户而言,这项研究预示着未来的数字体验将变得更加智能和便捷。当AI能够像人类一样自然地操作各种软件界面时,我们就能通过简单的语音指令完成复杂的数字任务,真正实现人机协作的理想状态。而对于开发者和研究者来说,GUI-G2提供的连续奖励建模框架为构建更强大的AI界面代理系统提供了重要的技术基础。

这项研究的影响可能远超界面操作本身。它展示的连续建模思想和人类行为模拟方法,也可能为其他需要精确空间定位的AI任务提供启发,推动整个人工智能领域向更加自然和高效的方向发展。有兴趣深入了解技术细节的读者,可以通过论文的开源项目获取完整的实现代码和实验数据。

Q&A

Q1:GUI-G2是什么?它解决了什么问题? A:GUI-G2是浙江大学开发的一种新型AI训练方法,专门用于教AI学会像人类一样操作电脑界面。它解决了传统方法"非黑即白"评分导致AI学习效率低的问题,通过模拟人类自然点击行为的高斯分布模式,让AI获得更细致的学习反馈。

Q2:这种方法会不会让AI操作界面变得更准确? A:是的,实验结果显示GUI-G2大幅提升了AI的界面操作精度。在专业软件界面测试中,准确率比之前最好的方法提高了24.7%,而且使用的模型参数量只有十分之一,效率更高。

Q3:普通用户什么时候能用上这种技术? A:虽然这项研究还处于学术阶段,但技术已经相当成熟。随着研究团队开源了相关代码,预计未来1-2年内就会有基于这种技术的AI助手产品出现,帮助用户通过语音或文字指令自动操作各种软件。

好文章,需要你的鼓励

-

鸡尾酒会里如何听清朋友说话?清华大学揭秘语音分离的终极奥秘

清华大学等多家机构研究团队完成了语音分离技术的全面调研,系统梳理了从传统方法到深度学习的技术演进。研究揭示了"鸡尾酒会问题"的核心挑战,分析了各种学习范式和网络架构的优劣,并通过统一实验框架提供了公平的性能基准。调研涵盖了实时处理、轻量化设计、多模态融合等关键技术方向,为学术界和产业界的技术选型提供了重要参考,推动语音分离从实验室走向实际应用。

-

浙大团队发现AI画画的黄金时机:什么时候出手最重要?

浙江大学和腾讯微信视觉团队发现AI图片生成训练中"时机胜过强度"的重要规律,开发出TempFlow-GRPO新方法。通过轨迹分支技术精确评估中间步骤,结合噪声感知权重调整优化不同阶段的学习强度,将训练效率提升三倍,在复杂场景理解方面准确率从63%提升至97%,为AI训练方法论带来重要突破。

-

谷歌DeepMind重磅突破:AI机器人学会了像人类一样思考和决策

谷歌DeepMind发布突破性AI规划技术,让机器人学会像人类一样进行"情境学习"规划。该技术通过Transformer架构实现了快速适应新问题的能力,在迷宫导航、机器人控制等测试中表现优异,为自动驾驶、智能制造、医疗等领域应用奠定基础,标志着向通用人工智能迈出重要一步。

-

新南威尔士大学首创ZARA:让AI像侦探一样从运动传感器数据中识别人类活动

新南威尔士大学研究团队开发了ZARA系统,这是首个零样本运动识别框架,能够在未经专门训练的情况下识别全新的人类活动。该系统集成了自动构建的知识库、多传感器检索机制和分层智能体推理,不仅实现了比现有最强基线高2.53倍的识别准确率,还提供清晰的自然语言解释,为可穿戴设备和健康监护等应用领域带来了突破性进展。